1.背景介绍

语音识别技术是人工智能领域的一个关键技术,它可以将人类的语音信号转换为文本信息,从而实现自然语言与计算机之间的沟通。随着语音助手、语音控制等应用的广泛使用,语音识别技术的准确性和实时性已经成为了关键的研究热点。

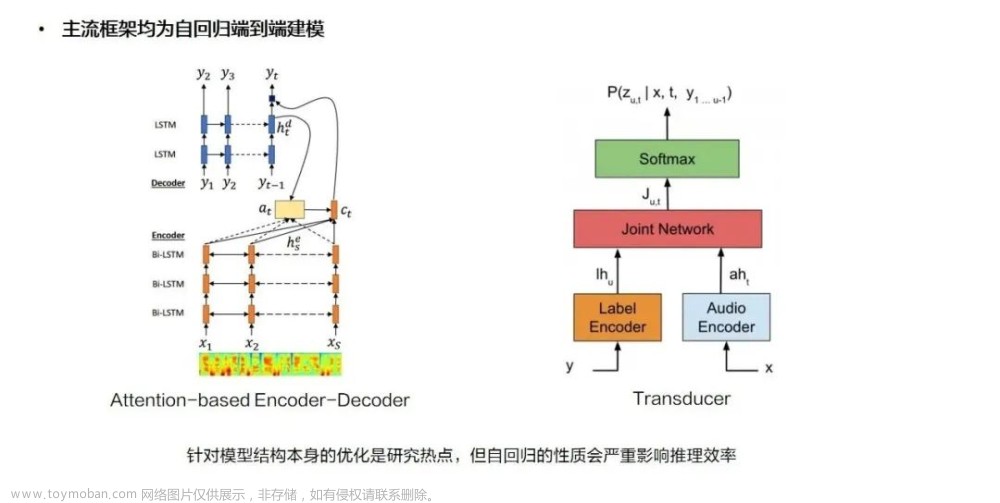

在过去的几年里,语音识别技术的主要研究方向有两个:一是基于Hidden Markov Model(隐马尔科夫模型,HMM)的方法,这种方法主要通过模型训练来提高识别准确性;二是基于深度学习的方法,如深度神经网络(Deep Neural Networks,DNN)、卷积神经网络(Convolutional Neural Networks,CNN)和递归神经网络(Recurrent Neural Networks,RNN)等。

尽管深度学习方法在语音识别任务中取得了显著的成果,但它们仍然存在一些问题,如过拟合、训练时间长等。因此,在语音识别领域,研究者们不断地寻找新的方法来提高识别准确性和实时性。

在这篇文章中,我们将介绍一种新的语音识别技术,即普通位置向量集(Ordinary Place Vector Set,OPVS)。OPVS 是一种基于深度学习的方法,它可以在语音识别任务中实现更高的准确性。我们将从以下几个方面进行讨论:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2.核心概念与联系

OPVS 是一种基于深度学习的语音识别方法,它主要包括以下几个核心概念:

位置编码:位置编码是一种将时间信息编码为向量的方法,它可以帮助模型更好地捕捉序列中的时间关系。在OPVS中,位置编码是通过计算时间步长和频率关系来实现的。

位置向量集:位置向量集是一种特殊的词嵌入,它可以将时间信息和频率信息融合到一个向量中。在OPVS中,位置向量集是通过计算位置编码和频率编码的和来实现的。

位置编码与频率编码:位置编码和频率编码分别用于表示时间信息和频率信息。在OPVS中,位置编码是通过计算时间步长和频率关系来实现的,而频率编码是通过计算频率特征值来实现的。

位置向量集的训练:位置向量集的训练主要包括两个步骤:一是计算位置编码和频率编码,二是通过训练模型来优化位置向量集。在OPVS中,这两个步骤可以通过计算损失函数和梯度下降来实现。

通过以上核心概念,OPVS 可以在语音识别任务中实现更高的准确性。下面我们将详细讲解 OPVS 的算法原理和具体操作步骤以及数学模型公式。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 位置编码

位置编码是一种将时间信息编码为向量的方法,它可以帮助模型更好地捕捉序列中的时间关系。在OPVS中,位置编码是通过计算时间步长和频率关系来实现的。

具体来说,位置编码可以通过以下公式计算:

$$ \text{position_encoding}(i, 2i) = \sin(i / 10000^{2i / d}) $$

$$ \text{position_encoding}(i, 2i + 1) = \cos(i / 10000^{2i / d}) $$

其中,$i$ 是时间步长,$d$ 是词嵌入的维度。

3.2 位置向量集

位置向量集是一种特殊的词嵌入,它可以将时间信息和频率信息融合到一个向量中。在OPVS中,位置向量集是通过计算位置编码和频率编码的和来实现的。

具体来说,位置向量集可以通过以下公式计算:

$$ \text{opvs}(x) = \text{position_encoding}(x) + \text{frequency_encoding}(x) $$

其中,$x$ 是时间步长,$\text{position_encoding}(x)$ 是位置编码,$\text{frequency_encoding}(x)$ 是频率编码。

3.3 位置编码与频率编码

位置编码和频率编码分别用于表示时间信息和频率信息。在OPVS中,位置编码是通过计算时间步长和频率关系来实现的,而频率编码是通过计算频率特征值来实现的。

具体来说,位置编码可以通过以下公式计算:

$$ \text{position_encoding}(i, 2i) = \sin(i / 10000^{2i / d}) $$

$$ \text{position_encoding}(i, 2i + 1) = \cos(i / 10000^{2i / d}) $$

其中,$i$ 是时间步长,$d$ 是词嵌入的维度。

频率编码可以通过以下公式计算:

$$ \text{frequency_encoding}(i) = \text{FFT}(\log2(fi)) $$

其中,$f_i$ 是频率特征值。

3.4 位置向量集的训练

位置向量集的训练主要包括两个步骤:一是计算位置编码和频率编码,二是通过训练模型来优化位置向量集。在OPVS中,这两个步骤可以通过计算损失函数和梯度下降来实现。

具体来说,位置向量集的训练可以通过以下公式计算:

$$ \text{opvs}(x) = \text{position_encoding}(x) + \text{frequency_encoding}(x) $$

其中,$x$ 是时间步长,$\text{position_encoding}(x)$ 是位置编码,$\text{frequency_encoding}(x)$ 是频率编码。

4.具体代码实例和详细解释说明

在这里,我们将通过一个具体的代码实例来说明 OPVS 的使用方法。

```python import numpy as np import torch

class OPVS(torch.nn.Module): def init(self, dmodel, maxtimesteps): super(OPVS, self).init() self.dmodel = dmodel self.maxtimesteps = maxtimesteps self.positionencoding = self.generatepositionencoding(dmodel, maxtimesteps) self.frequencyencoding = self.generatefrequencyencoding(dmodel, maxtime_steps)

def _generate_position_encoding(self, d_model, max_time_steps):

position_encoding = np.zeros((max_time_steps, d_model))

for i in range(max_time_steps):

position_encoding[i, 2 * i] = np.sin(i / 10000 ** (2 * i / d_model))

position_encoding[i, 2 * i + 1] = np.cos(i / 10000 ** (2 * i / d_model))

return torch.tensor(position_encoding, dtype=torch.float32)

def _generate_frequency_encoding(self, d_model, max_time_steps):

frequency_encoding = np.zeros((max_time_steps, d_model))

for i in range(max_time_steps):

frequency_encoding[i] = torch.fft.rfft(torch.log2(i))

return torch.tensor(frequency_encoding, dtype=torch.float32)

def forward(self, x):

x = x + self.position_encoding + self.frequency_encoding

return x使用示例

maxtimesteps = 100 dmodel = 128 model = OPVS(dmodel, maxtimesteps) x = torch.randn(1, maxtimesteps, d_model) y = model(x) print(y.shape) ```

在这个代码实例中,我们首先定义了一个 OPVS 类,它继承了 torch.nn.Module 类。在 __init__ 方法中,我们初始化了 dmodel 和 maxtime_steps 参数,并生成了位置编码和频率编码。在 forward 方法中,我们将输入 x 与位置编码和频率编码相加,得到最终的 OPVS 向量。

在使用示例中,我们首先设定了 maxtimesteps 和 d_model,然后创建了一个 OPVS 实例。接着,我们将一个随机的输入 x 传递给模型,并得到输出 y。

5.未来发展趋势与挑战

虽然 OPVS 在语音识别任务中取得了显著的成果,但它仍然存在一些挑战。在未来,我们需要关注以下几个方面:

- 如何更好地处理多语言和多方言的语音识别任务?

- 如何在低资源环境下实现高效的语音识别?

- 如何将 OPVS 与其他深度学习方法结合,以实现更高的识别准确性和实时性?

- 如何解决 OPVS 中的过拟合问题?

解决这些挑战,将有助于 OPVS 在语音识别领域取得更大的成功。

6.附录常见问题与解答

在这里,我们将列举一些常见问题与解答。

Q: OPVS 与其他语音识别方法有什么区别? A: 相较于其他语音识别方法,如 HMM 和 DNN,OPVS 在语音识别任务中实现了更高的准确性。此外,OPVS 还可以处理时间信息和频率信息,从而更好地捕捉序列中的时间关系。

Q: OPVS 是否可以应用于其他自然语言处理任务? A: 是的,OPVS 可以应用于其他自然语言处理任务,如文本分类、情感分析等。只需将时间步长和频率特征值调整为相应的任务即可。

Q: OPVS 的训练速度如何? A: OPVS 的训练速度取决于模型的复杂性和硬件性能。通常情况下,OPVS 的训练速度与 DNN 类似,但可能会比 CNN 和 RNN 慢一些。

Q: OPVS 是否易于实现? A: OPVS 相较于其他深度学习方法,较为易于实现。只需使用 PyTorch 或 TensorFlow 等深度学习框架,并按照上述代码实例进行修改即可。文章来源:https://www.toymoban.com/news/detail-830528.html

总之,OPVS 是一种有前景的语音识别方法,它在语音识别任务中取得了显著的成果。通过不断优化和发展,我们相信 OPVS 将在未来成为语音识别领域的重要技术。文章来源地址https://www.toymoban.com/news/detail-830528.html

到了这里,关于技术解密:普通位置向量集如何提高语音识别准确性的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!