机器学习中的梯度下降法是一种寻找函数最小值的优化算法,广泛应用于训练各种模型,尤其是在深度学习中。尽管其应用广泛,但梯度下降法也存在一些不可忽视的缺点:

1. 局部最小值和鞍点

- 局部最小值问题: 对于非凸函数,梯度下降法可能会陷入局部最小值,而不是全局最小值。这意味着算法可能找到一个看似最优的点,但实际上在整个参数空间中存在更好的解。

- 鞍点问题: 在高维空间中,鞍点(梯度为零,但既非局部最小值也非局部最大值的点)比局部最小值更常见。梯度下降法在遇到鞍点时可能会停滞不前,因为在这些点上梯度为零,导致更新停止。

2. 学习率的选择

- 学习率过小: 如果学习率设置得太小,梯度下降法会非常缓慢地收敛,需要更多的迭代次数,从而增加训练时间。

- 学习率过大: 如果学习率设置得太大,梯度下降法可能会在最小值附近震荡,甚至偏离最小值,导致算法无法收敛。

3. 特征缩放的敏感性

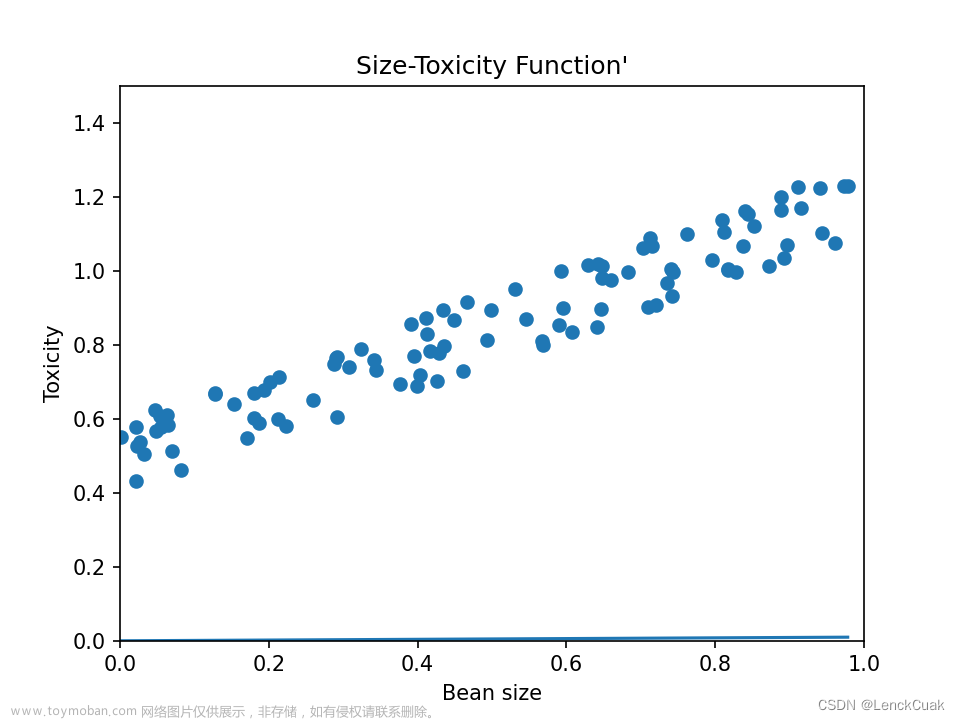

梯度下降法对特征的缩放非常敏感。如果数据集中的特征具有不同的尺度(例如,一个特征的范围是0到1,另一个特征的范围是0到1000),那么梯度下降法可能会非常缓慢地收敛。这是因为较大尺度的特征会对损失函数的梯度产生更大的影响。因此,通常需要对特征进行归一化或标准化处理。

4. 高维数据的挑战

在处理高维数据时,梯度下降法面临的挑战更加严峻。随着维度的增加,所需的计算资源和时间成指数级增长,这被称为“维度灾难”。此外,高维空间中空旷的区域更多,使得寻找全局最小值更加困难。

解决方案

尽管存在上述缺点,但研究人员已经开发出多种变体和技术来克服这些挑战,包括:文章来源:https://www.toymoban.com/news/detail-830710.html

- 使用动量(Momentum)和自适应学习率算法(如Adam、RMSprop):这些方法可以帮助算法跳出局部最小值和鞍点,同时自动调整学习率,以加快收敛速度并提高稳定性。

- 特征缩放:通过归一化或标准化输入特征,可以加快收敛速度,减少学习率选择的敏感性。

- 使用二阶优化方法:如牛顿法等,这些方法考虑了目标函数的二阶导数,可以更有效地处理某些类型的优化问题,尽管它们的计算成本更高。

总之,尽管梯度下降法有其局限性,但通过适当的策略和算法改进,它仍然是机器学习和深度学习中最强大和最流行的优化工具之一。文章来源地址https://www.toymoban.com/news/detail-830710.html

到了这里,关于机器学习中梯度下降法的缺点的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!