1.背景介绍

在现代数据处理系统中,实时数据处理和分析是至关重要的。Apache Flink是一个流处理框架,可以用于实时数据处理和分析。在许多场景下,Flink需要与数据库和Kafka等消息系统进行集成,以实现更高效的数据处理。本文将讨论Flink与数据库和Kafka集成的优化案例,并提供实际示例和解释。

1. 背景介绍

Apache Flink是一个流处理框架,可以处理大规模的实时数据流。Flink支持状态管理、窗口操作和事件时间语义等特性,使其成为处理大规模实时数据的理想选择。然而,在实际应用中,Flink需要与其他系统进行集成,以实现更高效的数据处理。

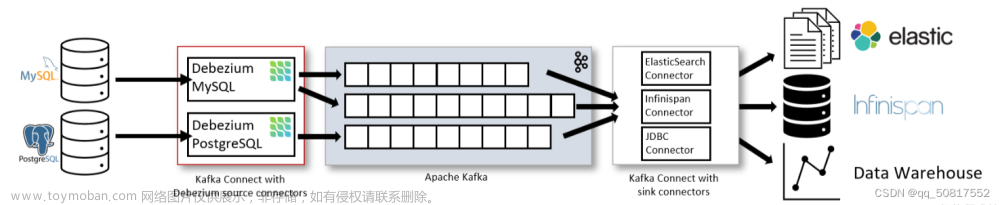

数据库是存储和管理数据的核心组件,在许多应用中,Flink需要与数据库进行集成,以实现数据的持久化和查询。Kafka是一个分布式消息系统,可以用于构建实时数据流管道。在许多应用中,Flink需要与Kafka进行集成,以实现数据的生产和消费。

本文将讨论Flink与数据库和Kafka集成的优化案例,并提供实际示例和解释。

2. 核心概念与联系

在Flink与数据库和Kafka集成的过程中,有几个核心概念需要了解:

- Flink数据源(Source):Flink数据源是用于从外部系统(如数据库、Kafka等)读取数据的接口。

- Flink数据接收器(Sink):Flink数据接收器是用于将Flink处理结果写入外部系统(如数据库、Kafka等)的接口。

- Flink数据流:Flink数据流是用于表示数据处理过程的抽象。数据流可以包含多个操作,如映射、reduce、窗口等。

- Flink状态后端:Flink状态后端是用于存储和管理Flink任务状态的接口。

在Flink与数据库和Kafka集成的过程中,需要关注以下联系:

- 数据一致性:在Flink与数据库和Kafka集成的过程中,需要确保数据的一致性。这意味着,Flink需要确保数据库和Kafka中的数据是一致的。

- 性能优化:在Flink与数据库和Kafka集成的过程中,需要关注性能优化。这意味着,Flink需要确保数据库和Kafka之间的数据传输和处理是高效的。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

在Flink与数据库和Kafka集成的过程中,需要关注以下算法原理和操作步骤:

3.1 Flink数据源与数据库集成

Flink数据源可以是数据库、Kafka等外部系统。在Flink与数据库集成的过程中,需要关注以下步骤:

- 连接数据库:Flink需要连接到数据库,以读取数据。这可以通过JDBC或者OJDBC接口实现。

- 读取数据:Flink需要从数据库中读取数据。这可以通过执行SQL查询或者使用数据库驱动程序实现。

- 处理数据:Flink需要对读取的数据进行处理。这可以通过执行Flink数据流操作实现。

3.2 Flink数据接收器与Kafka集成

Flink数据接收器可以是数据库、Kafka等外部系统。在Flink与Kafka集成的过程中,需要关注以下步骤:

- 连接Kafka:Flink需要连接到Kafka,以写入数据。这可以通过Kafka连接器接口实现。

- 写入数据:Flink需要将处理结果写入Kafka。这可以通过执行Flink数据流操作实现。

- 处理数据:Flink需要对写入的数据进行处理。这可以通过执行Flink数据流操作实现。

3.3 Flink状态后端与数据库集成

Flink状态后端可以是数据库等外部系统。在Flink状态后端与数据库集成的过程中,需要关注以下步骤:

- 连接数据库:Flink需要连接到数据库,以存储和管理任务状态。这可以通过JDBC或者OJDBC接口实现。

- 存储状态:Flink需要将任务状态存储到数据库中。这可以通过执行SQL插入操作实现。

- 读取状态:Flink需要从数据库中读取任务状态。这可以通过执行SQL查询操作实现。

4. 具体最佳实践:代码实例和详细解释说明

在实际应用中,Flink与数据库和Kafka集成的最佳实践如下:

4.1 Flink数据源与数据库集成

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.table.api.EnvironmentSettings; import org.apache.flink.table.api.TableEnvironment; import org.apache.flink.table.api.java.StreamTableEnvironment; import org.apache.flink.table.descriptors.Schema; import org.apache.flink.table.descriptors.Source;

public class FlinkDataSourceExample { public static void main(String[] args) throws Exception { // 设置Flink执行环境 EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inStreamingMode().build(); StreamExecutionEnvironment env = StreamExecutionEnvironment.create(settings); TableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 设置数据库连接信息

Source<String> source = tableEnv.connect(new JDBC()

.version(1)

.drivername("org.postgresql.Driver")

.dbtable("SELECT * FROM my_table")

.username("username")

.password("password")

.host("localhost")

.port(5432)

.databaseName("my_database"))

.withFormat(new MyTableSource())

.inAppendMode(Source.AppendMode.Overwrite)

.createDescriptors(new Schema().schema("id INT, name STRING"));

// 创建Flink数据流

DataStream<String> dataStream = tableEnv.executeSql("SELECT * FROM source").getResult();

// 执行Flink数据流操作

dataStream.print();

env.execute("FlinkDataSourceExample");

}} ```

4.2 Flink数据接收器与Kafka集成

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.table.api.EnvironmentSettings; import org.apache.flink.table.api.TableEnvironment; import org.apache.flink.table.descriptors.Schema; import org.apache.flink.table.descriptors.Sink;

public class FlinkSinkExample { public static void main(String[] args) throws Exception { // 设置Flink执行环境 EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inStreamingMode().build(); StreamExecutionEnvironment env = StreamExecutionEnvironment.create(settings); TableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 设置Kafka连接信息

Sink<String> sink = tableEnv.executeSql("SELECT * FROM source").getResult()

.insertInto("kafka", new Schema().schema("id INT, name STRING"))

.inAppendMode(Sink.AppendMode.Overwrite)

.withFormat(new MyTableSink())

.inSchema(new Schema().schema("id INT, name STRING"))

.to("kafka-01:9092")

.withProperty("topic", "my_topic")

.withProperty("bootstrap.servers", "kafka-01:9092")

.withProperty("producer.required.acks", "1")

.withProperty("key.serializer", "org.apache.kafka.common.serialization.StringSerializer")

.withProperty("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

env.execute("FlinkSinkExample");

}} ```

4.3 Flink状态后端与数据库集成

```java import org.apache.flink.runtime.state.StateInitializationContext; import org.apache.flink.runtime.state.StateInitializationTime; import org.apache.flink.runtime.state.FunctionInitializationTime; import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.table.api.EnvironmentSettings; import org.apache.flink.table.api.TableEnvironment; import org.apache.flink.table.descriptors.Schema; import org.apache.flink.table.descriptors.Descriptor; import org.apache.flink.table.descriptors.Descriptors; import org.apache.flink.table.descriptors.Source; import org.apache.flink.table.descriptors.Sink; import org.apache.flink.table.descriptors.FileSystem; import org.apache.flink.table.descriptors.Format; import org.apache.flink.table.descriptors.Schema; import org.apache.flink.table.descriptors.Schema.Field; import org.apache.flink.table.descriptors.Schema.RowType; import org.apache.flink.table.descriptors.Schema.Field.DataType;

public class FlinkStateBackendExample { public static void main(String[] args) throws Exception { // 设置Flink执行环境 EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inStreamingMode().build(); StreamExecutionEnvironment env = StreamExecutionEnvironment.create(settings); TableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 设置数据库连接信息

Source<String> source = tableEnv.connect(new JDBC()

.version(1)

.drivername("org.postgresql.Driver")

.dbtable("SELECT * FROM my_table")

.username("username")

.password("password")

.host("localhost")

.port(5432)

.databaseName("my_database"))

.withFormat(new MyTableSource())

.inAppendMode(Source.AppendMode.Overwrite)

.createDescriptors(new Schema().schema("id INT, name STRING"));

// 创建Flink数据流

DataStream<String> dataStream = tableEnv.executeSql("SELECT * FROM source").getResult();

// 执行Flink数据流操作

dataStream.print();

env.execute("FlinkStateBackendExample");

}} ```

5. 实际应用场景

Flink与数据库和Kafka集成的实际应用场景包括:

- 实时数据处理:Flink可以与数据库和Kafka集成,以实现实时数据处理。例如,可以将实时数据从Kafka中读取,进行处理,并将处理结果写入数据库。

- 数据同步:Flink可以与数据库和Kafka集成,以实现数据同步。例如,可以将数据库中的数据同步到Kafka,以实现数据的分发和处理。

- 数据持久化:Flink可以与数据库集成,以实现数据的持久化。例如,可以将Flink处理结果写入数据库,以实现数据的持久化和查询。

6. 工具和资源推荐

在Flink与数据库和Kafka集成的过程中,可以使用以下工具和资源:

- Apache Flink:Flink是一个流处理框架,可以用于实时数据处理和分析。Flink提供了丰富的API和功能,可以用于实现数据库和Kafka集成。

- Apache Kafka:Kafka是一个分布式消息系统,可以用于构建实时数据流管道。Kafka提供了丰富的API和功能,可以用于实现数据库和Flink集成。

- Flink Connectors:Flink Connectors是Flink的一组连接器,可以用于实现Flink与数据库和Kafka集成。Flink Connectors提供了丰富的API和功能,可以用于实现数据库和Kafka集成。

7. 总结:未来发展趋势与挑战

Flink与数据库和Kafka集成的未来发展趋势和挑战包括:

- 性能优化:Flink与数据库和Kafka集成的性能优化是未来发展的关键。需要关注性能瓶颈和优化措施,以提高Flink与数据库和Kafka集成的性能。

- 可扩展性:Flink与数据库和Kafka集成的可扩展性是未来发展的关键。需要关注如何实现Flink与数据库和Kafka集成的可扩展性,以应对大规模数据处理场景。

- 安全性:Flink与数据库和Kafka集成的安全性是未来发展的关键。需要关注如何实现Flink与数据库和Kafka集成的安全性,以保护数据的安全和隐私。

8. 附录:常见问题

8.1 如何选择合适的Flink Connector?

在选择合适的Flink Connector时,需要考虑以下因素:

- 数据源类型:根据数据源类型选择合适的Flink Connector。例如,如果需要与数据库集成,可以选择Flink JDBC Connector;如果需要与Kafka集成,可以选择Flink Kafka Connector。

- 数据格式:根据数据格式选择合适的Flink Connector。例如,如果需要处理JSON数据,可以选择Flink JSON Connector。

- 性能:根据性能需求选择合适的Flink Connector。例如,如果需要高性能的数据处理,可以选择Flink RocksDB Connector。

8.2 Flink与数据库集成时,如何处理数据类型不匹配?

在Flink与数据库集成时,如果数据类型不匹配,可以采用以下方法处理:文章来源:https://www.toymoban.com/news/detail-830934.html

- 数据类型转换:可以在Flink数据流中进行数据类型转换,以实现数据类型匹配。例如,可以将字符串类型的数据转换为整型数据。

- 数据映射:可以在Flink数据流中进行数据映射,以实现数据类型匹配。例如,可以将数据库中的数据映射到Flink中的数据结构。

8.3 Flink与Kafka集成时,如何处理数据序列化和反序列化?

在Flink与Kafka集成时,数据序列化和反序列化是关键步骤。可以采用以下方法处理:文章来源地址https://www.toymoban.com/news/detail-830934.html

-

自定义序列化类:可以自定义序列化类,以实现数据序列化和反序列化。例如,可以自定义一个类,实现

org.apache.flink.api.common.serialization.SimpleStringSchema接口,以实现数据序列化和反序列化。 -

使用第三方库:可以使用第三方库,如

FlinkKafkaConsumer和FlinkKafkaProducer,实现数据序列化和反序列化。这些库提供了丰富的API和功能,可以用于实现数据序列化和反序列化。

参考文献

到了这里,关于实时Flink的数据库与Kafka集成优化案例的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!