一、研究现状

早期图像生成方法主要是变分自动编码器(Variational Autoencoders, VAEs),该算法利用编码器和解码器以及变分推断的方法学习隐空间到真实图像空间的映射从而完成图像的生成。其优势是特征空间可迁移并且训练较为稳定,但是不容易进行模型评估,当输入的图像数据的分布情况复杂时,其学习到的特征泛化能力不足,而且生成的图像模糊。

生成对抗网络(Generative Adversarial Networks, GAN)通过生成器与判别器的动态博弈来优化模型,允许以良好的感知质量对高分辨率图像进行有效采样,生成的图像比较清晰。但该方法模型训练不稳定并难以捕捉完整的数据分布。

最近,扩散模型(Diffusion Model, DM)在分布估计和生成样本质量方面取得了最先进的结果。扩散模型一步一步地向原始数据中加入高斯噪声来破坏训练数据,随后训练神经网络来扭转整个破坏过程,即通过逐渐去噪过程直至消除掉噪声,从而将纯噪声转化为高质量图像。但该模型依赖于长的马尔可夫链的扩散步骤来产生样本,计算资源和时间占用过高。

二、研究出发点

扩散模型属于基于最大似然估计的生成模型类,容易花费过多的计算资源来学习数据中难以察觉的细节。尽管可以通过对相应损失项的低采样忽略感知上无关紧要的细节,但这一步仍然需要在像素空间中进行昂贵的函数计算,这导致了巨大的计算时间和能源需求。

因此,本文提出将VAE与DM结合,把压缩感知信息与生成图像的过程分离来避免这一缺陷。

三、创新点

1.通过自动编码器(Autoencoder, AE)压缩数据,将扩散过程在隐空间(Latent Space)进行,极大地减小了扩散模型的计算量,并保持生成图片的质量不变。

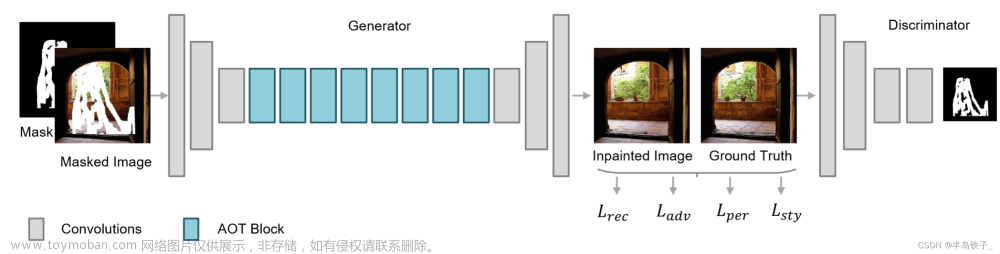

模型结构如上图所示。在训练过程中,输入样本的x通过AE的Encoder进行压缩至隐空间。扩散模型的正向扩散和反向生成过程都是在隐空间进行完成的。

具体来说,给定图像  ,我们可以先利用一个编码器

,我们可以先利用一个编码器 来将图像编码到潜在表示空间

来将图像编码到潜在表示空间 ,其中

,其中  ,然后再用解码器从潜在表示空间重建图片

,然后再用解码器从潜在表示空间重建图片 。在感知压缩压缩的过程中,下采样因子的大小 f=H/h=W/w

。在感知压缩压缩的过程中,下采样因子的大小 f=H/h=W/w 。

。

这种方法的另一个显著优势是,自编码器只需训练一次或采用预训练的模型,因此可以将其用于训练多次DM完全不同的任务。这使得对各种图像到图像和文本到图像任务的大量扩散模型的有效探索成为可能。

2.设计了一种基于交叉注意力的通用条件生成控制机制,能够实现多模态的训练。

为了进行有条件的图片生成,即根据控制信息来指导反向去噪过程,需要拓展得到一个条件时序去噪自编码器(conditional denoising autoencoder) ,通过 y 来控制图片合成的过程。

,通过 y 来控制图片合成的过程。

具体来说,论文通过在UNet主干网络上增加交叉注意力机制来实现 。为了能够从多个不同的模态预处理 y ,论文引入了一个领域专用编码器(domain specific encoder)

。为了能够从多个不同的模态预处理 y ,论文引入了一个领域专用编码器(domain specific encoder) ,它用来将 y 映射为一个中间表示 ,以引入各种形态的条件,如文本、类别等。最终模型就可以通过一个交叉注意力层映射将控制信息融入到UNet的中间层,交叉注意力层的实现如下:

,它用来将 y 映射为一个中间表示 ,以引入各种形态的条件,如文本、类别等。最终模型就可以通过一个交叉注意力层映射将控制信息融入到UNet的中间层,交叉注意力层的实现如下:

四、实验设计及验证

本文实验主要验证了LDMs(Latent Diffusion Models)模型的性能。本文设计了大量的对比实验,分别对压缩比率因子、隐空间有效性、条件扩散进行了验证。并测试了该模型在超分辨率、图像修复等任务中的表现。

实验一:感知压缩权衡(Perceptual Compression Tradeoffs)

调整AE中encoder下采样f,如果f=1那就等于没有对输入进行压缩,本文对比了f在{1,2,4, 8, 16, 32}下的效果,如果f越大,则信息压缩越严重,会造成图片失真,但是训练资源则占用越少,反之f约小则训练的会越慢。对比实验的结果如下图所示。

可见,f在{4-16}之间可以比较好的平衡效率与视觉感知效果。作者重点推荐了LDM-4和LDM-8。

实验二:对比生成图片的质量

本文对LDMs的样本生成能力从两方面进行对比实验,一是生成样本的质量,二是生成样本的多样性。实验数据使用的是CelebA-HQ、FFHQ和LSUN-Churches/Bedrooms,实验结果如下图所示。

其效果超过了GANs和LSGM,并且对于比同为扩散模型的DDPM效果要好,与ADM的效果接近,说明了隐空间的确保留了主要的特征信息。

实验三:条件扩散

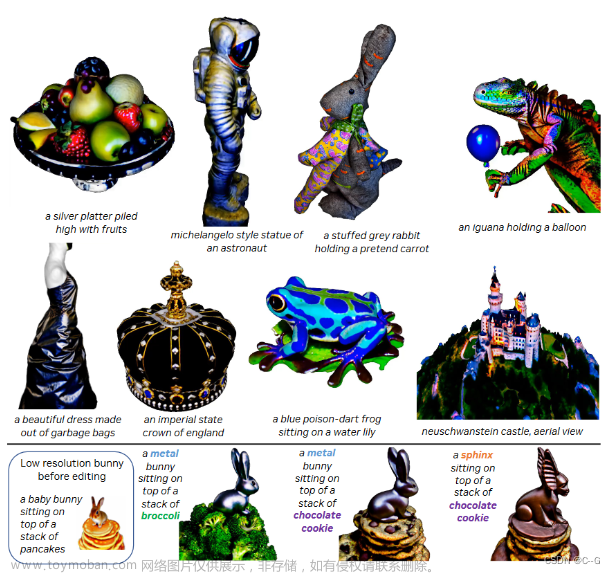

本文通过在Unet模型结构上添加交叉注意力机制的方式可以适配多类条件的图像生成任务,例如text-to-image任务上,训练数据为LAION-400M,文章展示了实验结果如下:

实验四:模型的通用性

作者测试了LDMs在根据语义信息生成图像、图像超分辨率及图像修复等应用方向上的性能,均取得了极佳的效果。

五、论文结论

- LDMs可以显著提高去噪扩散模型的训练和采样效率,而不降低模型的质量。

2. LDMs可以在诸多图像生成任务中显示出优于先有方法的性能。文章来源:https://www.toymoban.com/news/detail-831238.html

六、不足之处文章来源地址https://www.toymoban.com/news/detail-831238.html

- 该模型仍是一个大模型,有着高达859M的参数量。

- 模型生成的图片中存在许多“似是而非”的物体,说明模型并不真正理解各个物体的形态,可以通过更细致的标签或是引入先验的物体结构模型解决这一问题。

- 生成的图片中有的并不符合透视法,或在空间结构上不符合客观规律。针对这一问题,可以将扩散模型与NeRF相结合,将二维图像升维成三维结构后再投影到二维来解决遮挡等空间推理问题。

到了这里,关于High-Resolution Image Synthesis with Latent Diffusion Models 稳定扩散模型论文笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[CVPR-23-Highlight] Magic3D: High-Resolution Text-to-3D Content Creation](https://imgs.yssmx.com/Uploads/2024/02/642215-1.png)