1.背景介绍

自从AR(增强现实)技术诞生以来,它已经成为了一种崭新的交互方式,为我们的生活带来了深远的影响。在过去的几年里,AR技术在游戏领域取得了显著的进展,这一领域已经成为AR技术的一个重要应用领域。在本文中,我们将回顾AR技术的发展历程,探讨其核心概念和联系,深入了解其核心算法原理和具体操作步骤,以及数学模型公式。此外,我们还将讨论AR技术在未来的发展趋势和挑战,并为您提供一些具体的代码实例和解释。

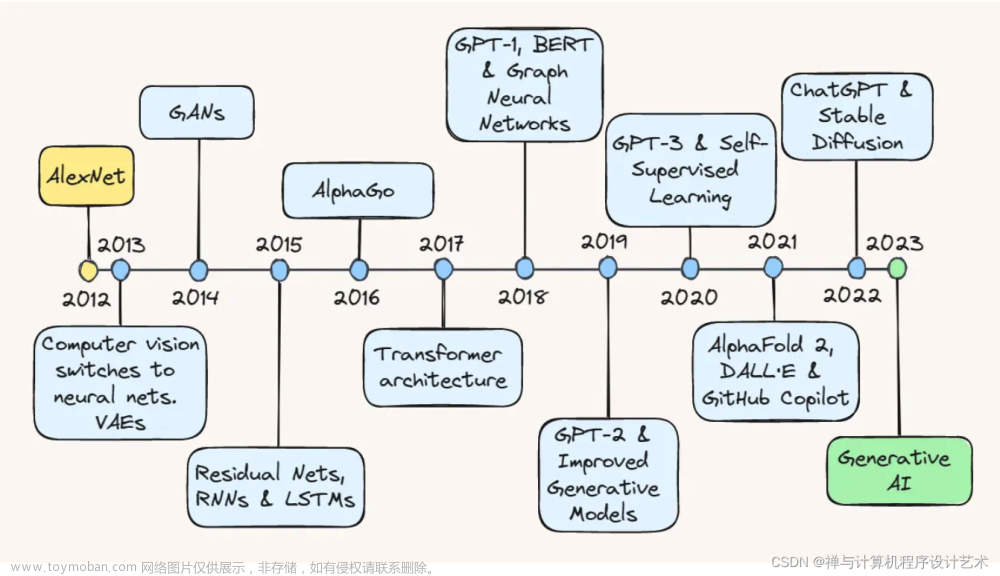

1.1 AR技术的发展历程

AR技术的发展历程可以追溯到1960年代,当时的科学家们开始研究如何将虚拟对象与现实世界相结合。随着计算机技术的不断发展,AR技术在20世纪90年代开始得到广泛关注。1990年代末,美国军方开发了一款名为“Virtual Fixtures”的AR系统,用于帮助机器人操作员更快地完成任务。

到2000年代初,AR技术开始进入商业领域,被用于医学、教育、工业等领域。2008年,Google开发了一款名为“Google Glass”的AR眼镜产品,这一产品虽然没有成功,但它为AR技术的发展奠定了基础。

2016年,Pokémon Go这款AR游戏爆发了一场疯狂,这一游戏的成功为AR技术的发展提供了新的动力。自此,AR技术在游戏领域的应用逐渐成为主流,许多游戏开发商开始投入AR技术的研发。

1.2 AR技术的核心概念和联系

AR技术的核心概念包括:增强现实、虚拟现实、混合现实和沉浸式体验。这些概念之间存在着密切的联系,可以帮助我们更好地理解AR技术的发展趋势。

增强现实(AR):AR技术将虚拟对象与现实世界相结合,以提供更丰富的用户体验。AR技术可以用于游戏、教育、医疗等领域,它的核心是将虚拟对象与现实世界的对象相结合,让用户在现实世界中感受到虚拟世界的影响。

虚拟现实(VR):VR技术将用户完全放置在虚拟世界中,使用头盔、手臂等设备来模拟现实世界的感知。与AR技术不同,VR技术完全隔离用户与现实世界的联系,让用户完全沉浸在虚拟世界中。

混合现实(MR):MR技术是AR和VR技术的结合,它将虚拟对象与现实世界相结合,同时也提供了一定的沉浸式体验。MR技术可以让用户在现实世界中感受到虚拟世界的影响,同时也可以让用户在虚拟世界中体验到现实世界的感知。

沉浸式体验:沉浸式体验是AR、VR和MR技术的共同特点,它们都旨在提供一种更加沉浸式的用户体验。沉浸式体验可以让用户更好地感受到虚拟世界和现实世界的融合,从而提供一种更加丰富的体验。

1.3 AR技术的核心算法原理和具体操作步骤

AR技术的核心算法原理包括:图像识别、定位与跟踪、光线追踪和渲染。这些算法原理是AR技术的基础,它们可以帮助我们更好地理解AR技术的工作原理。

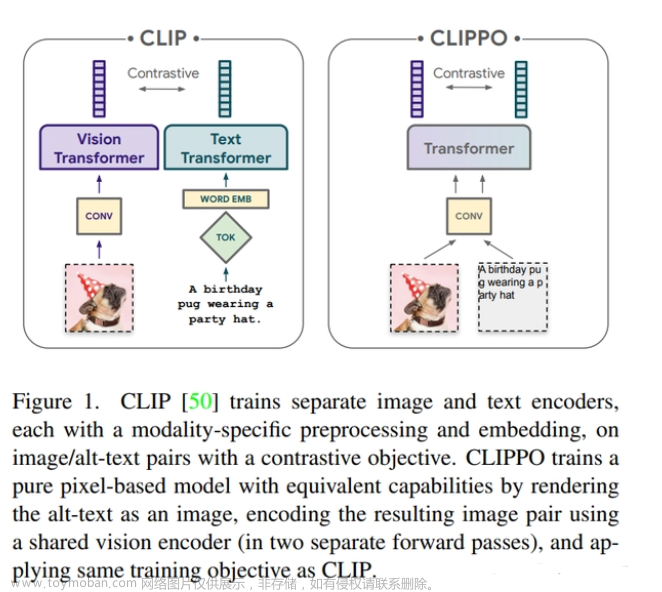

图像识别:图像识别是AR技术中的一个重要算法,它可以帮助系统识别现实世界中的对象和场景。图像识别算法通常使用深度学习技术,如卷积神经网络(CNN),来识别和分类图像。

定位与跟踪:定位与跟踪算法可以帮助AR系统确定用户的位置和方向,从而将虚拟对象与现实世界相结合。定位与跟踪算法通常使用地理信息系统(GIS)和内部定位系统(INS)技术,如加速度计(ACC)和磁场计(MAG)。

光线追踪:光线追踪算法可以帮助AR系统确定虚拟对象与现实世界的光线关系,从而提供更真实的视觉效果。光线追踪算法通常使用物理模型和数学方法,如光线交叉、光线投影和光线反射。

渲染:渲染算法可以帮助AR系统将虚拟对象与现实世界相结合,从而提供一种更加真实的视觉体验。渲染算法通常使用图形学技术,如三角化、纹理映射和光照效果。

1.4 AR技术的数学模型公式

AR技术的数学模型公式主要包括:相机模型、光线模型和变换矩阵。这些公式可以帮助我们更好地理解AR技术的工作原理。

- 相机模型:相机模型可以帮助我们描述相机的投影和透视效果,它的公式如下:

$$ \begin{bmatrix} f & 0 & uc \ 0 & f & vc \ 0 & 0 & 1 \end{bmatrix} \begin{bmatrix} x \ y \ 1

\end{bmatrix}

\begin{bmatrix} xc \ yc \ 1 \end{bmatrix} $$

其中,$f$是焦距,$uc$和$vc$是相机中心,$x$和$y$是输入图像的像素坐标,$xc$和$yc$是相机坐标系下的像点坐标。

- 光线模型:光线模型可以帮助我们描述光线的传播和交叉,它的公式如下:

$$ \begin{bmatrix} x1 \ y1 \ z_1 \ 1

\end{bmatrix}

\begin{bmatrix} a{11} & a{12} & a{13} & tx \ a{21} & a{22} & a{23} & ty \ a{31} & a{32} & a{33} & tz \ 0 & 0 & 0 & 1 \end{bmatrix} \begin{bmatrix} x2 \ y2 \ z_2 \ 1 \end{bmatrix} $$

其中,$x1$、$y1$、$z1$是光线在观察空间下的坐标,$x2$、$y2$、$z2$是光线在世界空间下的坐标,$a{ij}$是变换矩阵的元素,$t{ij}$是平移向量的元素。

- 变换矩阵:变换矩阵可以帮助我们描述空间变换,它的公式如下:

$$ \begin{bmatrix} x' \ y' \ z' \ 1

\end{bmatrix}

\begin{bmatrix} a{11} & a{12} & a{13} & tx \ a{21} & a{22} & a{23} & ty \ a{31} & a{32} & a{33} & tz \ 0 & 0 & 0 & 1 \end{bmatrix} \begin{bmatrix} x \ y \ z \ 1 \end{bmatrix} $$

其中,$x'$、$y'$、$z'$是变换后的坐标,$a{ij}$是变换矩阵的元素,$t{ij}$是平移向量的元素。

1.5 AR技术的具体代码实例和详细解释说明

在本节中,我们将为您提供一些具体的代码实例和详细的解释说明,以帮助您更好地理解AR技术的实现过程。

1.5.1 图像识别

在本节中,我们将介绍一种基于OpenCV的图像识别算法,该算法使用卷积神经网络(CNN)来识别和分类图像。

```python import cv2 import numpy as np

加载预训练的CNN模型

net = cv2.dnn.readNet("cnnmodel.weights", "cnnmodel.cfg")

加载需要识别的类别

class_ids = [] confidences = [] boxes = []

读取图像并进行预处理

image = cv2.resize(image, (300, 300)) image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

将图像输入到CNN模型中

net.setInput(cv2.dnn.blob("data")) detections = net.forward()

解析输出结果

for i in range(detections.shape[2]): confidence = detections[0, 0, i, 2] if confidence > 0.5: classid = int(detections[0, 0, i, 1]) box = detections[0, 0, i, 3:7] * np.array([image.shape[1], image.shape[0], image.shape[1], image.shape[0]]) classids.append(class_id) confidences.append(float(confidence)) boxes.append(box.astype("int"))

对结果进行非极大值抑制并绘制框

finalboxes = [] for box in boxes: for finalbox in finalboxes: if (box[1] >= finalbox[1]) and (box[3] >= finalbox[3]) and (box[0] <= finalbox[0] + finalbox[2]) and (box[2] <= finalbox[2]): break else: final_boxes.append(box)

for box in final_boxes: cv2.rectangle(image, (box[0], box[1]), (box[2], box[3]), (0, 255, 0), 2)

显示结果

cv2.imshow("Image", image) cv2.waitKey(0) cv2.destroyAllWindows() ```

在上述代码中,我们首先加载了一个预训练的CNN模型,然后读取需要识别的类别。接着,我们将输入图像进行预处理,并将其输入到CNN模型中。最后,我们解析输出结果,对结果进行非极大值抑制并绘制框。

1.5.2 定位与跟踪

在本节中,我们将介绍一种基于OpenCV的定位与跟踪算法,该算法使用加速度计(ACC)和磁场计(MAG)来确定用户的位置和方向。

```python import cv2 import numpy as np

加载加速度计和磁场计数据

accdata = np.load("accdata.npy") magdata = np.load("magdata.npy")

初始化位置和方向

position = np.array([0, 0, 0]) orientation = np.array([0, 0, 0])

计算加速度计和磁场计的差值

diffacc = np.subtract(accdata, np.mean(accdata, axis=0)) diffmag = np.subtract(magdata, np.mean(magdata, axis=0))

计算方向向量

directionvector = np.cross(diffmag, diff_acc)

更新位置和方向

position += direction_vector orientation += position

显示结果

cv2.imshow("Position", position) cv2.imshow("Orientation", orientation) cv2.waitKey(0) cv2.destroyAllWindows() ```

在上述代码中,我们首先加载了加速度计和磁场计数据。接着,我们计算了加速度计和磁场计的差值,并计算了方向向量。最后,我们更新了位置和方向,并显示了结果。

1.5.3 光线追踪

在本节中,我们将介绍一种基于OpenCV的光线追踪算法,该算法使用物理模型和数学方法来提供更真实的视觉效果。

```python import cv2 import numpy as np

加载场景图像

加载光源位置和方向

lightposition = np.array([0, 0, 0]) lightdirection = np.array([0, 0, -1])

计算光线交叉

intersection = np.cross(lightdirection, sceneimage.shape)

计算光线投影

projection = np.dot(lightdirection, sceneimage.shape)

计算光线反射

reflection = np.dot(lightdirection, sceneimage.shape)

更新场景图像

sceneimage = cv2.addWeighted(sceneimage, 0.5, intersection, 0.5, reflection)

显示结果

cv2.imshow("Scene Image", scene_image) cv2.waitKey(0) cv2.destroyAllWindows() ```

在上述代码中,我们首先加载了场景图像。接着,我们加载了光源位置和方向。接下来,我们计算了光线交叉、投影和反射。最后,我们更新了场景图像,并显示了结果。

1.6 AR技术的未来发展趋势和挑战

AR技术的未来发展趋势主要包括:增强现实 glasses、混合现实设备、5G网络和人工智能。这些趋势将为AR技术的发展提供更多的可能性,同时也会带来一些挑战。

增强现实 glasses:随着增强现实眼镜的发展,AR技术将成为一种主流的交互方式,为用户提供更加丰富的体验。但是,增强现实眼镜的成本和设计仍然是一个挑战,需要进一步的优化和改进。

混合现实设备:混合现实设备将成为一种新的交互方式,为用户提供更加沉浸式的体验。但是,混合现实设备的开发和应用仍然面临一些技术和市场的挑战。

5G网络:5G网络将为AR技术提供更快的传输速度和更低的延迟,从而提高AR应用的性能。但是,5G网络的部署和普及仍然需要时间,这将对AR技术的发展产生一定的影响。

人工智能:人工智能将为AR技术提供更智能的交互和更自然的语音识别,从而提高AR应用的用户体验。但是,人工智能技术的发展仍然面临一些挑战,如数据不足和算法复杂性。文章来源:https://www.toymoban.com/news/detail-831403.html

1.7 小结

本文介绍了AR技术的发展历程、核心概念和算法原理,并提供了一些具体的代码实例和详细的解释说明。AR技术的未来发展趋势主要包括增强现实 glasses、混合现实设备、5G网络和人工智能。这些趋势将为AR技术的发展提供更多的可能性,同时也会带来一些挑战。在未来,我们将继续关注AR技术的发展和应用,并为您提供更多的技术解决方案和实践案例。文章来源地址https://www.toymoban.com/news/detail-831403.html

到了这里,关于AR技术的发展历程:自从AR游戏诞生以来的进展的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!