大数据技术原理与应用实验指南——HBase安装与编程实践

一、 实验目的

(1) 熟练使用HBase操作常用的Shell命令。

(2) 熟悉HBase操作常用的Java API。

二、 实验内容

(1) 安装HBase软件。

(2) 编程实现指定功能,并利用Hadoop提供的Shell命令完成相同的任务(实现增、删、改、查基本操作,统计表的行数,打印表的记录等操作)。

三、 实验平台(软件版本)

VirtualBox-6.1.4

jdk-8u162-linux-x64.tar

ubuntukylin-16.04-desktop-amd64

hadoop-3.1.3

FileZilla_3.17.0.0_win64_setup 这是一个用于将windows文件与linux互相传的软件-

hbase-2.2.2-bin.tar.gz

四、 实验步骤 (全分布环境下搭建HBase ——一主三从并实现 HBase 的Java Api )

实验思维导图:

- 全分布环境下搭建HBase

(1)下载安装Hbase,将Hbase传送至linux系统上的根目录下。

(2)解压安装包hbase-2.2.2-bin.tar.gz至路径 /usr/local,命令如下:

$ cd ~

$ sudo tar -zxvf ~/hbase-2.2.2-bin.tar.gz -C /usr/local

(3)将解压的文件名hbase-2.2.2改为hbase,以方便使用,命令如下:

$ cd /usr/local

$ sudo mv ./hbase-2.2.2 ./hbase

(4)下面把hbase目录权限赋hadoop用户:

$ cd /usr/local

$ sudo chown -R hadoop ./hbase

(5)配置环境变量,集群上的每个节点都要配置:

$ vim ~/.bashrc

在尾部加:(之后保存退出)

export HBASE_HOME=/usr/local/hbase

export PATH=$PATH:$HBASE_HOME/bin

改变的每个节点的~/.bashrc后的结果如图所示

$ source ~/.bashrc #使配置生效!!千万不能忘记

(6)修改hbase的配置文件:

① hbase-env.sh文件的修改:

注意:hbase-env.sh中本来就存在如下这些变量的配置,大家只需要删除前面的#并修改配置内容即可(#代表注释)

$ cd /usr/local/hbase/conf #切换到配置文件的目录

$ vim hbase-env.sh

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

#因为是分布式的hbase安装,所以要在hbase-env.sh里设置java环境变量

#修改HBASE_CLASSPATH帮助找到hbase

export HBASE_CLASSPATH=/usr/local/hbase/conf

图中给出上下文,便于寻找

export HBASE_MANAGES_ZK=true#因为使用hbase自带的zookeeper,所以将HBASE_MANAGES_ZK设为true

图中给出上下文,便于寻找

$ source hbase-env.sh #使得配置生效!!!不能忘记

② hbase-site.xml文件的修改:

$ vim hbase-site.xml

配置的内容如下:将原来 …中添加如下内容

<property>

<name>hbase.rootdir</name>

<value>hdfs://Master:9000/hbase</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/hadoop/zookeeper</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>Master,Slave1,Slave2,Slave3</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

参数解释如下:

a) hbase.rootdir,用于指定HBase数据的存储位置,因为如果不设置的话,hbase.rootdir默认为/tmp/hbase-${user.name},这意味着每次重启系统都会丢失数据。

b) hbase.cluster.distributed 值为 ture设置集群处于分布式模式.

c)hbase.zookeeper.property.dataDir:用于指定HBase自带的ZooKeeper存储数据的本地路径

e)hbase.zookeeper.quorum:对于HBase的完全分布式模式(使用HBase内置的ZooKeeper),应将该参数的值设置为作为内置zookeeper的主机列表,此时在配置文件hbase-env.sh中的HBASE_MANAGES_ZK参数必须为true

修改hbase-env.sh结果如图所示

③配置regionservers文件

$ sudo vim regionservers #此文件在/usr/local/hbase/conf下

配置所有节点的主机名,类似于hadoop里的slave文件,也是一行一个。(如下表所示)

Master

Slave1

Slave2

Slave3

④拷贝Hadoop的两个配置文件core-site.xml和hdfs-site.xml到HBase的配置文件目录(HBase对HDFS有依赖关系)

依次执行命令

$ cp /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf

$ cp /usr/local/hadoop/etc/hadoop/hdfs-site.xml /usr/local/hbase/conf

(7) 将配置过的整个hbase文件使用scp命令传输到各个slave上:

依次执行命令

$ cd /usr/local/hbase/conf # 切换到配置文件所在目录

$ scp hbase-env.sh hbase-site.xml core-site.xml hdfs-site.xml regionservers hadoop@Slave1:/usr/local/hbase/conf/

$ scp hbase-env.sh hbase-site.xml core-site.xml hdfs-site.xml regionservers hadoop@Slave2:/usr/local/hbase/conf/

$ scp hbase-env.sh hbase-site.xml core-site.xml hdfs-site.xml regionservers hadoop@Slave3:/usr/local/hbase/conf/

别忘了要在所有节点执行如下命令,使得HBase的配置参数生效:

$ source hbase-env.sh

(8)启动Hbase:(请在启动前确保集群(一主三从)已经启动)

$ start-hbase.sh

启动过程如图所示

$ jps #使用jps进行检验是否所有进程启动

主节点启动结果如图所示

从节点启动结果如图所示

自此HBase的配置便全部结束了

- 实现 HBase 的shell编程与Java Api

(1)进入shell界面

$ hbase shell

进入shell界面如图所示

初步测试,shell中list命令的结果如图所示

(2) shell命令交互

a) 表格操作

# 列出已有表格

> list

# 建立表格

> create 'student','Sname','Ssex','Sage','Sdept','course'

# 查看表格信息

> describe 'student'

创建表格后查看表格信息结果如图所示

b) 数据操作:增删改查(在student表格上测试)

改:在添加数据时,HBase会自动为添加的数据添加一个时间戳,故在需要修改数据时,只需直接添加数据,HBase即会生成一个新的版本,从而完成“改”操作

# 增加数据:一次只能为一个单元格添加一个数据,实际一般利用编程操作数据。

> put 'student','95001', 'Sname','LiYing'

> put 'student','95001', 'course:math','80'

> list

# 查看数据

> get 'student','95001' # 查看表的某一行数据

> scan 'student' # 查看某个表的全部数据

> deleteall 'student','95001' # 删除一行数据

> scan 'student' #查看删除一行数据后的结果

> get 'student','95001' #查看表结果

# 删除数据

> delete 'student','95001','Sname' # 删除一个数据

# 删除表格:第一步先让该表不可用,第二步才能删除表。

> disable 'student'

> drop 'student'

以上代码实现的结果如图所示

c) 查询表历史数据:(查询表的历史版本,需要两步。)

#创建表的时候,指定保存的版本数(假设指定为5)

$ create 'teacher',{NAME=>'username',VERSIONS=>5}

#插入数据然后更新数据,使其产生历史版本数据,注意:这里插入数据和更新数据都是用put命令

$ put 'teacher','91001','username','Mary'

$ put 'teacher','91001','username','Mary1'

$ put 'teacher','91001','username','Mary2'

$ put 'teacher','91001','username','Mary3'

$ put 'teacher','91001','username','Mary4'

$ put 'teacher','91001','username','Mary5'

#查询时,指定查询的历史版本数。默认会查询出最新的数据。(有效取值为1到5)

$ get 'teacher','91001',{COLUMN=>'username',VERSIONS=>5}

以上查询历史的结果截图如下:

d) 退出shell界面的操作如下

hbase(main):002:0> exit #退出Shell命令,注意:这里退出HBase数据库是退出对数据库表的操作,而不是停止启动HBase数据库后台运行。

(3)HBase Java API编程实践

a) 启动Eclipse,启动以后,出现如下图所示界面,点击界面右下角的“Launch”按钮

b) 启动进入Eclipse以后的程序开发界面如下图所示。

c) 点击界面顶部的“File”菜单,在弹出的子菜单如下图所示中选择“New”,再选择子菜单中的“Java Project”。

d) 这时会弹出一个java project 创建对话框,在“Project name”文本框中输入“HBaseExample”,在“JRE”选项卡中选中第2项“Use a project specific JRE”,然后点击界面底部的“Next”按钮。在弹出的界面中,用鼠标点击“Libraries”选项卡,然后,点击界面右侧的“Add External JARs…”按钮,

导入下图文件中的包:步骤如下面两张图所示:

全部导入完毕后,点击OK即可

e) 在界面左侧的“HBaseExample”工程名称上单击鼠标右键,在弹出的菜单中选择“New”,再在弹出的子菜单中选择“Class”。创建一个新的类ExampleForHBase

ExampleForHBase.java代码内容如图所示:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.*;

import org.apache.hadoop.hbase.client.*;

import org.apache.hadoop.hbase.util.Bytes;

import java.io.IOException;

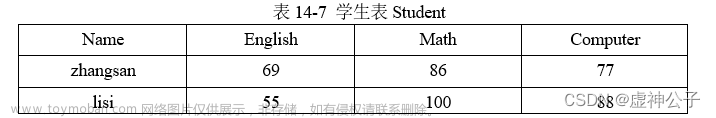

public class ExampleForHBase {

public static Configuration configuration;

public static Connection connection;

public static Admin admin;

public static void main(String[] args)throws IOException{

init();

createTable("student",new String[]{"score"});

insertData("student","zhangsan","score","English","69");

insertData("student","zhangsan","score","Math","86");

insertData("student","zhangsan","score","Computer","77");

getData("student", "zhangsan", "score","English");

close();

}

public static void init(){

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir","hdfs://192.168.43.49:9000/hbase");

try{

connection = ConnectionFactory.createConnection(configuration);

admin = connection.getAdmin();

}catch (IOException e){

e.printStackTrace();

}

}

public static void close(){

try{

if(admin != null){

admin.close();

}

if(null != connection){

connection.close();

}

}catch (IOException e){

e.printStackTrace();

}

}

public static void createTable(String myTableName,String[] colFamily) throws IOException {

TableName tableName = TableName.valueOf(myTableName);

if(admin.tableExists(tableName)){

System.out.println("talbe is exists!");

}else {

TableDescriptorBuilder tableDescriptor = TableDescriptorBuilder.newBuilder(tableName);

for(String str:colFamily){

ColumnFamilyDescriptor family =

ColumnFamilyDescriptorBuilder.newBuilder(Bytes.toBytes(str)).build();

tableDescriptor.setColumnFamily(family);

}

admin.createTable(tableDescriptor.build());

}

}

public static void insertData(String tableName,String rowKey,String colFamily,String col,String val) throws IOException {

Table table = connection.getTable(TableName.valueOf(tableName));

Put put = new Put(rowKey.getBytes());

put.addColumn(colFamily.getBytes(),col.getBytes(), val.getBytes());

table.put(put);

table.close();

}

public static void getData(String tableName,String rowKey,String colFamily, String col)throws IOException{

Table table = connection.getTable(TableName.valueOf(tableName));

Get get = new Get(rowKey.getBytes());

get.addColumn(colFamily.getBytes(),col.getBytes());

Result result = table.get(get);

System.out.println(new String(result.getValue(colFamily.getBytes(),col==null?null:col.getBytes())));

table.close();

}

}

在开始运行ExampleForHBase.java程序之前,需要启动HDFS和HBase。

代码运行结果如图所示:

在shell中检验上述代码是否真的运行成功如图所示:

**五、**完成情况与问题讨论

(1) 实际完成情况

a) 完成HBase全分布搭建

b) 完成hbase的shell部分命令

c) HBase的Java API操作

(2) 问题与讨论

问题一:出现HBase启动一段时间后,HMaster消失的现象?

解决:在hbase的conf文件中修改hbase-site.xml文件,加入如下一句话:

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

问题二:对于全分布与伪分布的了解不是特别详细,使得对于在配置文件,默认加载src下的配置文件总是配置不对?

解决:文章来源:https://www.toymoban.com/news/detail-831449.html

//全分布

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir","hdfs://192.168.43.49:9000/hbase");

//192.168.43.49是全分布namenode的ip地址

/***********************/

//伪分布

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir","hdfs://localhost:9000/hbase");

.unsafe.stream.capability.enforce

false

文章来源地址https://www.toymoban.com/news/detail-831449.html

问题二:对于全分布与伪分布的了解不是特别详细,使得对于在配置文件,默认加载src下的配置文件总是配置不对?

解决:

```java

//全分布

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir","hdfs://192.168.43.49:9000/hbase");

//192.168.43.49是全分布namenode的ip地址

/***********************/

//伪分布

configuration = HBaseConfiguration.create();

configuration.set("hbase.rootdir","hdfs://localhost:9000/hbase");

到了这里,关于大数据技术原理与应用实验指南——HBase编程实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!