1.背景介绍

1. 背景介绍

ClickHouse 是一个高性能的列式数据库,主要用于日志分析和实时数据处理。Kafka 是一个分布式流处理平台,用于构建实时数据流管道和流处理应用程序。在现代数据处理系统中,ClickHouse 和 Kafka 是常见的组件,它们之间的整合可以实现更高效的数据处理和分析。

本文将涵盖 ClickHouse 与 Kafka 的整合方法、最佳实践、实际应用场景和未来发展趋势。

2. 核心概念与联系

2.1 ClickHouse

ClickHouse 是一个高性能的列式数据库,它的核心特点是支持快速的数据读写操作。ClickHouse 使用列式存储,即将数据按列存储,而不是行式存储。这使得 ClickHouse 能够在查询时快速跳过不需要的列,从而提高查询速度。

ClickHouse 还支持多种数据类型,如整数、浮点数、字符串、日期等,以及一些特定的数据类型,如 IP 地址、URL、UUID 等。此外,ClickHouse 支持数据压缩、数据分区和数据索引等优化技术,以提高数据存储和查询效率。

2.2 Kafka

Kafka 是一个分布式流处理平台,它的核心特点是支持高吞吐量的数据传输和存储。Kafka 使用分区和副本机制,实现了数据的分布式存储和并行处理。Kafka 支持生产者-消费者模式,即生产者将数据发送到 Kafka 集群,消费者从 Kafka 集群中读取数据进行处理。

Kafka 还支持数据压缩、数据索引和数据消费者群集等优化技术,以提高数据传输和处理效率。

2.3 ClickHouse 与 Kafka 的联系

ClickHouse 与 Kafka 的整合可以实现以下目的:

- 将 Kafka 中的实时数据流转化为 ClickHouse 中的表格数据,以便进行快速的数据分析和查询。

- 将 ClickHouse 中的分析结果存储到 Kafka 中,以便在其他系统中使用。

- 实现 ClickHouse 和 Kafka 之间的数据同步,以确保数据的一致性和实时性。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 ClickHouse 与 Kafka 的整合算法原理

ClickHouse 与 Kafka 的整合可以通过以下算法原理实现:

- 数据生产者将数据发送到 Kafka 集群。

- Kafka 集群将数据分发到 ClickHouse 数据库。

- ClickHouse 数据库将数据存储到磁盘上,并建立索引。

- 数据消费者从 ClickHouse 数据库中读取数据进行处理。

3.2 具体操作步骤

整合 ClickHouse 与 Kafka 的具体操作步骤如下:

- 安装并配置 ClickHouse 数据库。

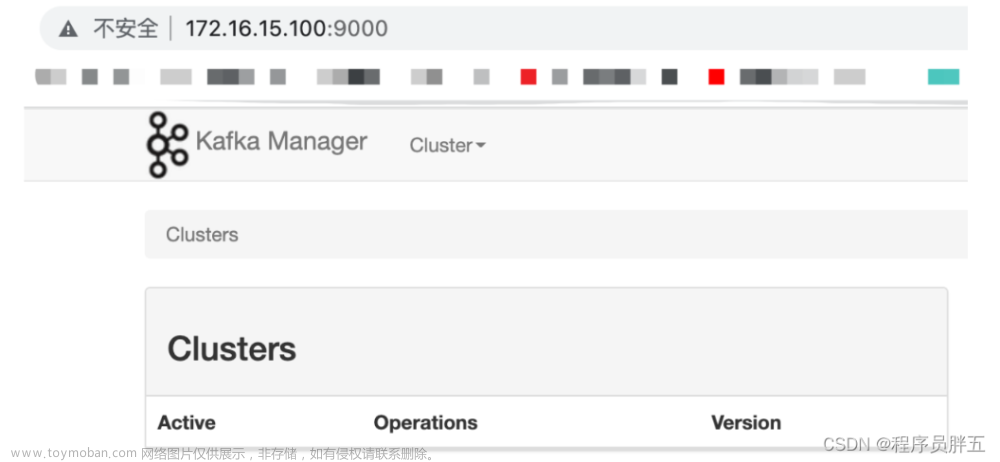

- 安装并配置 Kafka 集群。

- 创建 ClickHouse 数据库和表。

- 配置 Kafka 生产者将数据发送到 ClickHouse 数据库。

- 配置 ClickHouse 数据库将数据存储到 Kafka 集群。

- 配置数据消费者从 ClickHouse 数据库中读取数据进行处理。

3.3 数学模型公式详细讲解

在 ClickHouse 与 Kafka 的整合过程中,可以使用以下数学模型公式来描述数据处理和传输的效率:

- 吞吐量(Throughput):数据处理和传输的速度,单位为数据/时间。公式为:Throughput = 数据数量 / 处理时间。

- 延迟(Latency):数据处理和传输的时延,单位为时间。公式为:Latency = 处理时间。

- 吞吐率(Throughput Rate):数据处理和传输的效率,单位为数据/时间/功耗。公式为:Throughput Rate = 吞吐量 / 功耗。

4. 具体最佳实践:代码实例和详细解释说明

4.1 ClickHouse 数据库配置

在 ClickHouse 数据库中,需要创建一个用于存储 Kafka 数据的表。以下是一个示例表的定义:

sql CREATE TABLE kafka_data ( id UInt64, topic String, partition Int32, offset Int64, timestamp Int64, payload String, PRIMARY KEY (id, topic, partition, offset) ) ENGINE = MergeTree() PARTITION BY (topic, partition) ORDER BY (id, topic, partition, offset);

4.2 Kafka 生产者配置

在 Kafka 生产者中,需要配置数据发送到 ClickHouse 数据库的地址和端口。以下是一个示例生产者配置:

java Properties props = new Properties(); props.put("bootstrap.servers", "clickhouse-server:9000"); props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer"); props.put("topic", "kafka_data"); KafkaProducer<String, String> producer = new KafkaProducer<>(props);

4.3 ClickHouse 数据库插入数据

在 ClickHouse 数据库中,可以使用以下 SQL 语句插入 Kafka 数据:

sql INSERT INTO kafka_data (id, topic, partition, offset, timestamp, payload) VALUES (1, 'test_topic', 0, 100, 1514736000, 'Hello, ClickHouse!');

4.4 ClickHouse 数据库读取数据

在 ClickHouse 数据库中,可以使用以下 SQL 语句读取 Kafka 数据:

sql SELECT * FROM kafka_data WHERE topic = 'test_topic' AND partition = 0 AND offset > 100;

4.5 Kafka 消费者配置

在 Kafka 消费者中,需要配置数据从 ClickHouse 数据库读取的地址和端口。以下是一个示例消费者配置:

java Properties props = new Properties(); props.put("bootstrap.servers", "clickhouse-server:9000"); props.put("group.id", "kafka_data_group"); props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); props.put("topic", "kafka_data"); KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

5. 实际应用场景

ClickHouse 与 Kafka 的整合可以应用于以下场景:

- 实时数据分析:将 Kafka 中的实时数据流转化为 ClickHouse 中的表格数据,以便进行快速的数据分析和查询。

- 日志分析:将日志数据发送到 Kafka 集群,并将其存储到 ClickHouse 数据库,以便进行快速的日志查询和分析。

- 实时数据处理:将 ClickHouse 中的分析结果存储到 Kafka 集群,以便在其他系统中使用。

6. 工具和资源推荐

- ClickHouse 官方网站:https://clickhouse.com/

- Kafka 官方网站:https://kafka.apache.org/

- ClickHouse 文档:https://clickhouse.com/docs/en/

- Kafka 文档:https://kafka.apache.org/documentation.html

7. 总结:未来发展趋势与挑战

ClickHouse 与 Kafka 的整合可以实现更高效的数据处理和分析,但也存在一些挑战:

- 数据一致性:在 ClickHouse 与 Kafka 的整合过程中,需要确保数据的一致性和实时性。

- 性能优化:需要对 ClickHouse 与 Kafka 的整合过程进行性能优化,以提高数据处理和传输的效率。

- 扩展性:需要考虑 ClickHouse 与 Kafka 的整合过程的扩展性,以适应不断增长的数据量和流量。

未来,ClickHouse 与 Kafka 的整合可能会在大数据处理和实时分析领域取得更大的应用。

8. 附录:常见问题与解答

Q: ClickHouse 与 Kafka 的整合过程中,如何确保数据的一致性?

A: 可以使用 Kafka 的分区和副本机制,以及 ClickHouse 的事务和索引机制,来确保数据的一致性。

Q: ClickHouse 与 Kafka 的整合过程中,如何优化性能?

A: 可以使用 Kafka 的压缩和分区机制,以及 ClickHouse 的压缩、分区和索引机制,来优化性能。

Q: ClickHouse 与 Kafka 的整合过程中,如何扩展性?文章来源:https://www.toymoban.com/news/detail-831503.html

A: 可以使用 Kafka 的分布式集群和 ClickHouse 的分布式集群,来实现扩展性。文章来源地址https://www.toymoban.com/news/detail-831503.html

到了这里,关于ClickHouse与Kafka的整合的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!