标题:Task Offloading Optimization in Mobile Edge Computing based on Deep Reinforcement Learning

会议:MSWiM ’23 (CCF-C)

注:本文仅用户学习。

一、知识梳理

问题:边缘计算可以很好地缓解云计算网络拥塞和高通信开销等问题。然而,考虑到边缘计算资源是有限的,需要采用合理的优化策略提高首先资源的利用率。

模型:为解决上述问题,本文提出了一个agent辅助管理用户卸载的计算卸载方案,在考虑到电能、计算和通信约束下做出智能决策。目的是最小化实验和能耗的加权和,优化策略是卸载策略。

算法:Advantage Actor-Critic (A2C)算法。

二、模型介绍

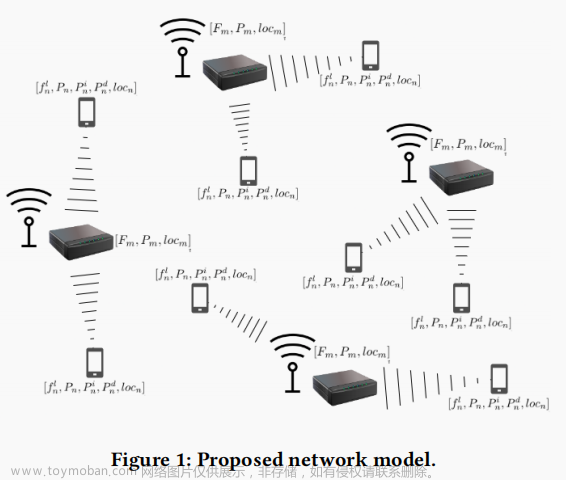

该框架包含一个agent,M个Edge Servers (ESs)和N Mobile Devices (MDs),其中M={1,2,...m,...,M},N={1,2,...,n,...,N}。

2.1 本地计算

MD n 本地计算的时延和能耗可以表示为:

其中Dn表示任务量大小,表示设备n每秒CPU的周期数,表示每CPU周期数产生的能耗。因此,本地计算的总成本为:

其中。

2.2 边缘计算

MD n的任务卸载给ES m的上行传输时延和能耗为:

其中表示卸载数据量的大小,表示设备传输功率。然后,ES m的处理时延为:

同时,MD在空闲时的功耗为:

其中,表示ES m的总计算资源量,表示卸载到ES m的任务数目量,表示计算的CPU周期数,表示空闲功耗。此外,任务结果下行的传输时延和设备空闲功耗为:

其中表示计算的结果大小,表示下载的功耗。任务的总时延和总能耗为:

因此,最后的总成本为:

则计算卸载决策所产生的总成本为:

由此可知。因此,MEC系统的平均成本和最坏情况的成本为:

2.3 问题公式

总成本的优化目标为:

2.4问题转化

上述问题转为MDP问题为:

状态空间:表示状态空间,包含所有请求的任务。其中, (生成的计算任务量,计算结果大小,所需的CPU周期数,时延权重,能耗权重)

动作空间:,表示动作空间。

转台转移矩阵: 表示转移概率分布 。

奖励函数:,最大化成本的负奖励。文章来源:https://www.toymoban.com/news/detail-831704.html

三、代码

代码:https://github.com/Carlos-Marques/rl-MEC-scheduler文章来源地址https://www.toymoban.com/news/detail-831704.html

到了这里,关于论文阅读06-Task Offloading Optimization in Mobile Edge Computing based on Deep Reinforcement Learning的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

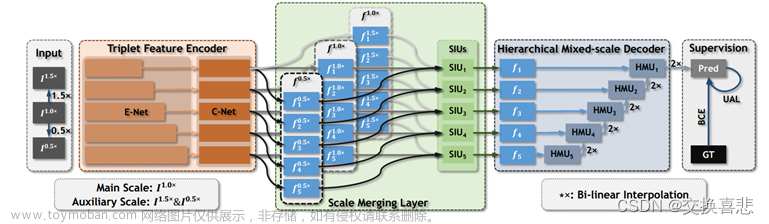

![[论文阅读] Revisiting Feature Propagation and Aggregation in Polyp Segmentation](https://imgs.yssmx.com/Uploads/2024/02/786537-1.jpeg)