2024年2月15日,OpenAI在其官网发布了《Video generation models as world simulators》的报告,该报告提出了作为世界模拟器的视频生成模型Sora。

OpenAI对Sora介绍如下:

We explore large-scale training of generative models on video data. Specifically, we train text-conditional diffusion models jointly on videos and images of variable durations, resolutions and aspect ratios.

We leverage a transformer architecture that operates on spacetime patches of video and image latent codes. Our largest model, Sora, is capable of generating a minute of high fidelity video. Our results suggest that scaling video generation models is a promising path towards building general purpose simulators of the physical world.

OpenAI利用视频数据对生成模型进行大规模训练。通过一种transformer架构对视频的时空序列包和图像潜在编码进行操作,在不同持续时间、分辨率和纵横比的视频和图像上联合训练了以文本为输入条件的扩散模型Sora。

目前,Sora已经能够生成最长一分钟的高保真视频,OpenAI也野心勃勃的提出:我们有望构建出能够模拟物理世界的通用模拟器。

1. 主要看点

看点一:60s超长长度

首先感受下Sora生成的一分钟视频:

Prompt: A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

openAI sora01

该视频一镜到底,主体人物稳定,背景真实,缝切流畅,可以看出Sora能够根据用户提供的文本描述,生成符合用户需要的、高品质、60S视频。

看点二:语言逻辑与物理规律

对于文生视频技术,在充分语义理解的基础上,关键是要生成符合逻辑、时间连续的视频。既要符合语义逻辑,又要符合物理规律,并且时间连贯的表现出来。

openAI sora02

之前的视频生成用的都是Diffusion,它把视频看作多个真实图片的组合,并未掌握真正的物理规律。

Sora把LLM和Diffusion结合,同时具备了理解世界和模拟世界的能力。

看点三:世界模型

OpenAI雄心勃勃的提出:

Simulating digital worlds. Sora is also able to simulate artificial processes–one example is video games. Sora can simultaneously control the player in Minecraft with a basic policy while also rendering the world and its dynamics in high fidelity. These capabilities can be elicited zero-shot by prompting Sora with captions mentioning “Minecraft.”

These capabilities suggest that continued scaling of video models is a promising path towards the development of highly-capable simulators of the physical and digital world, and the objects, animals and people that live within them.

视频模型的持续扩展为模拟物理世界提供了一条充满希望的道路。

通过模拟生活在这些世界中的物体、动物和人等实体,我们可以更深入地理解现实世界的运行规律,并开发出更加逼真、自然的视频生成技术。

2. 核心技术

(1)将视觉数据转化为 patchs

在可视数据的处理上借鉴了大语言模型的成功经验,这些模型通过对互联网规模的数据进行训练,获得了强大的通用能力。同样,我们考虑如何将这种优势引入到可视数据的生成式模型中。

大语言模型通过token将各种形式的文本代码、数学和自然语言统一起来,而Sora则通过视觉包(patchs)实现了类似的效果。我们发现,对于不同类型的视频和图像,包是一种高度可扩展且有效的表示方式,对于训练生成模型具有重要意义。

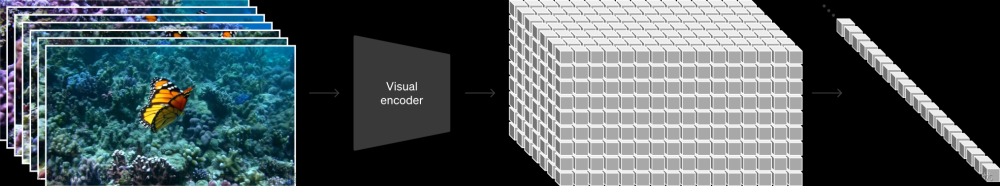

在更高层次上,我们首先将视频压缩到一个低维度的潜在空间:这是通过对视频进行时间和空间上的压缩实现的。这个潜在空间可以看作是一个“时空包”的集合,从而将原始视频转化为这些包。

(2)视频压缩网络(Video compression network)

我们训练了一个网络,专门负责降低视觉数据的维度。这个网络接收原始视频作为输入,并输出经过压缩的潜在表示。Sora模型就是在这个压缩后的潜在空间中接受训练,并最终生成视频。此外,我们还设计了一个解码器模型,它可以将生成的潜在表示重新映射回像素空间,从而生成可视的视频或图像。

(3)时空包(Spacetime Latent Patches)

当给定一个压缩后的输入视频时,我们会从中提取出一系列的时空包,这些包被用作转换token。这一方案不仅适用于视频,因为视频本质上就是由连续帧构成的,所以图像也可以看作是单帧的视频。通过这种基于包的表示方式,Sora能够跨越不同分辨率、持续时间和纵横比的视频和图像进行训练。在推理阶段,我们只需在适当大小的网格中安排随机初始化的包,就可以控制生成视频的大小和分辨率。

(4)用于视频生成的缩放Transformers

Sora是一个扩散模型(diffusion transformer),它接受输入的噪声包(以及如文本提示等条件性输入信息),然后被训练去预测原始的“干净”包。重要的是,Sora是一个基于扩散的转换器模型,这种模型已经在多个领域展现了显著的扩展性,包括语言建模、计算机视觉以及图像生成等领域。

3. 未来思考

(1)大佬如何看

马斯克的前女友格莱姆斯发布了一连串帖子,讨论这项新技术对电影以及更广泛的艺术创作的影响。马斯克在其中一条帖子下回应称:“AI增强的人类将在未来几年里创造出最好的作品。”

英伟达人工智能研究院Jim Fan表示“如果你还是把Sora当做DALLE那样的生成式玩具,还是好好想想吧,这是一个数据驱动的物理引擎。” 言外之意,AI已经可以读懂物理规律。

(2)主要影响

视频创作行业规则将被永远的改变了,

生成式视频也意味着虚假信息会真到无以复加。

(3)哲学思考

句子是实在的图像;因为当我理解一个句子,我就知道它所表述的情况,而且无须向我解释其意义,我就理解这个句子。

—— 《逻辑哲学论》(维特根斯坦)

语言使智人能有效传递信息,通力合作,不断完成物理世界的任务,最终成为世界主人。

因此,语言本身就是世界模型。文章来源:https://www.toymoban.com/news/detail-831716.html

总之

好好思考

把话说好

剩下的

交给AI。文章来源地址https://www.toymoban.com/news/detail-831716.html

到了这里,关于全面解读视频生成模型Sora的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!