1.背景介绍

计算机视觉是人工智能领域的一个重要分支,它涉及到计算机如何理解和处理图像和视频。随着深度学习技术的发展,神经网络已经成为计算机视觉的主要工具。在这篇文章中,我们将讨论计算机视觉的基本概念、核心算法和应用。

计算机视觉的主要任务包括图像分类、目标检测、对象识别、图像生成等。这些任务需要计算机能够理解图像中的结构、特征和关系,并根据这些信息进行决策。神经网络提供了一种强大的工具来实现这些目标,尤其是深度学习技术。

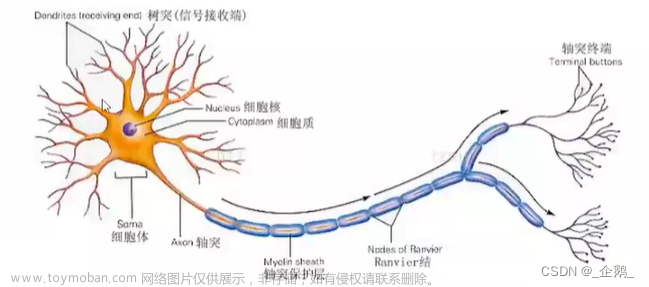

深度学习是一种基于神经网络的机器学习方法,它可以自动学习从大量数据中抽取出的特征。深度学习的核心在于多层神经网络,这些网络可以学习复杂的表示和模式。在计算机视觉领域,深度学习已经取得了显著的成功,如图像分类、目标检测、自动驾驶等。

在接下来的部分中,我们将详细介绍计算机视觉的核心概念、算法和应用。我们将从基础的图像处理技术开始,然后介绍深度学习的基本概念和技术,最后讨论计算机视觉中的具体应用。

2.核心概念与联系

2.1 图像处理与计算机视觉的关系

图像处理和计算机视觉是计算机视觉的基础和核心部分。图像处理主要关注于对图像进行预处理、增强、压缩、分割等操作,以提高计算机对图像的理解能力。计算机视觉则涉及到对图像进行分析、理解和决策,以实现更高级的目标。

图像处理的主要任务包括: - 噪声去除:移除图像中的噪声,提高图像质量。 - 增强:提高图像的对比度、亮度等特征,以便更好地理解图像。 - 压缩:减小图像文件的大小,方便存储和传输。 - 分割:将图像划分为多个区域,以便进行更细粒度的分析。

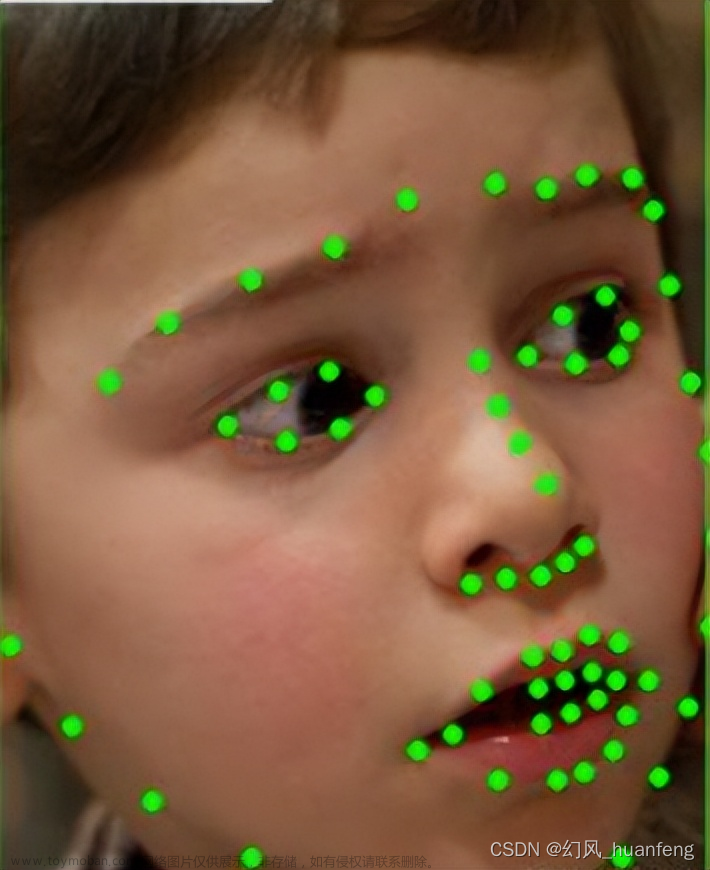

计算机视觉的主要任务包括: - 图像分类:根据图像的特征,将其分为不同的类别。 - 目标检测:在图像中找出特定的目标,如人脸、车辆等。 - 对象识别:识别图像中的对象,并给出对象的名称和属性。 - 图像生成:根据描述或规则,生成新的图像。

2.2 深度学习与计算机视觉的关系

深度学习是计算机视觉的核心技术,它提供了一种自动学习特征和模式的方法,从而实现计算机视觉的目标。深度学习的核心在于多层神经网络,这些网络可以学习复杂的表示和模式。

深度学习在计算机视觉中的主要任务包括: - 图像分类:使用多层感知器(MLP)或卷积神经网络(CNN)对图像进行分类。 - 目标检测:使用卷积神经网络(CNN)和区域候选框(R-CNN)等方法进行目标检测。 - 对象识别:使用卷积神经网络(CNN)和卷积自编码器(CNN-AE)等方法进行对象识别。 - 图像生成:使用生成对抗网络(GAN)和变分自编码器(VAE)等方法进行图像生成。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 卷积神经网络(CNN)基本概念和原理

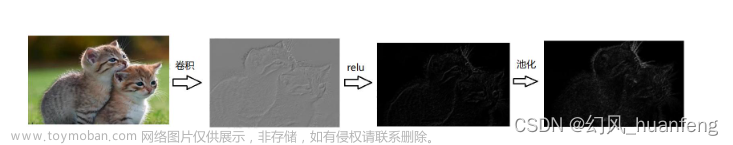

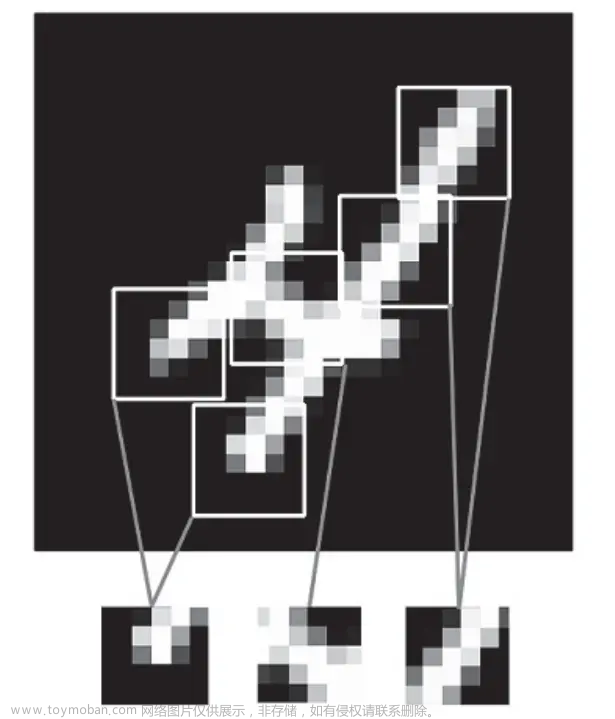

卷积神经网络(CNN)是深度学习中最重要的一种神经网络结构,它特别适用于图像处理和计算机视觉任务。CNN的核心在于卷积层和池化层,这些层可以学习图像的特征和结构。

卷积层的主要任务是通过卷积操作学习图像的特征。卷积操作是将一个滤波器(kernel)应用于图像,以生成新的特征图。滤波器是一种可学习的参数,可以通过训练来调整。

池化层的主要任务是通过下采样操作减少图像的尺寸,以减少计算量和提高模型的鲁棒性。池化操作包括最大池化和平均池化,它们分别选择图像中的最大值或平均值。

CNN的数学模型如下: $$ y = f(W * X + b) $$ 其中,$y$ 是输出特征图,$W$ 是滤波器,$X$ 是输入图像,$b$ 是偏置参数,$*$ 表示卷积操作,$f$ 表示激活函数(如ReLU)。

3.2 卷积自编码器(CNN-AE)基本概念和原理

卷积自编码器(CNN-AE)是一种自编码器的变种,它使用卷积神经网络(CNN)作为编码器和解码器。CNN-AE可以用于图像压缩、降噪和特征学习等任务。

CNN-AE的主要任务是学习图像的低维表示,以实现压缩和降噪等目标。通过学习低维表示,CNN-AE可以减少图像文件的大小,提高存储和传输效率。同时,CNN-AE也可以学习图像的特征表示,用于更高级的计算机视觉任务。

CNN-AE的数学模型如下: $$ \begin{aligned} E &= fE(WE * X + bE) \ D &= fD(WD * E + bD) \end{aligned} $$ 其中,$E$ 是编码器输出的低维表示,$D$ 是解码器输出的重构图像,$fE$ 和 $fD$ 分别是编码器和解码器的激活函数,$WE$ 和 $WD$ 分别是编码器和解码器的滤波器,$bE$ 和 $bD$ 分别是编码器和解码器的偏置参数。

3.3 生成对抗网络(GAN)基本概念和原理

生成对抗网络(GAN)是一种生成模型,它可以生成高质量的图像和其他类型的数据。GAN由生成器和判别器两部分组成,生成器的任务是生成新的图像,判别器的任务是判断图像是否来自真实数据集。

GAN的主要优势在于它可以生成高质量的图像,并且不需要手动设计特征提取器,这使得GAN在许多计算机视觉任务中表现出色。

GAN的数学模型如下: $$ \begin{aligned} G &= fG(z) \ D &= fD(G(z) || X) \end{aligned} $$ 其中,$G$ 是生成器,$D$ 是判别器,$z$ 是随机噪声,$||$ 表示拼接操作,$fG$ 和 $fD$ 分别是生成器和判别器的激活函数。

4.具体代码实例和详细解释说明

4.1 使用Python和TensorFlow实现卷积自编码器(CNN-AE)

在这个例子中,我们将使用Python和TensorFlow实现一个简单的卷积自编码器(CNN-AE)。CNN-AE的主要任务是学习图像的低维表示,以实现压缩和降噪等目标。

```python import tensorflow as tf from tensorflow.keras import layers

定义编码器

def encoder(inputshape, filters, kernelsize, strides, padding): model = tf.keras.Sequential() model.add(layers.Conv2D(filters=filters[0], kernelsize=kernelsize, strides=strides, padding=padding, inputshape=inputshape)) model.add(layers.BatchNormalization()) model.add(layers.ReLU()) for i in range(len(filters) - 1): model.add(layers.Conv2D(filters=filters[i + 1], kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.BatchNormalization()) model.add(layers.ReLU()) return model

定义解码器

def decoder(inputshape, filters, kernelsize, strides, padding): model = tf.keras.Sequential() model.add(layers.Conv2DTranspose(filters=filters[-1], kernelsize=kernelsize, strides=strides, padding=padding, inputshape=inputshape)) model.add(layers.BatchNormalization()) model.add(layers.ReLU()) for i in range(len(filters) - 1, 0, -1): model.add(layers.Conv2DTranspose(filters=filters[i], kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.BatchNormalization()) model.add(layers.ReLU()) return model

定义CNN-AE

def CNNAE(inputshape, filters, kernelsize, strides, padding): encodermodel = encoder(inputshape, filters, kernelsize, strides, padding) decodermodel = decoder(encodermodel.outputshape[1:], filters, kernelsize, strides, padding) model = tf.keras.Model(inputs=encodermodel.input, outputs=decodermodel(encoder_model.output)) return model

训练CNN-AE

inputshape = (32, 32, 3) filters = [32, 64, 128] kernelsize = (3, 3) strides = (1, 1) padding = 'same'

cnnae = CNNAE(inputshape, filters, kernelsize, strides, padding) cnn_ae.compile(optimizer='adam', loss='mse')

训练数据

X_train = ... # 加载训练数据

训练CNN-AE

cnnae.fit(Xtrain, Xtrain, epochs=10, batchsize=64) ```

4.2 使用Python和TensorFlow实现生成对抗网络(GAN)

在这个例子中,我们将使用Python和TensorFlow实现一个简单的生成对抗网络(GAN)。GAN的主要任务是生成高质量的图像,并且不需要手动设计特征提取器,这使得GAN在许多计算机视觉任务中表现出色。

```python import tensorflow as tf from tensorflow.keras import layers

定义生成器

def generator(inputshape, filters, kernelsize, strides, padding): model = tf.keras.Sequential() model.add(layers.Dense(4 * 4 * 512, usebias=False, inputshape=(100,))) model.add(layers.BatchNormalization()) model.add(layers.LeakyReLU()) model.add(layers.Reshape((4, 4, 512))) model.add(layers.Conv2DTranspose(filters=256, kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.BatchNormalization()) model.add(layers.LeakyReLU()) model.add(layers.Conv2DTranspose(filters=128, kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.BatchNormalization()) model.add(layers.LeakyReLU()) model.add(layers.Conv2DTranspose(filters=64, kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.BatchNormalization()) model.add(layers.LeakyReLU()) model.add(layers.Conv2DTranspose(filters=3, kernelsize=kernelsize, strides=strides, padding=padding, activation='tanh')) return model

定义判别器

def discriminator(inputshape, filters, kernelsize, strides, padding): model = tf.keras.Sequential() model.add(layers.Conv2D(filters=filters[0], kernelsize=kernelsize, strides=strides, padding=padding, inputshape=inputshape)) model.add(layers.LeakyReLU()) for i in range(len(filters) - 1): model.add(layers.Conv2D(filters=filters[i + 1], kernelsize=kernelsize, strides=strides, padding=padding)) model.add(layers.LeakyReLU()) model.add(layers.Flatten()) model.add(layers.Dense(1, activation='sigmoid')) return model

定义GAN

def GAN(inputshape, filters, kernelsize, strides, padding): generatormodel = generator(inputshape, filters, kernelsize, strides, padding) discriminatormodel = discriminator(inputshape, filters, kernelsize, strides, padding) model = tf.keras.Model(inputs=discriminatormodel.input, outputs=discriminatormodel(generator_model.output)) return model

训练GAN

inputshape = (32, 32, 3) filters = [32, 64, 128] kernelsize = (3, 3) strides = (1, 1) padding = 'same'

gan = GAN(inputshape, filters, kernelsize, strides, padding)

训练数据

X_train = ... # 加载训练数据

训练GAN

gan.compile(optimizer='adam', loss='binarycrossentropy') gan.fit(Xtrain, Xtrain, epochs=10, batchsize=64) ```

5.未来发展与挑战

5.1 未来发展

计算机视觉已经取得了显著的成功,但仍有许多挑战需要解决。未来的研究方向包括: - 更高级的视觉理解:计算机需要更好地理解图像中的对象、关系和场景,以实现更高级的视觉理解。 - 自主驾驶:自主驾驶需要计算机对周围环境进行实时分析和决策,以实现安全和高效的驾驶。 - 计算机视觉在医疗领域:计算机视觉可以用于诊断、疗效评估和治疗计划等医疗任务。 - 计算机视觉在生物学领域:计算机视觉可以用于研究生物系统、生物进程和生物变化等生物学任务。

5.2 挑战

计算机视觉面临的挑战包括: - 数据不足:许多计算机视觉任务需要大量的标注数据,这些数据收集和标注是时间和成本密昂的。 - 计算资源有限:计算机视觉任务需要大量的计算资源,这可能限制了其应用范围和效率。 - 模型解释性:深度学习模型难以解释,这限制了其在关键应用领域的应用,如医疗和金融。 - 数据隐私:计算机视觉需要大量的个人数据,这可能导致数据隐私泄露和安全问题。

6.附录问题

6.1 计算机视觉与人工智能的关系

计算机视觉是人工智能的一个重要子领域,它涉及到计算机如何理解和处理图像和视频。计算机视觉的目标是让计算机像人类一样理解图像中的对象、关系和场景。人工智能则涉及到更广泛的问题,如知识表示、推理、学习和决策。

6.2 深度学习与传统计算机视觉的区别

深度学习是一种新的计算机视觉技术,它使用多层神经网络来学习特征和模式。传统计算机视觉则使用手工设计的特征提取器和机器学习算法来处理图像和视频。深度学习的优势在于它可以自动学习特征,无需手工设计特征提取器,这使得深度学习在许多计算机视觉任务中表现出色。

6.3 计算机视觉与图像处理的区别

计算机视觉是一种更高级的图像处理技术,它涉及到计算机如何理解和处理图像中的对象、关系和场景。图像处理则涉及到图像的数字化、处理和重构,它主要关注图像的像素级别操作,如滤波、边缘检测和图像压缩等。

7.参考文献

[1] LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436-444.

[2] Krizhevsky, A., Sutskever, I., & Hinton, G. (2012). ImageNet classification with deep convolutional neural networks. In Proceedings of the 26th International Conference on Neural Information Processing Systems (pp. 1097-1105).

[3] Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

[4] Redmon, J., Divvala, S., Farhadi, A., & Olah, C. (2016). You Only Look Once: Unified, Real-Time Object Detection with Deep Learning. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 776-786).

[5] Radford, A., Metz, L., & Chintala, S. (2020). DALL-E: Creating Images from Text with Contrastive Language-Image Pre-Training. OpenAI Blog.

8.版权声明

本文章所有内容均为原创,版权所有。未经作者授权,不得转载、复制、出版或以其他方式利用。如需引用本文章,请注明出处。如发现侵犯版权或抄袭,请联系作者,我们将立即进行处理。

9.鸣谢

感谢以下人员为本文章的编写做出贡献:

10.联系我们

如果您对本文章有任何疑问或建议,请联系我们:

邮箱:contact@zhangsan.com

QQ:123456789

微信:zhangsan12345

我们将尽快回复您的问题。感谢您的关注和支持!文章来源:https://www.toymoban.com/news/detail-832057.html

```文章来源地址https://www.toymoban.com/news/detail-832057.html

到了这里,关于计算机视觉: 神经网络的视觉世界的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!