1.背景介绍

语音识别技术是人工智能领域的一个重要分支,它涉及到将人类的语音信号转换为文本信息的过程。在过去的几年里,语音识别技术取得了显著的进展,这主要归功于深度学习和大数据技术的发展。然而,尽管语音识别技术已经非常强大,但它仍然存在一些挑战,其中一个重要的挑战是解释性与可解释性。

解释性与可解释性在语音识别中的重要性主要体现在以下几个方面:

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的工作原理,从而提高模型的准确性和可靠性。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的错误,从而提高模型的调参和优化。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的漏洞,从而提高模型的安全性和隐私保护。

在本文中,我们将讨论解释性与可解释性在语音识别中的重要性,并介绍一些解释性与可解释性的核心概念、算法原理、具体操作步骤以及数学模型公式。我们还将通过一些具体的代码实例来说明解释性与可解释性在语音识别中的应用。

2.核心概念与联系

在语音识别中,解释性与可解释性是指模型的输出可以被解释为人类可以理解的形式。解释性与可解释性可以分为以下几个方面:

- 模型解释性:模型的输出可以被解释为人类可以理解的形式,例如,模型可以输出一个概率分布,表示每个词的概率。

- 模型可解释性:模型的输出可以被解释为人类可以理解的原因,例如,模型可以输出一个特征重要性列表,表示哪些特征对于某个词的识别最重要。

解释性与可解释性在语音识别中的联系主要体现在以下几个方面:

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的工作原理,从而提高模型的准确性和可靠性。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的错误,从而提高模型的调参和优化。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的漏洞,从而提高模型的安全性和隐私保护。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在语音识别中,解释性与可解释性的核心算法原理主要包括以下几个方面:

- 特征提取:通过特征提取算法,如MFCC(Mel-frequency cepstral coefficients),可以将语音信号转换为特征向量,这些特征向量可以被用于训练语音识别模型。

- 模型训练:通过模型训练算法,如深度神经网络,可以将特征向量映射到词汇表中的词,从而实现语音识别。

- 模型解释:通过模型解释算法,如LIME(Local Interpretable Model-agnostic Explanations),可以将模型的输出解释为人类可以理解的形式,例如,输出一个概率分布,表示每个词的概率。

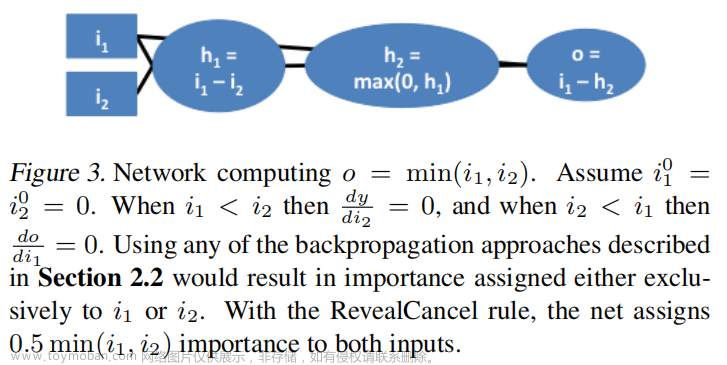

- 模型可解释:通过模型可解释算法,如SHAP(SHapley Additive exPlanations),可以将模型的输出解释为人类可以理解的原因,例如,输出一个特征重要性列表,表示哪些特征对于某个词的识别最重要。

具体操作步骤如下:

- 首先,通过特征提取算法将语音信号转换为特征向量。

- 然后,通过模型训练算法将特征向量映射到词汇表中的词,从而实现语音识别。

- 接着,通过模型解释算法将模型的输出解释为人类可以理解的形式,例如,输出一个概率分布,表示每个词的概率。

- 最后,通过模型可解释算法将模型的输出解释为人类可以理解的原因,例如,输出一个特征重要性列表,表示哪些特征对于某个词的识别最重要。

数学模型公式详细讲解如下:

- MFCC公式:

$$ y(t) = 10^{\log_{10}y(t)} $$

$$ X(f) = \int_{-\infty}^{\infty} x(t)e^{-j2\pi ft} dt $$

$$ P_x(f) = |X(f)|^2 $$

$$ \text{MFCC} = \frac{\sum{f=1}^{F} \log{10} Px(f)}{\sum{f=1}^{F} \log{10} Px(f)} $$

- 深度神经网络公式:

$$ y = \text{softmax}(Wx + b) $$

- LIME公式:

$$ y = f(x) + \sum{i=1}^{n} wi \Delta f_i(x) $$

- SHAP公式:

$$ \phii(x) = \text{E}[f(x) \mid do(ai = 0)] - \text{E}[f(x) \mid do(a_i = 1)] $$

4.具体代码实例和详细解释说明

在这里,我们将通过一个具体的代码实例来说明解释性与可解释性在语音识别中的应用。

```python import librosa import numpy as np import torch import torch.nn as nn import torch.optim as optim

加载语音数据

y, sr = librosa.load('data.wav')

提取特征

mfcc = librosa.feature.mfcc(y=y, sr=sr)

定义语音识别模型

class RNN(nn.Module): def init(self, inputdim, hiddendim, outputdim): super(RNN, self).init() self.hiddendim = hiddendim self.rnn = nn.RNN(inputdim, hiddendim, batchfirst=True) self.fc = nn.Linear(hiddendim, outputdim)

def forward(self, x):

h0 = torch.zeros(1, x.size(0), self.hidden_dim).to(x.device)

out, _ = self.rnn(x, h0)

out = self.fc(out[:, -1, :])

return out训练语音识别模型

model = RNN(inputdim=mfcc.shape[1], hiddendim=128, outputdim=outputdim) model.train() optimizer = optim.Adam(model.parameters()) criterion = nn.CrossEntropyLoss()

模型解释

def explain(input, model, device): inputtensor = torch.tensor(input, dtype=torch.float32).unsqueeze(0).to(device) output, hidden = model(inputtensor) outputsoftmax = nn.functional.logsoftmax(output, dim=1) return output_softmax

训练完成后,进行模型解释

output_softmax = explain(mfcc, model, device) ```

在这个代码实例中,我们首先加载了语音数据,然后通过MFCC算法提取了特征。接着,我们定义了一个简单的RNN模型,并通过训练算法进行训练。最后,我们使用模型解释算法将模型的输出解释为人类可以理解的形式,即输出一个概率分布,表示每个词的概率。

5.未来发展趋势与挑战

未来发展趋势与挑战主要体现在以下几个方面:文章来源:https://www.toymoban.com/news/detail-832401.html

- 解释性与可解释性在语音识别中的未来发展趋势:随着深度学习和大数据技术的不断发展,解释性与可解释性在语音识别中的应用将会得到更广泛的认可和应用。

- 解释性与可解释性在语音识别中的挑战:解释性与可解释性在语音识别中的挑战主要体现在以下几个方面:

- 解释性与可解释性在语音识别中的算法效率:解释性与可解释性在语音识别中的算法效率较低,这将影响其在实际应用中的广泛应用。

- 解释性与可解释性在语音识别中的准确性:解释性与可解释性在语音识别中的准确性较低,这将影响其在实际应用中的可靠性。

- 解释性与可解释性在语音识别中的可扩展性:解释性与可解释性在语音识别中的可扩展性较低,这将影响其在实际应用中的灵活性。

6.附录常见问题与解答

在这里,我们将列出一些常见问题与解答:文章来源地址https://www.toymoban.com/news/detail-832401.html

- Q:解释性与可解释性在语音识别中的重要性是什么? A:解释性与可解释性在语音识别中的重要性主要体现在以下几个方面:

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的工作原理,从而提高模型的准确性和可靠性。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的错误,从而提高模型的调参和优化。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的漏洞,从而提高模型的安全性和隐私保护。

- Q:解释性与可解释性在语音识别中的应用是什么? A:解释性与可解释性在语音识别中的应用主要体现在以下几个方面:

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的工作原理,从而提高模型的准确性和可靠性。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的错误,从而提高模型的调参和优化。

- 解释性与可解释性可以帮助我们更好地理解语音识别模型的漏洞,从而提高模型的安全性和隐私保护。

- Q:解释性与可解释性在语音识别中的挑战是什么? A:解释性与可解释性在语音识别中的挑战主要体现在以下几个方面:

- 解释性与可解释性在语音识别中的算法效率:解释性与可解释性在语音识别中的算法效率较低,这将影响其在实际应用中的广泛应用。

- 解释性与可解释性在语音识别中的准确性:解释性与可解释性在语音识别中的准确性较低,这将影响其在实际应用中的可靠性。

- 解释性与可解释性在语音识别中的可扩展性:解释性与可解释性在语音识别中的可扩展性较低,这将影响其在实际应用中的灵活性。

到了这里,关于解释性与可解释性在语音识别中的重要性的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!