目前,LLM大模型正以雨后春笋般出现,不同领域、厂家的大模型层出不穷,有支持本地微调、部署的开源大模型,也有提供 Web 及 API 服务的通用大模型。不同的大模型有着不同的调用方式及参数,比如讯飞星火认知大模型支持websocket 连接调用,文心一言则直接使用 request 调用,ChatGPT和智谱AI等有自己的开放API直接调用,可以说,各自之间都存在差异。对于不同调用方式的大模型,如果不能统一调用,就需要在程序代码中增加很多复杂的业务逻辑和细节,增加了程序开发的工作量,也增加了Bug和维护成本。

一、选择合适的在线大模型 API

目前,市面上有很多在线大模型 API 可供选择,具体如下,本文主要基于前四个模型开展。

- 清华大学的智谱AI大模型MaaS开放平台

- 科大讯飞的星火认知大模型

- 百度文心一言的千帆大模型

- 阿里巴巴的通义千问大模型

- Meta公司的LLaMA大模型

- OpenAI 的 ChatGPT 和 DALL-E

- Google AI 的 Bard或Gemini

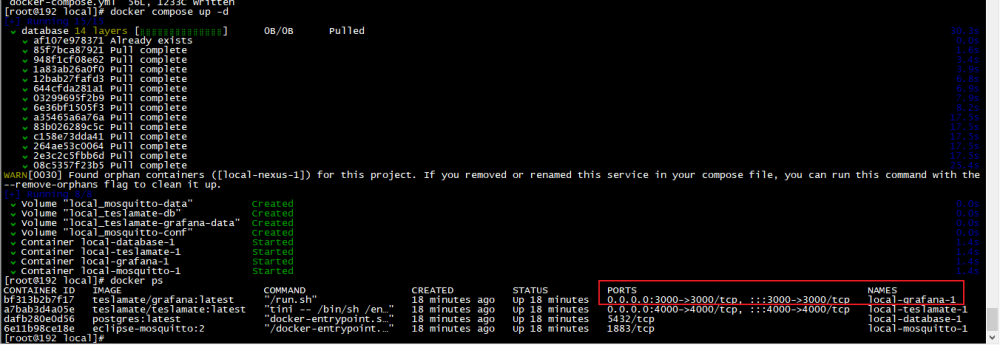

二、安装和配置本地 API 服务器

本地 API 服务器可以用来接收来自客户端的请求,并将其转发到在线大模型 API,在安装和配置本地 API 服务器时,主要考虑服务器的性能、稳定性和安全性。常用的本地 API 服务器包括:文章来源:https://www.toymoban.com/news/detail-832426.html

- FastAPI

- Flask

- Django

三、设计开发本地统一的API服务

通过设计开发统一的本地API服务,对不同的大模型 API 再进行一层封装,将其映射到本地接口上,文章来源地址https://www.toymoban.com/news/detail-832426.html

到了这里,关于如何将在线大模型的API 封装为本地 API服务的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!