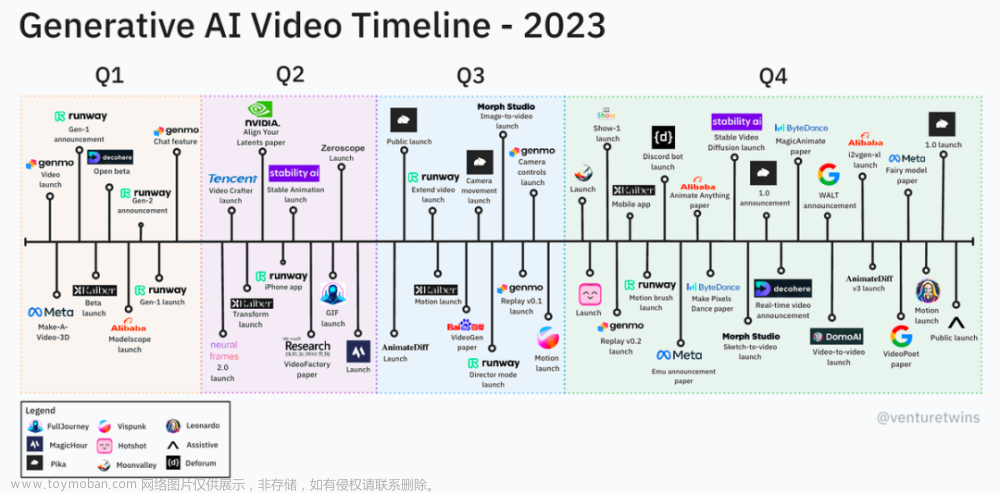

2023年是语言模型(llm)和图像生成技术激增的一年,但是视频生成受到的关注相对较少。今年刚到2月份,OpenAI就发布了一个惊人的视频生成模型Sora。虽然它的架构没有披露,但是通过总结现有的视频生成领域可能能对Sora的构架有所理解。

在这篇文章中,我们将整理视频生成在最近几年是发展概况,模型的架构是如何发展的,以及现在面临的突出问题。

我们以时间轴看作是一个观察视频生成模型演变的旅程。这将帮助我们理解为什么模型是这样设计的,并为未来的研究和应用工作提供见解。

2022年4月:Video Diffusion Model

从谷歌在利用扩散模型生成视频方面的开创性工作开始,可以认为是这一领域快速发展开端。虽然这篇论文没有详细介绍,但它是创建T2V(文本-视频)扩散模型的首批尝试之一。

模型利用扩散模型从文本描述生成视频,VDM的架构利用3D U-Net和时间注意力来生成跨帧的一致图像。该模型可以在视频和图像上进行联合训练。它是通过移除每个时间注意力块内的注意力操作来完成的,并为这个输入固定注意力矩阵。

模型使用了未公开的1000万个带字幕的视频数据集。如果你查看原论文可能会发现,论文非常的短,所以这项工作可能是概念性验证演示,并没有什么实际意义,但是不能不说它是一个开创性的研究。

2022年9月:Make-a-Video

这是Meta在T2V(文本-视频)方面的开创性工作。模型是在开源的非配对视频数据集上进行的训练。

它扩展了T2I (Diffusion Text-to-Image)模型,通过整合时态层来实现文本到视频的生成。但是与谷歌的那个模型的最大变化是级联。作者使用了一系列时间和空间超分辨率扩散模型来提高分辨率和帧率。论文说明如下:

“级联的不同组成部分是独立训练的。解码器、先验和两个超分辨率模块只使用图像进行训练,而不使用任何文本。基本的T2I模型可以得到文本输入,并通过文本-图像对进行训练,而无需进一步的视频训练。”

另一个重要的步骤是2+1D。该模型利用“伪三维”卷积方法更有效地整合时间信息。2+1D方法可以更高效的计算策略模拟全3D卷积和注意力机制(直接将视频作为3D数据进行操作)的效果。它首先在每个帧上分别应用标准2D卷积,然后沿着时间轴应用- 1D卷积,在帧之间共享信息。如果你对视频理解比较敢兴趣,那么2+1D 是当时通用的方法。

论文还包含了一个精心策划的开源数据集组合:LAION-5B的2.3B子集,其中文本为英语+ HD-VILA-100M的10M子集+ WebVid-10M

使这篇论文现在已经成为一篇基础论文,后来被许多新方法引用和比较。

2022年10月:Imagen Video

“如果我们有一个级联,我们能做一个更大的级联吗?”这就是你的答案。

谷歌的这个新模型内部有7个子模型:文本编码器,基础模型(视频U-Net), 3个空间(SSR)和2个时间(TSR)超分辨率模型。所有7个模型都可以并行训练。与之前的Make-a-Video一样,SSR模型增加了所有输入帧的空间分辨率,而TSR模型通过填充输入帧之间的中间帧来增加时间分辨率。

所有的级联模型都使用+1时间维度。这意味着它们都适应视频格式,因此超分辨率(SSR)可以考虑视频的时间方面,而不会产生“闪烁的伪影”。为了计算效率,只有基本模型在所有帧中使用时间注意力,而SSR和TSR使用时间卷积(计算成本更低)。

2023年3月:NUWA-XL Video

“Diffusion over Diffusion”可以生成非常长的剪辑,并且具有相对较好的时间一致性。该模型使用递归,而不是级联来插值帧。

这里的核心概念是“扩散之上的扩散”——一种分层的、从粗到精的视频生成方法,从全局模型开始建立关键帧,然后通过局部扩散模型逐步填充细节。这使得视频片段的并行生成成为可能。

作者将生成1024帧的时间从7.55分钟减少到26秒(但gpu配置没有公开)。

关键模块是带掩码时间扩散(MTD),“掩码”一词意味着它处理全局生成过程(缺乏初始/结束视频帧引用)和局部细化过程(使用现有帧作为指导)。

还记得我提到的"潜在表征"吗?作者应用了他们称之为T-KLVAE的潜在编码器。论文描述如下:

T-KLVAE利用预先训练的增加了时间卷积和注意层的图像KLVAE(潜在编码器),结合时间动态的同时保留空间信息。

T-KLVAE将视频编码为紧凑的维度表示,从而降低了计算复杂度。

另外就是作者提到模型是直接在长电影(最多3376帧)上训练的。FlintstonesHD 是~6M帧的1高清动画数据集,这个模型在一次运行中生成了整个卡通剧集,

2023年4月Video LDM

到了这个时间节点就开始使用SD (StableDiffusion)了。虽然在NUWA-XL中看到了潜在空间的技巧,但这篇论文采用了所有人都喜欢的StableDiffusion并将其转换为T2V模型。ldm是图像生成的首选架构,现在是时候让它们在视频生成中大放光芒了。

Video LDM通过时间维度扩展了传统LDM的潜在空间。该流程很简单:

1、仅在图像上预训练LDM (StableDiffusion);

2、将时间维度引入潜在空间并对视频数据集进行微调。

3、微调图像上采样器,制作视频超分辨率模型。

LDM的使用提高了计算效率,为生成高分辨率视频(1280 x 2048)开辟了道路。

2023年6月:AnimateDiff

这是视频预训练ldm最有趣的应用之一,也是我们目前看到SD中让视频动起来的最常用的方法。它想法很简单——模型从视频中学习运动的先验,使堆栈图像动画化。这些运动先验可以插入到任何StabelDiffusion模型的顶部,所以任何SD模型无需重新训练。

AnimateDiff的核心是一个在视频数据集上训练的Spatio-Temporal Transformer运动建模模块。通过一个称为Inflation的过程将该模块集成到冻结的T2I模型(如Stable Diffusion)中,使原始模型能够处理5D视频张量(批次×通道×帧×高度×宽度)。

“Spatio-Temporal Transformer”由沿着时间轴的几个自注意力块组成,使用正弦位置编码来编码动画中每一帧的位置。

通过将每个2D卷积和注意层转换为仅限空间的伪3d层,以 batch x channels × frames × height × width形状的5D视频张量作为输入

这是一项了不起的工作,目前的开源库还在更新新版本,例如支持SD-XL和Domain Adapter LoRA。如果你想使用SD模型生成视频,可以先用它,因为非常好用。

2023年9月:Show-1

我们能合并潜在表征和像素表征吗?

Show-1同时利用基于像素和基于潜在的扩散模型:

它具有3个基于像素的扩散模型的级联结构(DeepFloyd作为关键帧的基础T2I模型,一个时间插值和一个分辨率插值)和1个LDM作为超分辨率模型。

该模型从基于像素的视频扩散模型(vdm)开始,创建与文本提示密切相关的低分辨率视频。然后采用基于潜在的vdm将低分辨率输出升级为高分辨率视频。

作者认为基于像素的是识别运动的好方法,而latent是超分辨率的专家。他们通过展示优于VideoLDM或Make-a-Video的评估指标来支持他们的论点

这篇论文提出了一个非常有趣的问题:潜在表示对视频有利吗?最后,你会看到一个意想不到的答案。

2023年11月:Stable Video Diffusion

这应该是目前最著名的开源T2V模型。尽管与Video LDM有很多相似之处,但SVD最大的价值在于数据管理。作者详细描述了他们如何建立一个大型视频数据集。

不要把这项工作当作一个新的模型,它回答了所有这些闭源数据集是如何创建和管理的问题。

SVD与Video LDM具有相同的架构:

1、模型首先在图像-文本对上训练sd2.1。

2、插入时间卷积和注意层,使模型适应视频生成,对大量视频数据进行训练。

3、在一小部分高质量视频上对模型进行微调

这里的主要重点是数据处理,创建精心策划的视频文本对。它从切割检测开始,以防止突然切割和淡出影响合成视频。每个视频片段使用三种合成字幕方法进行注释:

CoCa(图像字幕):注释每个剪辑的中间帧。

V-BLIP:提供基于视频的标题描述。

基于LLM的摘要:结合前两个标题来创建剪辑的简明描述。

最后,他们通过测量平均光流来过滤静态场景,并使用OCR去除含有过量文本的片段。

2023年12月:VideoCrafter-v2

论文包含了一个非常详细的训练过程和作者如何克服使用高质量生成图像的低质量视频的限制的描述。

模型的结构非常简单,没有帧插值或上采样,与VideoCrafterV1和其他T2V ldm类似的架构,结合了从SD 2.1初始化权重的空间模块和初始化为零的时间模块。

首先训练一个的视频模型。然后只对该模型的空间模块进行微调,生成高质量的图像。在论文中详细描述了的实验设置和对微调T2I不同方法,推荐阅读。

2023年12月:VideoPoet

VideoPoet是所有论文中最独特的一篇。与依赖扩散的传统方法不同,VideoPoet利用自回归LLM来生成视频甚至声音。

这个特殊模型的内部部分非常有趣,但对于与多模式LLM一起工作的人来说可能非常熟悉。作者使用了一个仅解码器的LLM架构,能够将图像、视频和音频模式作为离散的令牌。

为了创建这样的令牌,使用magvitv -v2进行联合图像和视频令牌化,使用SoundStream进行音频令牌化,将第一帧和随后的4帧块编码为令牌进行表示。

由于能够处理不同模式的输入,这使得模型能够执行广泛的视频生成任务:文本到视频、图像到视频、视频样式化和视频到音频任务,它还可以生成长视频。

模型可以通过调节视频的最后一秒来预测下一秒,从而生成更长的视频,允许创建任何期望持续时间的视频,并具有强对象身份保留。

这个模型提出了另一个问题——我们真的可以应用LLM吗?我们真的应该使用扩散吗?

2024年1月:Lumiere

在最新的工作中,Google认为基于像素的扩散是可行的方法(如果你有钱资源 )

这是目前基于T2V像素的扩散模型的最新进展。最新的详细技术论文。虽然最近的大部分工作都集中在潜在扩散上,但这项工作在某种意义上重新思考了级联模型。

该模型由一次生成所有帧的基本模型(STUnet)和具有时间感知的空间超分辨率(SSR)模型组成(没有帧插值),主要的是时空u网络(STUnet)。引用论文内容:

该架构扩展了imagent2i模型,现在可以对输入信号进行空间和时间上的下采样。这包括在文本到图像架构中交错的时间块,以及插入时间上采样和下采样模块

另一个明显的特点是它重新思考级联模型。模型结合了重叠窗口的超分辨率模型和MultiDiffusion来混合重叠部分,将分辨率提高到1024x1024。所有这些都使模型能够在一系列任务上显示SOTA质量,包括图像到视频、视频绘制和风格化生成。

作者认为STUnet和多扩散的思想可以应用于ldm。

Sora和未来展望

在Sora被OpenAI发布后,你也质疑现实吗?他发布的技术论文看起来更像一篇文章,并没有披露详细的架构。我们可以推测LLM与经过大量数据训练的扩散模型的某种融合。

这引出了我们下面的讨论:

扩散是最好的方法吗?

我们看到当前的视频模型是基于扩散的。基本思想是生成帧,然后在帧之间创建时间一致的动画。但我们也看到llm生成令牌,然后解码成图像甚至声音。

今年我们会看到新的突破性架构吗?

这里只有模型作品是针对长视频生成的。主要是因为扩散模型缺乏对“变换视图”的理解——当摄像机从一个视角跳到另一个视角时扩散模型无法对其进行理解。这就是为什么大多数模型都是通过过滤这些变化来去除“闪烁”——当模型在未过滤的数据上训练时,图像在视频中间出现的变化。

从哪里获取数据?

现在的主要问题是从哪里获得高质量的数据。它主要是关于注释数据,因为收集视频并对其进行注释需要花钱,大多数实验室都负担不起。我们已经看到了一些模型如何使用生成的图像数据集来克服这个问题。今年我们会看到一个新的“万能”视频数据集吗?

上面说的都是目前的问题,希望在2024年可以得到解决,最后下面是本文的引用

[1] J. Ho, T. Salimans, A. Gritsenko, W. Chan, M. Norouzi, D. J. Fleet, “Video Diffusion Models” (2022), arXiv:2204.03458.

[2] U. Singer, A. Polyak, T. Hayes, X. Yin, J. An, S. Zhang, Q. Hu, H. Yang, O. Ashual, O. Gafni, D. Parikh, S. Gupta, Y. Taigman, “Make-a-Video: Text-to-Video Generation without Text-Video Data” (2022), arXiv:2209.14792.

[3] J. Ho, W. Chan, C. Saharia, J. Whang, R. Gao, A. Gritsenko, D. P. Kingma, B. Poole, M. Norouzi, D. J. Fleet, T. Salimans, “Imagen Video: High-definition Video Generation with Diffusion Models” (2022), arXiv:2210.02303.

[4] S. Yin, C. Wu, H. Yang, J. Wang, X. Wang, M. Ni, Z. Yang, L. Li, S. Liu, F. Yang, J. Fu, G. Ming, L. Wang, Z. Liu, H. Li, N. Duan, “NUWA-XL: Unified Generative Pre-training for Visual Synthesis” (2023), arXiv:2303.12346.

[5] A. Blattmann, R. Rombach, H. Ling, T. Dockhorn, S. W. Kim, S. Fidler, K. Kreis, “Align your Latents: High-Resolution Video Synthesis with Latent Diffusion Models” (2023), arXiv:2304.08818.

[6] Y. Guo, C. Yang, A. Rao, Z. Liang, Y. Wang, Y. Qiao, M. Agrawala, D. Lin, B. Dai, “AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning” (2023), arXiv:2307.04725.

[7] D. J. Zhang, J. Z. Wu, J.-W. Liu, R. Zhao, L. Ran, Y. Gu, D. Gao, M. Z. Shou, “Show-1: Marrying Pixel and Latent Diffusion Models for Text-to-Video Generation” (2023), arXiv:2309.15818.

[8] A. Blattmann, T. Dockhorn, S. Kulal, D. Mendelevitch, M. Kilian, D. Lorenz, Y. Levi, Z. English, V. Voleti, A. Letts, V. Jampani, R. Rombach, “Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets” (2023), arXiv:2311.15127.

[9] H. Chen, Y. Zhang, X. Cun, M. Xia, X. Wang, C. Weng, Y. Shan, “VideoCrafter2: Overcoming Data Limitations for High-Quality Video Diffusion Models” (2024), arXiv:2401.09047.

[10] D. Kondratyuk, L. Yu, X. Gu, J. Lezama, J. Huang, R. Hornung, H. Adam, H. Akbari, Y. Alon, V. Birodkar, Y. Cheng, M.-C. Chiu, J. Dillon, I. Essa, A. Gupta, M. Hahn, A. Hauth, D. Hendon, A. Martinez, D. Minnen, D. Ross, G. Schindler, M. Sirotenko, K. Sohn, K. Somandepalli, H. Wang, J. Yan, M.-H. Yang, X. Yang, B. Seybold, L. Jiang, “VideoPoet: Autoregressive Video Generation” (2023), arXiv:2312.14125.

[11] O. Bar-Tal, H. Chefer, O. Tov, C. Herrmann, R. Paiss, S. Zada, A. Ephrat, J. Hur, G. Liu, A. Raj, Y. Li, M. Rubinstein, T. Michaeli, O. Wang, D. Sun, T. Dekel, I. Mosseri, “Lumiere: Enhancing Video Generation with Pixel-based Diffusion Models” (2024), arXiv:2401.12945.

https://avoid.overfit.cn/post/6242680847f94e6b8ef3eb2217ce1f89文章来源:https://www.toymoban.com/news/detail-832519.html

作者:Nikita Kiselov文章来源地址https://www.toymoban.com/news/detail-832519.html

到了这里,关于视频生成领域的发展概述:从多级扩散到LLM的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文精读] 使用扩散模型生成真实感视频 - 【李飞飞团队新作,文生视频 新基准】](https://imgs.yssmx.com/Uploads/2024/02/772295-1.png)