1.背景介绍

在大数据时代,数据的处理和分析已经成为企业的核心竞争力。MySQL作为最流行的关系型数据库之一,被广泛应用于各种业务场景中。而Apache Spark则是一个大规模数据处理的统一分析引擎,它提供了一种简单、通用的方式来处理大规模数据。本文将介绍如何将MySQL与Spark集成,以实现对大规模数据的高效处理。

2.核心概念与联系

2.1 MySQL

MySQL是一个开源的关系型数据库管理系统,它使用SQL语言进行数据操作,具有高性能、稳定性强、易用性好等特点。

2.2 Spark

Apache Spark是一个大规模数据处理的统一分析引擎,它提供了一种简单、通用的方式来处理大规模数据。Spark支持多种数据源,包括HDFS、Cassandra、HBase、MySQL等。

2.3 MySQL与Spark的联系

Spark可以通过JDBC连接器与MySQL进行连接,从而实现对MySQL中数据的读取和写入。通过Spark对MySQL的集成,可以实现对大规模数据的高效处理。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 Spark读取MySQL数据的原理

Spark通过JDBC连接器与MySQL进行连接,然后通过SQL语句读取MySQL中的数据。读取的数据会被转换为Spark的DataFrame或DataSet,然后可以通过Spark的各种算子进行处理。

3.2 Spark写入MySQL数据的原理

Spark可以将处理后的数据写入MySQL。写入的过程是通过JDBC连接器将DataFrame或DataSet转换为SQL语句,然后通过JDBC连接器将SQL语句发送到MySQL执行。

3.3 具体操作步骤

- 创建SparkSession对象

- 使用SparkSession的read方法读取MySQL中的数据

- 对读取的数据进行处理

- 使用DataFrame或DataSet的write方法将处理后的数据写入MySQL

3.4 数学模型公式

在Spark中,数据处理的基本单位是RDD(Resilient Distributed Datasets),它是一个分布式的元素集合。在RDD上可以进行各种转换操作和行动操作。

假设我们有一个RDD,表示为$RDD = {x1, x2, ..., xn}$,其中$xi$表示RDD中的一个元素。

我们可以对RDD进行map操作,表示为$RDD.map(f)$,其中$f$是一个函数,它会被应用到RDD的每一个元素上。结果是一个新的RDD,表示为$RDD' = {f(x1), f(x2), ..., f(x_n)}$。

我们也可以对RDD进行reduce操作,表示为$RDD.reduce(op)$,其中$op$是一个二元操作符,它会被应用到RDD的元素上,以产生一个单一的值。结果是一个值,表示为$v = op(op(...op(op(x1, x2), x3), ..., xn)$。

4.具体最佳实践:代码实例和详细解释说明

下面是一个使用Spark读取MySQL数据并进行处理的示例代码:

```scala import org.apache.spark.sql.SparkSession

val spark = SparkSession.builder.appName("MySQL Integration Example").getOrCreate()

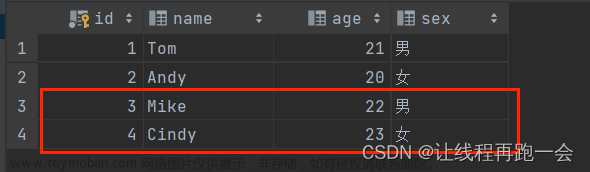

val jdbcDF = spark.read .format("jdbc") .option("url", "jdbc:mysql://localhost:3306/testdb") .option("dbtable", "testTable") .option("user", "root") .option("password", "root") .load()

jdbcDF.show() ```

这段代码首先创建了一个SparkSession对象,然后使用SparkSession的read方法读取MySQL中的数据。读取的数据被转换为DataFrame,然后通过show方法显示出来。

5.实际应用场景

MySQL与Spark的集成在许多实际应用场景中都有应用,例如:

- 数据仓库:可以使用Spark从MySQL中读取数据,进行ETL处理,然后写入到Hadoop HDFS或其他大数据存储系统中。

- 数据分析:可以使用Spark从MySQL中读取数据,进行复杂的数据分析和挖掘,然后将结果写回MySQL。

- 实时数据处理:可以使用Spark Streaming从MySQL中读取实时数据,进行实时的数据处理和分析,然后将结果写回MySQL。

6.工具和资源推荐

- MySQL:https://www.mysql.com/

- Apache Spark:https://spark.apache.org/

- Spark SQL and DataFrame Guide:https://spark.apache.org/docs/latest/sql-programming-guide.html

- JDBC to Other Databases:https://spark.apache.org/docs/latest/sql-data-sources-jdbc.html

7.总结:未来发展趋势与挑战

随着大数据技术的发展,MySQL与Spark的集成将会越来越重要。然而,也存在一些挑战,例如如何提高数据读取和写入的效率,如何处理大规模的数据等。

8.附录:常见问题与解答

Q: Spark如何连接到MySQL?

A: Spark可以通过JDBC连接器连接到MySQL。你需要提供MySQL的URL、数据库名、用户名和密码。

Q: Spark读取MySQL数据时,如何处理大规模的数据?

A: Spark可以通过分区的方式来处理大规模的数据。你可以在读取数据时指定分区的数量,Spark会将数据分成多个分区,然后在各个分区上并行处理数据。

Q: Spark写入MySQL数据时,如何保证数据的一致性?文章来源:https://www.toymoban.com/news/detail-832712.html

A: Spark写入MySQL数据时,可以使用事务来保证数据的一致性。你可以在写入数据前开启一个事务,然后在写入数据后提交事务。如果在写入数据过程中发生错误,你可以回滚事务,以保证数据的一致性。文章来源地址https://www.toymoban.com/news/detail-832712.html

到了这里,关于MySQL与Spark集成实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!