Deep Multiview Clustering by Contrasting Cluster Assignments

原文链接

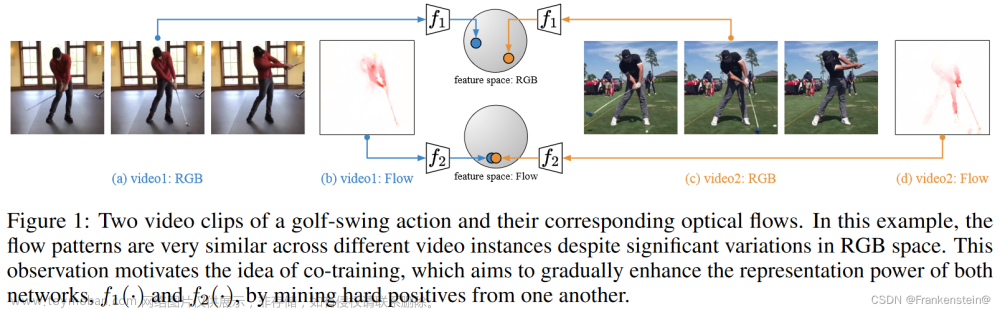

对于大多数现有的深度MVC方法,探索多视图的不变表示仍然是一个棘手的问题。在本文中,提出了一种跨视图对比学习(CVCL)方法,该方法学习视图不变表示,并通过比较多个视图之间的聚类分配来产生聚类结果。

具体来说,首先在预训练阶段使用深度自编码器提取视图相关特征。然后,提出了一种聚类级CVCL策略,在微调阶段探索多个视图之间一致的语义标签信息。因此,所提出的CVCL方法能够通过这种学习策略产生更多的判别性聚类分配。

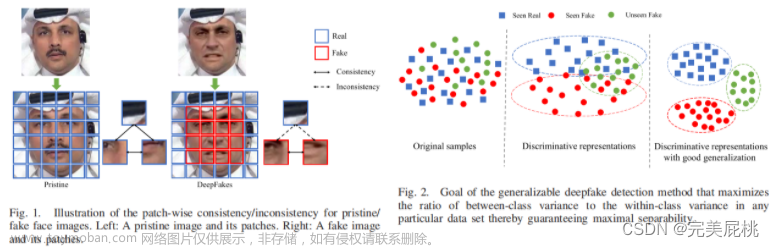

与大多数现有的深度MVC方法相比,引入了集群级CVCL策略来跨多个视图捕获一致的语义标签信息。通过比较多个视图之间的聚类分配,所提出的CVCL方法学习了MVC正对之间的视图不变表示。由正对派生的聚类分配合理地对齐了多个视图之间的不变表示。这种对齐灵活地描述了从单个视图获得的一致语义标签,用于度量数据样本之间的内在关系。k维分配概率表示对应视图中每个样本的聚类分配。基于这些视图不变表示,所提出的CVCL方法的对比损失鼓励为正对产生的k维聚类分配相似,并将为负对提供的聚类分配分开。此外,本文还对软集群分配对齐的可实现性提供了理论解释。

每个视图包含两个模块,包括特定于视图的自动编码器模块和CVCL模块(跨视图对比学习模块)。多层感知器(MLP)由多个线性层组成。视图自编码器模块包括编码部分和解码部分。CVCL模块通过对比多个视图之间的聚类分配来探索一致的语义标签信息

聚类层次上的CVCL

f将N个样本映射为语义特征的函数。在语义特征上叠加两个线性层和一个连续的softmax函数来产生一个聚类分配概率。

所有视图的聚类概率矩阵{**H(v)**∈R N×K}nv v=1,这是在前一层的语义特征上产生的。设h (v) i为h (v)中的第i行,设h (v) ij表示实例i在视图m中属于聚类j的概率。实例i的语义标签由h (v) i中概率的最大值决定。

为了增加聚类分配之间的差异,统一的目标分布{**P(v)**∈R N×K}nv v=1是{H(v)}nv v=1的较好替代,其每个元素的计算如下:

设p(v)j是p(v)的第j列。p(v)j中的每个元素p(v)ij表示属于聚类j的样本i的一个软聚类分配。因此,p(v)j表示同一语义聚类的一个聚类分配。

聚类j的两个聚类分配p (v1) j和p (v2) j之间的相似性:

其中v1和v2表示两个不同的视图。

在CVCL模块中,不同视图中实例的集群分配概率应该是相似的,因为这些实例表征相同的样本。此外,如果用多个视图中的实例来描述不同的样本,它们之间是不相关的。因此,当考虑跨nv视图的p (v) j和K个簇时,存在(nv−1)个正簇分配对和nv (K−1)个负簇分配对。**集群内分配的相似性要最大化,集群间分配的相似性要最小化。**同时对样本进行聚类,同时加强聚类分配之间的一致性。p (v1) k和p (v2) k的横视对比损失定义如下:

跨多个视图引起的跨视图对比损失:

为了防止所有实例都被分配到一个特定的集群,引入一个正则化如下:

两阶段训练机制

通过预训练网络进行参数初始化

设计一个预训练网络,该网络由特定视图的编码器模块f (v) e(1≤v≤nv)和对应的解码器模块f (v) d组成

对于多视图,预训练网络在输入和输出之间的重构损失设计为:

MVC通过一个微调网络

该方法的总体损失包括三个主要部分:预训练网络的重建损失、交叉视图对比损失和交叉视图一致性损失:

预测结果表示: 文章来源:https://www.toymoban.com/news/detail-833153.html

文章来源:https://www.toymoban.com/news/detail-833153.html

在本文中,提出了一种CVCL方法来学习MVC的视图不变表示。提出了一种聚类级的CVCL策略,用于探索多个视图之间具有一致性的语义标签信息。CVCL在两个连续阶段有效地实现了更多的判别聚类分配。对软集群分配对齐的理论分析表明了集群级学习策略在CVCL中的重要性。作者对MVC数据集进行了大量的实验和烧蚀研究,以验证模型的优越性和各组成部分在整体重建损失方面的有效性。文章来源地址https://www.toymoban.com/news/detail-833153.html

到了这里,关于【论文阅读】通过对比聚类分配的深度多视图聚类的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]MVF——基于 LiDAR 点云的 3D 目标检测的端到端多视图融合](https://imgs.yssmx.com/Uploads/2024/01/817020-1.png)