目标检测,就像电影中的侦探找寻线索,让计算机能够发现并识别图像中的物体。在目标检测领域,YOLO(You Only Look Once)算法犹如一位神奇的探险家,通过一瞥就能洞察图像的奥秘。本篇博客将深入解析YOLO算法,让我们一同揭秘这场目标检测的冒险之旅。

什么是YOLO?

首先,让我们认识一下这位神奇的探险家——YOLO。YOLO是一种目标检测算法,与传统的目标检测方法不同,它通过一次前向传递就能够同时预测图像中的多个物体类别和位置。

YOLO算法的全称是You Only Look Once,这也正是它的特点所在:只需一次前向传递,即可完成目标检测任务。这让YOLO成为目标检测领域的一颗耀眼的明星。

YOLO的优势

在揭开YOLO的神秘面纱之前,我们先来了解一下它为何备受欢迎,成为目标检测领域的翘楚。

实时性强,如同时光机器

YOLO以其快速的目标检测速度而闻名,实时性极强。这就像是一台时光机器,能够在瞬间洞察图像中的所有物体。

简洁高效,如同大师之笔

相比于传统的目标检测算法,YOLO更加简洁高效。它将目标检测问题转化为一个回归问题,通过直接回归边界框的坐标和物体类别,避免了繁琐的区域提取和特征计算。这就像是一位大师之笔,一笔勾勒出令人惊叹的画面。

多物体检测,如同多面手

YOLO不仅能够检测单个物体,还能够同时检测图像中的多个物体,甚至是重叠的物体。这就像是一位多面手,能够灵活应对各种场景。

YOLO的基础概念

在揭开YOLO的神秘面纱之前,我们先来了解一些YOLO的基础概念,让我们能够更好地理解这位探险家的探险原理。

锚框

YOLO使用锚框(Anchor Boxes)来预测物体的位置。锚框是一些预定义的边界框,通过这些边界框,YOLO能够更准确地捕捉不同形状和大小的物体。

网格

为了提高目标检测的效率,YOLO将图像划分为一个个小网格,并在每个网格上预测物体的位置和类别。这就像是在地图上划分区域,每个区域都有一个专属的探险家。

类别预测

YOLO不仅能够预测物体的位置,还能够预测物体的类别。通过在每个网格上预测不同类别的概率,YOLO能够识别图像中不同种类的物体。

YOLO的实践

了解了YOLO的基础概念后,我们来实际操作一下,感受一下YOLO的神奇魅力。在这个例子中,我们使用YOLOv3模型进行目标检测。

步骤1:安装YOLO

首先,我们需要安装YOLO。在终端中执行以下命令:

git clone https://github.com/pjreddie/darknet.git

cd darknet

make

步骤2:下载权重文件

下载YOLOv3的权重文件,执行以下命令:

wget https://pjreddie.com/media/files/yolov3.weights

步骤3:进行目标检测

在终端中执行以下命令进行目标检测:

./darknet detect cfg/yolov3.cfg yolov3.weights data/dog.jpg

这个例子中,我们使用了YOLOv3模型对一张图像进行目标检测,你将会看到终端输出目标的类别、位置和置信度。

YOLO的高级应用

了解了YOLO的实践方法后,我们来深入探讨一些高级应用,看看YOLO的探险家工具箱中还有哪些令人惊叹的功能。

YOLOv4

YOLOv4是YOLO算法的进化版本,引入了许多新的特性,包括CIOU损失函数、Mish激活函数等。使用YOLOv4能够在目标检测任务中取得更好的性能。

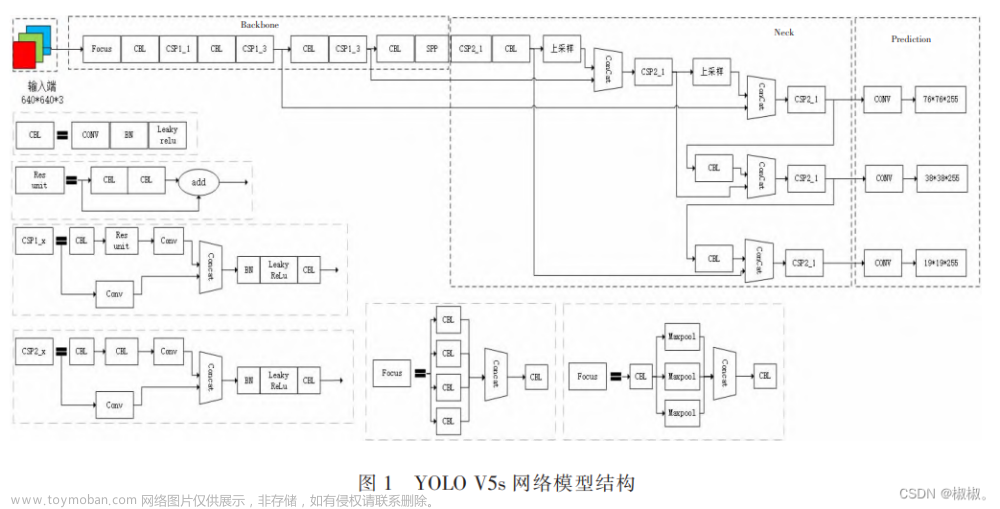

YOLOv5

YOLOv5是由ultralytics团队开发的YOLO版本,它在YOLOv4的基础上进一步优化,提供了更加简单易用的接口,并支持多种设备上的推理。

自定义数据集训练

如果你希望使用YOLO进行特定物体的检测,你可以通过训练自定义数据集来训练YOLO模型。以下是一个简单的自定义数据集训练的步骤:

步骤1:准备数据集

首先,准备包含你要检测物体的图像和相应标注信息的数据集。确保标注信息中包含物体的类别和边界框坐标。

步骤2:生成YOLO标签

使用工具将标注信息转换为YOLO格式的标签文件。YOLO格式的标签包括物体的类别和边界框的归一化坐标。

步骤3:调整YOLO配置文件

调整YOLO的配置文件,包括类别数、anchors等参数,以适应你的数据集。

步骤4:开始训练

执行训练命令,开始训练YOLO模型:

./darknet detector train custom_data.data custom_yolov4.cfg yolov4.conv.137

在这个命令中,custom_data.data是包含数据集信息的配置文件,custom_yolov4.cfg是调整过的YOLO配置文件,yolov4.conv.137是预训练权重文件。

步骤5:评估模型

训练完成后,可以使用测试集对模型进行评估:

./darknet detector map custom_data.data custom_yolov4.cfg backup/custom_yolov4_last.weights

这个命令会输出模型在测试集上的平均精度(mAP)等评估指标。

实时目标检测

YOLO算法的实时性能使其成为实时目标检测的理想选择。你可以通过将YOLO模型与摄像头或视频流结合,实时检测图像中的物体。

下面是一个使用OpenCV和YOLO进行实时目标检测的简单示例:

import cv2

# 加载YOLO模型

net = cv2.dnn.readNet("yolov4.weights", "yolov4.cfg")

layer_names = net.getUnconnectedOutLayersNames()

# 打开摄像头

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

height, width = frame.shape[:2]

# 构建blob,用于输入模型

blob = cv2.dnn.blobFromImage(frame, 1/255.0, (416, 416), swapRB=True, crop=False)

net.setInput(blob)

# 前向传播

detections = net.forward(layer_names)

# 处理检测结果

for detection in detections:

for obj in detection:

scores = obj[5:]

class_id = np.argmax(scores)

confidence = scores[class_id]

if confidence > 0.5:

# 获取物体框的坐标

center_x = int(obj[0] * width)

center_y = int(obj[1] * height)

w = int(obj[2] * width)

h = int(obj[3] * height)

# 计算框的左上角坐标

x = int(center_x - w / 2)

y = int(center_y - h / 2)

# 绘制边界框和标签

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2)

cv2.putText(frame, f"Class {class_id}", (x, y - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示结果

cv2.imshow("YOLO Object Detection", frame)

if cv2.waitKey(1) & 0xFF == 27:

break

# 释放资源

cap.release()

cv2.destroyAllWindows()

这个例子中,我们使用OpenCV和YOLO模型实现了实时目标检测。摄像头捕获的图像通过YOLO模型进行处理,检测到的物体会被用矩形边界框标出,并显示在窗口中。

YOLO的未来

YOLO作为目标检测领域的重要算法,其未来充满了期待。随着深度学习技术的不断发展,YOLO算法将继续引领目标检测的创新方向。

在未来,我们可以期待更加高效和精准的目标检测算法,以及更加灵活多样的应用场景。YOLO将继续在计算机视觉的舞台上发挥其强大的魔法力量。

结语

通过本文的揭秘,我们深入了解了YOLO算法的原理、实践方法以及一些高级应用。YOLO就像是一位神奇的探险家,通过其快速、精准的目标检测能力,为计算机视觉领域带来了一场惊险刺激的冒险之旅。文章来源:https://www.toymoban.com/news/detail-834103.html

在这次冒险中,我们领略了YOLO的实时性能、自定义数据集训练、实时目标检测等多个方面的魅力。未来,YOLO将继续挑战更多目标,为我们的技术世界带来更多的奇迹。愿你在目标检测的征途上,充满好奇,不断迎接新的挑战,探索更多的领域。向YOLO致敬,感叹目标检测的不凡魅力!文章来源地址https://www.toymoban.com/news/detail-834103.html

到了这里,关于揭秘YOLO:深入理解目标检测的神奇算法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!