SadTalker:使用一张图片和一段语音来生成口型和头、面部视频.

西安交通大学开源了人工智能SadTalker模型,通过从音频中学习生成3D运动系数,使用全新的3D面部渲染器来生成头部运动,可以实现图片+音频就能生成高质量的视频。

论文地址:Learning Realistic 3D Motion Coefficients

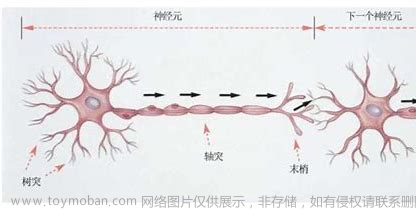

整体来说 Talking head 就是用语音驱动每一帧图片的表情(眼睛、嘴巴等)和头部(head motion)运动,并重建人脸以生成视频。表情运动是局部的,头部运动是全局的,且表情跟声音的关系比较强,头部姿态跟声音的关系比较弱,将这两个系数解耦开可以减少人脸扭曲。

sadtalker的原理基于深度学习技术,主要包括两个关键步骤:情感分类和文本生成。

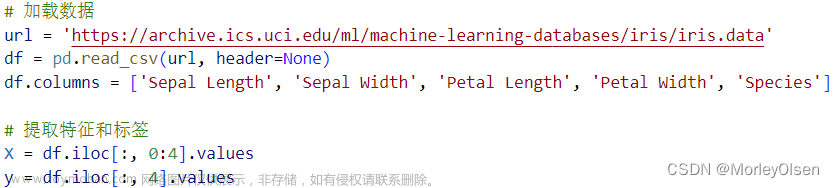

安装Python 3.8并选中“将Python添加到PATH”。

手动安装 git 或使用 Scoop:scoop install git。

按照本教程或使用 scoop 安装 ffmpeg:scoop install ffmpeg。

通过运行

git clone 文章来源地址https://www.toymoban.com/news/detail-834170.html

文章来源:https://www.toymoban.com/news/detail-834170.html

到了这里,关于让图片说话SadTalker的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!