原创:谭婧

从“古”至今,AI的江湖,都是开源引领技术发展。

(此处咬牙切齿表态:不接受反驳)。

虽然Stable Diffusion作为开源的图像生成模型,将图像生成提到了全新境界,但是GPT-4的出现,似乎动摇了人们的信念。

要我说,那些人只是信念不坚定。

眼看Meta公司(原脸书)LLAMA2挽回了不少尊严。

虽然GPT-4依然是地表最强。

你来我往,卷到极致。

谭老师我作为一个“开源党”,只想拍手叫好。

脑海中仰天长啸:开源大模型(LLM)何时赶上GPT-4?

为了这个小目标,《开源大模型卷死你系列》,还得更新200集。

我已经开始思考:看剧的时候啃鸭脖,选五香,还是选麻辣?

那些不服气开源模型的小伙伴,我再甩出几个证据:

证据一:

模型的保鲜期(Shelf Life)基本上是一年左右。以 2012 年里程碑模式AlexNet为例,六个月到一年之后就会出现效果接近的开源模型。

证据二:

Meta公司LLaMA系列、伯克利的 Vicuna、斯坦福的 Alpaca、Databricks的 Dolly,都在展示开源强大的可能性。

GPT系列在演进,

强大的开源模型也在陆续发布,

开源和闭源竞争加剧。

如今,卷得情况怎么样了?

先看图,观察一下这三家“开源大户”:

敢谈微见,再讲几点观察:

第一点

AI开源生态重心转移。

“预训练大模型”成为新的开源生态中心。

也就是说,无论训练什么规模的模型,把“预训练大模型”训练出来这件事成为“开源热门事件”,也可以加之微调,代表着模型结构以此为主流。

预训练模型百花齐放,是大势所趋。

以前,小模型是主流,大家在AI框架(比如Pytorch)上调算法,调来调去,搞算法创新。因为模型小,在框架层面的调用API就可以做算法创新。现在,大家在预训练大模型的基础上创新。准确地说,我们之前的AI生态重心在AI框架的API上。现在情况完全不同了,AI框架变成“幕后英雄”,大模型则变得“大红大紫。

第二点

500亿以上参数规模的模型开源数量极为稀少,千亿更是罕见。

2023年11月27日,浪潮信息发布“源2.0”大模型,刚刚跨过千亿参数门槛,其中有1026亿参数这个版本。2023年9月 “鹏城·脑海”(PengCheng Mind)大模型由高文院士团队研发,采用了国产化深度学习框架,参数规模2000亿。这个模型知道的人特别少,是个冷知识。很多人都误以为“源2.0”千亿版本的开源模型是“首个”。而早在两年前,智谱AI的千亿模型(GLM-130B)开源。

扶额苦笑,就算千亿模型开源了,能有算力跑得起来的玩家也是少数。没有办法,算力就是大模型训练的配套刚需。

第三点

从10亿到400亿区间,拥挤不堪。

这里简直是“红海赛道”。

我手动画一条横线,把参数规模从小到大(从1到10000)都标准在线上,再用点分成几个区间。

这个区间段里,写各个厂商,实验室的模型名称,写不下,实在写不下。

我认为,一个比较标志性的事件是百川智能创始人王小川很早就表态520亿参数不会开源。个人观点是百川智能团队作为“开源大户”,肯定能清楚判断出500亿以上参数模型发布数量会很少,这是一个专业且合理的预判。

第四点

互联网厂商分为“强势派”和“无为派”,对开源社区来说,大厂的参与始终都是好事。阿里算是强势派,同时又拥有云底座,对大模型生态有强烈的,建设好的欲望,正处于舍得投入的时期。

此处轻轻扶一把华为,华为有开源大模型,数量较少,鹏城盘古开源较早(2020年),后面节奏没有跟上。再就是基于华为昇腾昇思开源的“紫东太初2.0”的10亿参数(2022年),38亿参数(2023年)的两版模型,均为多模态大模型。

“无为派”就很多了,巨头就那么几家,谁一点模型都没开源,掰着手指头也能数出来。

第五点

没必要盲目追求参数数量,并不是越大越好。美国厂商团队也不比拼参数,都是效果和用途导向。目前,从开发者的反馈来看,投入产出比高的模型尺寸更受欢迎。

一般说来,开发者选大模型会有几个标准:

第一,模型效果好是基础分,效果不好,说啥也不顶用。

第二,生态好,社区好,再加之配套工具链全。

第三,持续性,开源社区最遗憾的事莫过于“啥也不说,直接停更”。持续投入好比一种保障,所以开源背后的团队,实力越强越好,不能仅靠“用爱发电”。

开源协议是加分项。当然越开放越好,不要暗藏陷阱,在知识产权这块,有些厂商有“暗藏陷阱”的经验。Llama2在商用方面有月活不超过7亿的限制条款。

回到第一点“效果好”这件事情,我亲耳听到多位专家在多个场合表达的观点十分一致:“大模型评测榜单(评测基准)被用得很有问题。”

还看到开发者在微信群里吐糟得更为激烈,他们还总结了“套路”:预训练“新”玩法:第一阶段普通预训练,第二部分拿榜单领域数据微调。”

所以,想通过评测证明一下就直接得出结论“全球最强”,这一做法并不科学。“榜单成绩”再亮眼,刻意刷榜恐怕也会收获“嘘声”,最终还得靠用户反馈说话。

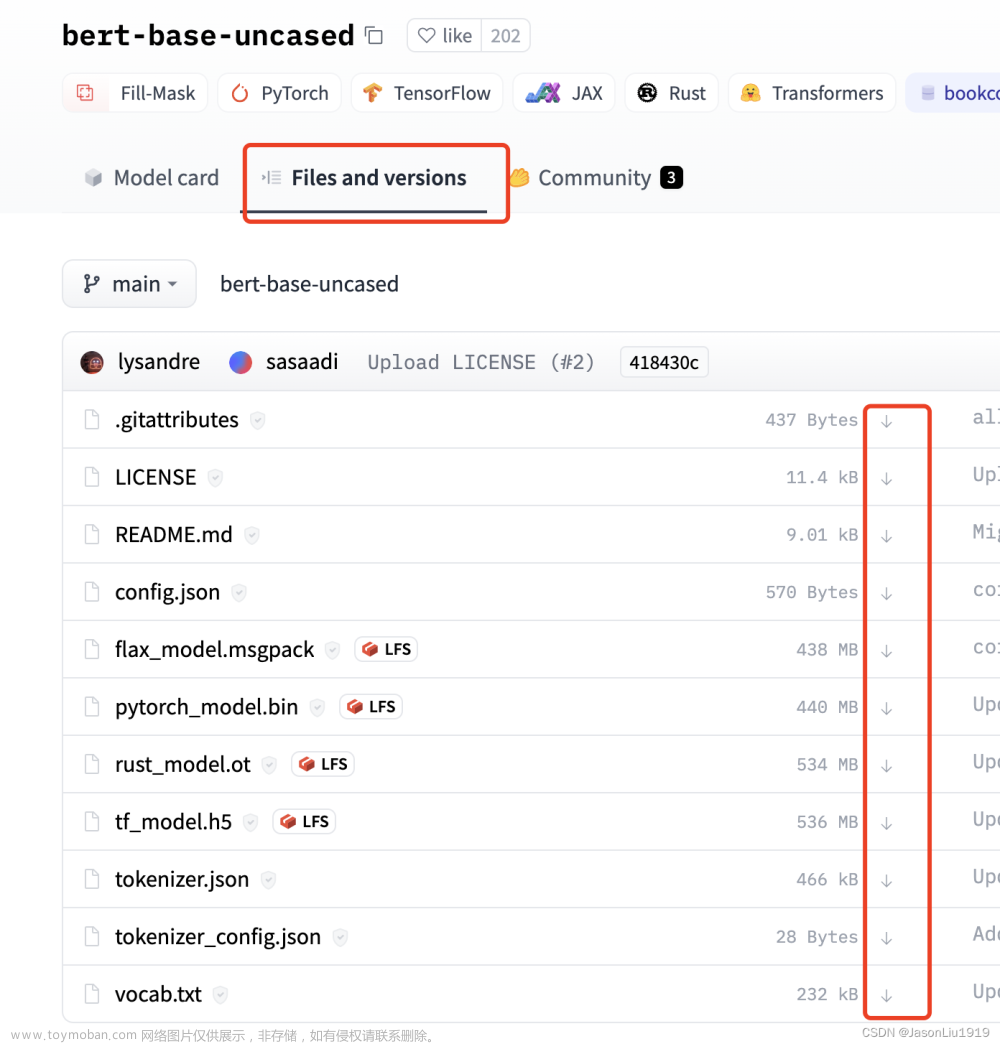

榜单我没有本领做一个,倒是能给大家推荐一个抱抱脸(Huggingface)上的工具,帮助筛选真正适合自己的好用模型,选项做得非常细,我能想到的上面都有了,我没想到的,它也都有了。

开源社区里会分享出修改和优化的模型,我在抱抱脸社区搜baichuan,能搜出来179个模型,搜Qwen,能搜出来235个模型。

就在今天,阿里又把通义千问开源大模型的上限往上推了一把,高达720亿参数,推特上讨论热烈;

虽然LLAMA2有700亿参数,但对中文场景不够友好。目前,国内还没出现足以叫板Llama 2-70B的优质开源模型,720亿参数确实也属于稀缺尺寸。

阿里是如何选择这次开源发布规模的,720亿和18亿,一小一大两个规模?阿里内部员工告诉我,这次的开源尺寸是通过社区用户的痛点来确定的。

这次,阿里还开源了通义千问音频大模型(Qwen-Audio)。

我还听说,用于读图识物的Qwen-VL-72B模型新升级后的效果很好,暂时还没有开源。至此,通义千问的开源尺寸就很全面了:18亿、70亿、140亿、720亿,四款大语言基座模型。

我又找了业内几位专家了解到,大模型的能力想要快速普及,部署在常用电子设备上更好。比如,笔记本电脑。大模型作为类似Cortana助手背后的“力量”(内置到手机系统里),而不是安装了一个需要上网的应用程序。

有趣的是,有一位名叫“土土”开发者,骨灰级玩家,一位动手能力很强的工程师,从事电力系统控制优化方面工作;他基于通义千问140亿参数版本的开源模型,把上百万字的电力系统知识文档做成了一个检索知识库。

他的个人配置倒是很“奢华”,他说:“在家里买了个服务器,扔三四块显卡上去,下载Qwen,再搞个FRP快速反向代理,从阿里云上买最便宜的30多块钱一个多月的服务,这样就能通过外网访问家里的服务器,在单位上班的时候,也能用Qwen做实验。”

华东理工大学·X-D Lab(心动实验室)成员颜鑫说:“从可持续性、生态和场景适配这三个维度判断,通义千问成了当下最优解。此前有一家企业找我们合作,我们只用 20 万tokens的数据微调了Qwen基座模型,就得到了比另一家用百万级数据微调的模型更好的效果。这不仅证明了通义千问基座模型的能力,也证明了我们实验室有很好的行业know-how。”

开源社区卷卷更健康,活跃的开发者、积极的贡献者,这一把阿里通义千问的诚意我是看到了。希望国产开源大模型早日在开源和闭源两个江湖里“拔类超群”。让我们自己的大模型早日拥有碾压性的优势。

(完)

《我看见了风暴:人工智能基建革命》,作者:谭婧

更多阅读

AI大模型与ChatGPT系列:

1. ChatGPT大火,如何成立一家AIGC公司,然后搞钱?

2. ChatGPT:绝不欺负文科生

3. ChatGPT触类旁通的学习能力如何而来?

4. 独家丨从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进

5. 独家丨前美团联合创始人王慧文“正在收购”国产AI框架OneFlow,光年之外欲添新大将

6. ChatGPT大模型用于刑侦破案只能是虚构故事吗?

7. 大模型“云上经济”之权力游戏

8. 云从科技从容大模型:大模型和AI平台什么关系?为什么造行业大模型?

9. 深聊第四范式陈雨强丨如何用AI大模型打开万亿规模传统软件市场?

10. 深聊京东科技何晓冬丨一场九年前的“出发”:奠基多模态,逐鹿大模型

11. 老店迎新客:向量数据库选型与押注中,没人告诉你的那些事

12. 微调真香,漫画科技博主竟然在用国产大模型生成系列漫画女主角

13. 大模型“搅局”,数据湖,数据仓库,湖仓选型会先淘汰谁?

14. 大模型用于腾讯广告,难在哪?

15. 搞掂大模型,如何榨干每一滴算力?

16. 假如你家大模型还是个二傻子,就不用像llya那样操心AI安全

长文

1. 深聊科大讯飞刘聪丨假如对大模型算法没把握,错一个东西,三个月就过去了

2. 深聊武汉人工智能研究院张家俊丨 “紫东太初”大模型背后有哪些值得细读的论文(一)

3. 深聊武汉人工智能研究院王金桥丨紫东太初:造一个国产大模型,需用多少篇高质量论文?(二)

4. 为何重视提示工程?

5. 跳槽去搞国产大模型,收入能涨多少?

6. AI咆哮后,一个赚大钱的AI+Data公司估值居然430亿美元?

7. 抢滩大模型,抢单公有云,Databricks和Snowflake用了哪些“阳谋”?

8. 大模型下一场战事,为什么是AI Agent?

漫画系列

1. 是喜,还是悲?AI竟帮我们把Office破活干完了

2. AI算法是兄弟,AI运维不是兄弟吗?

3. 大数据的社交牛气症是怎么得的?

4. AI for Science这事,到底“科学不科学”?

5. 想帮数学家,AI算老几?

6. 给王心凌打Call的,原来是神奇的智能湖仓

7. 原来,知识图谱是“找关系”的摇钱树?

8. 为什么图计算能正面硬刚黑色产业薅羊毛?

9. AutoML:攒钱买个“调参侠机器人”?

10. AutoML:你爱吃的火锅底料,是机器人自动进货

11. 强化学习:人工智能下象棋,走一步,能看几步?

12. 时序数据库:好险,差一点没挤进工业制造的高端局

13. 主动学习:人工智能居然被PUA了?

14. 云计算Serverless:一支穿云箭,千军万马来相见

15. 数据中心网络:数据还有5纳秒抵达战场

16. 数据中心网络:迟到不可怕,可怕的是别人都没迟到

17. 漫画:大模型用于腾讯广告,难在哪?

AI框架系列:

1.搞深度学习框架的那帮人,不是疯子,就是骗子(一)

2.搞AI框架那帮人丨燎原火,贾扬清(二)

3.搞 AI 框架那帮人(三):狂热的 AlphaFold 和沉默的中国科学家

4.搞 AI 框架那帮人(四):AI 框架前传,大数据系统往事文章来源:https://www.toymoban.com/news/detail-834291.html

注:(三)和(四)仅收录于《我看见了风暴》。文章来源地址https://www.toymoban.com/news/detail-834291.html

到了这里,关于卷大模型开源,正确姿势是什么?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!