1.背景介绍

随着人工智能技术的不断发展,越来越多的企业开始投入人力、物力和财力来构建自己的企业级AI大模型。这些大模型在处理大规模数据、自然语言处理、图像识别等方面具有显著优势,为企业创造了巨大的价值。然而,构建企业级AI大模型并不是一件容易的事情,需要面对许多挑战,如数据处理、算法优化、模型训练、部署等。

在本文中,我们将从以下几个方面进行深入探讨:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2. 核心概念与联系

在本节中,我们将介绍一些关键的概念,包括AI大模型、企业级AI大模型、深度学习、神经网络等。这些概念将为我们的后续讨论提供基础。

2.1 AI大模型

AI大模型是指具有极大规模、高度复杂结构和强大表现力的人工智能模型。这些模型通常具有以下特点:

- 数据规模:AI大模型通常涉及的数据量非常大,可以达到百亿甚至千亿级别。

- 模型规模:AI大模型的参数量通常非常大,可以达到百万甚至千万级别。

- 计算复杂度:AI大模型的训练和推理过程通常具有极高的计算复杂度,需要大量的计算资源来完成。

2.2 企业级AI大模型

企业级AI大模型是指企业在实际应用中使用的AI大模型。这些模型通常具有以下特点:

- 业务需求驱动:企业级AI大模型的设计和开发都是为了满足企业的具体业务需求。

- 数据安全与隐私:企业级AI大模型需要遵循相关法律法规,确保数据安全和隐私保护。

- 可解释性与可靠性:企业级AI大模型需要具备一定的可解释性和可靠性,以满足企业的业务需求。

2.3 深度学习

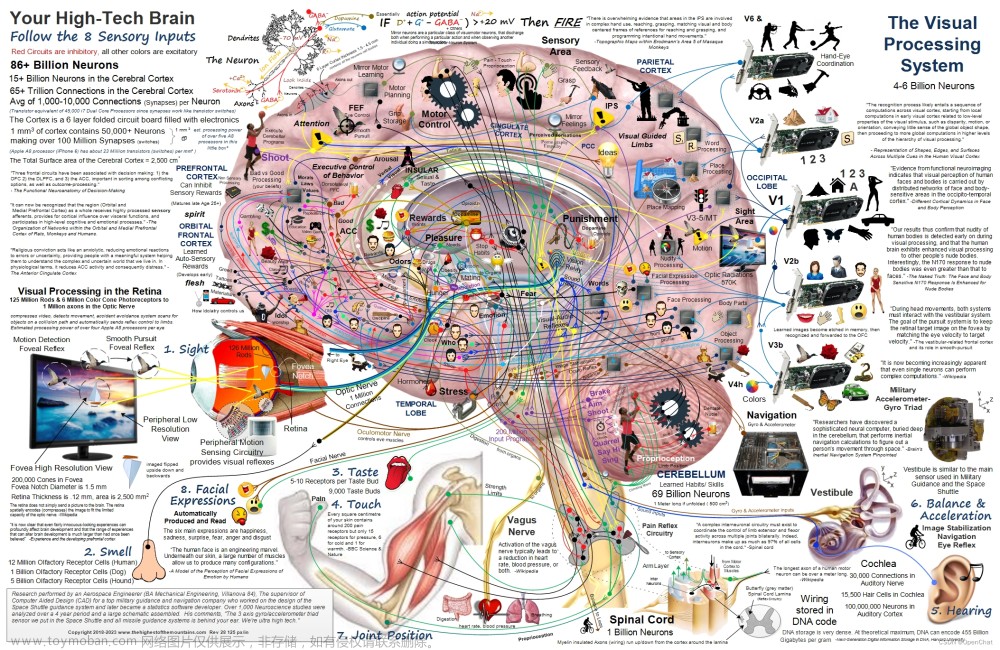

深度学习是一种通过多层神经网络来学习表示的方法,它在处理大规模数据和复杂任务方面具有显著优势。深度学习的核心思想是通过多层次的非线性转换,可以学习出更高级别的特征表示,从而实现更高的表现力。

2.4 神经网络

神经网络是深度学习的基本结构,它由多个节点(称为神经元)和多个连接(称为权重)组成。神经网络的每个节点都接收来自其他节点的输入,并根据其权重和激活函数来计算输出。神经网络通过训练(即调整权重)来学习输入-输出的映射关系。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

在本节中,我们将详细介绍一些核心算法原理,包括前馈神经网络、卷积神经网络、递归神经网络等。这些算法将为我们的后续讨论提供基础。

3.1 前馈神经网络

前馈神经网络(Feedforward Neural Network)是一种最基本的神经网络结构,它由输入层、隐藏层和输出层组成。在前馈神经网络中,数据从输入层传递到隐藏层,然后再传递到输出层。前馈神经网络的训练过程通常涉及到梯度下降算法,以最小化损失函数来调整权重。

3.1.1 前馈神经网络的训练过程

假设我们有一个前馈神经网络,其中包含$L$个层,包括$L-1$个隐藏层和一个输出层。我们使用$x^{(l)}$表示第$l$个层的输入,$y^{(l)}$表示第$l$个层的输出,$w^{(l)}$表示第$l$个层的权重,$b^{(l)}$表示第$l$个层的偏置。

训练过程的目标是找到一个最小化损失函数$J(\theta)$的参数$\theta$(其中$\theta$包括所有权重和偏置)。常见的损失函数包括均方误差(Mean Squared Error,MSE)和交叉熵损失(Cross-Entropy Loss)等。

通常,我们使用梯度下降算法来最小化损失函数。梯度下降算法的基本思想是在梯度方向上更新参数,直到损失函数达到最小值。具体来说,我们可以使用以下公式来更新权重和偏置:

$$ w^{(l)}{ij} = w^{(l)}{ij} - \alpha \frac{\partial J(\theta)}{\partial w^{(l)}_{ij}} $$

$$ b^{(l)}{j} = b^{(l)}{j} - \alpha \frac{\partial J(\theta)}{\partial b^{(l)}_{j}} $$

其中$\alpha$是学习率,它控制了梯度下降算法的速度。

3.1.2 前馈神经网络的前向传播

在前馈神经网络的前向传播过程中,我们首先将输入数据$x^{(0)}$传递到第一个隐藏层,然后逐层传递到其他隐藏层和输出层。具体来说,我们可以使用以下公式来计算每个层的输出:

$$ z^{(l)}{j} = \sum{i} w^{(l)}{ij} * a^{(l-1)}{i} + b^{(l)}_{j} $$

$$ a^{(l)}{j} = f(z^{(l)}{j}) $$

其中$z^{(l)}{j}$是第$l$个层的输入,$a^{(l)}{j}$是第$l$个层的激活值,$f$是激活函数。

3.1.3 前馈神经网络的反向传播

在前馈神经网络的反向传播过程中,我们首先计算输出层的误差,然后逐层计算每个隐藏层的误差,最后更新权重和偏置。具体来说,我们可以使用以下公式来计算每个层的误差:

$$ \delta^{(l)}{j} = \frac{\partial J(\theta)}{\partial z^{(l)}{j}} * f'(z^{(l)}_{j}) $$

其中$\delta^{(l)}_{j}$是第$l$个层的误差,$f'$是激活函数的导数。

3.2 卷积神经网络

卷积神经网络(Convolutional Neural Network,CNN)是一种特殊类型的神经网络,它主要应用于图像处理任务。卷积神经网络的核心结构是卷积层,它通过卷积操作来学习图像中的特征。

3.2.1 卷积层的训练过程

卷积层的训练过程与前馈神经网络类似,也涉及到梯度下降算法来最小化损失函数。不同之处在于,卷积层的权重是通过卷积核来表示的,卷积核通常是二维的,用于处理二维图像数据。

3.2.2 卷积层的前向传播

卷积层的前向传播过程与前馈神经网络类似,也涉及到卷积操作来计算输入图像中的特征。具体来说,我们可以使用以下公式来计算卷积层的输出:

$$ y{ij} = \sum{k} w{ik} * x{jk} + b_{i} $$

其中$y{ij}$是卷积层的输出,$w{ik}$是卷积核,$x{jk}$是输入图像,$b{i}$是偏置。

3.2.3 卷积层的反向传播

卷积层的反向传播过程与前馈神经网络类似,也涉及到卷积操作来计算误差。具体来说,我们可以使用以下公式来计算卷积层的误差:

$$ \delta{i} = \frac{\partial J(\theta)}{\partial y{i}} * f'(y_{i}) $$

其中$\delta_{i}$是卷积层的误差,$f'$是激活函数的导数。

3.3 递归神经网络

递归神经网络(Recurrent Neural Network,RNN)是一种能够处理序列数据的神经网络,它通过递归结构来处理时间序列数据。

3.3.1 递归神经网络的训练过程

递归神经网络的训练过程与前馈神经网络类似,也涉及到梯度下降算法来最小化损失函数。不同之处在于,递归神经网络的权重是通过隐藏状态来表示的,隐藏状态通过递归关系来更新。

3.3.2 递归神经网络的前向传播

递归神经网络的前向传播过程与前馈神经网络类似,也涉及到递归关系来计算隐藏状态。具体来说,我们可以使用以下公式来计算递归神经网络的输出:

$$ ht = f(W * h{t-1} + U * x_t + b) $$

$$ yt = g(V * ht + c) $$

其中$ht$是隐藏状态,$xt$是输入序列,$y_t$是输出序列,$W$、$U$、$V$是权重矩阵,$b$、$c$是偏置向量,$f$和$g$是激活函数。

3.3.3 递归神经网络的反向传播

递归神经网络的反向传播过程与前馈神经网络类似,也涉及到递归关系来计算隐藏状态的误差。具体来说,我们可以使用以下公式来计算递归神经网络的误差:

$$ \deltat = \frac{\partial J(\theta)}{\partial ht} * f'(W * h{t-1} + U * xt + b) $$

其中$\delta_t$是隐藏状态的误差,$f'$是激活函数的导数。

4. 具体代码实例和详细解释说明

在本节中,我们将通过一个具体的代码实例来展示如何使用Python和TensorFlow来构建一个前馈神经网络。

```python import tensorflow as tf

定义前馈神经网络的结构

class FeedForwardNet(tf.keras.Model): def init(self, inputshape, hiddenunits, outputunits): super(FeedForwardNet, self).init() self.dense1 = tf.keras.layers.Dense(hiddenunits, activation='relu') self.dense2 = tf.keras.layers.Dense(output_units, activation='softmax')

def call(self, inputs):

x = self.dense1(inputs)

return self.dense2(x)定义训练数据和标签

input_data = tf.random.normal([100, 10]) labels = tf.random.uniform([100, 10], minval=0, maxval=10, dtype=tf.int32)

定义前馈神经网络

model = FeedForwardNet(inputshape=(10,), hiddenunits=10, output_units=10)

定义损失函数和优化器

lossfn = tf.keras.losses.SparseCategoricalCrossentropy(fromlogits=True) optimizer = tf.keras.optimizers.Adam()

训练前馈神经网络

model.compile(optimizer=optimizer, loss=lossfn, metrics=['accuracy']) model.fit(inputdata, labels, epochs=10) ```

在上述代码中,我们首先定义了一个前馈神经网络的结构,包括一个隐藏层和一个输出层。然后我们定义了训练数据和标签,并使用TensorFlow来构建和训练前馈神经网络。在训练过程中,我们使用了SparseCategoricalCrossentropy作为损失函数,并使用Adam作为优化器。

5. 未来发展趋势与挑战

在本节中,我们将讨论企业级AI大模型的未来发展趋势与挑战。

5.1 未来发展趋势

- 数据规模的增长:随着数据生成和收集的速度不断加快,企业级AI大模型将面临更大规模的数据挑战。这将需要更高效的数据处理和存储技术,以及更强大的计算资源。

- 算法优化:随着AI技术的不断发展,企业级AI大模型将需要更先进的算法来提高其性能。这将需要跨学科的合作,以及对现有算法的不断优化和创新。

- 模型解释性和可靠性:随着AI技术的广泛应用,企业级AI大模型将需要更高的解释性和可靠性,以满足企业的业务需求。这将需要对模型的设计和训练过程进行深入研究,以及对模型的性能进行严格评估。

5.2 挑战

- 数据隐私和安全:企业级AI大模型需要处理大量敏感数据,这将引发数据隐私和安全的挑战。企业需要采取措施来保护数据的隐私和安全,同时也需要遵循相关法律法规。

- 算法解释性和可靠性:企业级AI大模型的解释性和可靠性是企业业务成功的关键。企业需要采取措施来提高模型的解释性和可靠性,以满足企业的业务需求。

- 算法伪原子性:企业级AI大模型的训练和部署过程通常涉及多个组件,这将引发算法伪原子性的挑战。企业需要采取措施来确保这些组件之间的协同和互补,以提高模型的性能。

6. 附录常见问题与解答

在本节中,我们将回答一些关于企业级AI大模型的常见问题。

6.1 如何选择合适的AI技术栈?

选择合适的AI技术栈取决于企业的具体需求和资源。企业可以根据需求选择合适的框架(如TensorFlow或PyTorch),并根据资源选择合适的硬件(如GPU或TPU)。

6.2 如何保护模型的知识 Property?

保护模型的知识Property需要采取多种措施,例如对模型进行加密,对模型的训练和部署过程进行保密,以及对模型的使用和传播进行权限管理。

6.3 如何评估模型的性能?

评估模型的性能需要采取多种方法,例如使用标准的性能指标(如准确率、F1分数等),使用竞争对手模型进行比较,使用用户反馈进行评估。文章来源:https://www.toymoban.com/news/detail-834485.html

总结

在本文中,我们详细介绍了企业级AI大模型的基本概念、核心算法原理、具体代码实例和未来发展趋势与挑战。我们希望这篇文章能够帮助读者更好地理解企业级AI大模型的相关知识,并为企业的AI应用提供有益的启示。文章来源地址https://www.toymoban.com/news/detail-834485.html

到了这里,关于从零开始:构建企业级AI大模型的最佳实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!