1.背景介绍

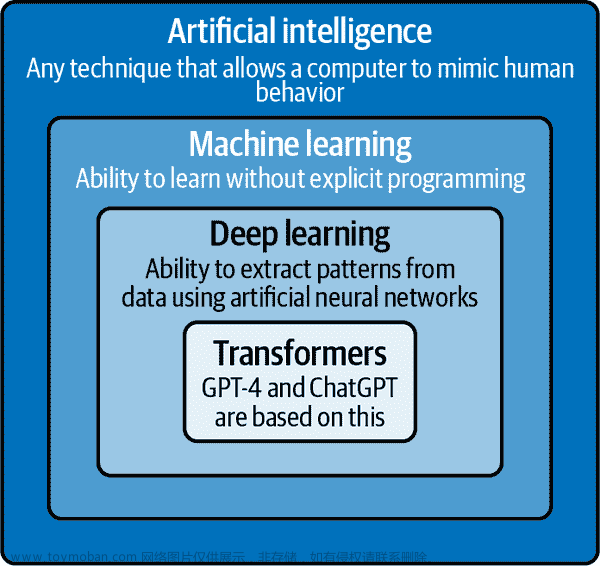

人工智能(AI)和机器学习(ML)技术在过去几年中取得了显著的进展,为许多领域带来了革命性的改变。自动化图像生成(AIGC)是一种使用AI和ML技术自动生成高质量图像的方法。AIGC框架可以应用于许多场景,例如生成艺术作品、设计、广告、电影制作等。本文将深入探讨AIGC框架的核心概念、算法原理、具体操作步骤以及数学模型公式,并提供代码实例和未来发展趋势与挑战。

2.核心概念与联系

AIGC框架的核心概念包括:

生成模型:生成模型是AIGC框架的核心组件,负责根据输入的条件生成图像。常见的生成模型有生成对抗网络(GAN)、变分自编码器(VAE)和循环生成对抗网络(CycleGAN)等。

条件生成:条件生成是指根据输入的条件(例如文本描述、图像标签等)生成图像。这种方法可以实现对图像的有意义控制和扩展。

图像生成任务:AIGC框架可以应用于多种图像生成任务,例如图像生成、图像修复、图像翻译、图像增强等。

训练数据:训练数据是AIGC框架的关键组件,用于训练生成模型。高质量的训练数据可以提高生成模型的性能。

评估指标:评估指标用于评估生成模型的性能,例如Inception Score(IS)、Fréchet Inception Distance(FID)等。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 生成模型

3.1.1 GAN

GAN由两个相互对抗的神经网络组成:生成器(G)和判别器(D)。生成器生成图像,判别器判断生成的图像是真实图像还是生成的图像。GAN的训练过程可以理解为一个最小化判别器误差的过程。

3.1.2 VAE

VAE是一种生成模型,它可以通过变分推断学习生成图像。VAE的核心思想是通过编码器(encoder)和解码器(decoder)来实现图像的生成和重构。编码器将输入图像编码为低维的随机变量,解码器将这些随机变量重构为图像。

3.1.3 CycleGAN

CycleGAN是一种跨域图像生成模型,它可以将图像从一个域转换为另一个域。CycleGAN的核心思想是通过两个生成器和两个判别器实现域间的转换。

3.2 条件生成

条件生成可以通过以下方法实现:

条件生成模型:将条件信息(例如文本描述、图像标签等)与生成模型的输入进行拼接,然后通过生成模型生成图像。

条件随机场(CRF):将条件信息与生成模型的输入进行拼接,然后使用条件随机场对生成模型的输出进行条件化。

3.3 图像生成任务

3.3.1 图像生成

图像生成是指根据随机噪声生成图像。常见的图像生成任务包括:生成对抗网络(GAN)、变分自编码器(VAE)等。

3.3.2 图像修复

图像修复是指根据损坏的图像生成完整的图像。常见的图像修复任务包括:非局部均值平滑(NL-means)、深度卷积神经网络(DCNN)等。

3.3.3 图像翻译

图像翻译是指将一种图像类型转换为另一种图像类型。常见的图像翻译任务包括:条件生成模型、循环生成对抗网络(CycleGAN)等。

3.3.4 图像增强

图像增强是指通过对图像进行变换(例如旋转、翻转、裁剪等)生成新的图像。常见的图像增强任务包括:数据增强、随机翻转等。

3.4 训练数据

训练数据是AIGC框架的关键组件,用于训练生成模型。训练数据可以来自于实际场景(例如照片、画作等)或者生成模型自身生成的图像。

3.5 评估指标

评估指标用于评估生成模型的性能,例如Inception Score(IS)、Fréchet Inception Distance(FID)等。

4.具体代码实例和详细解释说明

在本节中,我们将提供一个使用PyTorch实现的简单GAN模型的代码实例。

```python import torch import torch.nn as nn import torch.optim as optim

Generator

class Generator(nn.Module): def init(self): super(Generator, self).init() self.main = nn.Sequential( nn.ConvTranspose2d(100, 256, 4, 1, 0, bias=False), nn.BatchNorm2d(256), nn.ReLU(True), nn.ConvTranspose2d(256, 128, 4, 2, 1, bias=False), nn.BatchNorm2d(128), nn.ReLU(True), nn.ConvTranspose2d(128, 64, 4, 2, 1, bias=False), nn.BatchNorm2d(64), nn.ReLU(True), nn.ConvTranspose2d(64, 3, 4, 2, 1, bias=False), nn.Tanh() )

def forward(self, input):

return self.main(input)Discriminator

class Discriminator(nn.Module): def init(self): super(Discriminator, self).init() self.main = nn.Sequential( nn.Conv2d(3, 64, 4, 2, 1, bias=False), nn.LeakyReLU(0.2, inplace=True), nn.Conv2d(64, 128, 4, 2, 1, bias=False), nn.BatchNorm2d(128), nn.LeakyReLU(0.2, inplace=True), nn.Conv2d(128, 256, 4, 2, 1, bias=False), nn.BatchNorm2d(256), nn.LeakyReLU(0.2, inplace=True), nn.Conv2d(256, 1, 4, 1, 0, bias=False), nn.Sigmoid() )

def forward(self, input):

return self.main(input)GAN

class GAN(nn.Module): def init(self, generator, discriminator): super(GAN, self).init() self.generator = generator self.discriminator = discriminator

def forward(self, input):

fake_image = self.generator(input)

real_image = self.discriminator(input)

return fake_image, real_imageTraining

def train(generator, discriminator, realimages, batchsize, learningrate, numepochs): # ... # 训练过程 # ...

主程序

if name == 'main': # 初始化生成器和判别器 generator = Generator() discriminator = Discriminator()

# 初始化优化器

optimizerG = optim.Adam(generator.parameters(), lr=learning_rate)

optimizerD = optim.Adam(discriminator.parameters(), lr=learning_rate)

# 训练GAN

train(generator, discriminator, real_images, batch_size, learning_rate, num_epochs)```

5.未来发展趋势与挑战

未来,AIGC框架将面临以下挑战:

高质量图像生成:AIGC框架需要生成更高质量的图像,以满足更多应用场景。

更高效的训练:AIGC框架需要更高效的训练方法,以减少训练时间和计算资源消耗。

更好的控制:AIGC框架需要更好的控制能力,以实现更有意义的图像生成。

更强的泛化能力:AIGC框架需要更强的泛化能力,以适应不同的应用场景和领域。

解决抗噪声和抗扭曲的问题:AIGC框架需要解决生成的图像抗噪声和抗扭曲的问题,以提高图像质量。

解决生成模型的模糊性和不稳定性:AIGC框架需要解决生成模型的模糊性和不稳定性,以提高生成模型的可靠性。

6.附录常见问题与解答

Q1:AIGC框架与传统图像生成方法有什么区别? A1:AIGC框架与传统图像生成方法的主要区别在于,AIGC框架可以根据输入的条件生成图像,而传统图像生成方法则无法实现这种有意义的控制。

Q2:AIGC框架可以应用于哪些领域? A2:AIGC框架可以应用于多个领域,例如艺术、设计、广告、电影制作等。

Q3:AIGC框架的训练数据是否必须是高质量的? A3:是的,训练数据是AIGC框架的关键组件,高质量的训练数据可以提高生成模型的性能。文章来源:https://www.toymoban.com/news/detail-834683.html

Q4:AIGC框架的评估指标有哪些? A4:AIGC框架的评估指标包括Inception Score(IS)、Fréchet Inception Distance(FID)等。文章来源地址https://www.toymoban.com/news/detail-834683.html

到了这里,关于第三章:AIGC框架和应用场景的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!