我创建了一个社区,欢迎大家一起学习交流。社区名称:Spider学习交流

注:该系列教程已经默认用户安装了Pycharm和Anaconda,未安装的可以参考我之前的博客有将如何安装。同时默认用户掌握了Python基础语法。

抓取网页代码之后,接着是从网页中提取信息,提取信息的方式有很多,可以使用正则来提取 ,但是写起来相对比较烦琐 。

在这用这些强大的解析库进行处理,,如 lxml、Beautiful Soup、pyquery等。

1.lxml安装

lxml是Python一个解析库,支持 HTML和XML解析,支持 XPath 解析方式,而且解析效率高。

#1.打开anaconda prompt

#2.激活前面创建的conda虚拟环境

conda activate spider

#3.输入下述代码进行安装

conda install lxml

#验证是否安装成功

#4.输入

python

#5.导入该包

import lxml

1.安装界面

2.验证是否成功安装

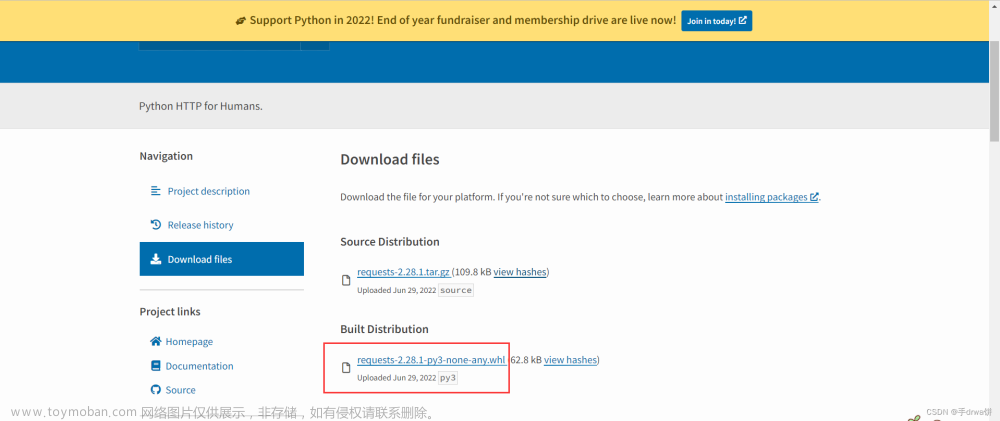

2.Beautiful Soup安装

Beautiful Soup是Python的HTML和XML的解析库,它拥有强大的 API和多样的解析方式。

安装方法同上。

给大家放个网址,大家可以自己查看。

Beautiful Soup 4.12.0

大家可以进去网址可以知道3已经停止开发,因此我们安装4.

大家有时间,可以学学HTML(CSS+javascript)很有帮助,主要好理解。

#1.打开anaconda prompt

#2.激活前面创建的conda虚拟环境

conda activate spider

#3.输入下述代码进行安装

conda install beautifulsoup4

#验证是否安装成功

#4.输入

python

#5.导入该包

from bs4 import BeautifulSoup

soup = BeautifulSoup('<p>Hello World!<p/>','lxml')

print(soup.p.string)

1.安装界面

2.验证

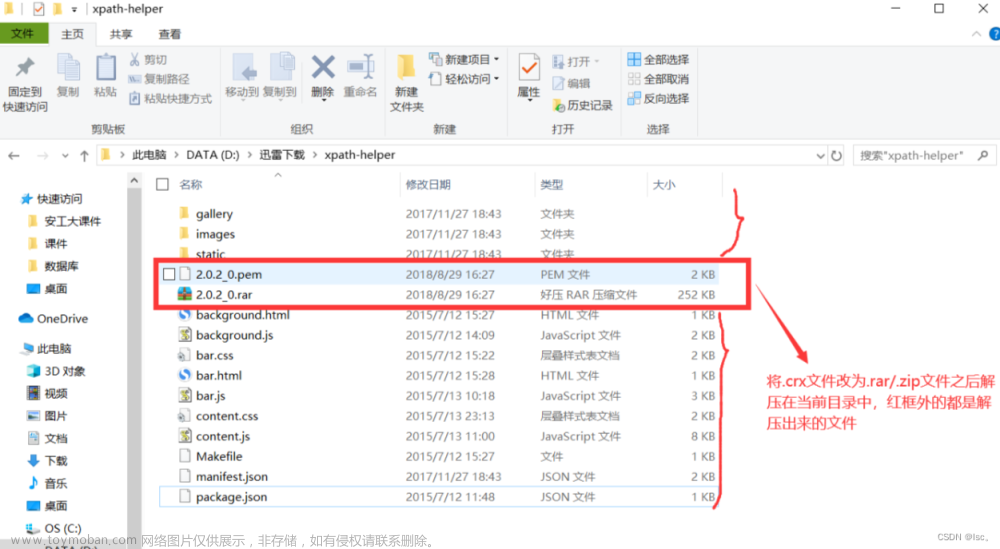

3.pyquery 的安装

pyquery是个很强大的网页解析工具,它提供了和 jQuery 类似的语法来解析HTML 文梢,支持css 择器。文章来源:https://www.toymoban.com/news/detail-834741.html

#1.打开anaconda prompt

#2.激活前面创建的conda虚拟环境

conda activate spider

#3.输入下述代码进行安装

conda install pyquery

#验证是否安装成功

#4.输入

python

#5.导入该包

import pyquery

1.安装

2.验证是否成功安装,如下图无报错,即成功安装 文章来源地址https://www.toymoban.com/news/detail-834741.html

文章来源地址https://www.toymoban.com/news/detail-834741.html

到了这里,关于Python爬虫——解析库安装(1)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!