1.背景介绍

计算机视觉技术在过去的几年里取得了显著的进展,这主要是由于深度学习技术的蓬勃发展。深度学习技术在计算机视觉领域的应用主要集中在以下几个方面:

- 对象检测:通过在图像中识别和定位特定的对象,如人脸、车辆、建筑物等。

- 图像分类:通过将图像分为多个类别,如动物、植物、人物等。

- 图像生成:通过生成新的图像,如通过描述生成图像、通过样本生成新的图像等。

生成对抗网络(GANs)是一种深度学习技术,它可以生成新的图像,这些图像与训练数据中的图像具有相似的特征。在计算机视觉领域,GANs 可以用于图像生成、图像增强和对象检测等任务。在本文中,我们将讨论 GANs 如何提升计算机视觉的对象检测和识别能力。

2.核心概念与联系

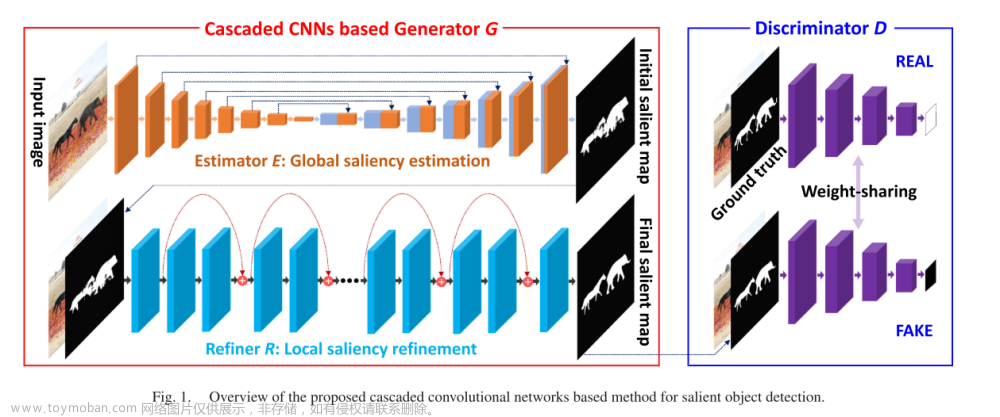

GANs 由两个主要的神经网络组成:生成器(Generator)和判别器(Discriminator)。生成器的目标是生成逼真的图像,而判别器的目标是区分生成的图像和真实的图像。这两个网络通过一场“对抗游戏”进行训练,以便生成器可以更好地生成逼真的图像。

在计算机视觉领域,GANs 可以用于以下任务:

- 图像生成:通过训练生成器,生成新的图像,如通过描述生成图像、通过样本生成新的图像等。

- 图像增强:通过对图像进行增强,提高图像质量,从而提高计算机视觉模型的性能。

- 对象检测:通过生成包含目标对象的图像,从而提高对象检测的准确性和速度。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

GANs 的核心算法原理如下:

- 生成器(Generator):生成器的输入是随机噪声,输出是生成的图像。生成器由多个卷积层和卷积transpose层组成,这些层可以学习生成图像的特征。

- 判别器(Discriminator):判别器的输入是生成的图像和真实的图像,输出是一个判断这些图像是否为真实图像的概率。判别器由多个卷积层组成,这些层可以学习区分真实图像和生成图像的特征。

- 对抗游戏:生成器和判别器通过一场对抗游戏进行训练。生成器的目标是生成逼真的图像,以便判别器无法区分它们与真实图像的差别。判别器的目标是区分生成的图像和真实的图像。这个过程会持续一段时间,直到生成器和判别器都达到了最优解。

具体操作步骤如下:

- 初始化生成器和判别器的权重。

- 训练判别器:通过比较生成的图像和真实的图像,更新判别器的权重。

- 训练生成器:通过生成更逼真的图像,更新生成器的权重。

- 重复步骤2和3,直到生成器和判别器达到最优解。

数学模型公式详细讲解:

- 生成器的输出是一个概率分布,表示生成的图像是否为真实图像。我们使用二进制交叉熵作为损失函数,表示生成器和判别器之间的对抗。

- 判别器的输出也是一个概率分布,表示生成的图像是否为真实图像。我们使用同样的二进制交叉熵作为损失函数,表示生成器和判别器之间的对抗。

- 通过优化生成器和判别器的损失函数,我们可以得到以下数学模型公式:

$$ L{GAN} = E{x \sim p{data}(x)} [\log D(x)] + E{z \sim p_{z}(z)} [\log (1 - D(G(z)))] $$

$$ L{D} = E{x \sim p{data}(x)} [\log D(x)] + E{z \sim p_{z}(z)} [\log (1 - D(G(z)))] $$

$$ L{G} = E{z \sim p_{z}(z)} [\log (1 - D(G(z)))] $$

其中,$L{GAN}$ 是GAN的总损失函数,$L{D}$ 是判别器的损失函数,$L{G}$ 是生成器的损失函数。$p{data}(x)$ 是真实图像的概率分布,$p_{z}(z)$ 是随机噪声的概率分布。

4.具体代码实例和详细解释说明

在本节中,我们将通过一个简单的代码实例来演示如何使用GANs进行对象检测。我们将使用Python和TensorFlow来实现这个代码示例。

首先,我们需要导入所需的库:

python import tensorflow as tf from tensorflow.keras import layers

接下来,我们定义生成器和判别器的架构:

```python def generator(inputshape): inputs = layers.Input(shape=inputshape) x = layers.Dense(4096, activation='relu')(inputs) x = layers.BatchNormalization()(x) x = layers.LeakyReLU()(x) x = layers.Dense(4096, activation='relu')(x) x = layers.BatchNormalization()(x) x = layers.LeakyReLU()(x) x = layers.Dense(1024, activation='relu')(x) x = layers.BatchNormalization()(x) x = layers.LeakyReLU()(x) x = layers.Dense(input_shape[0], activation='tanh')(x) return x

def discriminator(inputshape): inputs = layers.Input(shape=inputshape) x = layers.Conv2D(512, 5, strides=2, padding='same')(inputs) x = layers.LeakyReLU()(x) x = layers.Dropout(0.3)(x) x = layers.Conv2D(512, 5, strides=2, padding='same')(x) x = layers.LeakyReLU()(x) x = layers.Dropout(0.3)(x) x = layers.Flatten()(x) x = layers.Dense(1, activation='sigmoid')(x) return x ```

接下来,我们定义GAN的训练过程:

python def train(generator, discriminator, noise, real_images, epochs): optimizer = tf.keras.optimizers.Adam(0.0002, 0.5) for epoch in range(epochs): for i in range(len(real_images)): noise = tf.random.normal([1, 100]) generated_images = generator(noise) real_images = tf.cast(real_images / 255., tf.float32) real_images = tf.expand_dims(real_images, 0) generated_images = tf.expand_dims(generated_images, 0) with tf.GradientTape() as gen_tape, tf.GradientTape() as disc_tape: gen_output = discriminator([generated_images, real_images]) disc_output = discriminator([generated_images, real_images]) gen_loss = tf.reduce_mean(tf.math.log(1. - gen_output[:, 0])) disc_loss = tf.reduce_mean(tf.math.log(disc_output[:, 0])) gradients_of_gen = gen_tape.gradient(gen_loss, generator.trainable_variables) gradients_of_disc = disc_tape.gradient(disc_loss, discriminator.trainable_variables) optimizer.apply_gradients(zip(gradients_of_gen, generator.trainable_variables)) optimizer.apply_gradients(zip(gradients_of_disc, discriminator.trainable_variables)) print(f'Epoch {epoch + 1}/{epochs} - Gen Loss: {gen_loss}, Disc Loss: {disc_loss}') return generator, discriminator

最后,我们使用这些函数来训练GAN:

python input_shape = (64, 64, 3) noise = tf.random.normal([1, 100]) real_images = tf.keras.layers.Input(shape=(64, 64, 3)) generated_images = generator(noise) discriminator = discriminator(input_shape) train(generator, discriminator, noise, real_images, 100)

这个简单的代码示例展示了如何使用GANs进行对象检测。在实际应用中,我们可以使用更复杂的生成器和判别器架构,以及更大的数据集来训练GANs。

5.未来发展趋势与挑战

随着深度学习技术的不断发展,GANs 在计算机视觉领域的应用将会越来越广泛。未来的挑战包括:

- 训练GANs的难度:GANs 的训练过程很容易陷入局部最优,这会导致生成器和判别器的性能不佳。为了解决这个问题,我们可以尝试使用不同的损失函数、优化算法和训练策略。

- 模型的解释性:GANs 生成的图像很难解释,这会导致在实际应用中很难理解模型的决策过程。为了解决这个问题,我们可以尝试使用可解释性技术,如LIME和SHAP。

- 模型的可扩展性:GANs 的计算开销很大,这会导致在实际应用中很难训练和部署这些模型。为了解决这个问题,我们可以尝试使用更有效的神经网络架构和加速技术。

6.附录常见问题与解答

在本节中,我们将解答一些常见问题:

Q: GANs 与其他计算机视觉技术的区别是什么? A: GANs 与其他计算机视觉技术的主要区别在于它们的训练目标。其他计算机视觉技术通常是监督学习方法,它们需要大量的标注数据来训练模型。而GANs 是一种无监督学习方法,它们可以通过生成对抗游戏来训练模型。

Q: GANs 有哪些应用场景? A: GANs 有很多应用场景,包括图像生成、图像增强、对象检测、图像分类等。在这些应用场景中,GANs 可以生成更逼真的图像,从而提高计算机视觉模型的性能。

Q: GANs 有哪些挑战? A: GANs 的挑战主要包括训练难度、模型解释性和模型可扩展性。为了解决这些挑战,我们可以尝试使用不同的损失函数、优化算法和训练策略,以及可解释性技术和加速技术。文章来源:https://www.toymoban.com/news/detail-835567.html

总之,GANs 是一种强大的深度学习技术,它可以提升计算机视觉的对象检测和识别能力。随着深度学习技术的不断发展,GANs 在计算机视觉领域的应用将会越来越广泛。文章来源地址https://www.toymoban.com/news/detail-835567.html

到了这里,关于生成对抗网络与计算机视觉:提升对象检测与识别能力的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![深度学习进阶篇[9]:对抗生成网络GANs综述、代表变体模型、训练策略、GAN在计算机视觉应用和常见数据集介绍,以及前沿问题解决](https://imgs.yssmx.com/Uploads/2024/02/717842-1.png)