Docker容器中部署大型语言模型(LLM)项目,尤其是需要利用GPU进行加速的情况下,确保主机系统正确安装了NVIDIA驱动和CUDA是第一步。接着,你需要使用NVIDIA提供的Docker工具,如NVIDIA Container Toolkit,来确保容器可以访问宿主机的GPU资源。

步骤1: 确保主机上安装了NVIDIA驱动和CUDA

- 首先,确认你的系统上已经安装了合适的NVIDIA显卡驱动和CUDA版本。可以通过

nvidia-smi命令来检查。

步骤2: 安装NVIDIA Docker支持

为了让Docker容器能够使用GPU,你需要安装NVIDIA Container Toolkit。以下是在Ubuntu系统上安装NVIDIA Docker的步骤:

-

安装NVIDIA Container Toolkit:

distribution=$(. /etc/os-release;echo $ID$VERSION_ID) \ && curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add - \ && curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list -

更新软件包列表并安装nvidia-docker2:

sudo apt-get update sudo apt-get install -y nvidia-docker2 -

重启Docker服务:

sudo systemctl restart docker

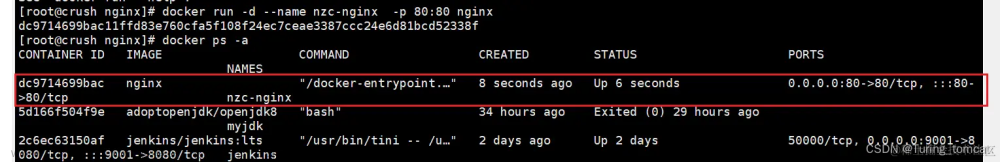

步骤3: 运行支持CUDA的Docker容器

安装NVIDIA Container Toolkit后,你可以运行支持CUDA的Docker容器了。使用--gpus all标志来允许Docker容器访问所有可用的GPU资源。

-

示例:运行支持CUDA的容器:

docker run --gpus all -it --rm nvidia/cuda:11.0-base nvidia-smi这个命令会启动一个基于

nvidia/cuda:11.0-base镜像的容器,并在容器内执行nvidia-smi命令,显示容器可以访问的GPU信息。

步骤4: 部署LLM模型

当你的Docker环境已经准备好支持CUDA后,接下来就是部署你的LLM模型。确保Docker镜像中包含了所有必要的依赖,包括正确版本的深度学习框架(如TensorFlow或PyTorch)和模型代码。你可以创建一个Dockerfile来构建包含这些依赖的镜像。文章来源:https://www.toymoban.com/news/detail-835794.html

- 在Dockerfile中,确保选择一个包含CUDA支持的基础镜像,比如

nvidia/cuda。

注意事项

- 兼容性:确保你使用的CUDA镜像版本与宿主机上安装的CUDA版本兼容。

-

性能考虑:在生产环境中,合理分配GPU资源,可能需要根据具体需求调整

--gpus参数。

通过遵循这些步骤,你就可以在Docker容器中部署并运行使用GPU加速的大型语言模型了。文章来源地址https://www.toymoban.com/news/detail-835794.html

到了这里,关于docker部署llm模型的项目,需要安装什么驱动的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!