1.背景介绍

1. 背景介绍

Web抓取和爬虫技术是现代互联网应用中不可或缺的一部分。它们可以帮助我们自动收集和处理大量的网页内容,从而提取有价值的信息。Python是一种强大的编程语言,拥有丰富的第三方库和框架,使得在Python中进行Web抓取和爬虫编程变得非常简单和高效。

本文将从以下几个方面进行阐述:

- 核心概念与联系

- 核心算法原理和具体操作步骤

- 数学模型公式详细讲解

- 具体最佳实践:代码实例和详细解释说明

- 实际应用场景

- 工具和资源推荐

- 总结:未来发展趋势与挑战

- 附录:常见问题与解答

2. 核心概念与联系

2.1 Web抓取与爬虫的定义

Web抓取(Web Crawling)是指通过自动化的程序从互联网上的网页上收集信息的过程。爬虫(Web Crawler)是用于实现Web抓取的程序。爬虫通常会按照一定的规则和策略访问网页,并从中提取有价值的信息。

2.2 爬虫的工作原理

爬虫的工作原理主要包括以下几个步骤:

- 发现:爬虫首先需要找到一个或多个需要抓取的网页的URL。这些URL可以是人工设定的,也可以是通过网页内容中的链接自动发现的。

- 访问:爬虫通过HTTP协议发送请求给服务器,请求获取网页的内容。

- 解析:爬虫解析收到的网页内容,并根据预定义的规则提取有价值的信息。

- 存储:爬虫将提取到的信息存储到本地或数据库中,以便后续使用。

- 跟踪:爬虫根据网页内容中的链接更新自己的访问列表,并继续抓取下一个网页。

2.3 Python中的Web抓取和爬虫库

Python中有许多用于Web抓取和爬虫编程的第三方库,其中最著名的是requests和BeautifulSoup。requests库用于发送HTTP请求,BeautifulSoup库用于解析HTML和XML文档。此外,还有其他一些库,如Scrapy、MechanicalSoup等,可以提供更高级的功能和性能。

3. 核心算法原理和具体操作步骤

3.1 使用requests库发送HTTP请求

requests库是Python中最常用的HTTP库之一。它提供了简单易用的接口,可以用于发送各种类型的HTTP请求。以下是一个使用requests发送GET请求的示例:

```python import requests

url = 'http://example.com' response = requests.get(url)

print(response.status_code) print(response.text) ```

3.2 使用BeautifulSoup库解析HTML文档

BeautifulSoup库是一个用于解析HTML和XML文档的库。它可以帮助我们快速地提取网页中的有价值信息。以下是一个使用BeautifulSoup解析HTML文档的示例:

```python from bs4 import BeautifulSoup

html = '

title = soup.title.string print(title) ```

3.3 爬虫的核心算法

爬虫的核心算法主要包括以下几个部分:

- URL队列:用于存储待抓取的URL。

- 请求发送器:用于发送HTTP请求。

- 解析器:用于解析收到的网页内容。

- 数据提取器:用于提取有价值的信息。

- 数据存储器:用于存储提取到的信息。

以下是一个简单的爬虫示例:

```python import requests from bs4 import BeautifulSoup

def crawl(url): response = requests.get(url) soup = BeautifulSoup(response.text, 'html.parser') title = soup.title.string print(title)

urls = ['http://example.com', 'http://example.org'] for url in urls: crawl(url) ```

4. 数学模型公式详细讲解

在实际应用中,我们可能需要使用一些数学模型来解决爬虫编程中的一些问题,例如:

- 网页内容的抓取速度和效率

- 网页内容的相似性和重复性

- 网页链接的拓扑结构和连通性

这些问题可以通过一些数学模型来描述和解决。以下是一个简单的例子:

4.1 网页内容的抓取速度和效率

网页内容的抓取速度和效率可以通过计算平均抓取时间来衡量。假设有N个网页需要抓取,每个网页的抓取时间为t,那么整个抓取过程的平均抓取时间可以通过以下公式计算:

$$ \bar{t} = \frac{1}{N} \sum{i=1}^{N} ti $$

4.2 网页内容的相似性和重复性

网页内容的相似性和重复性可以通过计算Jaccard相似度来衡量。假设有两个网页A和B,它们的文本内容分别为TA和TB,那么它们的Jaccard相似度可以通过以下公式计算:

$$ J(A, B) = \frac{|TA \cap TB|}{|TA \cup TB|} $$

4.3 网页链接的拓扑结构和连通性

网页链接的拓扑结构和连通性可以通过计算连通分量来描述。假设有一个有向图G,其中每个节点表示一个网页,每条边表示一个链接,那么G的连通分量可以通过以下公式计算:

$$ C = \text{strongly connected components}(G) $$

5. 具体最佳实践:代码实例和详细解释说明

在实际应用中,我们可以根据具体需求和场景选择合适的爬虫编程方法和技术。以下是一个实际应用场景的例子:

5.1 爬取新闻网站的头条新闻

假设我们需要爬取一个新闻网站的头条新闻,以下是一个简单的爬虫示例:

```python import requests from bs4 import BeautifulSoup

def crawl_headlines(url): response = requests.get(url) soup = BeautifulSoup(response.text, 'html.parser') headlines = soup.select('.headline') for headline in headlines: print(headline.text)

url = 'http://example.com/news' crawl_headlines(url) ```

5.2 爬取电子商务网站的商品信息

假设我们需要爬取一个电子商务网站的商品信息,以下是一个简单的爬虫示例:

```python import requests from bs4 import BeautifulSoup

def crawlproducts(url): response = requests.get(url) soup = BeautifulSoup(response.text, 'html.parser') products = soup.select('.product') for product in products: name = product.selectone('.product-name').text price = product.select_one('.product-price').text print(name, price)

url = 'http://example.com/products' crawl_products(url) ```

6. 实际应用场景

爬虫技术可以应用于各种场景,例如:

- 数据挖掘:爬取网页内容,以便进行数据分析和挖掘。

- 搜索引擎:爬取网页内容,以便为用户提供搜索结果。

- 网站监控:定期爬取网站内容,以便检测网站是否正常运行。

- 社交网络:爬取社交网络数据,以便进行分析和挖掘。

- 新闻爬虫:爬取新闻网站的头条新闻,以便实时了解新闻动态。

- 电子商务:爬取电子商务网站的商品信息,以便进行价格比较和购物引导。

7. 工具和资源推荐

在实际应用中,我们可以使用以下工具和资源来提高爬虫编程的效率和质量:

- 第三方库:

requests、BeautifulSoup、Scrapy、MechanicalSoup等。 - 数据存储:MySQL、MongoDB、Redis等。

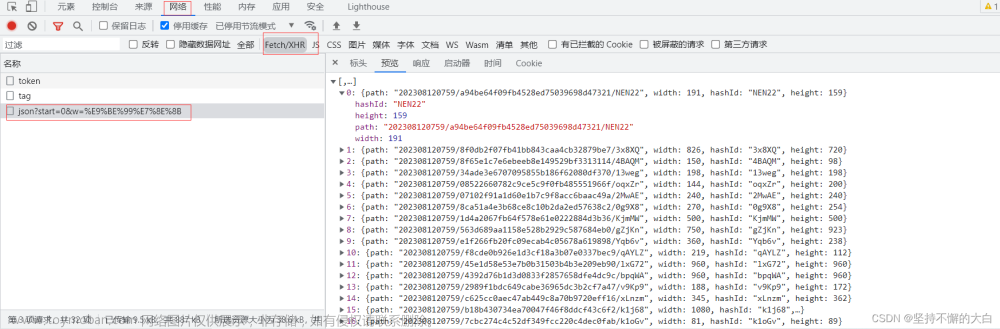

- 网络工具:Fiddler、Charles、Wireshark等。

- 学习资源:官方文档、博客、视频、课程等。

8. 总结:未来发展趋势与挑战

爬虫技术已经发展了很长时间,但仍然存在一些挑战:

- 网站防爬虫技术:越来越多的网站采用防爬虫技术,以阻止爬虫抓取其内容。

- 网络速度和稳定性:网络速度和稳定性对爬虫性能有很大影响。

- 数据处理和存储:大量的抓取到的数据需要进行处理和存储,这可能会带来一些技术和性能挑战。

未来,爬虫技术可能会发展到以下方向:

- 智能爬虫:通过机器学习和人工智能技术,使爬虫具有更高的自主性和智能性。

- 分布式爬虫:通过分布式技术,使爬虫能够更高效地抓取大量数据。

- 安全爬虫:通过加密和安全技术,保护爬虫和网络安全。

9. 附录:常见问题与解答

在实际应用中,我们可能会遇到一些常见问题,例如:文章来源:https://www.toymoban.com/news/detail-835969.html

- Q: 如何处理被封禁的IP地址? A: 可以使用代理服务器或VPN来解决这个问题。

- Q: 如何处理网页中的JavaScript和Ajax内容? A: 可以使用

Selenium或Pyppeteer等库来解决这个问题。 - Q: 如何处理网页中的CAPTCHA验证? A: 可以使用

deform或2Captcha等库来解决这个问题。 - Q: 如何处理网页中的cookie和session? A: 可以使用

requests库的cookies参数来解决这个问题。

本文已经详细介绍了爬虫技术的核心概念、算法原理、实际应用场景和最佳实践。希望这篇文章能够帮助读者更好地理解和掌握爬虫编程的技能和方法。文章来源地址https://www.toymoban.com/news/detail-835969.html

到了这里,关于使用Python进行Web抓取和爬虫的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!