1.背景介绍

优化问题是计算机科学和数学中的一个重要领域,它涉及到寻找一个函数的最大值或最小值。在机器学习、数据挖掘和人工智能等领域,优化问题是非常常见的。这篇文章将讨论如何使用 Hessian 矩阵 和凸性函数来解决这些问题。

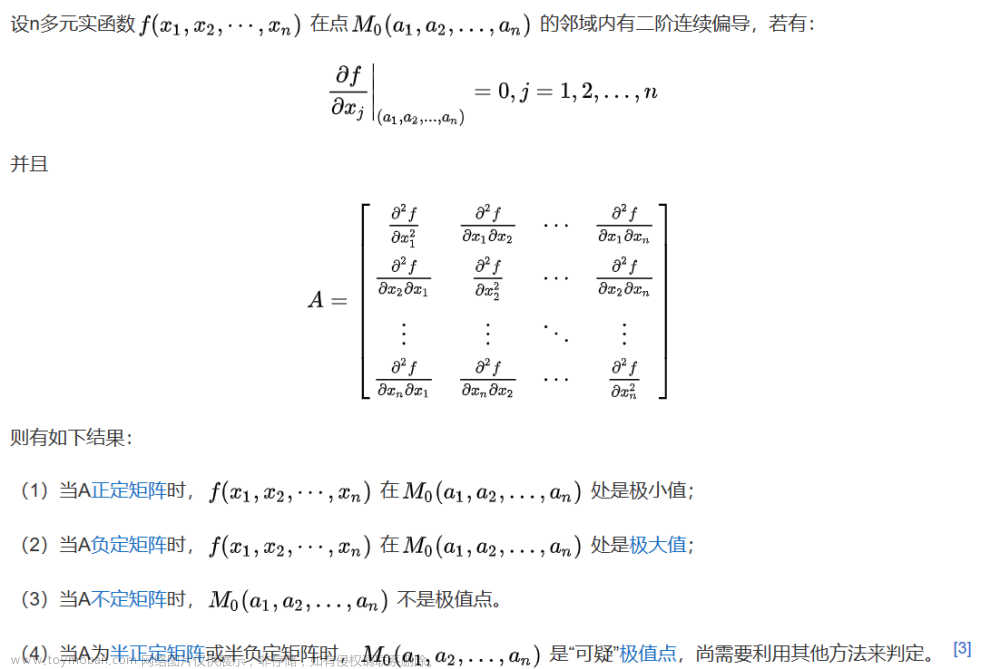

Hessian 矩阵是一种二阶微分矩阵,它用于表示一个函数在某一点的二阶导数。凸性函数是一种特殊类型的函数,它在整个域内具有唯一的极大值或极小值。这两个概念在优化问题中具有重要的作用。

在本文中,我们将讨论以下内容:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2. 核心概念与联系

2.1 Hessian 矩阵

Hessian 矩阵是一种二阶微分矩阵,它用于表示一个函数在某一点的二阶导数。对于一个二元函数 f(x, y),其 Hessian 矩阵 H 定义为:

$$ H = \begin{bmatrix} \frac{\partial^2 f}{\partial x^2} & \frac{\partial^2 f}{\partial x \partial y} \ \frac{\partial^2 f}{\partial y \partial x} & \frac{\partial^2 f}{\partial y^2} \end{bmatrix} $$

Hessian 矩阵可以用来判断函数在某一点的凸性、凹性或非凹性。如果 Hessian 矩阵在该点都是正定的(即所有元素都是正数),则函数在该点凸;如果 Hessian 矩阵在该点都是负定的(即所有元素都是负数),则函数在该点凹;否则,函数在该点是非凹的。

2.2 凸性函数

凸性函数是一种特殊类型的函数,它在整个域内具有唯一的极大值或极小值。如果对于任何两个点 x 和 y 以及任何 0 < t < 1,都有 f(t * x + (1 - t) * y) <= max(f(x), f(y)),则函数 f 是凸的。

凸性函数在优化问题中具有重要的作用,因为它们的梯度下降算法可以保证收敛到全局最优解。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 梯度下降算法

梯度下降算法是一种常用的优化算法,它通过在梯度方向上进行小步长的更新来逐步接近函数的极大值或极小值。对于一个函数 f(x),梯度下降算法的步骤如下:

- 初始化 x 为某个值。

- 计算梯度 g = ∇f(x)。

- 选择一个学习率 α。

- 更新 x = x - α * g。

- 重复步骤 2-4,直到收敛。

3.2 新罗勒梯度下降算法

新罗勒梯度下降算法是一种改进的梯度下降算法,它使用 Hessian 矩阵来加速收敛。对于一个函数 f(x),新罗勒梯度下降算法的步骤如下:

- 初始化 x 为某个值。

- 计算梯度 g = ∇f(x)。

- 计算 Hessian 矩阵 H。

- 选择一个学习率 α。

- 更新 x = x - α * (H^(-1) * g)。

- 重复步骤 2-5,直到收敛。

3.3 牛顿法

牛顿法是一种高级优化算法,它使用 Hessian 矩阵来计算函数在某一点的极小值。对于一个函数 f(x),牛顿法的步骤如下:

- 初始化 x 为某个值。

- 计算梯度 g = ∇f(x)。

- 计算 Hessian 矩阵 H。

- 解决以下方程组:

$$ \begin{cases} H * dx = -g \ x = x + dx \end{cases} $$

- 重复步骤 2-4,直到收敛。

4. 具体代码实例和详细解释说明

在这里,我们将通过一个简单的例子来展示如何使用新罗勒梯度下降算法和牛顿法来解决优化问题。假设我们要优化的函数为:

$$ f(x) = x^4 - 4x^3 + 3x^2 $$

首先,我们需要计算函数的梯度和 Hessian 矩阵:

$$ \frac{\partial f}{\partial x} = 4x^3 - 12x^2 + 6x $$

$$ \frac{\partial^2 f}{\partial x^2} = 12x^2 - 24x + 6 $$

$$ \frac{\partial^2 f}{\partial x \partial y} = 0 $$

现在,我们可以使用新罗勒梯度下降算法和牛顿法来解决这个优化问题。以下是使用 Python 编写的代码实例:

```python import numpy as np

def f(x): return x4 - 4x3 + 3x**2

def grad_f(x): return 4x3 - 12x2 + 6*x

def hessian_f(x): return 12x2 - 24x + 6

def newtonraphson(x0, alpha, maxiter): x = x0 g = gradf(x) h = hessianf(x) for i in range(max_iter): dx = -alpha * np.linalg.solve(h, g) x = x + dx if np.abs(dx) < 1e-6: break return x

def gradientdescent(x0, alpha, maxiter): x = x0 g = gradf(x) for i in range(maxiter): dx = -alpha * g x = x + dx if np.abs(dx) < 1e-6: break return x

x0 = 1 alpha = 0.1 max_iter = 1000

xnewton = newtonraphson(x0, alpha, maxiter) print("Newton-Raphson method:", xnewton)

xgradientdescent = gradientdescent(x0, alpha, maxiter) print("Gradient descent method:", xgradientdescent) ```

从这个例子中,我们可以看到新罗勒梯度下降算法和牛顿法的优势。虽然两个算法的收敛速度相似,但牛顿法在某些情况下可以更快地收敛。

5. 未来发展趋势与挑战

随着大数据技术的发展,优化问题在机器学习、数据挖掘和人工智能等领域的应用越来越广泛。这也带来了一些挑战,例如:

大规模优化问题:随着数据规模的增加,传统的优化算法可能无法有效地处理这些问题。我们需要开发更高效的算法来解决这些问题。

非凸优化问题:许多现实世界的优化问题是非凸的,传统的优化算法在这些问题上的表现不佳。我们需要开发更高效的算法来解决这些问题。

多目标优化问题:在实际应用中,我们经常遇到多目标优化问题,这些问题的解是一个多维向量,而不是一个数值。我们需要开发新的多目标优化算法来解决这些问题。

6. 附录常见问题与解答

Q: 什么是梯度下降算法? A: 梯度下降算法是一种常用的优化算法,它通过在梯度方向上进行小步长的更新来逐步接近函数的极大值或极小值。

Q: 什么是新罗勒梯度下降算法? A: 新罗勒梯度下降算法是一种改进的梯度下降算法,它使用 Hessian 矩阵来加速收敛。

Q: 什么是牛顿法? A: 牛顿法是一种高级优化算法,它使用 Hessian 矩阵来计算函数在某一点的极小值。文章来源:https://www.toymoban.com/news/detail-836116.html

Q: 为什么 Hessian 矩阵对于优化问题非常重要? A: Hessian 矩阵可以用来判断函数在某一点的凸性、凹性或非凹性,并且可以用来加速优化算法的收敛。文章来源地址https://www.toymoban.com/news/detail-836116.html

到了这里,关于优化问题解决:Hessian 矩阵与凸性函数的算法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!