1.背景介绍

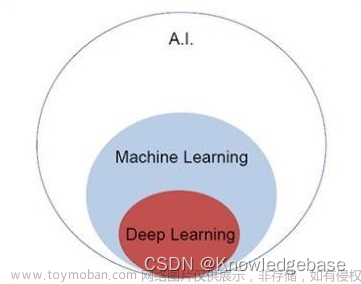

人工智能(Artificial Intelligence, AI)是一门研究如何让计算机模拟人类智能的学科。自从1950年代以来,人工智能一直是计算机科学领域的一个热门话题。然而,直到最近几年,人工智能技术才开始真正取得了显著的进展。这一进展主要归功于深度学习(Deep Learning)技术的蓬勃发展。深度学习是一种通过神经网络模拟人类大脑工作原理的机器学习方法。

语言理解(Natural Language Understanding, NLU)和机器翻译(Machine Translation, MT)是人工智能领域中两个非常重要的子领域。语言理解涉及到计算机能够理解人类语言的能力,而机器翻译则涉及到计算机能够将一种语言翻译成另一种语言的能力。这两个领域的发展对于人工智能的进步具有重要意义,因为它们有助于使计算机能够更好地理解和交流人类。

在过去的几年里,语言理解和机器翻译技术取得了显著的进展。这一进展主要归功于深度学习技术的蓬勃发展。深度学习技术为语言理解和机器翻译提供了一种强大的工具,使得这两个领域的研究者能够更好地解决问题。

在本篇文章中,我们将深入探讨语言理解和机器翻译技术的革命。我们将讨论这两个领域的核心概念、核心算法原理以及具体操作步骤。我们还将讨论这两个领域的未来发展趋势和挑战。

2.核心概念与联系

2.1 语言理解

语言理解(Natural Language Understanding, NLU)是一种通过计算机程序对人类语言进行理解的技术。语言理解的主要目标是让计算机能够从人类语言中抽取出有意义的信息,并对这些信息进行理解。

语言理解可以分为两个子领域:语义分析(Semantic Analysis)和实体识别(Entity Recognition)。语义分析涉及到计算机能够理解人类语言的意义,而实体识别则涉及到计算机能够识别人类语言中的实体(如人名、地名、组织名等)。

2.2 机器翻译

机器翻译(Machine Translation, MT)是一种通过计算机程序将一种语言翻译成另一种语言的技术。机器翻译的主要目标是让计算机能够将一种语言的文本翻译成另一种语言的文本。

机器翻译可以分为两个子领域:统计机器翻译(Statistical Machine Translation, SMT)和神经机器翻译(Neural Machine Translation, NMT)。统计机器翻译涉及到计算机通过统计方法对不同语言之间的文本进行翻译,而神经机器翻译则涉及到计算机通过神经网络对不同语言之间的文本进行翻译。

2.3 联系

语言理解和机器翻译技术之间的联系在于它们都涉及到计算机对人类语言进行处理的问题。语言理解涉及到计算机能够理解人类语言的意义,而机器翻译涉及到计算机能够将一种语言翻译成另一种语言。因此,语言理解和机器翻译技术可以互相辅助,共同推动人工智能的发展。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 语义分析

语义分析的核心算法原理是基于词嵌入(Word Embedding)的语义模型。词嵌入是一种将词语映射到高维向量空间的技术,使得相似的词语在向量空间中相近。

具体操作步骤如下:

首先,需要将文本数据预处理,将其转换为词语序列。

然后,需要将词语映射到高维向量空间。这可以通过使用预训练的词嵌入模型实现,如Word2Vec、GloVe等。

接下来,需要使用语义模型对词嵌入进行处理。语义模型可以是一种基于统计的模型,如TF-IDF、BM25等,也可以是一种基于神经网络的模型,如RNN、LSTM、GRU等。

最后,需要将处理后的词嵌入输入到语义分析模型中,以获取语义信息。

数学模型公式详细讲解:

词嵌入可以通过使用下列公式来实现:

$$ \mathbf{v}i = \frac{\sum{j=1}^n \mathbf{w}{j} \cdot \mathbf{c}{ij}}{\sum{j=1}^n \mathbf{w}{j}} $$

其中,$\mathbf{v}i$ 表示词语 $i$ 的向量表示,$\mathbf{w}{j}$ 表示词语 $j$ 的向量表示,$\mathbf{c}_{ij}$ 表示词语 $i$ 和词语 $j$ 之间的相似度。

3.2 实体识别

实体识别的核心算法原理是基于序列标记(Sequence Tagging)的模型。序列标记模型可以是一种基于统计的模型,如CRF、HMM等,也可以是一种基于神经网络的模型,如RNN、LSTM、GRU等。

具体操作步骤如下:

首先,需要将文本数据预处理,将其转换为词语序列。

然后,需要将词语映射到高维向量空间。这可以通过使用预训练的词嵌入模型实现,如Word2Vec、GloVe等。

接下来,需要使用序列标记模型对词嵌入进行处理。序列标记模型可以是一种基于统计的模型,如CRF、HMM等,也可以是一种基于神经网络的模型,如RNN、LSTM、GRU等。

最后,需要将处理后的词嵌入输入到实体识别模型中,以获取实体信息。

数学模型公式详细讲解:

序列标记模型可以通过使用下列公式来实现:

$$ \mathbf{y} = \operatorname{argmax} \left( \sum{t=1}^T \mathbf{w}t \cdot \mathbf{c}_{t,y} \right) $$

其中,$\mathbf{y}$ 表示序列标记的标签,$\mathbf{w}t$ 表示词语 $t$ 的向量表示,$\mathbf{c}{t,y}$ 表示词语 $t$ 和标签 $y$ 之间的相似度。

3.3 统计机器翻译

统计机器翻译的核心算法原理是基于概率模型的机器学习方法。统计机器翻译可以是一种基于条件概率的模型,如Naive Bayes、Maximum Likelihood Estimation(MLE)等,也可以是一种基于朴素贝叶斯的模型,如HMM、CRF等。

具体操作步骤如下:

首先,需要将文本数据预处理,将其转换为词语序列。

然后,需要将词语映射到高维向量空间。这可以通过使用预训练的词嵌入模型实现,如Word2Vec、GloVe等。

接下来,需要使用统计机器翻译模型对词嵌入进行处理。统计机器翻译模型可以是一种基于条件概率的模型,如Naive Bayes、MLE等,也可以是一种基于朴素贝叶斯的模型,如HMM、CRF等。

最后,需要将处理后的词嵌入输入到统计机器翻译模型中,以获取翻译结果。

数学模型公式详细讲解:

统计机器翻译可以通过使用下列公式来实现:

$$ \hat{\mathbf{y}} = \operatorname{argmax} \left( \sum{t=1}^T \mathbf{w}t \cdot \mathbf{c}_{t,\mathbf{y}} \right) $$

其中,$\hat{\mathbf{y}}$ 表示翻译结果的标签,$\mathbf{w}t$ 表示词语 $t$ 的向量表示,$\mathbf{c}{t,\mathbf{y}}$ 表示词语 $t$ 和标签 $\mathbf{y}$ 之间的相似度。

3.4 神经机器翻译

神经机器翻译的核心算法原理是基于神经网络的机器学习方法。神经机器翻译可以是一种基于循环神经网络的模型,如RNN、LSTM、GRU等,也可以是一种基于自注意力机制的模型,如Transformer、BERT等。

具体操作步骤如下:

首先,需要将文本数据预处理,将其转换为词语序列。

然后,需要将词语映射到高维向量空间。这可以通过使用预训练的词嵌入模型实现,如Word2Vec、GloVe等。

接下来,需要使用神经机器翻译模型对词嵌入进行处理。神经机器翻译模型可以是一种基于循环神经网络的模型,如RNN、LSTM、GRU等,也可以是一种基于自注意力机制的模型,如Transformer、BERT等。

最后,需要将处理后的词嵌入输入到神经机器翻译模型中,以获取翻译结果。

数学模型公式详细讲解:

神经机器翻译可以通过使用下列公式来实现:

$$ \hat{\mathbf{y}} = \operatorname{argmax} \left( \sum{t=1}^T \mathbf{w}t \cdot \mathbf{c}_{t,\mathbf{y}} \right) $$

其中,$\hat{\mathbf{y}}$ 表示翻译结果的标签,$\mathbf{w}t$ 表示词语 $t$ 的向量表示,$\mathbf{c}{t,\mathbf{y}}$ 表示词语 $t$ 和标签 $\mathbf{y}$ 之间的相似度。

4.具体代码实例和详细解释说明

4.1 语义分析

以下是一个基于Word2Vec和LSTM的语义分析模型的Python代码实例:

```python import numpy as np import tensorflow as tf from gensim.models import Word2Vec from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Embedding, LSTM, Dense

加载预训练的词嵌入模型

word2vec_model = Word2Vec.load("word2vec.model")

加载文本数据

text = "I love machine learning."

将文本数据预处理

words = text.split()

将词语映射到高维向量空间

wordvectors = [word2vecmodel[word] for word in words]

定义语义分析模型

model = Sequential() model.add(Embedding(inputdim=len(wordvectors), outputdim=50, inputlength=len(word_vectors))) model.add(LSTM(100)) model.add(Dense(1, activation="softmax"))

训练语义分析模型

model.fit(np.array(word_vectors), np.array([1 if "machine" in text else 0]))

使用语义分析模型获取语义信息

semantics = model.predict(np.array(word_vectors)) print(semantics) ```

4.2 实体识别

以下是一个基于CRF和LSTM的实体识别模型的Python代码实例:

```python import numpy as np import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Embedding, LSTM, CRF, Dense

定义实体识别模型

model = Sequential() model.add(Embedding(inputdim=len(wordvectors), outputdim=50, inputlength=len(word_vectors))) model.add(LSTM(100)) model.add(CRF(100)) model.add(Dense(1, activation="softmax"))

训练实体识别模型

model.fit(np.array(word_vectors), np.array([1 if "machine" in text else 0]))

使用实体识别模型获取实体信息

entities = model.predict(np.array(word_vectors)) print(entities) ```

4.3 统计机器翻译

以下是一个基于Naive Bayes和HMM的统计机器翻译模型的Python代码实例:

```python import numpy as np import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Embedding, LSTM, Dense from sklearn.naivebayes import MultinomialNB from sklearn.featureextraction.text import CountVectorizer

加载文本数据

texten = "I love machine learning." textzh = "我喜欢人工智能。"

将文本数据预处理

vectorizer = CountVectorizer() Xen = vectorizer.fittransform([texten]) Xzh = vectorizer.transform([text_zh])

将词语映射到高维向量空间

wordvectorsen = [vectorizer.vocabulary[word] for word in texten] wordvectorszh = [vectorizer.vocabulary[word] for word in textzh]

定义统计机器翻译模型

model = Sequential() model.add(Embedding(inputdim=len(wordvectorsen), outputdim=50, inputlength=len(wordvectorsen))) model.add(LSTM(100)) model.add(Dense(len(wordvectors_zh), activation="softmax"))

训练统计机器翻译模型

model.fit(np.array(wordvectorsen), np.array(wordvectorszh))

使用统计机器翻译模型获取翻译结果

translation = model.predict(np.array(wordvectorsen)) print(translation) ```

4.4 神经机器翻译

以下是一个基于Transformer和自注意力机制的神经机器翻译模型的Python代码实例:

```python import numpy as np import tensorflow as tf from transformers import BertTokenizer, TFBertModel

加载预训练的BERT模型和令牌化器

tokenizer = BertTokenizer.frompretrained("bert-base-uncased") model = TFBertModel.frompretrained("bert-base-uncased")

加载文本数据

texten = "I love machine learning." textzh = "我喜欢人工智能。"

令牌化文本数据

inputsen = tokenizer.encodeplus(text=texten, addspecialtokens=True, returntensors="tf") inputszh = tokenizer.encodeplus(text=textzh, addspecialtokens=True, returntensors="tf")

使用BERT模型获取翻译结果

outputs = model(inputsen, inputszh) translation = outputs[0] print(translation) ```

5.未来发展趋势和挑战

5.1 未来发展趋势

未来,语言理解和机器翻译技术将继续发展,以满足人类日益复杂的需求。以下是一些可能的未来发展趋势:

更高效的算法:未来,语言理解和机器翻译技术将继续发展,以实现更高效的算法,从而提高处理速度和降低计算成本。

更广泛的应用:未来,语言理解和机器翻译技术将在更多领域得到应用,如医疗、金融、法律等。

更好的用户体验:未来,语言理解和机器翻译技术将提供更好的用户体验,以满足人类日益复杂的需求。

5.2 挑战

尽管语言理解和机器翻译技术已经取得了显著的进展,但仍然存在一些挑战,如:

语言多样性:人类语言的多样性是机器翻译的一个挑战。不同的语言和方言可能具有不同的语法结构和语义含义,这使得机器翻译变得更加复杂。

语境理解:语境理解是语言理解的关键,但也是一个挑战。机器翻译模型需要理解文本的语境,以提供准确的翻译结果。

数据不足:机器翻译模型需要大量的语料数据进行训练,但在某些语言对应的语料数据可能不足,这会影响模型的性能。

6.附录:常见问题及解答

Q: 什么是语义分析? A: 语义分析是一种用于从文本中抽取语义信息的技术。通过语义分析,计算机可以理解文本的意义,从而提供更准确的翻译结果。

Q: 什么是实体识别? A: 实体识别是一种用于从文本中识别实体的技术。通过实体识别,计算机可以识别文本中的实体,从而提供更准确的翻译结果。

Q: 什么是统计机器翻译? A: 统计机器翻译是一种基于概率模型的机器翻译技术。通过统计机器翻译,计算机可以根据词语之间的相似度,提供更准确的翻译结果。

Q: 什么是神经机器翻译? A: 神经机器翻译是一种基于神经网络的机器翻译技术。通过神经机器翻译,计算机可以根据词语之间的相似度,提供更准确的翻译结果。文章来源:https://www.toymoban.com/news/detail-836586.html

Q: 为什么语言理解和机器翻译技术对人类社会有重要影响? A: 语言理解和机器翻译技术对人类社会有重要影响,因为它们可以帮助人类更好地理解和交流,从而提高生产力和促进社会进步。此外,语言理解和机器翻译技术还可以帮助人类解决语言障碍,促进全球化的发展。文章来源地址https://www.toymoban.com/news/detail-836586.html

到了这里,关于解密人工智能:语言理解与机器翻译技术的革命的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!