1.背景介绍

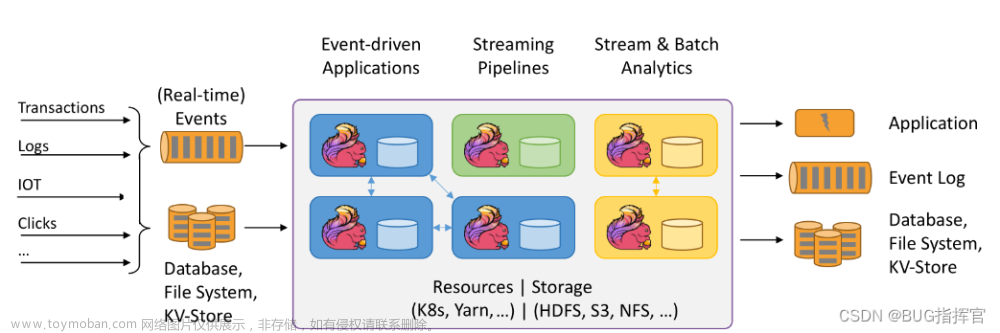

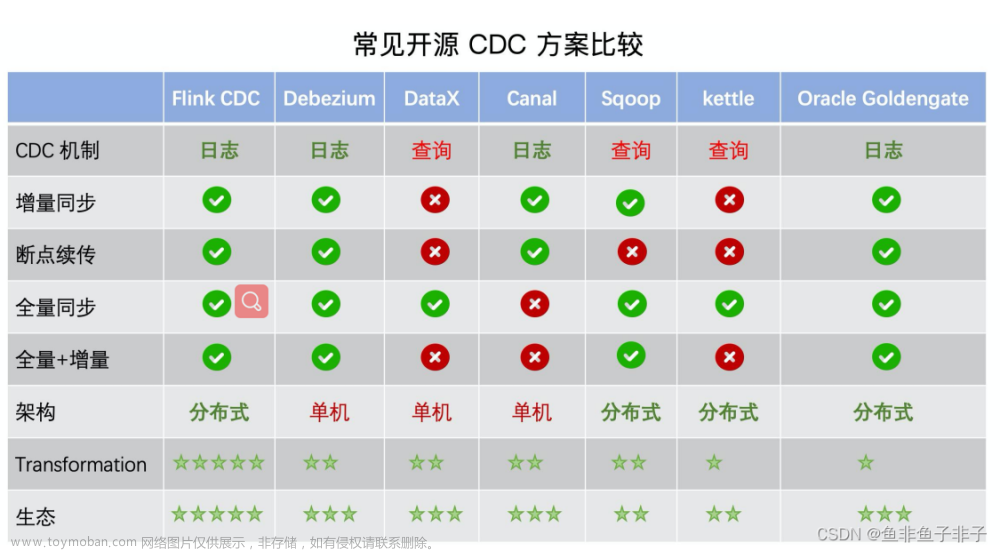

在大数据时代,实时数据处理和分析已经成为企业和组织中不可或缺的技术。Apache Flink是一种流处理框架,它可以实时处理大量数据,并提供高吞吐量和低延迟。在大数据处理中,数据压缩和解压是非常重要的一部分,因为它可以减少存储和传输开销,提高系统性能。本文将讨论Flink如何应用实时数据压缩和解压,以及相关的核心概念、算法原理和实例代码。

2.核心概念与联系

在Flink中,数据压缩和解压是指将数据从一种格式转换为另一种格式的过程。这种转换可以减少数据的大小,从而提高系统性能。Flink支持多种压缩和解压算法,如Gzip、LZ4、Snappy等。这些算法可以根据不同的需求和场景选择。

Flink的数据压缩和解压主要与以下几个核心概念有关:

- 数据源(Source):Flink中的数据源是生成数据的来源,可以是文件、数据库、网络流等。

- 数据流(Stream):Flink中的数据流是一种无限序列,用于表示实时数据的流动。

- 数据接收器(Sink):Flink中的数据接收器是数据流的终点,可以是文件、数据库、网络流等。

- 数据转换(Transformation):Flink中的数据转换是对数据流进行操作的过程,可以包括过滤、聚合、分组等。

- 数据压缩(Compression):Flink中的数据压缩是将数据流中的数据转换为更小的格式的过程。

- 数据解压(Decompression):Flink中的数据解压是将数据流中的数据转换回原始格式的过程。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

Flink中的数据压缩和解压算法主要包括以下几种:

-

Gzip:Gzip是一种常见的数据压缩算法,基于LZ77算法。它可以将数据压缩为更小的格式,但压缩率相对较低。Gzip的压缩和解压过程如下:

- 压缩:将数据流中的数据按照一定的规则进行编码,生成压缩后的数据流。

- 解压:将压缩后的数据流按照一定的规则进行解码,恢复原始数据流。

-

LZ4:LZ4是一种高性能的数据压缩算法,基于LZ77算法。它可以将数据压缩为更小的格式,压缩率相对较高。LZ4的压缩和解压过程如下:

- 压缩:将数据流中的数据按照一定的规则进行编码,生成压缩后的数据流。

- 解压:将压缩后的数据流按照一定的规则进行解码,恢复原始数据流。

-

Snappy:Snappy是一种快速的数据压缩算法,基于LZ77算法。它可以将数据压缩为更小的格式,压缩率相对较高。Snappy的压缩和解压过程如下:

- 压缩:将数据流中的数据按照一定的规则进行编码,生成压缩后的数据流。

- 解压:将压缩后的数据流按照一定的规则进行解码,恢复原始数据流。

在Flink中,数据压缩和解压可以通过以下步骤实现:

- 创建数据源,生成数据流。

- 对数据流进行压缩,生成压缩后的数据流。

- 对压缩后的数据流进行操作,如过滤、聚合、分组等。

- 对压缩后的数据流进行解压,恢复原始数据流。

- 将原始数据流发送到数据接收器。

4.具体代码实例和详细解释说明

在Flink中,可以使用以下代码实现数据压缩和解压:

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.streaming.util.serialization.SimpleStringSchema; import org.apache.flink.table.api.EnvironmentSettings; import org.apache.flink.table.api.TableEnvironment; import org.apache.flink.table.descriptors.FileSystem; import org.apache.flink.table.descriptors.Schema; import org.apache.flink.table.descriptors.Source; import org.apache.flink.table.descriptors.Sink;

public class FlinkCompressionExample { public static void main(String[] args) throws Exception { // 设置Flink执行环境 EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inStreamingMode().build(); StreamExecutionEnvironment env = StreamExecutionEnvironment.create(settings); TableEnvironment tableEnv = TableEnvironment.create(env);

// 设置数据源

Source<String> source = tableEnv.readStrings(

new Source<String>(

new SimpleStringSchema(),

"file:///path/to/input/data.txt",

"file:///path/to/output/data.txt",

"file:///path/to/output/data.gz",

"file:///path/to/output/data.lz4",

"file:///path/to/output/data.snappy"

)

);

// 设置数据接收器

Sink<String> sink = tableEnv.writeStrings(

new Sink<String>(

new FileSystem().path("file:///path/to/output/data.txt"),

new FileSystem().path("file:///path/to/output/data.gz"),

new FileSystem().path("file:///path/to/output/data.lz4"),

new FileSystem().path("file:///path/to/output/data.snappy")

)

);

// 设置数据流转换

DataStream<String> dataStream = env.fromCollection(source);

dataStream.map(x -> x.toUpperCase())

.keyBy(x -> x)

.sum(1)

.print();

// 设置数据接收器

dataStream.addSink(sink);

// 执行Flink程序

env.execute("Flink Compression Example");

}} ```

在上述代码中,我们首先设置Flink执行环境,然后设置数据源和数据接收器。接着,我们设置数据流转换,将输入数据流进行转换,并将转换后的数据流发送到数据接收器。最后,我们执行Flink程序。

5.未来发展趋势与挑战

在未来,Flink应用实时数据压缩与解压的发展趋势和挑战主要有以下几个方面:

- 性能优化:随着数据量的增加,Flink应用实时数据压缩与解压的性能优化将成为关键问题。未来,我们需要不断优化压缩和解压算法,提高Flink应用的性能。

- 多语言支持:Flink目前主要支持Java和Scala等编程语言。未来,我们需要扩展Flink的多语言支持,以便更多的开发者可以使用Flink应用实时数据压缩与解压。

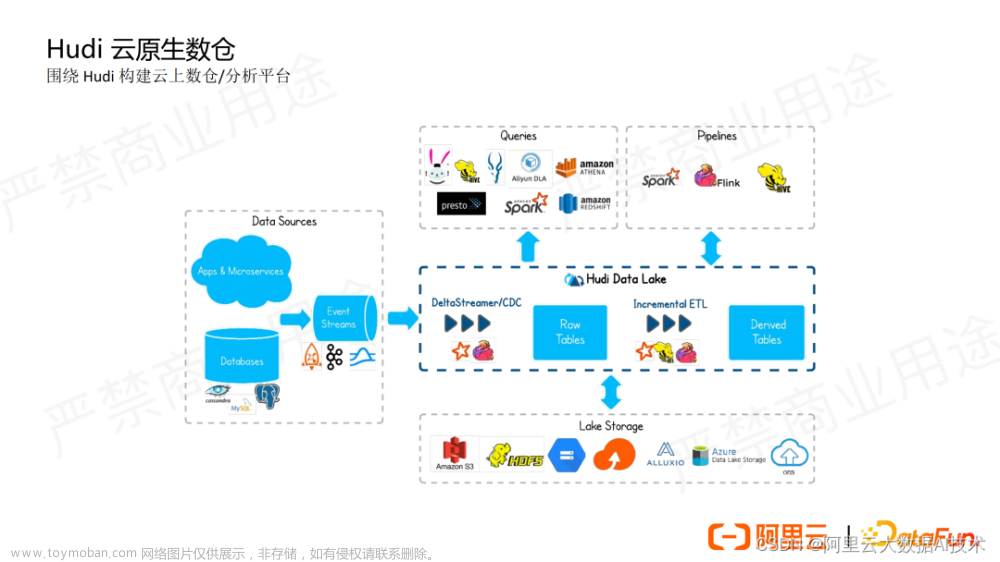

- 云原生支持:随着云计算的普及,Flink需要更好地支持云原生技术。未来,我们需要开发云原生的Flink应用实时数据压缩与解压组件,以便更好地满足企业和组织的需求。

- 安全性和隐私保护:随着数据的敏感性增加,Flink应用实时数据压缩与解压的安全性和隐私保护将成为关键问题。未来,我们需要开发安全性和隐私保护的Flink应用实时数据压缩与解压组件,以便更好地保护数据的安全性和隐私。

6.附录常见问题与解答

Q:Flink应用实时数据压缩与解压有哪些优势?

A:Flink应用实时数据压缩与解压的优势主要有以下几个方面:

- 减少存储和传输开销:通过压缩数据,可以减少存储和传输的开销,从而提高系统性能。

- 提高系统性能:压缩和解压算法可以提高系统性能,降低延迟。

- 支持多种压缩和解压算法:Flink支持多种压缩和解压算法,可以根据不同的需求和场景选择。

Q:Flink应用实时数据压缩与解压有哪些挑战?

A:Flink应用实时数据压缩与解压的挑战主要有以下几个方面:

- 性能优化:随着数据量的增加,Flink应用实时数据压缩与解压的性能优化将成为关键问题。

- 多语言支持:Flink目前主要支持Java和Scala等编程语言。未来,我们需要扩展Flink的多语言支持,以便更多的开发者可以使用Flink应用实时数据压缩与解压。

- 云原生支持:随着云计算的普及,Flink需要更好地支持云原生技术。未来,我们需要开发云原生的Flink应用实时数据压缩与解压组件,以便更好地满足企业和组织的需求。

- 安全性和隐私保护:随着数据的敏感性增加,Flink应用实时数据压缩与解压的安全性和隐私保护将成为关键问题。未来,我们需要开发安全性和隐私保护的Flink应用实时数据压缩与解压组件,以便更好地保护数据的安全性和隐私。

Q:Flink应用实时数据压缩与解压有哪些应用场景?

A:Flink应用实时数据压缩与解压的应用场景主要有以下几个方面:

- 大数据处理:Flink应用实时数据压缩与解压可以用于处理大量数据,提高系统性能。

- 实时分析:Flink应用实时数据压缩与解压可以用于实时分析,提高分析效率。

- 云计算:Flink应用实时数据压缩与解压可以用于云计算,降低存储和传输开销。

参考文献

[1] Apache Flink官方文档。https://flink.apache.org/docs/stable/

[2] Lempel, A., & Ziv, Y. (1976). A Universal Algorithm for Sequential Data Compression. IEEE Transactions on Information Theory, 22(6), 628-630.

[3] Welch, T. (1984). A Technique for High-Speed Adaptive Transform Coding. IEEE Transactions on Information Theory, 30(6), 724-751.文章来源:https://www.toymoban.com/news/detail-836588.html

[4] Zhang, Y., & Zhang, H. (2008). A Fast Lempel-Ziv-Welch Compression Algorithm. IEEE Transactions on Information Theory, 54(1), 263-274.文章来源地址https://www.toymoban.com/news/detail-836588.html

到了这里,关于Flink应用实时数据压缩与解压的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!