一、hadoop部署

| master | slave1 | slave2 | |

| namenode | 是 | ||

| secondarynamenode | 是 | ||

| datanode | 是 | 是 | 是 |

| resourcemanager | 是 | ||

| nodemanager | 是 | 是 | 是 |

| jobhistory | 是 |

二、相关设置

1、主机名与ip映射:hosts文件

验证:ping master,ping slave1,ping slave2

hosts文件要传送至slave1,slave2。思考原因?(让slave1和slave2可以通过主机名ping通对方)

2、免密

与之前默认部署区别,“老大”部署位置要留意,由老大带动一群小弟,老大对小弟要有免密权限。

之前免密设置:master->master,master->slave1,master->slave2

现最好设置:master,slave1,slave2之间相互免密

master->master,master->slave1,master->slave2

slave1->master,master->slave1,master->slave2

slave2->master,master->slave1,master->slave2

3、java环境支持

master,slave1,slave2,环境变量/etc/profile设置

验证:java -version,javac

slave1,slave2可传送,并验证。

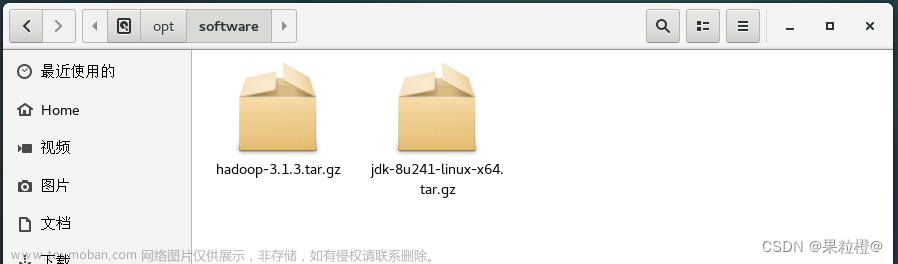

4、hadoop安装

先在master中解压安装,并设置环境变量,然后验证。

最后根据部署要求进行相关配置设置。然后分发给slave1,slave2。在master(namenode)中进行格式化。

验证:启动验证。(注意启动位置)

master中启动:start-dfs.sh。namenode部署位置

slave2中启动:start-yarn.sh。resourcemanager部署位置

slave1中启动历史服务器。jobhistory部署位置

淘汰的命令:mr-jobhistory-daemon.sh start historyserver

mapred --daemon start historyserver

三、相关配置

在hadoop安装目录下依次创建hadoopDatas/tempDatas,hadoopDatas/namenodesDatas,hadoopDatas/datanodeDatas,hadoopDatas/dfs/nn/edits,hadoopDatas/dfs/snn/name,hadoopDatas/dfs/nn/snn/edits

1、hadoop-env.sh配置。

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_DATANODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

export JAVA_HOME=/app/jdk1.8 java家目录位置

2、works

master

slave1

slave2

3、core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9820</value>

</property>文章来源地址https://www.toymoban.com/news/detail-836960.html

<property>

<name>hadoop.tmp.dir</name>

<value>/app/hadoop3.1/hadoopDatas/tempDatas</value>

</property>

4、hdfs-site.xml

<property>

<name>dfs.namenode.name.dir</name>

<value>/app/hadoop3.1/hadoopDatas/namenodeDatas</value>

</property>

<property>

<name>dfs.namenode.data.dir</name>

<value>/app/hadoop3.1/hadoopDatas/datanodeDatas</value>

</property>

<property>

<name>dfs.namenode.edits.dir</name>

<value>/app/hadoop3.1/hadoopDatas/dfs/nn/edits</value>

</property>

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>/app/hadoop3.1/hadoopDatas/dfs/snn/name</value>

</property>

<property>

<name>dfs.namenode.checkpoint.edits.dir</name>

<value>/app/hadoop3.1/hadoopDatas/dfs/nn/snn/edits</value>

</property>

<property>

<name>dfs.replication</name> 副本数

<value>3</value>

</property>

<property>

#secondarynamenode 节点

<name>dfs.namenode.secondary.http-address</name>

<value>slave1</value>

</property>

5、mapreduce-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>slave2:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>slave2:19888</value>

</property>

6.yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>slave3</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>文章来源:https://www.toymoban.com/news/detail-836960.html

</property>

到了这里,关于hadoop3相关配置的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!