1.背景介绍

1. 背景介绍

HBase是一个分布式、可扩展、高性能的列式存储系统,基于Google的Bigtable设计。它是Hadoop生态系统的一部分,可以与HDFS、MapReduce、ZooKeeper等组件集成。HBase非常适用于实时数据访问和高速写入场景,如日志记录、实时数据分析、搜索引擎等。

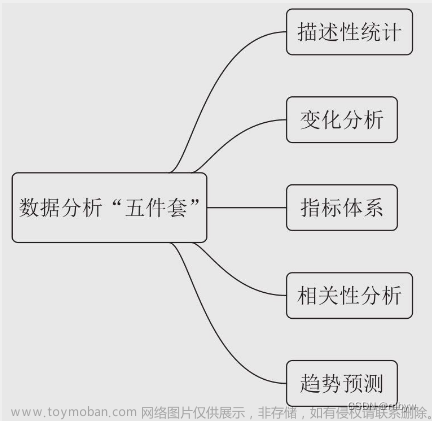

在现实生活中,运营数据分析是一项非常重要的技能,可以帮助企业了解客户行为、优化业务流程、提高效率等。运营数据分析涉及到大量的数据处理、存储和查询,这就是HBase发挥优势的地方。

本文将从以下几个方面进行阐述:

- 核心概念与联系

- 核心算法原理和具体操作步骤

- 数学模型公式详细讲解

- 具体最佳实践:代码实例和详细解释说明

- 实际应用场景

- 工具和资源推荐

- 总结:未来发展趋势与挑战

- 附录:常见问题与解答

2. 核心概念与联系

2.1 HBase核心概念

- 表(Table):HBase中的表类似于传统关系型数据库中的表,由一组列族(Column Family)组成。

- 列族(Column Family):列族是一组相关列的容器,用于存储同一类数据。列族内的列名是有序的,可以通过列族名和列名来访问数据。

- 行(Row):HBase中的行是表中唯一的一条数据,由一个唯一的行键(Row Key)组成。

- 列(Column):列是表中的一个单独的数据项,由列族名、列名和行键组成。

- 单元(Cell):单元是表中最小的数据单位,由行键、列键和值组成。

- 时间戳(Timestamp):时间戳是单元的一个属性,表示单元的创建或修改时间。

2.2 与运营数据分析的联系

运营数据分析需要处理大量的数据,包括用户行为数据、商品数据、订单数据等。这些数据需要高效地存储、查询和分析。HBase正是这种场景下的最佳选择,因为它具有以下特点:

- 高性能:HBase支持实时读写操作,可以达到10万次/秒的吞吐量,满足运营数据分析的实时性要求。

- 高可扩展性:HBase支持水平扩展,可以通过添加更多节点来扩展存储容量和查询能力。

- 高可靠性:HBase支持自动故障检测和恢复,可以确保数据的安全性和完整性。

3. 核心算法原理和具体操作步骤

3.1 HBase存储模型

HBase存储模型是基于Google Bigtable的,具有以下特点:

- 列式存储:HBase存储数据的单位是列,而不是行。这样可以有效地存储稀疏数据,节省存储空间。

- 无序存储:HBase不保证数据的有序性,这使得它能够实现高性能的读写操作。

- 分区存储:HBase通过Region和RegionServer实现数据的分区和负载均衡。

3.2 核心算法原理

HBase的核心算法包括:

- Bloom过滤器:HBase使用Bloom过滤器来减少不必要的磁盘查询,提高查询性能。

- MemStore:HBase将新写入的数据暂存到内存中的MemStore,当MemStore满了或者达到一定时间后,将数据刷新到磁盘上的Store文件中。

- Compaction:HBase会定期对Store文件进行压缩和合并操作,以减少磁盘空间占用和提高查询性能。

3.3 具体操作步骤

- 创建HBase表:使用

create命令创建一个新的HBase表,指定表名、列族名和列名。 - 插入数据:使用

put命令将数据插入到HBase表中,指定行键、列键和值。 - 查询数据:使用

get命令查询HBase表中的数据,指定行键和列键。 - 更新数据:使用

increment命令更新HBase表中的数据,指定行键、列键和增量值。 - 删除数据:使用

delete命令删除HBase表中的数据,指定行键和列键。

4. 数学模型公式详细讲解

在HBase中,数据存储和查询的过程涉及到一些数学模型公式。以下是一些常见的公式:

- Bloom过滤器的误判概率:$$ P(false) = (1 - e^{-k * m / n})^k $$

- MemStore的大小:$$ size{MemStore} = \sum{i=1}^{n} size_i $$

- Store文件的大小:$$ size{Store} = \sum{j=1}^{m} size_j $$

- HBase的吞吐量:$$ throughput = \frac{n}{t} $$

5. 具体最佳实践:代码实例和详细解释说明

以下是一个HBase的代码实例,用于插入、查询和更新运营数据:

```java import org.apache.hadoop.hbase.HBaseConfiguration; import org.apache.hadoop.hbase.client.Configurable; import org.apache.hadoop.hbase.client.HBaseAdmin; import org.apache.hadoop.hbase.client.Put; import org.apache.hadoop.hbase.client.Result; import org.apache.hadoop.hbase.client.Scan; import org.apache.hadoop.hbase.client.Table; import org.apache.hadoop.hbase.filter.SingleColumnValueFilter; import org.apache.hadoop.hbase.util.Bytes; import org.apache.hadoop.hbase.client.ResultScanner; import org.apache.hadoop.hbase.client.Row; import org.apache.hadoop.hbase.filter.CompareFilter; import org.apache.hadoop.hbase.filter.FilterList; import org.apache.hadoop.hbase.filter.RowFilter; import org.apache.hadoop.hbase.util.Bytes; import org.apache.hadoop.hbase.client.HTable; import org.apache.hadoop.hbase.client.HColumnDescriptor; import org.apache.hadoop.hbase.client.HTableDescriptor; import org.apache.hadoop.hbase.io.hfile.HFile; import org.apache.hadoop.hbase.util.CompactionUtils;

import java.io.IOException; import java.util.NavigableMap; import java.util.NavigableSet; import java.util.TreeSet;

public class HBaseExample { public static void main(String[] args) throws IOException { // 1. 创建HBase表 Configuration conf = HBaseConfiguration.create(); HBaseAdmin admin = new HBaseAdmin(conf); HTableDescriptor tableDescriptor = new HTableDescriptor(TableName.valueOf("run_data")); HColumnDescriptor columnDescriptor = new HColumnDescriptor("info"); tableDescriptor.addFamily(columnDescriptor); admin.createTable(tableDescriptor);

// 2. 插入数据

HTable table = new HTable(conf, "run_data");

Put put = new Put(Bytes.toBytes("row1"));

put.add(Bytes.toBytes("info"), Bytes.toBytes("age"), Bytes.toBytes("25"));

put.add(Bytes.toBytes("info"), Bytes.toBytes("gender"), Bytes.toBytes("male"));

table.put(put);

// 3. 查询数据

Scan scan = new Scan();

ResultScanner scanner = table.getScanner(scan);

for (Result result : scanner) {

System.out.println(Bytes.toString(result.getRow()) + ": " +

Bytes.toString(result.getValue(Bytes.toBytes("info"), Bytes.toBytes("age"))) +

", " + Bytes.toString(result.getValue(Bytes.toBytes("info"), Bytes.toBytes("gender"))));

}

// 4. 更新数据

put.clear();

put.add(Bytes.toBytes("row1"), Bytes.toBytes("age"), Bytes.toBytes("26"));

table.put(put);

// 5. 删除数据

Delete delete = new Delete(Bytes.toBytes("row1"));

table.delete(delete);

// 6. 关闭表

table.close();

admin.disableTable(TableName.valueOf("run_data"));

admin.deleteTable(TableName.valueOf("run_data"));

}} ```

6. 实际应用场景

HBase非常适用于以下场景:

- 实时数据分析:例如网站访问日志、搜索引擎查询记录等。

- 大数据处理:例如日志分析、用户行为分析、商品推荐等。

- 实时数据存储:例如缓存、消息队列等。

7. 工具和资源推荐

- HBase官方文档:https://hbase.apache.org/book.html

- HBase中文文档:https://hbase.apache.org/2.2.0/cn/index.html

- HBase源码:https://github.com/apache/hbase

- HBase社区:https://groups.google.com/forum/#!forum/hbase-user

8. 总结:未来发展趋势与挑战

HBase是一个非常有前景的技术,它已经在各种行业中得到了广泛应用。未来,HBase将继续发展,提供更高性能、更高可扩展性的数据存储和查询解决方案。

然而,HBase也面临着一些挑战,例如:

- 数据一致性:HBase需要解决分布式环境下的数据一致性问题,以确保数据的准确性和完整性。

- 容错性:HBase需要提高容错性,以便在出现故障时能够快速恢复。

- 易用性:HBase需要提高易用性,以便更多的开发者能够快速上手。

9. 附录:常见问题与解答

以下是一些常见问题及其解答:

-

Q:HBase如何实现高性能?

A: HBase通过以下方式实现高性能:

- 列式存储:有效地存储稀疏数据,节省存储空间。

- 无序存储:实现高性能的读写操作。

- 分区存储:实现数据的分区和负载均衡。

-

Q:HBase如何扩展?

A: HBase支持水平扩展,可以通过添加更多节点来扩展存储容量和查询能力。

-

Q:HBase如何保证数据安全性和完整性?

A: HBase支持自动故障检测和恢复,可以确保数据的安全性和完整性。

-

Q:HBase如何处理大量数据?文章来源:https://www.toymoban.com/news/detail-837147.html

A: HBase支持大量数据的存储和查询,可以通过调整参数和优化查询策略来提高性能。文章来源地址https://www.toymoban.com/news/detail-837147.html

到了这里,关于HBase应用实例:运营数据分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!