1.背景介绍

数据仓库与多源数据集成是数据科学领域的核心技术,它们为数据分析、报表和业务智能提供了基础设施。在本文中,我们将深入探讨数据仓库与多源数据集成的技术和实践,揭示其核心概念、算法原理、最佳实践和实际应用场景。

1. 背景介绍

数据仓库是一个用于存储、管理和分析大量历史数据的系统,它通常用于支持企业决策和竞争力。多源数据集成则是将来自不同来源的数据整合到一个统一的数据仓库中,以实现数据的一致性、可靠性和易用性。

数据仓库与多源数据集成的主要优势包括:

- 提高数据分析效率:通过将数据集成到一个中心化的仓库中,可以减少数据查询和分析的时间和成本。

- 提高数据质量:通过将数据来源进行统一管理和清洗,可以提高数据的准确性和一致性。

- 提高决策能力:通过将来自不同来源的数据整合到一个仓库中,可以为企业提供更全面、准确的决策支持。

2. 核心概念与联系

2.1 数据仓库

数据仓库是一个用于存储、管理和分析大量历史数据的系统,它通常包括以下组件:

- 数据源:来自不同来源的数据,如销售、市场、财务等。

- 数据仓库:一个用于存储和管理数据的数据库系统,如Oracle、SQL Server等。

- 数据仓库管理系统:用于管理数据仓库的软件系统,如Informatica、Microsoft SQL Server Integration Services等。

- 数据仓库应用系统:用于分析和报表的软件系统,如Microstrategy、Cognos等。

2.2 多源数据集成

多源数据集成是将来自不同来源的数据整合到一个统一的数据仓库中的过程,它通常包括以下步骤:

- 数据源识别:识别并确定需要整合的数据源。

- 数据源连接:连接并访问数据源。

- 数据清洗:对来自不同来源的数据进行清洗和转换。

- 数据集成:将清洗后的数据整合到数据仓库中。

- 数据质量管理:对整合后的数据进行质量管理和监控。

2.3 数据仓库与多源数据集成的联系

数据仓库与多源数据集成是紧密相连的,多源数据集成是实现数据仓库的关键技术。多源数据集成可以帮助数据仓库实现数据的一致性、可靠性和易用性,从而提高数据分析和决策的效率和准确性。

3. 核心算法原理和具体操作步骤及数学模型公式详细讲解

3.1 数据清洗算法

数据清洗是将来自不同来源的数据整合到一个统一的数据仓库中的关键步骤,它通常包括以下操作:

- 数据类型转换:将来自不同来源的数据类型转换为统一的数据类型。

- 数据格式转换:将来自不同来源的数据格式转换为统一的数据格式。

- 数据值转换:将来自不同来源的数据值转换为统一的数据值。

- 数据去重:将来自不同来源的重复数据去重。

- 数据补全:将来自不同来源的缺失数据补全。

3.2 数据集成算法

数据集成是将清洗后的数据整合到数据仓库中的关键步骤,它通常包括以下操作:

- 数据导入:将清洗后的数据导入到数据仓库中。

- 数据映射:将来自不同来源的数据映射到数据仓库中的目标表。

- 数据合并:将来自不同来源的数据合并到一个统一的表中。

- 数据索引:为数据仓库中的数据创建索引,以提高查询和分析的效率。

- 数据压缩:为数据仓库中的数据创建压缩,以节省存储空间。

3.3 数据质量管理算法

数据质量管理是确保数据仓库中的数据质量的关键步骤,它通常包括以下操作:

- 数据质量检查:对数据仓库中的数据进行质量检查,以确保数据的准确性、一致性和完整性。

- 数据质量报告:生成数据质量报告,以帮助数据仓库管理员了解数据质量的问题和解决方案。

- 数据质量改进:根据数据质量报告的结果,采取措施改进数据质量。

4. 具体最佳实践:代码实例和详细解释说明

4.1 数据清洗实例

假设我们有以下两个数据源:

- 销售数据:包括订单号、客户号、商品号、商品名称、商品价格、数量等字段。

- 客户数据:包括客户号、客户名称、客户地址、客户电话等字段。

我们需要将这两个数据源整合到一个数据仓库中,并进行数据清洗。

sql -- 数据类型转换 SELECT CAST(订单号 AS INT), CAST(客户号 AS INT), CAST(商品号 AS INT), CAST(商品价格 AS DECIMAL(10,2)), CAST(数量 AS INT), 客户名称, 客户地址, 客户电话 FROM 销售数据, 客户数据 WHERE 销售数据.客户号 = 客户数据.客户号

4.2 数据集成实例

假设我们已经将销售数据和客户数据进行了数据清洗,并将其导入到数据仓库中。现在我们需要将这两个表合并到一个统一的表中。

sql -- 数据合并 CREATE TABLE 销售数据集成 AS SELECT 订单号, 客户号, 商品号, 商品名称, 商品价格, 数量, 客户名称, 客户地址, 客户电话 FROM 销售数据 UNION ALL SELECT 订单号, 客户号, 商品号, 商品名称, 商品价格, 数量, 客户名称, 客户地址, 客户电话 FROM 客户数据

4.3 数据质量管理实例

假设我们已经将销售数据和客户数据整合到一个数据仓库中,现在我们需要对数据进行质量检查。

sql -- 数据质量检查 SELECT 订单号, 客户号, 商品号, 商品名称, 商品价格, 数量, 客户名称, 客户地址, 客户电话 FROM 销售数据集成 WHERE 商品价格 < 0 OR 数量 < 0

5. 实际应用场景

数据仓库与多源数据集成的实际应用场景包括:

- 企业决策支持:通过将来自不同来源的数据整合到一个数据仓库中,企业可以为决策提供更全面、准确的支持。

- 业务分析:通过对数据仓库中的数据进行分析,企业可以了解业务的发展趋势、竞争对手、市场需求等。

- 竞争分析:通过将来自不同来源的数据整合到一个数据仓库中,企业可以对竞争对手进行深入分析,了解其竞争优势和劣势。

- 风险管理:通过对数据仓库中的数据进行分析,企业可以预测和管理风险,提高企业的稳定性和可持续性。

6. 工具和资源推荐

6.1 数据清洗工具

- Talend Open Studio:一个开源的数据整合和数据清洗工具,支持多种数据源和目标。

- Microsoft SQL Server Integration Services:一个商业的数据整合和数据清洗工具,支持多种数据源和目标。

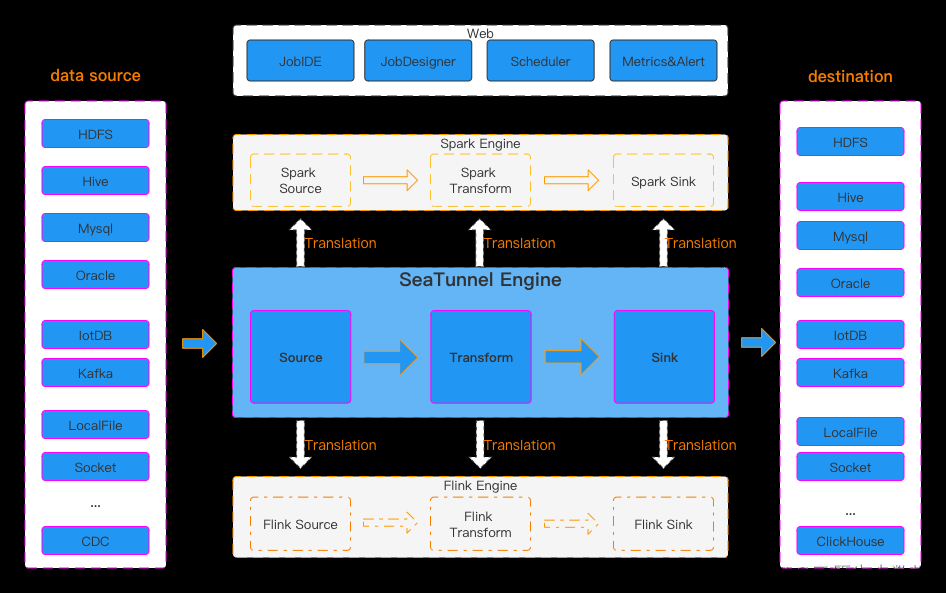

6.2 数据集成工具

- Informatica:一个商业的数据集成工具,支持多种数据源和目标。

- Talend Open Studio:一个开源的数据集成工具,支持多种数据源和目标。

6.3 数据仓库应用工具

- Microstrategy:一个商业的数据仓库应用工具,支持多种数据源和目标。

- Cognos:一个商业的数据仓库应用工具,支持多种数据源和目标。

7. 总结:未来发展趋势与挑战

数据仓库与多源数据集成是数据科学领域的核心技术,它们为数据分析、报表和业务智能提供了基础设施。在未来,数据仓库与多源数据集成将面临以下挑战:

- 数据量的增长:随着数据的生成和存储成本的降低,数据量将不断增长,这将对数据仓库与多源数据集成的性能和可靠性产生挑战。

- 数据来源的多样性:随着企业业务的扩张和合并,数据来源将变得更加多样化,这将对数据仓库与多源数据集成的复杂性和难度产生挑战。

- 数据质量的提高:随着数据的生成和存储成本的降低,数据质量将成为关键问题,这将对数据仓库与多源数据集成的准确性和可靠性产生挑战。

为了应对这些挑战,数据仓库与多源数据集成将需要进行以下发展:

- 技术创新:通过技术创新,如大数据处理、机器学习等,提高数据仓库与多源数据集成的性能和可靠性。

- 标准化:通过标准化,提高数据仓库与多源数据集成的可移植性和可维护性。

- 集成:通过集成,提高数据仓库与多源数据集成的一致性和易用性。

8. 附录:常见问题与解答

8.1 问题1:数据清洗和数据集成是什么?

答案:数据清洗是将来自不同来源的数据整合到一个统一的数据仓库中的过程,它通常包括以下步骤:数据类型转换、数据格式转换、数据值转换、数据去重、数据补全等。数据集成是将清洗后的数据整合到数据仓库中的过程,它通常包括以下步骤:数据导入、数据映射、数据合并、数据索引、数据压缩等。

8.2 问题2:数据仓库与多源数据集成有什么优势?

答案:数据仓库与多源数据集成的主要优势包括:提高数据分析效率、提高数据质量、提高决策能力等。

8.3 问题3:数据仓库与多源数据集成有什么挑战?

答案:数据仓库与多源数据集成面临的挑战包括:数据量的增长、数据来源的多样性、数据质量的提高等。文章来源:https://www.toymoban.com/news/detail-837584.html

8.4 问题4:数据仓库与多源数据集成的未来发展趋势是什么?

答案:数据仓库与多源数据集成的未来发展趋势包括:技术创新、标准化、集成等。文章来源地址https://www.toymoban.com/news/detail-837584.html

到了这里,关于数据仓库与多源数据集成的技术与实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!