虽然 Ollama 提供了运行和交互式使用大型语言模型(LLM)的功能,但从头开始创建完全定制化的 LLM 需要 Ollama 之外的其他工具和专业知识。然而,Ollama 可以通过微调在定制过程中发挥作用。以下是细分说明:

-

预训练模型选择:

Ollama 提供了一个预训练的开源 LLM 库,例如 Llama 2。这些模型已经针对海量数据集进行了训练,可以用于各种任务。 -

使用 Ollama 微调:

Ollama 允许您在您自己的特定数据上微调这些预训练模型。这包括在您的数据上训练模型,以提高其在与您的领域或用例相关的任务上的性能。 -

Ollama 的作用:

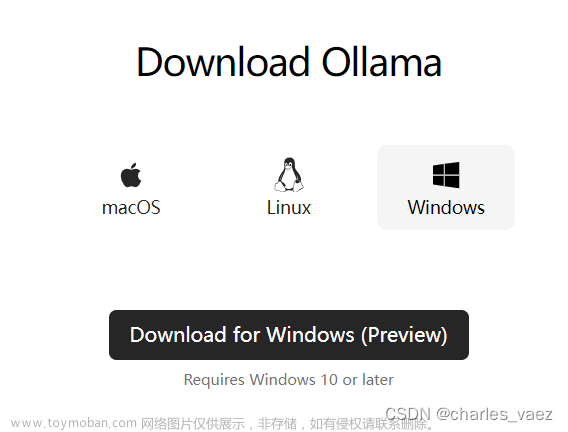

Ollama 通过以下方式简化微调过程:- 下载预训练模型。

- 将模型转换为兼容格式。

- 提供命令行界面,可在您的数据上运行微调过程。

- 集成微调后的模型以进行交互。

-

额外的工具和专业知识:

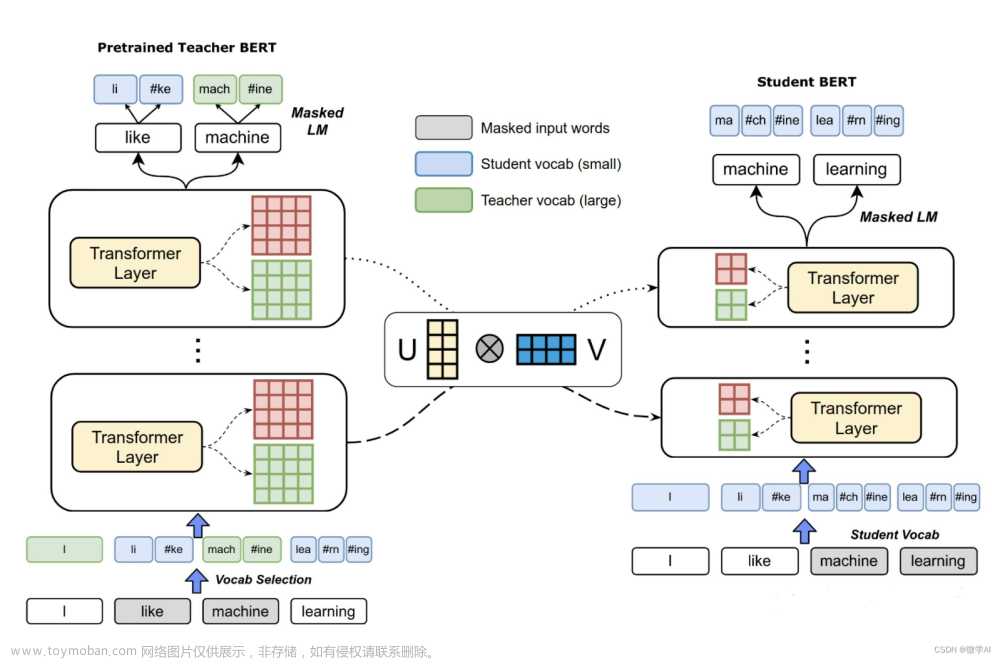

从头开始创建完全定制化的 LLM 涉及以下步骤:文章来源:https://www.toymoban.com/news/detail-838116.html- 收集与您的特定领域相关的海量数据集。

- 选择合适的 LLM 架构并从头开始使用您的数据训练它,这需要机器学习和深度学习方面的专业知识。

- TensorFlow 或 PyTorch 等工具常用于此目的。

-

资源:

虽然 Ollama 无法从头开始构建自定义 LLM,但它可以成为微调预训练模型的宝贵工具。探索 Ollama 的文档和在线教程以获取具体说明:https://ollama.com/

如果您对完整的创建过程感兴趣,可以考虑搜索有关使用 TensorFlow 或 PyTorch 等工具构建自定义 LLM 的资源。文章来源地址https://www.toymoban.com/news/detail-838116.html

到了这里,关于AIGC 实战:如何使用 Ollama 开发自定义的大模型(LLM)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!