【机器学习】进阶学习:详细解析Sklearn中的MinMaxScaler—原理、应用、源码与注意事项

这篇文章的质量分达到了97分,虽然满分是100分,但已经相当接近完美了。请您耐心阅读,我相信您一定能从中获得不少宝贵的收获和启发~

🌈 个人主页:高斯小哥

🔥 高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程👈 希望得到您的订阅和支持~

💡 创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Python领域的优质内容!(希望得到您的关注~)

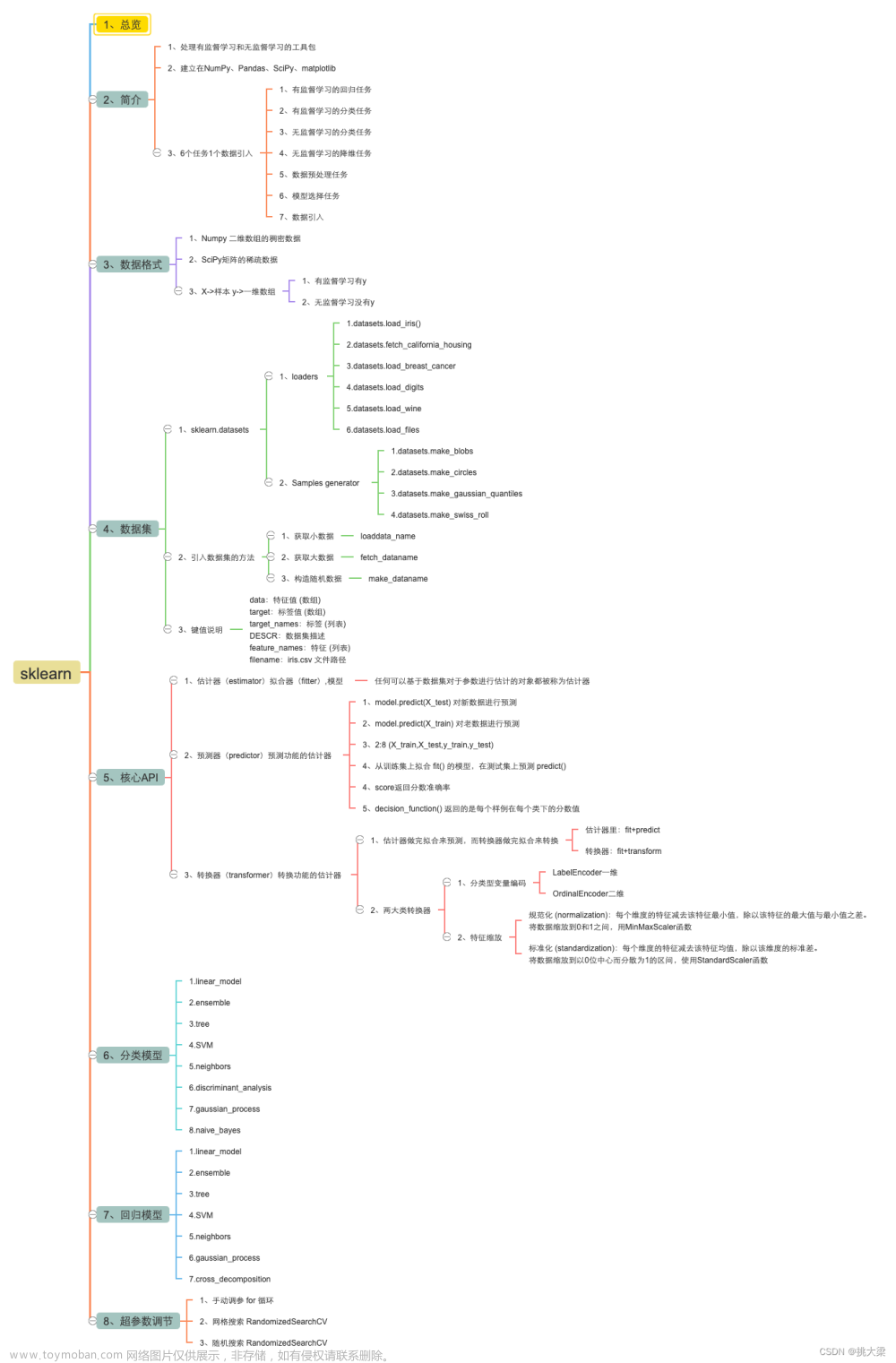

🧠 一、MinMaxScaler简介

MinMaxScaler是Scikit-learn库中的一个重要工具,主要用于数据的归一化处理。归一化是将数据按比例缩放,使之落入一个小的特定区间,如[0,1]或[-1,1]。MinMaxScaler通过计算特征列的最小值和最大值来实现归一化,它对于稳定模型的训练过程和提高模型的性能非常重要。

归一化的主要好处包括但不限于:

- 提高模型的收敛速度,因为特征都在相近的尺度上。

- 提高模型的精度,因为一些算法在特征尺度相近时表现更好。

- 使得不同单位的特征之间可以进行比较和加权。

🔧 二、MinMaxScaler原理与应用

MinMaxScaler的原理很简单,它使用下面的公式进行归一化:

X_std = (X - X.min(axis=0)) / (X.max(axis=0) - X.min(axis=0))

X_scaled = X_std * (max - min) + min

其中,X 是原始数据,min 和 max 是你想要缩放到的范围,通常是[0, 1]。

在应用归一化后,有时候我们需要将数据从归一化的范围转换回原始的范围,这个过程称为反归一化。使用MinMaxScaler进行反归一化的过程相对简单,只需按照下面的公式进行:

X_original = X_scaled * (max_original - min_original) + min_original

这里,max_original 和 min_original 是原始数据的最小值和最大值。

在Sklearn中,使用MinMaxScaler进行归一化和反归一化的示例如下:

from sklearn.preprocessing import MinMaxScaler

import numpy as np

# 示例数据

data = np.array([[1, 2], [3, 4], [5, 6]])

# 创建MinMaxScaler对象

scaler = MinMaxScaler(feature_range=(0, 1))

# 使用fit_transform方法拟合数据并进行转换

scaled_data = scaler.fit_transform(data)

print("Original data:\n", data)

print("Scaled data:\n", scaled_data)

# 使用inverse_transform方法将缩放后的数据转换回原始尺度

original_data = scaler.inverse_transform(scaled_data)

print("Data after inverse transformation:\n", original_data)

代码输出:

Original data:

[[1 2]

[3 4]

[5 6]]

Scaled data:

[[0. 0. ]

[0.5 0.5]

[1. 1. ]]

Data after inverse transformation:

[[1. 2.]

[3. 4.]

[5. 6.]]

在这个示例中,MinMaxScaler首先使用fit_transform方法拟合数据并计算每个特征(即每列分别计算)的最小值和最大值,然后将数据缩放到指定的范围(在这个例子中是[0, 1])。之后,使用inverse_transform方法可以将缩放后的数据还原到原始尺度。

MinMaxScaler的应用非常广泛,特别是在需要对数据进行归一化处理以消除量纲影响的机器学习算法中。通过将数据缩放到相同的范围,MinMaxScaler可以帮助算法更好地学习和优化。然而,需要注意的是,MinMaxScaler对异常值非常敏感,因为异常值会影响最小值和最大值的计算,从而影响缩放效果。在处理包含异常值的数据时,可能需要考虑使用其他的归一化方法,如RobustScaler或StandardScaler。

🔍 三、MinMaxScaler源码的简单复现与解析

MinMaxScaler的源码包含了fit、fit_transform以及inverse_transform等关键方法:

- fit方法用于计算训练数据的最小值和最大值

- fit_transform方法则用于根据这些最小值和最大值来缩放数据

- inverse_transform方法则用于将缩放后的数据转换回原始尺度。

以下是MinMaxScaler源码的一个简化版本,包括这些主要方法:

import numpy as np

class MinMaxScaler:

def __init__(self, feature_range=(0, 1)):

self.feature_range = feature_range

self.min_ = None

self.data_min_ = None

self.data_max_ = None

def fit(self, X):

"""计算训练集的最小值和最大值"""

self.data_min_ = np.min(X, axis=0)

self.data_max_ = np.max(X, axis=0)

self.min_ = np.min(self.data_min_)

return self

def fit_transform(self, X):

"""根据拟合的最小值和缩放比例转换数据"""

if self.min_ is None:

raise ValueError("This MinMaxScaler instance is not fitted yet. Call 'fit' with some data first.")

X_std = (X - self.data_min_) / (self.data_max_ - self.data_min_)

X_scaled = X_std * (self.feature_range[1] - self.feature_range[0]) + self.feature_range[0]

return X_scaled

def inverse_transform(self, X):

"""将缩放后的数据转换回原始尺度"""

if self.min_ is None:

raise ValueError("This MinMaxScaler instance is not fitted yet. Call 'fit' with some data first.")

X_std = (X - self.feature_range[0]) / (self.feature_range[1] - self.feature_range[0])

X_original = X_std * (self.data_max_ - self.data_min_) + self.data_min_

return X_original

# 假设我们有一些原始数据

original_data = np.array([[1, 2], [3, 4], [5, 6]])

# 创建一个MinMaxScaler对象

scaler = MinMaxScaler()

# 使用fit_transform方法对数据进行归一化

scaler.fit(original_data)

normalized_data = scaler.fit_transform(original_data)

print("Normalized data:")

print(normalized_data)

# 使用inverse_transform方法进行反归一化

original_data_reconstructed = scaler.inverse_transform(normalized_data)

print("Reconstructed original data:")

print(original_data_reconstructed)

代码输出:

Normalized data:

[[0. 0. ]

[0.5 0.5]

[1. 1. ]]

Reconstructed original data:

[[1. 2.]

[3. 4.]

[5. 6.]]

在上面的代码中,fit方法计算了训练数据集X中每个特征的最小值和最大值。fit_transform方法则利用这些参数将输入数据X转换为指定范围feature_range内的值。inverse_transform方法则执行相反的操作,将缩放后的数据转换回原始尺度。

需要注意的是,这个简化版本假设输入数据X至少包含一个特征(尚未对空值进行异常处理),并且所有特征的最小值和最大值都不相同(避免出现除0情况)。在实际应用中,Scikit-learn的MinMaxScaler实现会包含更多的错误检查和边界情况处理。

通过解析源码,我们可以更好地理解MinMaxScaler的工作原理,并在必要时自定义或扩展其功能。然而,在实际应用中,通常推荐使用Scikit-learn库中经过优化和测试的完整实现。

💡 四、注意事项

在使用MinMaxScaler时,需要注意以下几点:

-

数据的分布:MinMaxScaler对数据的分布没有假设,但如果数据集中存在异常值,它们会对最小值和最大值的计算产生很大影响,进而影响到归一化的效果。

-

新数据的处理:当使用fit方法计算了训练数据的最小值和最大值后,如果有新的数据需要归一化,应使用相同的最小值和最大值。如果直接使用新数据再次调用fit方法,会导致归一化结果的不一致。

-

特征重要性:归一化可能会改变特征之间的相对重要性。因为MinMaxScaler仅仅是将数据缩放到指定的范围,而不考虑特征的分布或其他属性,所以它不会保留任何关于原始特征重要性的信息。在需要特征重要性的场景中,可能需要结合其他方法,如使用特征选择算法或考虑特征的统计属性。

-

数据泄露问题:在机器学习的实践中,尤其是在构建预测模型时,需要特别注意避免数据泄露。如果在训练过程中,测试集或验证集的数据被用于MinMaxScaler的fit方法,那么模型可能会因为“看到”了测试集的信息而表现出过高的性能,这会导致对模型泛化能力的错误估计。因此,应该始终确保只使用训练集数据来fit MinMaxScaler。

-

数据类型和缺失值:MinMaxScaler默认处理数值型数据。如果数据集中包含非数值型特征或缺失值,需要预先进行处理。例如,可以将非数值型特征进行编码,或者用适当的方法填充或删除含有缺失值的样本。

-

保留原始数据:在进行归一化或其他预处理操作后,建议保留原始数据。这是因为某些情况下,可能需要重新访问或分析原始数据,或者将归一化后的数据与其他未归一化的数据合并。

-

与深度学习框架的集成:当使用深度学习框架(如TensorFlow或PyTorch)时,可能需要自定义归一化层或操作,以便在模型训练过程中直接应用归一化。虽然Scikit-learn的MinMaxScaler可以与这些框架一起使用,但了解如何在框架内部实现归一化也是很重要的。

总之,MinMaxScaler是一个简单而有效的工具,但在使用时需要注意上述事项,以确保归一化过程不会对模型性能产生负面影响,并能够充分利用归一化带来的好处。

🔄 五、MinMaxScaler与StandardScaler的比较

MinMaxScaler和StandardScaler都是Scikit-learn中常用的特征缩放方法,但它们的工作原理和适用场景有所不同:

-

MinMaxScaler通过线性变换将特征值缩放到给定的范围(通常是[0, 1]),它直接依赖于数据的最大值和最小值。这种方法对于有界特征或需要保持特征之间相对大小关系的场景特别有用。然而,由于MinMaxScaler对异常值敏感,因此如果数据集中包含极端值,可能会导致缩放后的数据不稳定或失去有意义的结构。

-

StandardScaler使用均值和标准差来缩放特征,使其具有零均值和单位方差。这种方法更适合于那些假设特征服从正态分布或近似正态分布的场景。StandardScaler对异常值的鲁棒性更好,因为它基于整个数据集的统计属性进行缩放,而不是仅仅依赖于最大值和最小值。

在选择使用MinMaxScaler还是StandardScaler时,需要考虑数据的特性、模型的假设以及具体的应用场景。例如,在处理像素值或百分比等具有明确边界的数据时,MinMaxScaler可能更合适;而在处理连续型特征且假设它们服从正态分布时,StandardScaler可能更合适。

此外,值得注意的是,除了MinMaxScaler和StandardScaler之外,还有其他一些特征缩放方法可供选择,如MaxAbsScaler、RobustScaler等。每种方法都有其特定的应用场景和优缺点,因此在实际应用中需要根据具体情况进行选择。

📚 六、总结

本文详细解析了Scikit-learn中的MinMaxScaler的原理、应用、源码和注意事项。通过深入了解其工作原理和适用场景,我们可以更好地利用这一工具来优化机器学习模型的性能。同时,我们也讨论了MinMaxScaler与StandardScaler之间的比较,以便在实际应用中根据数据特性和模型需求做出合适的选择。

在使用MinMaxScaler时,需要注意数据的分布、新数据的处理、特征重要性、数据泄露问题以及数据类型和缺失值等方面。此外,与深度学习框架的集成也是一个值得考虑的问题。文章来源:https://www.toymoban.com/news/detail-838953.html

总之,MinMaxScaler是一个强大而灵活的工具,通过合理使用它,我们可以提高机器学习模型的稳定性和性能。希望本文能够帮助你更好地理解和应用MinMaxScaler,并在实际项目中取得更好的效果。🚀文章来源地址https://www.toymoban.com/news/detail-838953.html

到了这里,关于【机器学习】进阶学习:详细解析Sklearn中的MinMaxScaler---原理、应用、源码与注意事项的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!