论文地址: https://www.semanticscholar.org/paper/A2FSeg%3A-Adaptive-Multi-modal-Fusion-Network-for-Wang-Hong/330f94e291a9b881ad14ca500f8d96e185d43b15

代码仓库: https://github.com/Zirui0623/A2FSeg/tree/main?tab=readme-ov-file

摘要:

磁共振成像(MRI)在多模式脑肿瘤分割中发挥着重要作用。然而,缺失模态在临床诊断中非常常见,这将导致分割性能严重下降。在本文中,我们提出了一种用于脑肿瘤分割的简单自适应多模态融合网络,该网络具有两个阶段的特征融合,包括简单的平均融合和基于注意机制的自适应融合。 两种融合技术都能够处理缺失模态的情况,并有助于改善分割结果,尤其是自适应分割结果。我们在 BraTS2020 数据集上评估我们的方法,与四种最新方法相比,在不完整的多模态脑肿瘤分割方面实现了最先进的性能。我们的 A2FSeg(平均和自适应融合分割网络)简单而有效,能够处理任意数量的图像模态以实现不完整的多模态分割。

引言:

从医学图像扫描中提取脑肿瘤在进一步分析和临床诊断中发挥着重要作用。通常,脑肿瘤包括瘤周水肿、增强肿瘤和非增强肿瘤核心。由于不同的模态呈现出脑肿瘤成分的不同清晰度,因此在脑肿瘤分割任务中我们经常使用多模态图像扫描,例如T1、T1c、T2和Flair。已经开展了使用从所有四种模式收集的图像扫描来处理脑肿瘤分割的工作。然而,在实践中,我们面临着同时收集所有模式的挑战,往往会丢失一种或多种模式。因此,在本文中,我们考虑了在缺失图像模式的情况下分割脑肿瘤的问题。

当前处理缺失模态的图像分割方法可分为三类,包括:(1)暴力方法:为每种可能的模态组合设计单独的分割网络(2)补全方法:合成缺失的模态以补全用于传统图像分割的全部模态,以及(3)基于融合的方法:将不同模态的图像映射到相同的特征空间进行融合,然后根据融合的特征分割脑肿瘤 第一类方法具有良好的分割性能;然而,它们是资源密集型的,并且通常需要更多的培训时间。第二类方法的性能受到缺失模态的合成质量的限制。第三类通常只有一个网络来处理缺失模态的不同场景,这是实践中最常用的一种。

为了处理各种数量的模态输入,HeMIS通过计算从不同模态提取的特征图作为融合特征的均值和方差,将不同模态的图像特征投影到相同的特征空间中。为了提高特征融合的表示,HVED 将每种模态的输入视为高斯分布,并通过高斯混合模型融合来自不同模态的特征图。另一方面,RobustSeg将模态特征分解为模态不变的内容代码和模态特定的外观代码,以实现更准确的融合和分割。考虑到不同模态下观察到的脑肿瘤区域的清晰度不同,RFNet引入了一种注意力机制来自适应地建模模态和肿瘤区域的关系。基于图结构和注意力机制,MFI被提出来学习不同缺失情况下模态之间的自适应互补信息。

由于当前模型的复杂性,我们倾向于开发一个简单的模型,采用简单的平均融合和注意力机制。这两种技术被证明在处理缺失模态和多模态融合方面是有效的。受 MAML的启发,我们提出了一种名为 A2FSeg(平均和自适应融合分割网络,见图 1)的模型,该模型有两个融合步骤,即平均融合和基于注意力的自适应融合,以集成来自不同模态用于分割的特征。尽管我们的融合想法非常简单,但 A2FSeg 在 BraTS2020 数据集上的不完整多模态脑肿瘤图像分割任务中实现了最先进的 (SOTA) 性能。我们在本文中的贡献总结如下:

- 我们提出了一种简单的多模态融合网络 A2FSeg,用于脑肿瘤分割,它是通用的,可以扩展到任意数量的不完整模态图像分割。

- 我们在 BraTS 2020 数据集上进行实验,实现了 SOTA 分割性能,整个肿瘤的平均 Dice 核心为 89.79%,肿瘤核心为 82.72%,增强肿瘤为 66.71%。

方法

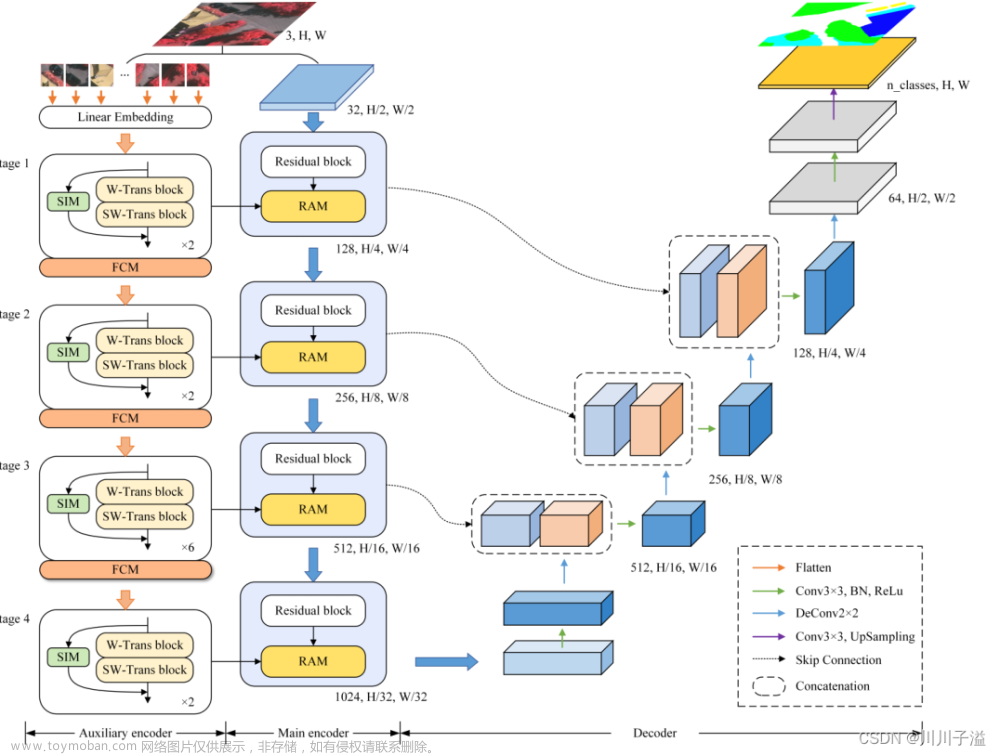

Fig 1:我们提出的自适应多模态融合网络(A2FSeg,平均和自适应融合分割网络的缩写)的概述。虚线表示缺失某些模态的可能性。如果是这样,平均融合模块和自适应融合模块都会忽略缺失的。最终的肿瘤掩码是根据自适应融合后的特征图来预测的,如红色实线箭头所示。 (彩色效果最佳)(在线彩色图)

图 1 展示了我们的 A2FSeg 的网络架构。它由四个用于特定模态特征提取的子网络,一个平均融合模块:用于在第一阶段简单地融合来自可用模态的特征,以及一个基于注意力机制的自适应融合模块,用于在第二阶段再次自适应地融合这些特征。

模态特定特征提取模块

在融合之前,我们首先使用 nnUNet 模型为每种单一模态提取特征,如图 1 所示。特别的,MSFE模型从特定模态 m m m(即 I m ∈ R H × W × D \mathbf{I}_{m}\in\mathbb{R}^{H\times W\times D} Im∈RH×W×D和 m ∈ { T 1 , T 2 , T 1 c, Flair } m\in\{\text{T}1,\text{ T}2,\text{T}1\text{c, Flair}\} m∈{T1, T2,T1c, Flair})进行3D图像扫描,并输出相应的图像特征 F m ∈ R C × H f × W f × D f \mathbf{F}_{m}\in\mathbb{R}^{C\times H_{f}\times W_{f}\times D_{f}} Fm∈RC×Hf×Wf×Df,这里,通道数C=32; Hf 、Wf 和Df 是特征图Fm 的高度、宽度和深度,它们与输入图像具有相同的尺寸。对于每种单一模态,每个 MSFE 模块都受到图像分割掩模的监督,以加快其收敛速度,并为以后的融合提供良好的特征提取。所有四个 MSFE 都具有相同的架构,但权重不同。

平均融合模块

为了聚合来自不同模态的图像特征并处理丢失一个或多个模态的可能性,我们使用来自不同模态的可用特征的平均值作为第一个融合结果。即,我们得到一个融合平均特征 F ˉ = 1 N m ∑ m = 1 N m F m \bar{\mathbf{F}}=\frac1{N_m}\sum_{m=1}^{N_m}\mathbf{F}_m Fˉ=Nm1∑m=1NmFm,这里 N m {N_m} Nm是可用模态的数目,例如,如图1所示,如果一次迭代中只有前两种模态可用,则 N m = 2 {N_m} = 2 Nm=2,我们将取这两种模态的平均值,忽略那些缺失的模态。

自适应融合模块

由于每种模态对最终肿瘤分割的贡献不同,与 MAML类似,我们采用注意力机制来衡量每种模态对最终分割的体素水平贡献。如图 1 所示,为了生成特定模态 m m m的注意力图,我们将 MSFE 模块 F m F_m Fm 提取的特征与平均融合后的平均特征 F ˉ \bar{F} Fˉ 串联起来,并通过卷积层生成初始注意力权重: W m = σ ( F m ( [ F ˉ ; F m ] ; θ m ) ) , m ∈ { T 1 , T 1 c , T 2 , F l a i r } . ( 1 ) \mathbf{W}_{m}=\sigma\left(\mathcal{F}_{m}\left(\left[\bar{\mathbf{F}};\mathbf{F}_{m}\right];\theta_{m}\right)\right),\quad m\in\{\mathrm{T}1,\mathrm{~T}1\mathrm{c},\mathrm{~T}2,\mathrm{~Flair}\}.\quad(1) Wm=σ(Fm([Fˉ;Fm];θm)),m∈{T1, T1c, T2, Flair}.(1)这里, F m \mathcal{F}_{m} Fm是该特定模态 m m m的卷积层, θ m θ_m θm表示该层的参数, σ σ σ是Sigmoid函数。也就是说,我们为每种模态都有一个单独的卷积层 F m \mathcal{F}_{m} Fm 来生成不同的权重。由于可能缺少模态,我们将有不同数量的特征图进行融合。为了解决这个问题,我们使用 Softmax 函数对不同的注意力权重进行标准化: W ^ m = exp ( W m ) ∑ m N m exp ( W m ) . ( 2 ) \hat{\mathbf{W}}_m=\frac{\exp\left(\mathbf{W}_m\right)}{\sum_m^{N_m}\exp\left(\mathbf{W}_m\right)}.\quad(2) W^m=∑mNmexp(Wm)exp(Wm).(2)也就是说,我们只考虑这些可用模态的特征图,但将它们对最终融合结果的贡献标准化,这样,无论缺少多少模态,融合后的特征图都具有一致的值范围。然后,我们将注意力权重与相应的模态特征图进行体素相乘。因此,自适应融合的特征图 F ^ \hat{F} F^ 是通过每个模态特征的加权和来计算的: F ^ = ∑ m W ^ m ⊗ F m . ( 3 ) \hat{\mathbf{F}}=\sum_m\hat{\mathbf{W}}_m\otimes\mathbf{F}_m.\quad(3) F^=m∑W^m⊗Fm.(3)这里,⊗表示体素相乘。

损失函数

我们有多个分割头,分布在A2FSeg的每个模块中。对于每个分割头,我们使用交叉熵和软Dice分数的组合作为基本损失函数,其定义为 L ( y ^ , y ) = L C E ( y ^ , y ) + L D i c e ( y ^ , y ) , ( 4 ) \mathcal{L}(\hat{y},y)=\mathcal{L}_{CE}(\hat{y},y)+\mathcal{L}_{Dice}(\hat{y},y),\quad(4) L(y^,y)=LCE(y^,y)+LDice(y^,y),(4)其中 y ^ \hat{y} y^和 y y y 分别表示分割预测和真实分割结果。基于这个基本函数,我们将整体损失函数定义为 L t o t a l = ∑ m L m ( y ^ m , y ) + L a v g ( y ^ a v g , y ) + L a d p ( y ^ a d p , y ) , ( 5 ) \mathcal{L}_{total}=\sum_m\mathcal{L}_m(\hat{y}_m,y)+\mathcal{L}_{avg}(\hat{y}_{avg},y)+\mathcal{L}_{adp}(\hat{y}_{adp},y),\quad(5) Ltotal=m∑Lm(y^m,y)+Lavg(y^avg,y)+Ladp(y^adp,y),(5)其中第一项是特征提取后每个模态 m m m 的基本分割损失;第二项是平均融合模块的分割输出的损失;最后一项是自适应融合模块最终输出的分割损失。文章来源:https://www.toymoban.com/news/detail-839132.html

实验

数据集:BraTS 2020

实验设置和实施细节:

Pytorch实现、使用RTX3090GPU进行实验、使用Adam优化器、learning rate = 0.01、使用学习率指数衰减方法:

(

1

−

#

epoch

#

m

a

x

e

p

o

c

h

)

0.9

(1-\frac{\#\text{epoch}}{ \# \mathrm{max}\quad\mathrm{epoch}})^{0.9}

(1−#maxepoch#epoch)0.9、patch = 128 x 128 x 128、训练300轮

Table 1:与最近的方法进行比较(包括HeMIS、U-HVED、mmFormer、MFI),与我们的模型在BraTS 2020上就Dice%方面进行比较,缺失模态用o表示,可用模态用●表示,F表示Flair,HVED表示U-HVED,mmFormer表示为Former文章来源地址https://www.toymoban.com/news/detail-839132.html

到了这里,关于论文阅读笔记——A2FSeg:用于医学图像分割自适应多模态融合网络的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[CVPR2022] 用于 3D 医学图像分析的 Swin Transformers 的自监督预训练](https://imgs.yssmx.com/Uploads/2024/02/607339-1.png)