1. Hadoop 生态圈组件介绍

Hadoop 生态系统包含多个组件,每个组件都有不同的功能。以下是一些核心组件的介绍:

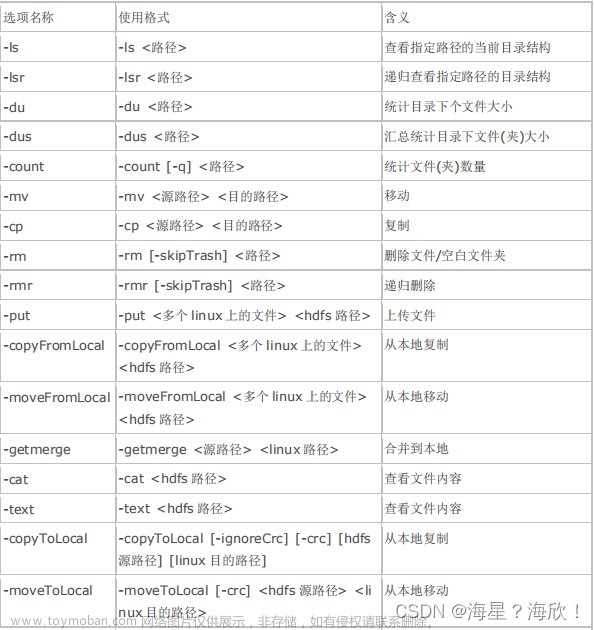

- HDFS(Hadoop Distributed File System):用于存储大规模数据的分布式文件系统。它将数据分成块并在集群中的多个节点上进行存储。

- MapReduce:分布式计算框架,用于处理大规模数据集。它将任务分为 Map 阶段和 Reduce 阶段,适合离线数据处理。

- YARN(Yet Another Resource Negotiator):资源管理器,负责集群资源的分配和调度。

- Hive:基于 Hadoop 的数据仓库工具,用于查询和分析大规模数据。

- Pig:高级脚本语言,用于数据分析和转换。

- HBase:分布式 NoSQL 数据库,适用于实时读写大量数据。

- Spark:快速、通用、内存计算的大数据处理框架。

-

2. MapReduce 概述

- MapReduce 是一种编程模型,用于处理大规模数据集。

- 它将任务分为两个阶段:Map 阶段和 Reduce 阶段。

- Map 阶段将输入数据拆分成键值对,然后应用用户定义的函数进行处理。

- Reduce 阶段将 Map 阶段的输出进行合并和汇总。

- MapReduce 适用于离线数据处理,但不适合实时数据处理。

3. Spark 技术特点和概述

- Spark 是一个通用的大数据处理框架,具有以下特点:

- 快速:spark的运行速度比较快

- 易用:spark支持使用scala、python、java、R等语言快速编写应用。此外,spark提供超过80个告诫算子,使得编写变得容易。

- 通用:spark可以与sql语句、实时计算及其他复杂的分析计算进行良好的结合。

- 随处运行:spark作为一个分布式计算框架,本身没有存储功能,但是可以从HDFS、cassandraHBase、Hive、Alluxio等数据源中读取数据。

- 代码简洁:支持scala、python、等语言编写,scala和python的代码比java的代码比较简洁。

4. MapReduce 和 Spark 的区别

- 速度:spark在内存中的运行速度比hadoop mapreduce运行速度的100多倍,在磁盘中则是10多倍。

- 数据处理范式:MapReduce 适用于批处理,Spark 更适合实时数据处理和迭代分析。

- 易用性:Spark 提供更友好的编程接口。

- 容错性:Spark 的 RDD 比 Hadoop MapReduce 的 HDFS 更容错。

5. 结构化数据与非结构化数据

- 结构化数据:具有明确定义的模式和格式,如关系数据库中的表格数据。

- 非结构化数据:不符合预定义模式的数据,如文本、图像、音频和视频。

6.Linux简单操作命令实训练习

pwd命令

ls命令

cd命令

mkdir命令

rm命令

cp命令

mv命令

cat命令

tar命令

useradd命令

passwd命令

chown命令

chmod命令

su命令

文章来源:https://www.toymoban.com/news/detail-842019.html

文章来源:https://www.toymoban.com/news/detail-842019.html

文章来源地址https://www.toymoban.com/news/detail-842019.html

到了这里,关于超级暴龙战士的核心竟是——————Hadoop生态圈和spark技术特点的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!