目录

1. 前置层归一化(Pre-normalization)

2. RMSNorm 归一化函数

3. SwiGLU 激活函数

4. 旋转位置嵌入(RoPE)

5. 注意力机制优化

6. Group Query Attention

7. 模型规模和训练超参数

8. 分布式模型训练

前置归一化与后置归一化的区别

前置归一化(Pre-normalization)

后置归一化(Post-normalization)

结论

1. 前置层归一化(Pre-normalization)

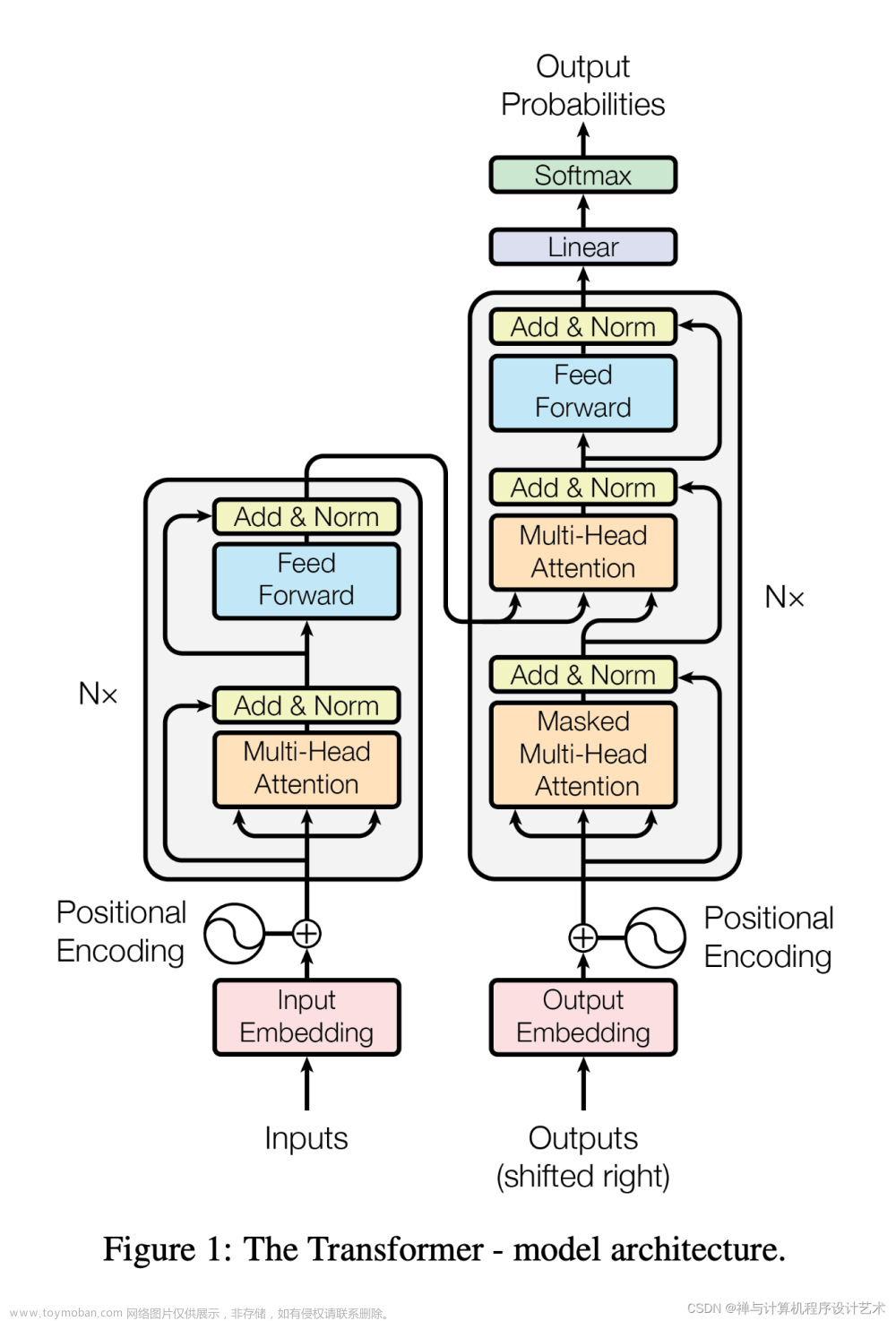

LLaMA模型采用了前置层归一化策略,这意味着在每个子层(自注意力层和前馈网络)的输入之前进行层归一化。这与传统的Transformer中的后置层归一化不同,后者在子层输出之后进行归一化。

2. RMSNorm 归一化函数

LLaMA模型使用RMSNorm作为其归一化函数,这是一种替代传统层归一化的方法,它在保持计算效率的同时,专注于规范化权重矩阵的行,以实现更快的收敛和更好的泛化。

3. SwiGLU 激活函数

在LLaMA模型的Transformer架构中,激活函数从传统的ReLU或GELU更换为SwiGLU。SwiGLU是一种基于Swish激活函数的GLU变体,它提供了更好的梯度流动和可能的性能提升。

4. 旋转位置嵌入(RoPE)

LLaMA模型还采用了旋转位置嵌入(RoPE)来代替传统的位置编码方法。RoPE通过将位置信息编码为旋转矩阵,使模型能够更有效地捕捉序列中元素之间的位置关系。

5. 注意力机制优化

LLaMA模型可能包含对注意力机制的优化,例如稀疏注意力机制,以减少计算复杂度和内存需求。这些优化措施有助于提高模型的计算效率。

6. Group Query Attention

在LLaMA v2中,使用了Group Query Attention技术,这是一种将query分组,组内共享Key-Value的方法,旨在减少缓存量并加速计算,同时保持与Multi-Query Attention相似的效果。

7. 模型规模和训练超参数

LLaMA模型有不同的规模版本,从几十亿到数百亿参数不等。每个版本的模型都有特定的超参数设置,例如隐藏层大小、头数、层数、学习率等。

8. 分布式模型训练

由于LLaMA模型的参数量非常大,需要依赖分布式模型训练框架来完成训练过程,这可能涉及到大量的GPU资源和优化的训练策略。

前置归一化与后置归一化的区别

前置归一化(Pre-normalization)

- 位置:在子层(如自注意力和前馈网络)的输入之前进行归一化。

- 优点:有助于提高训练过程中的稳定性,特别是在模型参数初始化阶段,可以降低梯度爆炸的风险。

- 缺点:可能需要更精细的学习率调整和优化策略。

后置归一化(Post-normalization)

- 位置:在子层的输出之后进行归一化。

- 优点:这是原始Transformer模型中的标准做法,对于许多任务而言效果良好。

- 缺点:在大型模型和数据集上可能导致训练初期的梯度不稳定问题。

结论

LLaMA模型中的前置层归一化是为了提高模型的训练稳定性和效率,而后置层归一化则是Transformer的传统方法。在实际应用中,前置归一化可能更适合于训练大型模型,因为它可以减少训练初期的梯度问题。然而,这两种方法都有其优势和局限性,选择哪一种取决于具体的模型设计和任务需求。文章来源:https://www.toymoban.com/news/detail-842101.html

参考:文章来源地址https://www.toymoban.com/news/detail-842101.html

- 深入解析LLaMA如何改进Transformer的底层结构 - 知乎

- LLaMA v1/2模型结构总览 - 知乎

- LLaMA Explained | Papers With Code

- Understanding Llama2: KV Cache, Grouped Query Attention, Rotary ...

到了这里,关于LLaMA 模型中的Transformer架构变化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!