DaFoEs: Mixing Datasets Towards the Generalization of Vision-State Deep-Learning Force Estimation in Minimally Invasive Robotic Surgery

Authors: Mikel De Iturrate Reyzabal, Graduate Student Member, IEEE, Mingcong Chen, Wei Huang, Sebastien Ourselin, and Hongbin Liu

Key words: Deep learning in grasping and manipulation, surgical robotics: Laparoscopy, computer vision for medical robotics.

Source: IEEE ROBOTICS AND AUTOMATION LETTERS, VOL. 9, NO. 3, MARCH 2024

Abstract

在微创机器人手术 (MIRS) 中精确确定安全相互作用期间的接触力仍然是一个开放的研究挑战。受手术视频术后定性分析的启发,使用跨模态数据驱动的深度神经网络模型一直是预测无传感器力趋势的最新方法之一。但是,这些方法需要用于当前不可用的大型和可变数据集。在本文中,提出了一种新的视觉触觉数据集(DaFoE),该数据集具有可变的软环境,用于训练深度神经模型。为了减少单个数据集的偏差,提出了一个管道,使用具有不同设置的先前验证的数据集,将不同的视觉和状态数据输入推广到混合数据集训练中。最后,提出了一种可变编码器-解码器架构,以使用单个输入或输入序列来预测腹腔镜工具所受的力。对于输入序列,使用一个以前缀 R 命名的递归解码器和一个新的时间采样来表示工具的加速度。在训练过程中,证明了单个数据集训练往往会过拟合训练数据域,但在跨新域转换结果时存在困难。然而,数据集混合呈现出良好的平移,循环和非循环模型的平均相对估计力误差分别为 5% 和 12%。方法还略微提高了变压器的力估算效率,最高可达 15%,因为可用数据量增加了 150%。总之,本研究证明了视觉状态的混合实验设置MIRS中的力估计是解决问题的一种可能方法。

在这项研究中,提出了一个新的基于视觉的无传感器力估计 (DaFoE) 数据集,该数据集使用安装在由定制商用触觉主设备控制的机械臂上的远程手术腹腔镜镊子,包括镊子抓握的驱动。这篇手稿的主要贡献是:

1)创建一个管道来推广深度神经网络训练的视觉状态输入,用于从不同数据流进行无传感器力估计;

2)通过将基于ViT的图像编码器和具有特定时间窗口的递归解码器相结合,提出了一种新的神经网络架构,以及

3)将该模型与该领域的先前工作进行了比较。

图 1.用于收集 DaFoEs(力估计数据集)数据集的完整实验设置。该装置分为 3 个主要组件,颜色编码:遥控机械臂(蓝色)、主控制器(绿色)和镊子控制器(红色)。在图像的左侧,展示了软组织环境的不同可能性。

表一 所用数据集的主要特点

图 2.运动学感知增强管道的水平镜像变换示例。在图像平面中,有视觉转换。在下半部分,有更新机器人运动矢量的所有步骤。K 代表运动学,IK 代表逆运动学。

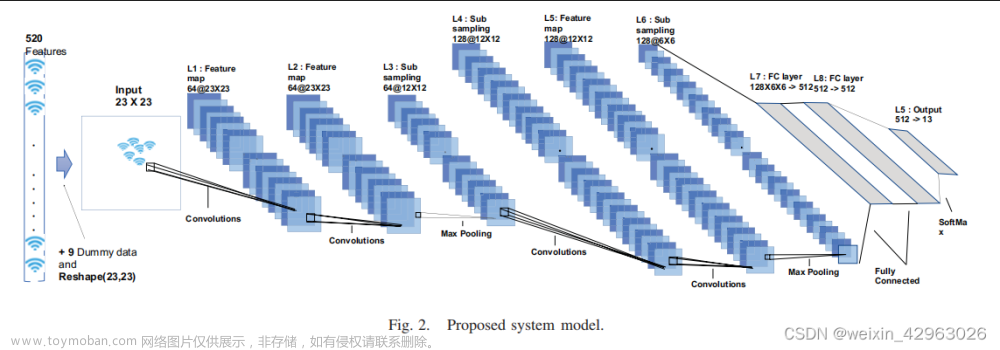

图 3.视觉状态模型训练管道的图形表示。在右上角,展示了用于本研究的不同视觉编码器(ResNet50 和 Vision Transformer)。在与状态向量连接后,有两种不同类型的解码器:非递归 (MLP) 或递归 (LSTM)。

图 4.用于比较数据集混合方法有效性的指标。条形表示测试剪辑的原点数据集。(a) 和 (b) 分别表示将训练隔离到单个数据集 dVRK 和 DaFoEs 中,以及将实验转换为相反的数据集。(c) 显示混合数据集训练的力差。

图 5.特征隔离实验的结果为条形图。X 轴显示了论文中介绍的不同模型。

图 6.参数遮挡实验结果为条形图。结果按照与图 5 相同的结构呈现。

图 7.包含力的演变(顶部)和误差随时间演变的图表(底部)。顶部的图表显示了 X 轴上力的时间演变。下图显示了本文介绍的 5 种不同模型的 RMSE 的时间变化:卷积神经网络 (CNN)、视觉转换器 (ViT) 和多层感知器 (FC),适用于非复发和复发情况 (R-)。

表II:力的孤立局部最大值和最小值的误差值

在这项研究中,证明了数据集混合的可行性,用于训练不同的深度神经网络,用于无传感器视觉状态力估计,作为 MIRS 中可能的通用方法。表明,使用正确的时间采样可以大大提高时间解码器的性能。一般来说,本文分析的所有模型都可以学习力的趋势,但只有循环模型才能预测整个剪辑中的全部力范围。此外,对于混合数据集管道,观察到 Transformer 架构确实受益于创建大量数据,即使硬件系统在状态和视觉记录方面都有所不同。然而,目前仍处于这一研究领域的初始阶段,应该开发更多的数据集、架构和学习技术,以达成共识并扩展对这一主题的了解。

出于这个原因,新的研究应该集中在收集新的更多可变数据集上,以探索来自多个和更多样化来源的泛化管道。数据来源的一些例子是:从用于大数据量的模拟环境,到对管腔、离体动物或人体组织进行更好的建模的复杂模型几何形状,以及用于更逼真的视觉输入的体内环境。然而,由于这些环境的工作空间有限,因此在使用可靠的力传感硬件方面确实存在更多问题,因此很难使用有监督的训练方案。因此,有必要创建额外的理论公式,以建立新的训练管道,以避免GT真实可靠力读数的必要性。

Reference:文章来源:https://www.toymoban.com/news/detail-842115.html

[1] Reyzabal, M. D. I., Chen, M., Huang, W., Ourselin, S., & Liu, H. (2024). DaFoEs: Mixing Datasets towards the generalization of vision-state deep-learning Force Estimation in Minimally Invasive Robotic Surgery. IEEE Robotics and Automation Letters.文章来源地址https://www.toymoban.com/news/detail-842115.html

到了这里,关于文献学习-21-DaFoEs:混合数据集以推广微创机器人手术中的视觉状态深度学习力估计的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!