AtomoVideo是一种新型的高保真图像到视频(I2V)生成框架,可以从输入图像生成高保真视频,实现比现有工作更好的运动强度和一致性,并且兼容各种个性化的T2I模型,无需特定调整。

相关链接

项目:atomo-video.github.io

论文:arxiv.org/abs/2403.01800

论文阅读

高保真图像到视频生成

摘要

近年来,基于先进的文本到图像生成技术,视频生成取得了长足的发展。在这项工作中,我们提出了一个用于图像到视频生成的高保真框架,名为AtomoVideo。基于多粒度图像注入,实现了生成的视频对给定图像的高保真度。此外,由于高质量的数据集和训练策略,我们实现了更大的运动强度,同时保持了优越的时间一致性和稳定性。我们的架构可以灵活地扩展到视频帧预测任务,通过迭代生成实现长序列预测。此外,由于适配器训练的设计,我们的方法可以很好地与现有的个性化模型和可控模块相结合。通过定量和定性评价,AtomoVideo与常用方法相比取得了更好的效果。

方法

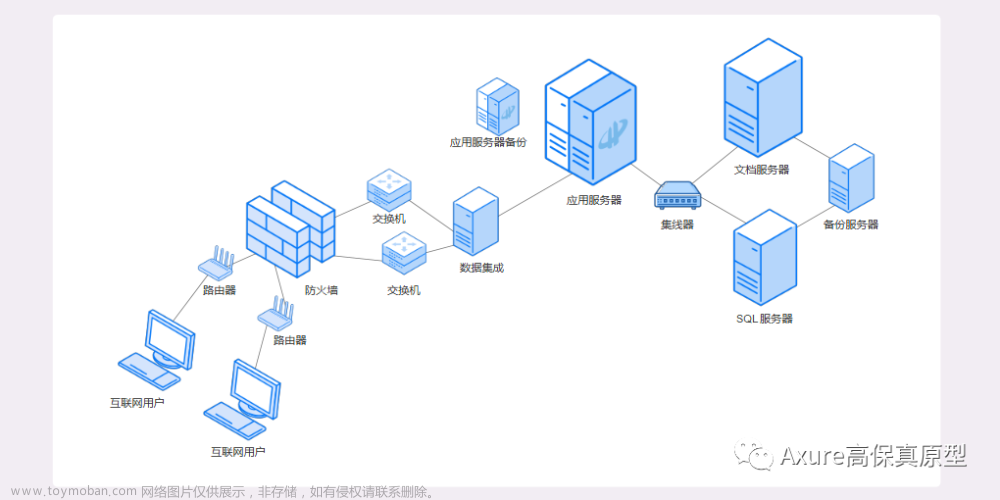

图像到视频方法的框架:我们使用预训练好的T2I模型,在每个空间卷积和注意层之后新增1D时间卷积和时间注意模块,固定T2I模型参数,只训练新增的时间层。同时,为了注入图像信息,我们将输入通道修改为9通道,增加图像条件隐码和二值掩码。由于输入的拼接图像信息仅由VAE编码,因此它代表低级信息,这有助于增强视频相对于给定图像的保真度。同时,我们还以交叉注意的形式注入高级图像语义,以实现更多的语义图像可控性。

实验

文章来源:https://www.toymoban.com/news/detail-842373.html

文章来源:https://www.toymoban.com/news/detail-842373.html

感谢你看到这里,也欢迎点击关注下方公众号,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion、Sora等相关技术,欢迎一起交流学习💗~文章来源地址https://www.toymoban.com/news/detail-842373.html

到了这里,关于AtomoVideo:阿里推出高保真图像到视频生成开源模型,具有更好的运动强度和一致性的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!