基本信息

题目:Adversarial Machine Learning for Network Intrusion Detection Systems: A Comprehensive Survey

期刊:IEEE Communications Surveys & Tutorials

SCI 工程技术 1 区

摘要

基于网络的入侵检测系统(NIDS)是抵御危及数据、系统和网络安全的网络攻击的一线防御系统。近年来,深度神经网络 (DNN) 因其检测准确性高而越来越多地用于 NIDS 中检测恶意流量。但是,DNN 容易受到对抗性攻击,这些攻击会以难以察觉的扰动修改输入示例,从而导致 DNN 错误分类。在 NIDS 等安全敏感领域,对抗性攻击对网络安全构成严重威胁。然而,针对 NIDS 的对抗性学习的现有研究直接实现了为计算机视觉(CV)任务设计的对抗性攻击,忽略了 CV 和 NIDS 之间检测管道和特征空间的根本差异。发起和检测针对 NIDS 的对抗性攻击仍然是一个重大的研究挑战。本文调查了自 2015 年以来关于 NIDS、对抗性攻击和网络防御的最新文献,以研究 CV 和 NIDS 中对抗性学习与深度神经网络的差异。它使读者对基于深度学习的 NIDS、对抗性攻击和防御以及该领域的研究趋势有了透彻的了解。我们首先提出了基于 DL 的 NIDS 的分类法,并讨论了分类法对对抗性学习的影响。接下来,我们回顾了对 DNN 的现有白盒和黑盒对抗性攻击及其在 NIDS 域中的适用性。最后,我们回顾了针对对抗性示例的现有防御机制及其特征。

通过调查(自 2015 年以来)关于基于 DL 的 NIDS 对抗性攻击和对抗性防御的文献,弥合 NIDS 中的对抗性学习与 CV 之间的差距,以全面概述基于 DL 的 NIDS 中的对抗性学习。

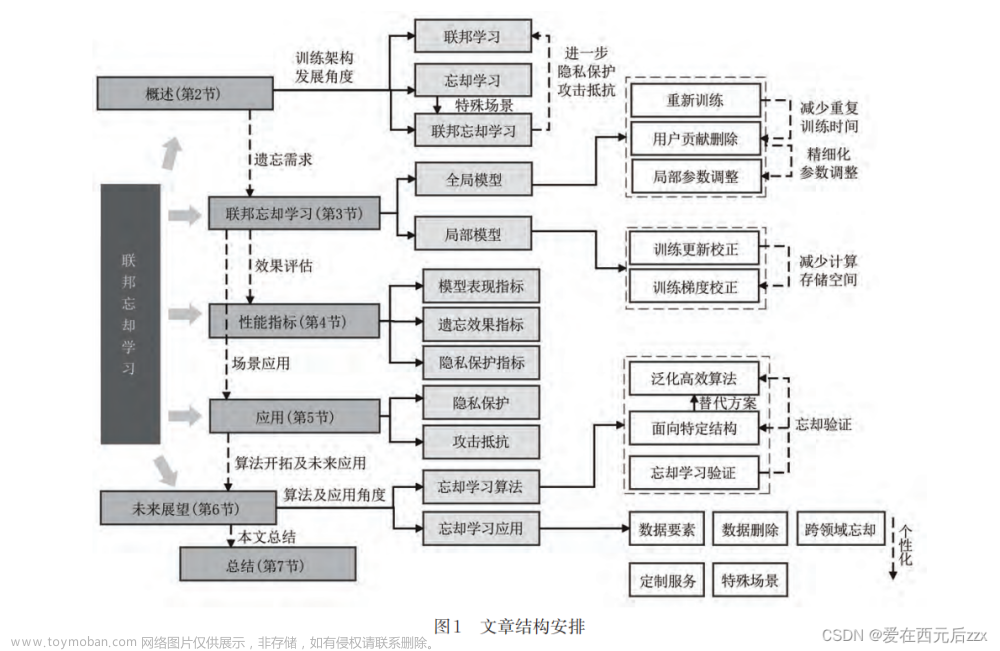

文章层次结构

- 搜集总结当前文献--基于 DL 的 NIDS 应用的对抗性攻击和防御

- 介绍 NIDS 的原理和过程

- 针对深度学习模型的各种一般对抗性攻击和针对 NIDS 的对抗性攻击

- 对抗性防御方法

- 展望与挑战

引言 (Introduction): 介绍网络入侵检测系统(NIDS)的背景、深度学习(DL)在 NIDS 中的应用,以及对抗性攻击对 DL 模型的威胁。

相关工作 (Existing Surveys and Our Contributions): 回顾和讨论了与 NIDS、对抗性攻击和防御相关的现有文献,并概述了本研究的贡献。

NIDS 的四个组成部分 (Taxonomy of NIDS): 提供了 DL-based NIDS 的组成,包括评估数据集、特征提取、特征降维和检测算法等组成部分。

对抗性攻击 (Adversarial Attacks): 描述了针对 DL 模型的一般性对抗性攻击,并讨论了它们在 NIDS 领域的适用性。

NIDS 特定的对抗性攻击 (NIDS-Specific Adversarial Attacks): 探讨了专门设计来规避 NIDS 的对抗性攻击。

对抗性防御机制 (Adversarial Defense Mechanisms): 调查了用于保护 DL 算法免受对抗性攻击的各种防御机制,并讨论了它们在 NIDS 领域的适用性。

研究挑战与未来方向 (Lessons Learned and Future Research Directions): 讨论了 NIDS 领域对抗性学习的主要挑战,并提出了未来研究的方向。

结论 (Conclusion): 总结了论文的主要发现,并强调了对抗性学习在 NIDS 领域的重要性。

附录 (Appendix): 提供了论文中使用的缩写词列表。

关键点

攻击和防御的挑战:

CV 任务:在 CV 中,对抗性攻击和防御策略通常集中在图像的像素级别,这使得攻击更容易实施,因为图像数据的维度相对较高,提供了更多的操作空间。

NIDS 任务:在 NIDS 中,由于网络流量数据的复杂性和结构化特性,实施有效的对抗性攻击更加困难。同时,防御策略也需要考虑到网络流量的时序性和协议约束,这增加了防御机制设计的复杂性。

解决的问题

这是一篇 NIDS 对抗学习,所以我们要关注研究背景和现状是否清晰,对研究形式的判断是否准确。

当前研究进度

检测管道(Detection Pipeline)

- CV 任务:在计算机视觉中,检测管道通常涉及图像的预处理、特征提取、分类或检测。例如,在目标检测任务中,图像首先被分割成多个区域,然后使用卷积神经网络(CNN)提取特征,最后通过分类器来识别图像中的对象。

- NIDS 任务:网络入侵检测系统的检测管道则涉及网络流量的监控、特征提取、以及基于这些特征的异常或恶意行为检测。NIDS 通常处理的是网络包(packets)或流量(traffic)数据,这些数据需要被转换成适合机器学习模型处理的特征向量。

特征空间(Feature Space)

- CV 任务:在计算机视觉中,特征空间通常是由图像的像素值、颜色、纹理、形状等视觉属性构成的高维空间。这些特征通常是连续的,并且可以通过图像处理技术(如卷积)来提取。

- NIDS 任务:网络入侵检测的特征空间则包括了网络流量的统计特性,如包的大小、传输时间、协议类型、端口号等。这些特征通常是离散的,并且与网络协议和设备行为紧密相关。网络流量数据的复杂性在于其结构化和时序性,这使得特征提取和分析更加复杂。

| 特性 | CV 领域 | NIDS 领域 | 备注 |

|---|---|---|---|

| 任务类型 | 图像的像素级别 | 网络流量数据 | CV 任务关注图像内容,NIDS 关注网络行为 |

| 攻击实施 | 相对容易 | 更加困难 | 图像数据维度高,提供更多操作空间;网络数据结构化,时序性强 |

| 防御策略 | 像素级修改 | 特征和流量分析 | CV 领域的防御侧重于图像层面,NIDS 侧重于流量特征和行为模式 |

| 检测管道 | 图像预处理、特征提取、分类/检测 | 网络流量监控、特征提取、异常/恶意行为检测 | CV 处理图像数据,NIDS 处理网络包和流量数据 |

| 特征空间 | 像素值、颜色、纹理、形状 | 包大小、传输时间、协议类型、端口号 | CV 特征空间连续且高维;NIDS 特征空间离散且与网络协议紧密相关 |

| 操作空间 | 高 | 低 | 图像提供更多操作自由度,网络数据受限于协议和结构 |

| 时序性 | 不显著 | 显著 | NIDS 需要考虑网络流量的时序性和协议约束 |

| 协议约束 | 无 | 有 | NIDS 必须考虑网络协议对流量数据的影响 |

| 复杂性 | 主要关注图像内容 | 关注流量的统计特性和行为模式 | NIDS 领域的特征提取和分析更复杂 |

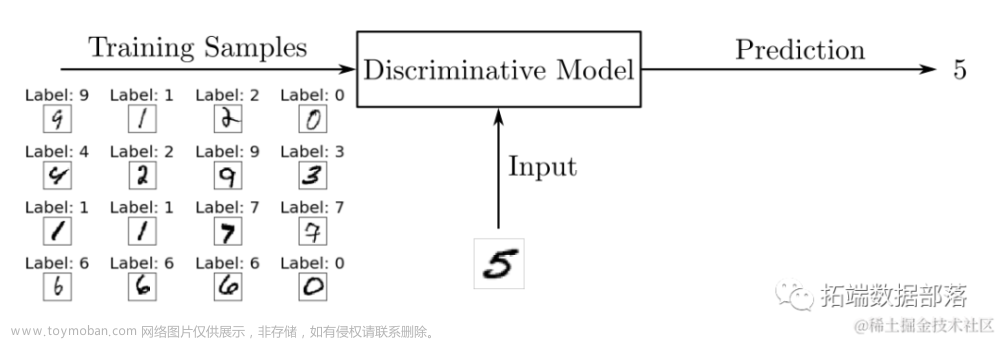

机器学习 (ML) 算法确定受监控的特征(包的大小、传输时间、协议类型、端口号等)是否表现出潜在网络攻击的属性。根据分类阶段的结果,系统在响应阶段采取适当的行动来防御攻击。

传统方法:随着流量的指数级增长,浅层机器学习算法(例如决策树 (DT)、支持向量机 (SVM) 和贝叶斯网络 (BN))的训练和测试效率越来越低。

新方法:深度学习算法的成功主要归功于它们能够充分利用大量数据来学习极其抽象和非线性的表示,从而实现高度准确的分类。但是,深度学习算法容易受到对抗性攻击创建的对抗性示例的影响。

从这里引出当前利用深度学习的 NIDS 容易受到对抗样本攻击的问题。当前针对这种攻击的方式沿用了 CV 防御的方式,忽略了 NIDS 和 CV 在检测管道和特征空间方面的巨大差异。

本文主要方法

NIDS 相关细节

NIDS 特征降维

随着计算能力和深度学习算法的进步,各种 NIDS 系统都使用深度学习算法和启发式搜索算法来降低输入特征的维数。我们将常见的特征缩减方法归类为“选择”或“投影”。

1)选择:特征选择是指找到输入特征的子集,以最大限度地提高决策模型的性能。用于特征选择的三种主要策略是: • 过滤方法利用统计方法将每个特征作为自变量进行评分,其中分数低的特征将被删除。

2)投影:特征投影是指将高维特征映射到低维表示中。直观地说,特征投影可生成原始高维特征的紧凑和抽象表示。投影要素可以是原始要素的线性或非线性组合。

基于 DL 的 NIDS 不执行特征缩减;因此,它不会影响对抗性攻击的配方。

然而,对抗性防御可能会从特征缩减中受益,方法是从输入中消除对抗性扰动或在模型中引入额外的复杂性以增加生成成功攻击的成本。

用于流量分类和异常值检测的深度学习算法

介绍用于流量分类和异常值检测的深度学习算法,以及与每种方法相关的细微差别。

讨论

现有的基于深度学习的 NIDS 解决方案主要使用分类算法对网络流量进行分类,因为它比异常值检测具有更好的性能和更可解释的输出。然而,分类算法在现实场景中训练具有挑战性,因为收集正确标记的网络数据集很麻烦。此外,对基于分类的 NIDS 的评估在很大程度上忽略了零日攻击,其中攻击流量是由 NIDS 以前从未见过的网络攻击产生的。因此,异常值检测算法在 NIDS 领域更实用,因为它们不需要标记数据,并且对零日攻击具有固有的鲁棒性。

现有的对抗性攻击和防御主要根据分类模型进行评估

对抗性攻击及其方法

两个概念

(1)目标攻击

对于一张图片和一个目标标注句子,生成一个对抗样本,使得标注系统在其上的标注与目标标注完全一致,即不仅要求攻击成功,还要求生成的对抗样本属于特定的类。

(2)非目标攻击

对于一张图片,生成一个对抗样本,使得标注系统在其上的标注与原标注无关,即只要攻击成功就好,对抗样本的最终属于哪一类不做限制。

白盒攻击

通常用于分析和洞察对抗性示例。因此,它假定对分类器有完整的了解。在 WB 威胁模型下,攻击者具有以下目标、知识和能力:1) 目标:攻击者的目标是生成一个同时满足置信度和相似性约束的对抗性示例。2)知识:攻击者对模型的参数有充分的了解。3)能力:攻击者可以操纵输入的每个特征。

- 最小范数攻击:最小范数攻击(Minimum Norm Attack)是一种白盒(White-Box)对抗性攻击方法,其目标是在满足对抗性样本的相似性约束(即对抗性样本与原始样本在某种范数度量下的差异尽可能小)的前提下,生成对抗性样本。这种攻击方法强调的是在保持对抗性样本与原始样本尽可能相似的同时,使得样本被错误分类。

| 攻击类型 | 目标 | 方法 | 特点 | 信息需求 | 计算复杂性 | 适用性 |

|---|---|---|---|---|---|---|

| 最小范数攻击 | 生成一个与原始样本尽可能相似的对抗性样本,扰动大小最小化 | 通过优化问题寻找最小范数扰动向量 | 强调扰动最小化,需要模型结构和参数(白盒) | 需要模型完整信息 | 可能较复杂 | 白盒场景 |

| 0 阶攻击 | 不需要模型参数信息,通过模型输出估计梯度 | 利用模型输出估计梯度方向,优化生成样本 | 不需要内部信息,适用于黑盒或灰盒场景 | 不需要模型内部信息 | 通常简单 | 黑盒或灰盒场景 |

| 2 阶攻击 | 利用模型的二阶信息生成对抗性样本 | 计算或近似二阶信息,基于此优化扰动向量 | 需要额外信息(如 Hessian 矩阵),计算资源需求高 | 需要模型额外信息 | 较复杂 | 白盒场景 |

异同点

- 相似性:所有这些攻击方法都旨在生成对抗性样本,使得模型做出错误的分类决策。

- 信息需求:最小范数攻击通常需要模型的完整信息(白盒),而 0 阶攻击不需要模型的内部信息,2 阶攻击可能需要模型的额外信息(如 Hessian 矩阵)。

- 计算复杂性:最小范数攻击和 2 阶攻击可能需要更复杂的优化过程,而 0 阶攻击通常更简单,因为它依赖于模型输出的查询。

- 适用性:最小范数攻击和 2 阶攻击更适合于白盒场景,而 0 阶攻击适用于黑盒或灰盒场景,其中攻击者无法直接访问模型的参数。

-

Maximum allowable attack:

在 Maximum allowable attack 中,攻击者会尝试找到一个扰动向量,当这个向量加到原始样本上时,会产生一个新的样本,这个新样本不仅会被模型错误地分类为目标类别,而且模型对这个分类的置信度会尽可能高。这种攻击通常在已知目标类别的情况下进行,即目标攻击(targeted attack)。 -

正则化的攻击:

第三种类型的攻击是基于正则化的攻击,它仔细平衡了相似性和置信度约束,以允许更精细的对抗性示例。

黑盒攻击

相比于白盒的区别是:分类器被视为预言机,攻击者对其参数一无所知。然而,可以进行有根据的猜测来确定神经网络试图解决的一般任务

- 基于转移:找到一个相似决策边界的模型,然后对该模型采取白盒攻击,用这种攻击方式转移至对黑盒模型的攻击。

- 基于分数:直接应用白盒攻击公式,梯度估计

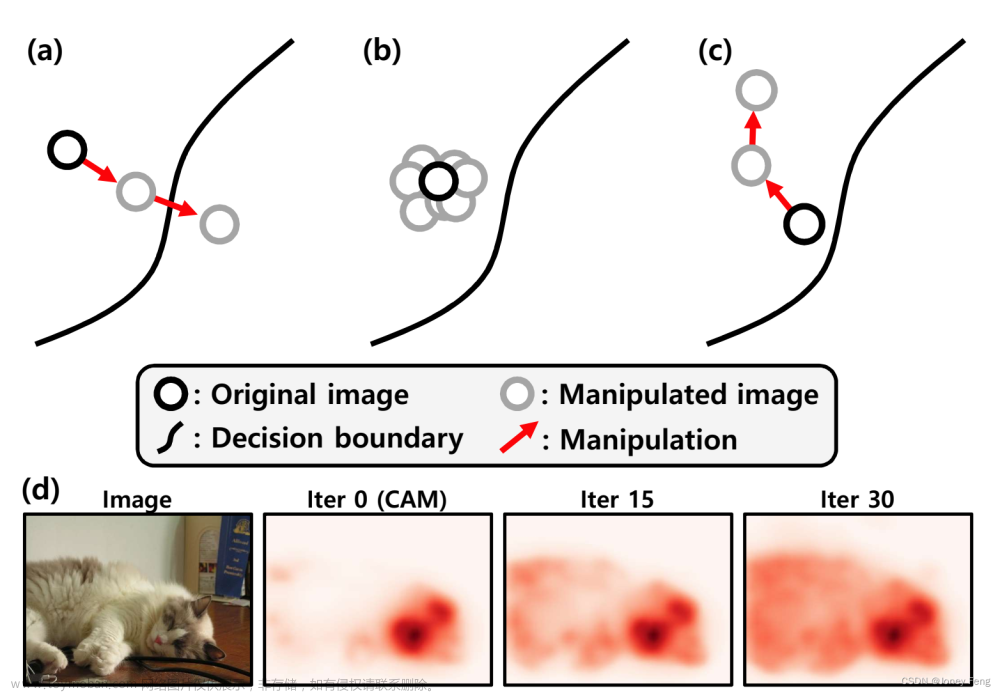

- 基于决策的攻击:基于决策的攻击是一种更强大的基于分数的攻击形式,只需要输出标签而不是分数。直观地说,基于决策的攻击可以被认为是穿越目标类和原始类之间的边界,以找到最接近原始样本的对抗性样本。

| 攻击类型 | 目标 | 方法 | 特点 |

|---|---|---|---|

| 基于转移的攻击 | 通过在替代模型上应用白盒攻击,生成在目标模型上有效的对抗性样本。 | 猜测目标模型任务,训练替代模型,然后在该模型上生成对抗性样本。 | 依赖于对抗性样本的迁移性,不需要目标模型的内部参数。 |

| 基于分数的攻击 | 估计目标模型的梯度来生成对抗性样本。 | 利用模型输出分数估计梯度,应用白盒攻击公式优化生成样本。 | 需要查询模型输出分数,不依赖于模型具体参数。 |

| 基于决策的攻击 | 改变模型的决策结果,从原始类别变为目标类别。 | 从目标类别样本开始,沿类别边界搜索最接近原始样本的对抗性样本。 | 不需要输出分数,只需模型预测标签,直接改变决策结果。 |

异同点

- 相似性:所有这三种攻击都是黑盒攻击,不需要知道目标模型的内部结构和参数。

- 梯度估计:基于转移的攻击不直接估计梯度,而是通过替代模型来生成对抗性样本。而基于分数的攻击则需要估计梯度。基于决策的攻击则不需要梯度信息,它通过搜索决策边界来生成样本。

- 复杂性:基于转移的攻击可能需要较多的计算资源,因为它涉及到训练替代模型。基于分数的攻击在估计梯度时可能需要多次查询模型。基于决策的攻击在理论上可能更简单,因为它不需要梯度信息,但实际上可能需要复杂的搜索策略来找到有效的对抗性样本。

- 目标:基于转移的攻击和基于分数的攻击都强调最大化对抗性样本的效果,而基于决策的攻击则专注于改变模型的决策结果。

威胁模型

目标:攻击者的目标是生成一个同时满足置信度和相似性约束的对抗性示例。

对于网络流量数据来说,定义一个统一的相似性概念是一个悬而未决的问题。现有的 NIDS 对抗性攻击通常会在对抗性特征和原始特征之间设置相似性约束。

知识:针对 CV 的对抗性攻击中的威胁模型主要考虑攻击者对分类器的了解。

在 NIDS 中,预处理功能(即特征提取和约简)是不可逆的。提取的特征的确切类型取决于 NIDS 的设计,而不是标准的。

上面提到的黑白盒攻击模式。只不过这里作者还给出了灰盒模型,可以看一下原文:

- Black-box, if the attacker has zero knowledge of the classifier and its auxiliary components.

- Grey-box, if the attacker has zero knowledge of the classifier but has some knowledge of the preprocessing functions.

- White-box, if the attacker has complete knowledge of the classifier and auxiliary components.

能力:针对 CV 的对抗性攻击通常假定攻击者无权访问训练数据。但是,攻击者能够访问网络流量数据是合理的。

因为一个图像识别程序一般不会暴露给你图像训练数据,但是 NIDS 的网络流量一般可以通过无线设备嗅探到。

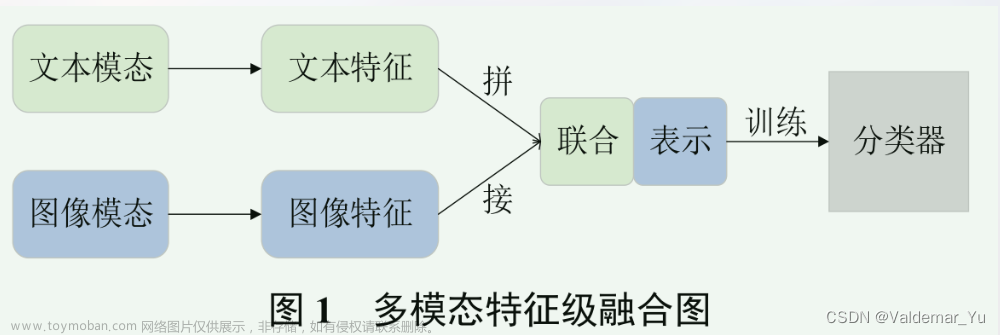

特征级攻击(Feature-Level Attacks, FLA)

特征级攻击是指直接对网络流量的特征表示进行操纵的攻击方法。这些攻击通常假设攻击者有白盒或灰盒的知识。FLA 的目标是在保持数据表示的合法性的同时,修改特征以绕过 NIDS 的检测。这些攻击可能包括:

- 修改现有流量的特征值。

- 添加或删除流量特征。

- 通过特征之间的关联来生成新的对抗性特征。

主要类别包含上面讲到的,基于转移、分数和基于 Wasserstein GAN 的攻击。但是,这些扰动仍处于功能级别,不会生成可用于进行实际攻击的恶意流/数据包。

尽管这些研究表明具有特征级扰动的 WB 和 BB 攻击是有效的,但它们有一个共同的局限性:缺乏实用性。

因为网络流量的各种特征之间具有某些联系,而且随意的改变就会导致样本失效,所以这种攻击方式很多时候难以直接使用。例如发送的数据包数和发送的字节数。当然,这两个特征是正相关的。发送大量字节和发送少量数据包几乎是不可能的。这些内在关系使得网络流量空间的低维、不完整为了生成更逼真的特征,提出了生成性特征级攻击。

生成特征级攻击(Generative Feature-Level Attacks, GFLA)

生成特征级攻击使用生成模型(如生成对抗网络 GAN)来学习网络流量特征的分布,并生成看起来合法但实际上具有恶意意图的特征。GFLA 的目标是创建新的、合成的流量特征,这些特征在统计上与正常的网络流量相似,但在 NIDS 中被识别为恶意。这种方法试图通过模拟真实世界的特征分布来提高攻击的隐蔽性。

| 攻击类型 | 目标 | 方法 | 特点 |

|---|---|---|---|

| 特征级攻击 (FLA) | 直接修改网络流量的特征表示来生成对抗性样本,欺骗 NIDS。 | 攻击者采用白盒或灰盒威胁模型,对特征进行精心设计的修改。 | 需要对 NIDS 的特征提取和分类过程有深入的了解。 |

| 生成特征级攻击 (GFLA) | 间接式生成对抗样本。使用生成模型学习网络流量特征的分布。 | 使用 GAN 或其他生成模型捕捉网络流量特征的统计特性,生成新的合成特征。 | 不需要对原始的 NIDS 有详细的了解,生成的样本在统计上与真实流量难以区分。 |

异同点

- 相似性:FLA 和 GFLA 都专注于修改网络流量的特征表示,以生成能够绕过 NIDS 检测的对抗性样本。

- 方法差异:FLA 通常需要对 NIDS 的内部工作机制有较深的理解,而 GFLA 则侧重于通过生成模型来模拟网络流量特征的分布,不需要详细的 NIDS 知识。

- 复杂性:FLA 可能涉及到对现有特征的直接修改,而 GFLA 涉及到训练生成模型来产生新的特征表示,这可能需要更多的计算资源和时间。

- 隐蔽性:GFLA 通过生成新的统计特征来模拟正常流量,可能在隐蔽性方面比 FLA 更有优势,因为它生成的特征在统计上与真实特征难以区分。

生成特征级攻击 GFLA 原理

为了训练 GAN,生成器首先生成一个随机输入,鉴别器很容易将其检测为非良性和现实性输入。然后,鉴别器将其损耗传递回生成器,生成器生成一组新的输入来减少损耗。重复此过程,直到鉴别器无法区分输入,这表明生成器已生成逼真的对抗特征。

WGAN 用于攻击分类器。

Attack-GAN,它通过考虑字节级修改和字节内的顺序信息来产生对抗性攻击。除了生成器学习和施加的约束外,Attack-GAN 还引入了预定义的网络特征约束。

NIDSGAN。它们在损失函数中引入了额外的术语,用于更具规避性的攻击。除了使判别器无法区分对抗性和良性流量的标准损失函数外,损失函数还最小化了对抗性特征和原始特征之间的距离。

生成算法在生成特征级攻击中的主要作用是捕获网络特征之间隐藏的相互依赖关系,并约束特征级扰动使其更加逼真。然而,尽管具有现实的对抗性网络功能,但在将网络功能转换为可重放数据包方面仍然存在很大差距。网络要素是网络数据包的抽象表示形式,仅用于检测入侵。它们不具有实际意义,不能在设备之间传输以进行网络活动。因此,要使任何特征级攻击都切实可行,必须找到特征提取和特征缩减过程的反函数,该过程生成一组用于生成对抗性特征的数据包。不幸的是,这个过程在计算上很难找到。因此,实际的对抗性攻击应该在数据包级别而不是特征级别进行。

数据包级攻击(Packet-Level Attacks, PLA)

数据包级攻击直接对网络数据包进行操作,以生成能够绕过 NIDS 的恶意流量。与 FLA 和 GFLA 不同,PLA 关注的是网络流量的实际传输层面,而不是抽象的特征表示。PLA 可能包括:

- 修改数据包的时间戳或序列号。

- 插入、删除或重排数据包。

- 改变数据包的负载内容,而不改变其外观。

PLA 现状

Homoliak 等考虑了一个 GB 威胁模型,并在一个名为 ASNM-NPBO 的自收集数据集上攻击五个浅层 ML 分类器(NB、DT、SVM、LR 和 NB,具有内核密度估计)。攻击是通过对数据包随机应用基于非有效载荷的混淆并检查它是否逃避分类器来进行的。混淆包括数据包时间延迟、数据包丢失、数据包损坏、数据包重复、数据包重新排序和负载碎片。

Hashemi 等假设 WB 威胁模型,并在 CIC-IDS2018 上攻击三种 NID:Kitsune 、DAGMM 和 BiGAN。该攻击采用与 Homoliak 等类似的方法,但只有三种突变操作:延迟数据包、拆分数据包或注入新数据包。对抗性示例是通过迭代尝试和测试其中一个突变操作并检查目标 NIDS 的异常评分是否低于突变后的阈值来生成的。

Kuppa 等提出了一种 GB 攻击方法,并攻击了七种不同的异常检测器:AE、DAGMM、AnoGAN、ALAD、DSVDD、OC-SVM 和隔离森林。该攻击是在 CIC-IDS2018 数据集上进行的。与以前直接修改数据包的数据包级攻击不同,Kuppa 等人首先使用流形近似算法 (MAA) 在标记数据中找到数据分布,该算法将决策空间转换为分段的局部球形子空间。基于子空间,攻击会生成一个与原始示例球形距离最小的对抗性示例。通过修改原始 pcap 文件中基于时间的特征,将对抗性特征实现回数据包中。

Han 等开发了一种新的 BB/GB 对抗性流量生成框架,称为 Traffic Manipulato。

PLA 总结

数据包级攻击标志着规避 NIDS 的实际对抗性攻击的重大改进,因为它们可以在网络中生成可重放的数据包。然而,现有的对抗性攻击缺乏对对抗性示例恶意性的全面评估。目前对对抗性攻击的评估主要集中在评估其规避性(即衡量 NIDS 对对抗性流量的准确性或 FNR),很少评估其恶意性(即保留了多少原始恶意行为)。攻击者的最终目标是在不被发现的情况下攻击设备。因此,对抗性数据包的规避性和恶意性同样重要。未来的研究应该全面评估对抗性数据包的恶意和规避性,而不是仅仅关注它们的规避性。此外,众所周知,数据包突变可以产生副作用特征(例如,将新数据包注入流量或分段数据包会导致提取新特征),但现有的数据包级对抗性攻击在很大程度上忽略了副作用特征的影响。

如何防御对抗性攻击?

参数保护(Parameter Protection)

- 梯度掩蔽(Gradient Masking):通过使梯度不可微分、不稳定或不存在,来防止白盒攻击者利用梯度信息生成对抗性样本。

- 破碎梯度(Shattered Gradients):例如使用 Thermometer Encoding、Input Transformation 等方法。

- 随机梯度(Stochastic Gradients):如 Stochastic Activation Pruning 和 Input Randomisation,通过在网络或输入样本中引入随机性来隐藏梯度。

- 消失与爆炸梯度(Vanishing & Exploding Gradients):使用深度生成模型如 Pixel Defend 和 Defense-GAN 来投影潜在的对抗性样本回数据流形。

对抗性检测(Adversarial Detection)

- 基于统计的检测(Statistics-Based Detection):使用统计方法如最大均值差异(MMD)测试来检测数据分布的差异。

- 变异基检测(Mutation-Based Detection):通过随机改变决策边界并测量输入样本对变异的敏感性来检测对抗性样本。

鲁棒性优化(Robustness Optimization)

- 输入预处理(Input Pre-Processing):如应用平均滤波器来移除输入样本中的对抗性扰动。

- 对抗性训练(Adversarial Training):在训练阶段引入正确标记的对抗性样本,以增强模型对对抗性样本的鲁棒性。

- 后训练修改(Post-Training Modifications):如防御性蒸馏(Defensive Distillation)和随机激活剪枝(Stochastic Activation Pruning),在模型训练完成后应用额外的处理来提高鲁棒性。

其他防御策略

- 特征挤压(Feature Squeezing):减少输入特征空间的大小,限制攻击者可用的扰动范围。

- 转移学习(Transfer Learning):应用转移学习技术来减少生成适合特定网络拓扑的网络数据集的成本。

这些防御方法各有优势和局限性,选择合适的防御策略需要考虑 NIDS 的具体需求和可用资源。论文还强调了在设计防御机制时需要考虑 NIDS 的独特性,包括处理时间的严格要求和对解释性的需求。此外,论文提出了对未来研究方向的建议,包括开发新的度量标准和评估框架,以及探索新的防御策略,如引入随机性来增强 NIDS 的安全性。

研究挑战与未来方向

论文讨论了在 NIDS 领域进行对抗性学习研究时面临的挑战,包括数据集的缺乏、异常检测的困难以及 NIDS 的可解释性问题。

作者提出了未来研究的方向,包括开发新的度量标准和评估框架,以及探索新的防御策略,如引入随机性来增强 NIDS 的安全性。

论文详细介绍了对抗性攻击的基本原理,包括目标、知识、能力和约束条件。

论文还讨论了白盒攻击、黑盒攻击以及专门针对 NIDS 的攻击方法,并提供了这些攻击方法的分类和概述。

对于防御机制,论文讨论了参数保护、对抗性检测和鲁棒性优化等策略,并分析了它们在 NIDS 领域的适用性。

研究挑战

- 缺乏基准数据集(Lack of Benchmark Datasets):

- 网络流量数据的私密性和不断变化的特性使得公开发布数据集变得困难。

- 快速增长的网络技术导致以前发布的基准数据集很快过时。

- 异常检测的评估困难(Challenges in Evaluating Outlier Detection):

- 由于缺乏标记数据,基于异常检测的 NIDS 更适用于实际应用,但评估这些系统的性能存在挑战。

- 需要开发新的度量标准和评估框架来准确反映 NIDS 的性能。

- NIDS 的可解释性(Explainability of NIDS):

- 深度学习模型的决策过程不透明,需要提高 NIDS 的可解释性和可解释性。

- 现有的解释方法未能充分解释网络流量特征的实际意义。

未来方向

- 应用转移学习(Applying Transfer Learning):

- 利用转移学习技术来减少生成特定网络拓扑的网络数据集的成本。

- 在基准数据集上学习一般流量模式,并将其应用到特定的网络环境中。

- 开发新的评估框架(Developing New Metrics and Evaluation Frameworks):

- 为基于异常检测的 NIDS 设计新的度量标准,以准确反映其性能。

- 评估对抗性攻击的恶意性、有效性和对抗性样本的统计特性。

- 提高 NIDS 的可解释性(Enhancing Explainability of NIDS):

- 研究如何解释网络流量特征的实际意义,而不仅仅是特征对模型输出的贡献。

- 开发能够提供上下文信息的解释方法,帮助理解 NIDS 的决策过程。

- 探索新的防御策略(Exploring New Defense Strategies):

- 研究新的防御技术,如引入随机性,使攻击者难以找到 NIDS 的弱点。

- 评估现有防御策略在不同网络速度和大小下的性能和开销。

- 对抗性样本的全面评估(Comprehensive Evaluation of Adversarial Samples):

- 评估对抗性样本的有效性、恶意性和对网络性能的影响。

- 确保防御机制不会引入过多的性能开销,同时保持高检测准确率。

相关文献

-

He et al. (2023): 这篇综述文章全面调查了自 2015 年以来在网络入侵检测系统(NIDS)中的对抗性学习和网络防御方面的文献,强调了在 CV 和 NIDS 之间检测流程和特征空间的根本差异。

-

Buczak and Guven (2016): 这篇文献提供了一个关于 NIDS 的全面分类,解释了在 NIDS 中使用的典型机器学习和深度学习算法,以及 NIDS 输入空间的特点。

-

Chaabouni et al. (2019): 研究了专门为物联网(IoT)设备设计的机器学习算法在 NIDS 中的应用,以及 IoT 环境中 NIDS 面临的独特挑战。

-

Hussain et al. (2020): 超越了 NIDS 的范畴,评估了机器学习和深度学习技术在解决物联网安全问题(如恶意软件分析、认证和访问控制以及入侵检测)方面的应用。

-

Zhang et al. (2019): 评估了用于无线和移动网络安全/分析任务的机器学习和深度学习算法,并考虑了为不同类型的移动网络定制深度学习算法。

-

Wang et al. (2017): 提供了一个对抗性攻击和防御的分类,这些攻击和防御针对机器学习模型,根据攻击针对的训练过程阶段进行分类,并讨论了训练过程中数据隐私保护的重要性。

-

Li et al. (2017): 对著名的白盒(WB)和黑盒(BB)对抗性攻击进行了数学回顾,并随后介绍了在测试时增强训练过程或去除对抗性扰动的防御方法。

-

Chakraborty et al. (2018): 使用更广泛的定义来描述对抗性攻击,包括探索性攻击、污染攻击和逃避攻击,并描述了对抗这些攻击的方法。

-

Silva and Najafirad (2020): 检查了现有的 WB 和 BB 攻击,并专注于提高网络鲁棒性的方法。

-

Serban et al. (2021): 分析了特定于计算机视觉任务的现有对抗性攻击和防御,并提出了一些关于是否需要为计算机视觉防御对抗性样本的有争议的观点。

-

Bhambri et al. (2019): 仅研究了针对计算机视觉任务的黑盒威胁模型下的攻击,以及防御机制。

-

Zhang et al. (2020): 调查了图像领域的现有对抗性攻击和防御,并寻求将这些攻击适应于自然语言处理任务的文本输入。

-

Olowononi et al. (2021): 提供了一个在网络物理系统(CPS)中应用的机器学习和深度学习/深度学习算法的分类,随后介绍了针对 CPS 的现有对抗性攻击和提高 ML 系统对抗性攻击韧性的防御。

-

Martins et al. (2020): 提出了针对机器学习/深度学习算法的显著 WB 和 BB 攻击,以及它们在 NIDS 和恶意软件检测中的适用性。

-

Ibitoye et al. (2021): 提供了一个关于网络安全任务中使用的机器学习和深度学习算法以及众多对抗性攻击和防御技术的全面总结。

- END - 文章来源:https://www.toymoban.com/news/detail-842694.html

::: block-2

一个只记录最真实学习网络安全历程的小木屋,最新文章会在公众号更新,欢迎各位师傅关注!

公众号名称:奇怪小木屋

博客园主页:

博客园-我记得https://www.cnblogs.com/Zyecho/

:::文章来源地址https://www.toymoban.com/news/detail-842694.html

到了这里,关于【论文阅读】NIDS对抗性机器学习综述的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!