1.背景介绍

图像分类与识别是计算机视觉的核心技术之一,它涉及到将图像中的对象进行分类和识别,以便于人工智能系统对图像进行理解和处理。图像分类与识别的应用非常广泛,包括但不限于人脸识别、自动驾驶、垃圾扔入分类等。

1.1 图像分类与识别的历史发展

图像分类与识别的历史发展可以分为以下几个阶段:

传统图像处理方法:在这一阶段,主要使用手工设计的特征提取方法,如边缘检测、颜色分析等,以及基于模板匹配的方法来进行图像分类与识别。这些方法的主要缺点是需要大量的人工参与,不能很好地处理复杂的图像,并且对于变化较大的图像有较低的识别准确率。

深度学习驱动的图像分类与识别:随着深度学习技术的发展,特别是卷积神经网络(Convolutional Neural Networks,CNN)的出现,图像分类与识别技术得到了巨大的提升。CNN可以自动学习图像的特征,并基于这些特征进行分类与识别,从而实现了人类水平甚至超越人类的识别准确率。

1.2 图像分类与识别的主要技术方法

图像分类与识别的主要技术方法包括:

传统图像处理方法:如边缘检测、颜色分析、模板匹配等。

深度学习方法:如卷积神经网络(CNN)、递归神经网络(RNN)、自编码器(Autoencoders)等。

传统机器学习方法:如支持向量机(Support Vector Machines,SVM)、随机森林(Random Forests)、K近邻(K-Nearest Neighbors,KNN)等。

在本文中,我们主要关注深度学习方法,特别是卷积神经网络(CNN)。

2.核心概念与联系

2.1 卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Networks,CNN)是一种特殊的神经网络,主要应用于图像分类与识别任务。CNN的主要特点是:

使用卷积层(Convolutional Layer)作为主要的特征提取模块,通过卷积运算来学习图像的局部特征。

使用池化层(Pooling Layer)来减少特征图的尺寸,以减少参数数量并提高模型的鲁棒性。

使用全连接层(Fully Connected Layer)来将卷积和池化层的输出转换为最终的分类结果。

2.2 卷积运算与特征映射

卷积运算是CNN的核心操作,它可以将输入图像的局部特征映射到特征图上。具体来说,卷积运算可以通过一个称为卷积核(Kernel)的小矩阵来对输入图像进行滤波。卷积核通常是一个2D矩阵,可以用来对输入图像的每个区域进行滤波。

通过卷积运算,我们可以得到一个特征图,其中的每个元素代表了输入图像中某个特定特征的强度。这些特征可以是边缘、颜色、纹理等。

2.3 池化运算与特征降维

池化运算是CNN中的另一个重要操作,它可以将特征图中的特征进行降维,以减少参数数量并提高模型的鲁棒性。池化运算通常使用最大池化(Max Pooling)或平均池化(Average Pooling)实现,它们的主要区别在于最大池化选择了特征图中的最大值,而平均池化选择了平均值。

2.4 全连接层与分类

全连接层是CNN中的最后一个层,它将卷积和池化层的输出转换为最终的分类结果。全连接层通常使用软max激活函数实现多类分类,或者使用sigmoid激活函数实现二类分类。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 卷积层的具体操作步骤

将输入图像与卷积核进行卷积运算,得到一个特征图。

将特征图与另一个卷积核进行卷积运算,得到另一个特征图。

将多个特征图进行拼接,得到一个新的特征图。

重复步骤1-3,直到所有卷积核都被使用。

3.2 池化层的具体操作步骤

对特征图中的每个区域,选择最大值或平均值,得到一个新的特征图。

将新的特征图的尺寸减小一半,以减少参数数量并提高模型的鲁棒性。

3.3 全连接层的具体操作步骤

将卷积和池化层的输出作为输入,通过全连接层得到最终的分类结果。

使用softmax或sigmoid激活函数将输出转换为概率分布。

3.4 数学模型公式详细讲解

3.4.1 卷积运算的数学模型

卷积运算的数学模型可以表示为:

$$ y(i,j) = \sum{p=0}^{P-1} \sum{q=0}^{Q-1} x(i-p,j-q) * k(p,q) $$

其中,$y(i,j)$表示输出特征图的值,$x(i,j)$表示输入图像的值,$k(p,q)$表示卷积核的值,$P$和$Q$分别表示卷积核的高度和宽度。

3.4.2 池化运算的数学模型

最大池化运算的数学模型可以表示为:

$$ y(i,j) = \max{p=0}^{P-1} \max{q=0}^{Q-1} x(i-p,j-q) $$

平均池化运算的数学模型可以表示为:

$$ y(i,j) = \frac{1}{P \times Q} \sum{p=0}^{P-1} \sum{q=0}^{Q-1} x(i-p,j-q) $$

3.4.3 损失函数

在训练CNN时,我们需要使用损失函数来衡量模型的预测结果与真实结果之间的差距。常用的损失函数有均方误差(Mean Squared Error,MSE)、交叉熵损失(Cross-Entropy Loss)等。

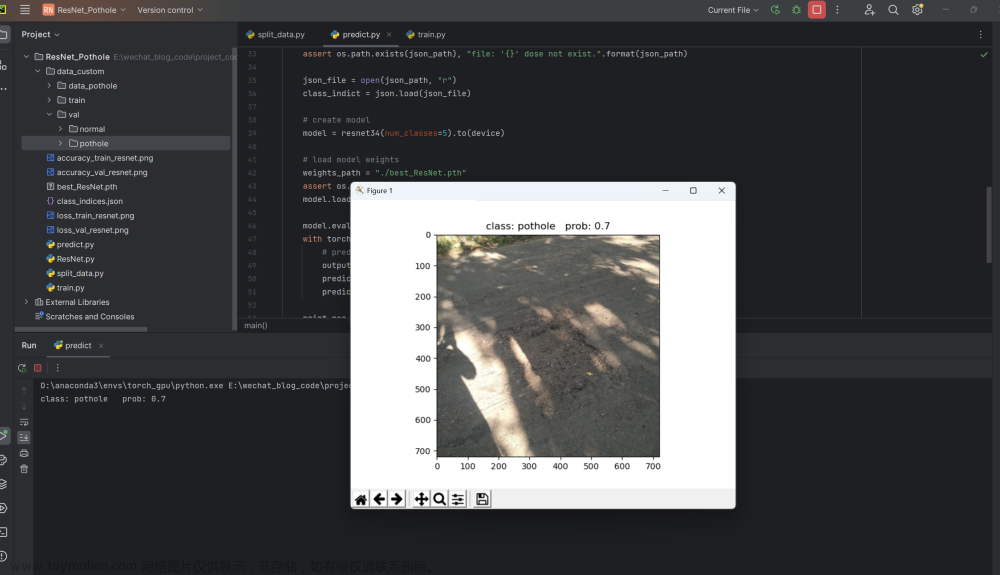

4.具体代码实例和详细解释说明

在本节中,我们将通过一个简单的图像分类任务来展示CNN的具体代码实例和详细解释说明。

4.1 数据预处理

首先,我们需要对输入图像进行预处理,包括缩放、裁剪、归一化等操作。

```python import numpy as np import cv2

def preprocessimage(imagepath): image = cv2.imread(imagepath) image = cv2.resize(image, (224, 224)) # 缩放图像到224x224 image = cv2.cvtColor(image, cv2.COLORBGR2RGB) # 将BGR图像转换为RGB图像 image = image / 255.0 # 归一化图像 return image ```

4.2 构建CNN模型

接下来,我们需要构建一个CNN模型,包括卷积层、池化层、全连接层等。

```python import tensorflow as tf

def buildcnnmodel(): model = tf.keras.Sequential()

model.add(tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(224, 224, 3)))

model.add(tf.keras.layers.MaxPooling2D((2, 2)))

model.add(tf.keras.layers.Conv2D(64, (3, 3), activation='relu'))

model.add(tf.keras.layers.MaxPooling2D((2, 2)))

model.add(tf.keras.layers.Conv2D(128, (3, 3), activation='relu'))

model.add(tf.keras.layers.MaxPooling2D((2, 2)))

model.add(tf.keras.layers.Flatten())

model.add(tf.keras.layers.Dense(512, activation='relu'))

model.add(tf.keras.layers.Dense(num_classes, activation='softmax'))

return model```

4.3 训练CNN模型

最后,我们需要训练CNN模型,并使用训练数据集和验证数据集进行训练。

```python import os

def traincnnmodel(model, trainimages, trainlabels, validationimages, validationlabels, epochs, batchsize): model.compile(optimizer='adam', loss='categoricalcrossentropy', metrics=['accuracy'])

train_images = train_images / 255.0

validation_images = validation_images / 255.0

train_images = train_images.reshape(-1, 224, 224, 3)

validation_images = validation_images.reshape(-1, 224, 224, 3)

train_labels = tf.keras.utils.to_categorical(train_labels, num_classes)

validation_labels = tf.keras.utils.to_categorical(validation_labels, num_classes)

history = model.fit(train_images, train_labels, epochs=epochs, batch_size=batch_size, validation_data=(validation_images, validation_labels))

return history```

4.4 评估CNN模型

最后,我们需要评估CNN模型的性能,并使用测试数据集进行测试。

```python def evaluatecnnmodel(model, testimages, testlabels): testimages = testimages / 255.0 testimages = testimages.reshape(-1, 224, 224, 3) testlabels = tf.keras.utils.tocategorical(testlabels, numclasses)

loss, accuracy = model.evaluate(test_images, test_labels)

return accuracy```

5.未来发展趋势与挑战

未来,图像分类与识别技术将会面临以下挑战:

数据不均衡问题:图像分类与识别任务中,数据集中的类别数量和样本数量可能存在很大差异,导致模型训练不均衡。

高质量图像数据的获取与标注:高质量的图像数据是图像分类与识别任务的基础,但获取和标注高质量图像数据是非常困难的。

模型解释性与可解释性:深度学习模型的黑盒性问题限制了其在实际应用中的使用。

未来,图像分类与识别技术的发展趋势将会包括:

自监督学习:通过自监督学习方法,可以从无标签的数据中学习到有用的特征,从而解决数据标注的问题。

跨模态学习:将图像分类与识别任务与其他模态(如语音、文本等)的任务相结合,以提高模型的性能。

强化学习:将图像分类与识别任务与强化学习任务相结合,以实现更高级别的视觉理解。

6.附录常见问题与解答

Q: 为什么卷积神经网络(CNN)的性能优于传统图像处理方法?

A: 卷积神经网络(CNN)的性能优于传统图像处理方法主要是因为其能够自动学习图像的局部特征,并基于这些特征进行分类与识别。此外,CNN的结构更加简洁,易于实现和训练。

Q: 如何选择卷积核的尺寸和数量?

A: 卷积核的尺寸和数量取决于输入图像的尺寸和类别数量。通常情况下,我们可以通过实验来选择最佳的卷积核尺寸和数量。

Q: 如何处理图像分类任务中的数据不均衡问题?

A: 处理图像分类任务中的数据不均衡问题可以通过多种方法,如重采样、综合评估指标、权重调整等。

Q: 如何提高CNN模型的泛化能力?

A: 提高CNN模型的泛化能力可以通过多种方法,如数据增强、迁移学习、数据增广等。

Q: 如何解决深度学习模型的黑盒性问题?文章来源:https://www.toymoban.com/news/detail-842726.html

A: 解决深度学习模型的黑盒性问题可以通过多种方法,如激活函数可视化、模型解释性、可解释性模型等。文章来源地址https://www.toymoban.com/news/detail-842726.html

到了这里,关于图像分类与识别:计算机视觉的核心技术的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!