弹性伸缩主要有三个维度:

HPA,根据利用率,自动伸缩 Pod 数量

VPA,根据历史数据,自动设置 Pod 的 Request、Limit

CA,根据使用率,自动伸缩 Node 数量

EKS集群的弹性扩缩容是一项功能(这里指node的),可以自动上下伸缩您的资源以满足不断变化的需求。若没有此项重要的 Kubernetes 功能,则需要耗费大量的人力资源来手动执行这些工作。

Amazon EKS 支持两款弹性缩放产品:Kubernetes Cluster Autoscaler 和 Karpenter 开源自动缩放项目。Cluster Autoscaler 使用 AWS 缩放组,而 Karpenter 则直接使用 Amazon EC2 Fleet。(参考 https://docs.aws.amazon.com/zh_cn/eks/latest/userguide/autoscaling.html)

EKS Cluster Autoscaler的配置实战

信息:

EKS集群名称:pre-production

地域: ap-southeast-1 亚太地区 (新加坡)

登录ID: 75xxxxxxx533

1、前置条件:一个AutoScaling Group [Cluster Autoscaler=CA 和 Auto Scaling组 是2个不同的概念,CA控制AS实现弹性伸缩。]

2、创建向 IAM 角色授予 Cluster Autoscaler 所需权限的 IAM 策略,使得 Cluster Autoscaler 能够具备操作 AWS AutoScaling 的权限。

- 首先在群集上为服务帐户启用IAM角色

eksctl utils associate-iam-oidc-provider \

--cluster pre-production \

--approve --region ap-southeast-1- 编辑文件IAM权限描述文件

cat <<EoF > /home/ec2-user/k8s-asg-policy.json

{

"Version": "2012-10-17",

"Statement": [

{

"Action": [

"autoscaling:DescribeAutoScalingGroups",

"autoscaling:DescribeAutoScalingInstances",

"autoscaling:DescribeLaunchConfigurations",

"autoscaling:DescribeTags",

"autoscaling:SetDesiredCapacity",

"autoscaling:TerminateInstanceInAutoScalingGroup",

"ec2:DescribeLaunchTemplateVersions"

],

"Resource": "*",

"Effect": "Allow"

}

]

}

EoF- 通过AWS CLI命令创建IAM权限

aws iam create-policy \

--policy-name k8s-asg-policy \

--policy-document file:///bsn/k8s/Cluster-Autoscaler/k8s-asg-policy.json --region ap-southeast-13、使用 eksctl 创建 Service Account 以及 IAM 角色,并将上一步创建的 IAM 策略附加到该角色 如果您自定义了集群名称,请将–cluster xxxx 替换为您的集群名称(若您没有使用默认配置) 请将 iam::xxxxxxxxxxxx:替换为您的账户ID(在您的aws控制台点击右上角可查看),例如263168716248(必须替换)

eksctl create iamserviceaccount \

--name cluster-autoscaler \

--namespace kube-system \

--cluster pre-production \

--attach-policy-arn "arn:aws:iam::75xxxxxx533:policy/k8s-asg-policy" \

--approve \

--override-existing-serviceaccounts --region ap-southeast-1特别注意:中国地域的arn格式会多一个-cn,宁夏为例:arn:aws-cn:iam::984xxxx4388:

此过程需要花一点时间,eksctl 会通过 CloudFormation 创建相关的权限资源

通过以下describe命令进行验证

kubectl -n kube-system describe sa cluster-autoscaler4、部署 Cluster Autoscaler,请直接复制执行下面命令

kubectl apply -f https://raw.githubusercontent.com/kubernetes/autoscaler/master/cluster-autoscaler/cloudprovider/aws/examples/cluster-autoscaler-autodiscover.yaml输出

serviceaccount/cluster-autoscaler created

clusterrole.rbac.authorization.k8s.io/cluster-autoscaler created

role.rbac.authorization.k8s.io/cluster-autoscaler created

clusterrolebinding.rbac.authorization.k8s.io/cluster-autoscaler created

rolebinding.rbac.authorization.k8s.io/cluster-autoscaler created

deployment.apps/cluster-autoscaler created5,执行以下命令将cluster-autoscaler.kubernetes.io/safe-to-evict批注添加到部署中。

为了防止 CA 删除运行它自己的 pod 的节点, 添加注释cluster-autoscaler.kubernetes.io/safe-to-evict

kubectl -n kube-system \

annotate deployment.apps/cluster-autoscaler \

cluster-autoscaler.kubernetes.io/safe-to-evict="false"6,通过kubectl edit编辑 Cluster Autoscaler 部署 (Deployment) 在 “spec: container: - command” 部分,将 (包括 <>)替换为当前 EKS 集群的名称(默认为odoo),并添加 “–balance-similar-node-groups"以及”–skip-nodes-with-system-pods=false"选项 示范如下: 执行命令,翻到后半段

修改部分如下所示(下面3行)

spec:

containers:

- command:

- ./cluster-autoscaler

- --v=4

- --stderrthreshold=info

- --cloud-provider=aws

- --skip-nodes-with-local-storage=false

- --expander=least-waste

- --node-group-auto-discovery=asg:tag=k8s.io/cluster-autoscaler/enabled,k8s.io/cluster-autoscaler/pre-production

- --balance-similar-node-groups

- --skip-nodes-with-system-pods=false完成修改后通过 esc键 输入 :wq 回车 保存并退出。

7,修改 Cluster Autoscaler 的 image 配置,复制执行以下命令

kubectl -n kube-system set image deployment.apps/cluster-autoscaler cluster-autoscaler=k8s.gcr.io/autoscaling/cluster-autoscaler:v1.20.0这个版本貌似可以用这2个命令确定,供参考

export K8S_VERSION=$(kubectl version --short | grep 'Server Version:' | sed 's/[^0-9.]*\([0-9.]*\).*/\1/' | cut -d. -f1,2)

export AUTOSCALER_VERSION=$(curl -s "https://api.github.com/repos/kubernetes/autoscaler/releases" | grep '"tag_name":' | sed -s 's/.*-\([0-9][0-9\.]*\).*/\1/' | grep -m1 ${K8S_VERSION})8,查看 Cluster Autoscaler 日志,确认部署成功,复制执行以下命令

kubectl -n kube-system logs -f deployment.apps/cluster-autoscaler9,您也可以通过命令autoscaling命令查看当前您的两个弹性扩展组状态。正常情况下,您现在拥有两个工作负载组,一个是onDemand的集群,最大节点数是1,一个是Spot的集群,最大值是4。当大规模负载发生时,会在Spot的集群进行扩容。平时的正常运行状态是1台Stop加2台onDemand

请将Value=='xxxx'的odoo替换为您的集群名称(默认为odoo),然后执行查看

aws autoscaling \

describe-auto-scaling-groups \

--query "AutoScalingGroups[? Tags[? (Key=='eks:cluster-name') && Value=='pre-production']].[AutoScalingGroupName, MinSize, MaxSize,DesiredCapacity]" \

--output table --region ap-southeast-1输出

-----------------------------------------------------------------------------------

| DescribeAutoScalingGroups |

+------------------------------------------------------------------+----+----+----+

| eks-pre-production-gnode1-b8c3ba17-d029-f1cb-839b-46478531d530 | 3 | 5 | 3 |

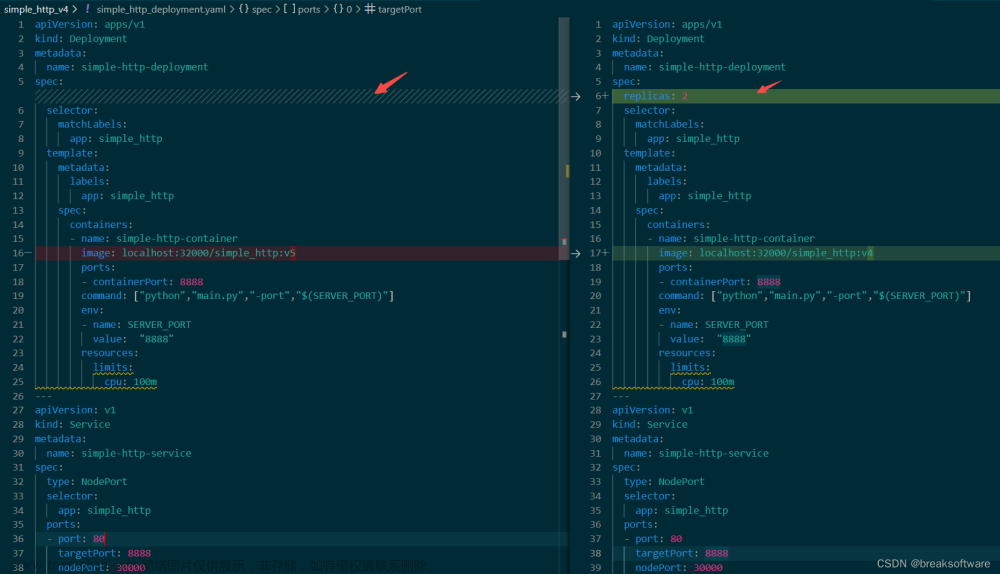

+------------------------------------------------------------------+----+----+----+10、部署测试应用,增加副本测试,或者并发压力测试

参考:

https://graviton2.awspsa.com/3-%E5%AE%9E%E9%AA%8C3%E9%85%8D%E7%BD%AEeks%E5%BC%B9%E6%80%A7%E9%9B%86%E7%BE%A4%E5%B9%B6%E8%BF%90%E8%A1%8C%E5%8E%8B%E5%8A%9B%E6%B5%8B%E8%AF%95.html文章来源:https://www.toymoban.com/news/detail-842950.html

https://blog.csdn.net/weixin_41335923/article/details/121486673文章来源地址https://www.toymoban.com/news/detail-842950.html

到了这里,关于EKS集群的弹性扩缩容CA的配置实战 ·『云原生品鉴与布道』·的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!