目录

前言

一、课题背景与意义

二、算法理论技术

2.1 双路金字塔网络

2.2 算法实现

三、模型训练

3.1 实验环境

3.2 结果分析

最后

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的危险驾驶(抽烟、打电话)检测系统

一、课题背景与意义

危险驾驶行为,如抽烟、打电话等,是导致交通事故的主要原因之一。传统的危险驾驶检测方法通常依赖于人工观察和交通摄像头监控,效果有限且受到主观因素的影响。通过实时监测和警示危险驾驶行为,驾驶员可以及时意识到自己的不当行为,并加以改善。这有助于提高驾驶员的安全意识和行为规范,减少交通事故的风险。可以推动深度学习技术在交通领域的应用,为其他相关领域提供借鉴和参考。

二、算法理论技术

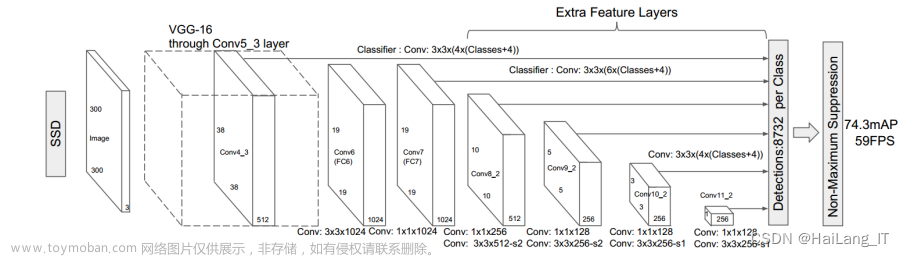

2.1 目标检测算法

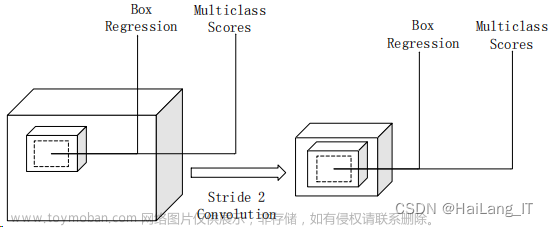

1.1 双路金字塔网络

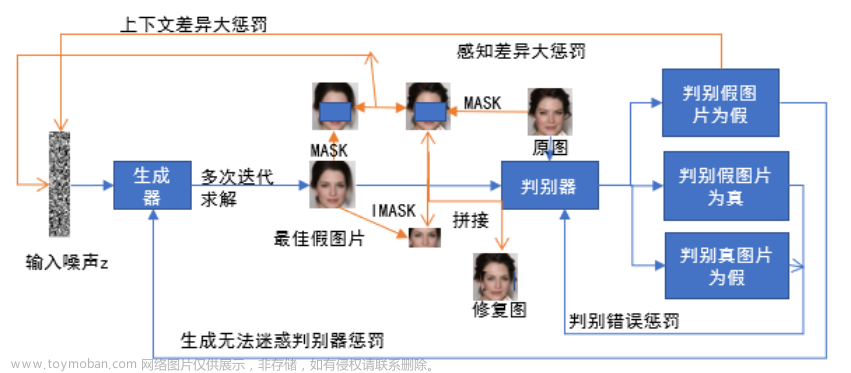

SIEDP是一种基于Faster R-CNN的双路金字塔网络,旨在增强浅层特征的细节和纹理信息。在ResNet FPN的基础上引入了图像金字塔结构,形成了双路金字塔(Double Pyramids, DP)结构。在特征融合之后,SIEDP还设计了空间信息增强(Spatial Information Enhancement, SIE)模块,受到Non-Local模块的启发。SIE模块通过两个分支分别捕获局部空间信息和全局空间信息,并在特征传递到FPN结构的过程中减少不相关区域和冗余信息的干扰。这样可以突出重点区域的信息,进一步提升特征提取的能力。

相关代码示例:

# 双路金字塔结构

def dual_pyramid_feature_extraction(image):

# 建立金字塔结构

pyramid1 = build_pyramid(image, levels=3)

pyramid2 = build_pyramid(image, levels=5)

# 提取浅层特征

features1 = []

for level in pyramid1:

feature = extract_features(level)

features1.append(feature)

# 提取深层特征

features2 = []

for level in pyramid2:

feature = extract_features(level)

features2.append(feature)

return features1, features2SIEDP通过引入双路金字塔结构和空间信息增强模块,对于浅层特征的细节和纹理信息进行增强,从而提升了目标检测的性能和精度。这种结构的应用可以在各种视觉任务中提供更准确和详细的特征表示,为计算机视觉领域的研究和应用带来了新的可能性。

相关代码示例:

# 空间信息增强模块

def spatial_enhancement(features1, features2):

enhanced_features = []

for i in range(len(features1)):

enhanced_feature = enhance_spatial_information(features1[i], features2[i])

enhanced_features.append(enhanced_feature)

return enhanced_features

# 目标检测主函数

def object_detection(image):

# 双路金字塔结构

features1, features2 = dual_pyramid_feature_extraction(image)

# 空间信息增强模块

enhanced_features = spatial_enhancement(features1, features2)

# 在增强后的特征上进行目标检测

detections = []

for feature in enhanced_features:

detection = detect_objects(feature)

detections.append(detection)

return detections为了解决直接将经过图像金字塔特征和骨干网络特征融合后的特征iO作为最终特征进行FPN操作时可能出现的冗余信息或不相关区域特征的干扰问题,SIEDP提出了空间信息增强(SIE)模块。在SIE模块中,首先将特征iO拆分为两个分支,分别用于学习局部空间信息和全局空间信息。局部分支通过池化和卷积操作进一步提取局部特征信息,而全局分支通过Non-Local模块提取特征图中任意位置之间的关联关系。然后,将这两个分支的特征进行堆叠(Concatenate)操作,以建立局部特征和全局特征之间的交互关系。这样做可以使网络更加聚焦于更重要的部分,减少冗余信息和不相关区域特征的干扰。

通过引入SIE模块,SIEDP能够增强细节纹理信息和语义信息,同时缓解由冗余信息或不相关区域特征引起的检测干扰。这样可以提高目标检测的性能和精度。

代码如下(示例):

# SIE模块

def spatial_information_enhancement(feature_io):

# 拆分为局部分支和全局分支

local_branch = pool_and_conv(feature_io)

global_branch = non_local_module(feature_io)

# 特征堆叠

enhanced_feature = concatenate(local_branch, global_branch)

return enhanced_feature

# 目标检测

def object_detection(image):

# 图像金字塔特征和骨干网络融合

feature_io = fusion(image)

# 空间信息增强模块

enhanced_feature = spatial_information_enhancement(feature_io)

# FPN操作

final_feature = fpn(enhanced_feature)

# 在最终特征上进行目标检测

detections = detect_objects(final_feature)

return detections2.2 算法实现

SINet在ROI Head部分将目标检测定义为一个图结构推理问题。它将物体建模为图中的点,并将物体之间的关系建模为图中的边。该方法利用物体在空间上的信息计算得到关系信息,并将关系信息、物体外观信息和场景信息共同输入到门控循环单元(GRU)进行时序记忆推断。一个物体的目标检测结果不仅取决于其细粒度的外观细节,还受到来自场景的视觉信息以及与其他物体的空间位置信息的影响。这种结构推理的方法使得目标检测模型能够更全面地考虑物体之间的关系,从而提升检测的准确性和鲁棒性。

在SINet的基础上,尝试去掉场景分支,并在关系分支中引入了结构聚类引导(SCG)模块,以对人物交互关系建模进行引导,形成了SCGNet。SCG模块通过对图中的情况进行聚类来引导网络学习抽烟和打电话的动作。在训练过程中,通过计算每对候选框与聚类中心点之间的距离,找出符合抽烟和打电话动作空间位置关系的类别。同时,对于不符合这几个类别的情况进行抑制。通过引入SCG模块,SCGNet能够在目标检测中更好地建模人物之间的交互关系,并通过结构聚类引导来指导网络学习特定动作。这种方法可以提高目标检测的准确性和鲁棒性。

代码如下(示例):

# SCGNet

class SCGNet(nn.Module):

def __init__(self, input_dim, num_classes):

super(SCGNet, self).__init__()

self.input_dim = input_dim

self.num_classes = num_classes

# 定义SCGNet中的其他网络层

self.backbone = ...

self.roi_head = ...

...

# 实例化SCG模块

self.scg_module = SCGModule(input_dim, num_classes)

def forward(self, input_images):

# 前向传播过程

backbone_features = self.backbone(input_images)

roi_features = self.roi_head(backbone_features)

scg_probs = self.scg_module(roi_features)

return scg_probs三、模型训练

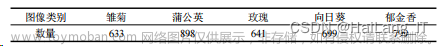

3.1数据处理

为了评估提出的网络结构对人、香烟和电话检测的有效性,我们构建了复杂场景下的抽烟打电话目标检测数据集。该数据集包括实验室提供的全景摄像头监控数据(加油站、收银台和化工厂场景)、网络上爬取的数据(新闻、日常拍摄和电影片段)以及开源数据集数据。数据集中的图像分辨率各异,人、香烟和电话的尺度变化较大。数据集的构建考虑了多样性和复杂性,为评估目标检测任务带来了挑战,以验证提出的网络结构对各类目标的检测效果。

在人的数据标注过程中,由于在不同的工程背景下,不同颜色制服的人代表着不同的职业或身份,因此我们将普通人统一定义为"person",而特殊工种的人则根据其着装的颜色来进行定义。

相关代码示例:

import numpy as np

def annotate_dataset(dataset_path, output_path):

# 加载数据集文件列表

image_files = glob.glob(dataset_path + "/*.jpg")

for image_file in image_files:

# 读取图像

image = cv2.imread(image_file)

# 进行目标检测和标注

# 这里需要根据具体任务和目标来进行目标检测算法的实现

# 并将检测到的目标位置和类别信息记录下来

# 根据目标位置和类别信息进行标注

for target in targets:

x, y, w, h = target['bbox']

label = target['label']

# 在图像上绘制边界框和标签

cv2.rectangle(image, (x, y), (x + w, y + h), (0, 255, 0), 2)

cv2.putText(image, label, (x, y - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.9, (0, 255, 0), 2)

# 保存标注后的图像

output_file = output_path + "/" + image_file.split("/")[-1]

cv2.imwrite(output_file, image)

print("标注完成!")3.2 实验环境

3.3 结果分析

进行了关键点选取方式的对比实验,分别比较了选择全部17个关键点和仅选择上半身的11个关键点的效果。仅利用上半身11个关键点的准确率也能达到89.8%。这表明在姿态分类任务中,选择上半身关键点进行特征提取已经足够有效,并且能够减少冗余信息对SVM分类器效果的影响。

SVM分类器完全根据关键点进行拟合,没有参考任何视觉特征。虽然对于数据集来说是误检,但它们仍然能起到辅助判断疑似目标的作用。同时,姿态估计的结果也间接证明了抽烟和打电话动作的识别不能只参考关键点特征,需要结合视觉特征进行综合判断。通过对误检图片的分析,我们可以得出以下结论:

- SVM分类器完全基于关键点进行拟合,没有考虑任何视觉特征。

- 除了特定情况(如d)外,其他误检情况在数据集中仍然有一定的辅助判断作用。

- 对于抽烟和打电话等动作的识别,不能仅仅依赖于关键点特征,需要结合视觉特征进行综合判断。

在面对类似于抽烟和打电话动作的"打哈欠"、"喝水"和"用手扶头"等动作时,并没有产生误检。通过可视化结果可以观察到,这类图片在SHOPR生成候选框阶段由于未检测到预定义的物体(如香烟或电话),因此不参与后续的动作交互推理,直接被过滤掉了。

通过可视化结果,我们可以得出以下结论:文章来源:https://www.toymoban.com/news/detail-845184.html

- 当人与已定义的物体有交集,但动作并不属于已定义的交互时,算法会将结果自动归属为未定义的交互,并以黄色虚线表示。

- 当人手拿手机但没有看向手机时,算法能准确地仅识别出hold动作。

- 类似于抽烟和打电话动作的"打哈欠"、"喝水"和"用手扶头"等动作,并没有被算法误检测。这是因为在SHOPR生成候选框阶段,由于未检测到预定义的物体,这类图片被直接过滤掉了。

文章来源地址https://www.toymoban.com/news/detail-845184.html

文章来源地址https://www.toymoban.com/news/detail-845184.html

最后

到了这里,关于毕业设计:基于深度学习的危险驾驶(抽烟、打电话)检测系统 人工智能 python 计算机视觉的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!