随着数字时代的来临,大数据技术成为了企业获取、存储、处理和分析海量数据的关键工具。大数据组件构建了一个庞大而强大的数据生态系统,为企业提供了更深入的洞察和更智能的决策支持。本文将深入解析一些重要的大数据组件,揭示它们在现代数据处理中的关键角色。

Hadoop生态系统

- Hadoop分布式文件系统(HDFS): HDFS是Hadoop的核心组件之一,用于存储大规模数据集。它将数据划分成块并分布在多个节点上,提供了高度容错性和可扩展性。

- MapReduce: MapReduce是Hadoop中用于处理和分析大规模数据集的编程模型。它将任务分解成Map和Reduce两个阶段,实现并行化处理,支持大规模数据的批处理。

- YARN(Yet Another Resource Negotiator): YARN是Hadoop的资源管理器,负责协调和管理集群中的计算资源。它使得多个应用程序可以共享集群资源,实现更高效的资源利用。

Apache Spark

- Spark Core: Spark是一个基于内存计算的大数据处理框架。Spark Core提供了任务调度、内存管理和容错机制等基础功能,支持在内存中进行快速而高效的数据处理。

- Spark SQL: 用于处理结构化数据的Spark模块。它提供了SQL查询的接口,允许用户通过SQL语句查询Spark中的数据,从而将SQL与Spark的强大分布式计算能力结合起来。

- Spark Streaming: 用于实时数据处理的Spark组件。它支持流式数据的实时处理和分析,使得企业能够更迅速地对不断涌入的数据做出反应。

- Spark MLlib: Spark的机器学习库,提供了丰富的机器学习算法和工具,使得在大规模数据集上进行机器学习任务变得更加便捷。

示例中提到的数据模板分享给大家——

https://s.fanruan.com/8j9is

零基础快速上手,还能根据需求进行个性化修改哦

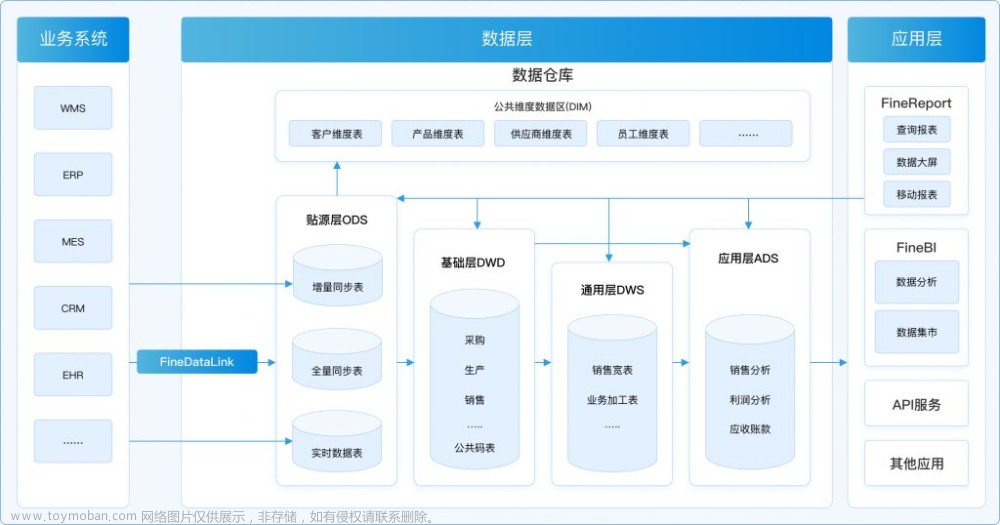

数据仓库和分析组件

- Apache Hive: 基于Hadoop的数据仓库工具,提供了类似SQL的查询语言(HiveQL),使得用户能够在Hadoop集群上执行数据分析。

- Apache HBase: 一个分布式的NoSQL数据库,用于实时读写大规模的结构化数据。HBase适用于需要快速访问和处理大量数据的场景。

- Apache Flink: 一种流处理框架,支持事件驱动和精确一次语义。Flink能够处理无界和有界的数据流,为实时数据分析和处理提供了强大支持。

- BI数据分析工具:BI工具是一类专门设计用于帮助企业收集、分析和可视化数据的软件工具。这些工具的主要目标是提供决策者和业务用户在业务运营和战略制定过程中所需的数据洞察。BI工具能够将庞大、复杂的数据集转化为直观、易于理解的图形和报表,帮助用户更好地理解业务状况,做出明智的决策。其中万能的实用工具强推帆软的FineBI。

文章来源:https://www.toymoban.com/news/detail-846776.html

文章来源:https://www.toymoban.com/news/detail-846776.html

数据集成和消息队列

- Apache Kafka: 一个高吞吐量的分布式消息队列系统,用于实时数据传输。Kafka能够持久化、分发和处理流式数据,成为构建实时数据管道的重要工具。

- Apache NiFi: 一个用于构建数据流的开源数据集成工具,支持数据采集、传输和处理。NiFi提供直观的图形化界面,使得用户能够轻松设计和管理数据流。

图处理和机器学习组件

- Apache Giraph: 用于大规模图数据处理的分布式计算系统。Giraph支持图的遍历和计算,适用于社交网络分析、推荐系统等场景。

- TensorFlow和PyTorch: 两个流行的开源机器学习框架,提供了灵活的工具和库,使得用户能够构建和训练各种深度学习模型。

结语

大数据组件构成了一个庞大而强大的生态系统,为企业提供了从数据存储、处理到分析的全方位解决方案。在日益增长的数据量和多样化的数据类型面前,这些组件的不断发展和创新将继续推动大数据技术的演进,为企业带来更多的机遇和挑战。通过深入了解这些组件的功能和特性,企业可以更好地选择适合其需求的工具,构建出更为高效、可靠的大数据处理平台。文章来源地址https://www.toymoban.com/news/detail-846776.html

到了这里,关于大数据组件有哪些?构建现代数据生态系统的组件一览的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!