本文仅是个人对该文章的阅读总结,并不能全篇概括作者的精华,还需大家详细阅读原文

---------------------------------------------------------------------------------------------------------------------------------

摘要

问题:模仿学习为教授机器人灵巧技能提供了一种高效途径,但是学习复杂的、具有普适性的技能通常需要大量的人类示范

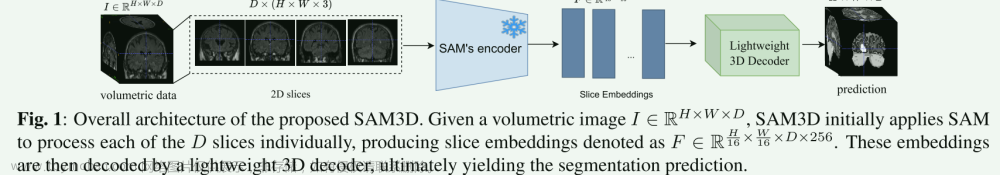

解决:3D扩散策略(DP3)将3D视觉表示的强大之处融入到扩散策略中,这是一类有条件的动作生成模型。

核心:利用高效的点编码器从稀疏点云中提取紧凑的3D视觉表示。

取得成果:

(1)在涉及 72 个模拟任务的实验中,DP3仅使用 10 个示范就成功处理了大多数任务,并且相对于基线方法取得了 55.3% 的相对改进。

(2)在 4 个真实机器人任务中,DP3仅使用每个任务 40 个示范就展示了精确控制,成功率高达 85%,并且在空间、视点、外观和实例等多个方面展现了出色的泛化能力。

(3)DP3很少违反安全要求。

方法

问题定义:

视觉运动策略 π : O → A

视觉观察 o ∈ O

动作 a ∈ A

DP3组成:

(1)Perception:DP3利用点云数据感知环境,并利用高效的点编码器将这些视觉观测结果处理成视觉特征;

(2)Decision:DP3利用了expressive Diffusion Policy 作为动作生成的支干,该策略根据我们的3D视觉特征生成动作序列。

A Motivating Example

证明DP3的泛化能力:

目标:让手持器准确的到达指定目标点

为了评估模仿学习算法不仅适应训练数据的有效性,还要泛化到新场景的能力,在3D空间中可视化了•训练点和•成功评估点

仅用五个训练点,DP3就能到达分布在3D空间中的点,展示了DP3在数据有限的情况下的优越泛化能力和效率。

Perception

DP3侧重于仅使用单视图摄像机对所有任务进行策略学习。

Representing 3D scenes with point clouds(点云表示)

- DP3采用稀疏点云作为三维表示,因为与(RGB-D、深度和体素)相比,点云更有效。

- 对于模拟和现实世界,从单个相机获得大小为84 × 84的深度图像。然后,使用相机外参和内参将深度转换为点云。为了获得更好的外观泛化效果,不使用彩色通道。

Point cloud processing(点云处理)

- 由于从深度转换而来的点云可能包含冗余点,因此需要裁剪掉这些点,仅保留在一个边界框内的点

- 通过最远点采样(FPS)对点进行降采样,这有助于充分覆盖 3D 空间,并减少了点云采样的随机性

- 将点云降采样至 512 或 1024 个点

Encoding point clouds into compact representations(将点云编码为紧凑的表示)

使用轻量级MLP网络将点云编码为紧凑的3D表示

Decision

Conditional action generation(条件动作生成)

- 该模型在三维视觉特征和机器人姿态 q 的条件下,将随机高斯噪声降噪为动作 a 。

Training objective(loss损失):

- 训练目标是预测添加到原始数据中的噪声

Implementation details(实现细节)

- 使用基于卷积网络的扩散策略

- 使用 DDIM 作为噪声调度器,并使用样本预测代替epsilon预测来更好地生成高维动作,训练时使用100个时间步,推理时使用10个时间步

- DP3和所有基线训练了3000个epoch,批大小为128,以确保所有任务的收敛性。

实验

Simulation benchmark

仿真与现实场景之间仍然存在显著差距

(1)真实机器人实验的重要性

(2)大规模多样化模拟任务的必要性 收集了7个领域的72个任务,涵盖了不同的机器人技能,(双手动操作、可变形对象操作、铰接对象操作、平行抓手操作)

Expert demonstrations:(这个地方没看懂,就直接全翻译过来,大家自己看吧....)

专家演示是由强化学习(RL)

- 算法训练的代理收集的,适用于除了 DexDeform 外的所有领域,其中我们使用人类远程操作的数据。

- 对于 Adroit,我们使用 VRL3 [67];

- 对于 MetaWorld,我们使用 BAC [29];

- 对于所有其他领域,我们使用 PPO [54]。

- 我们使用 RL 代理生成成功轨迹,并确保所有模仿学习算法使用相同的演示。

Baselines

- 这项工作的主要重点是强调3D模式在扩散政策中的重要性。

- baseline是于图像的扩散策略,简称为扩散策略

Evaluation metric:

对每个实验使用seeds号为 0、1、2 运行 3 个seeds。对于每个seeds,我们在每 200 个训练epochs次评估 20 个 episode,然后计算最高的 5 个成功率的平均值。我们报告了在 3 个seeds上成功率的平均值和标准差。

Efficiency and Effectiveness

在以下三个方面DP3表现出惊人的效率:

(1) High accuracy

- DP3在近30个任务中实现了超过90%的成功率

- 扩散策略在不到15个任务中实现了超过90%的成功率

- DP3没有记录任何成功率低于10%的任务

- 扩散策略有超过10个成功率低于10%的任务

(2) Learning efficiency

虽然每个任务都训练了3000个epoch,但是观察发现DP3在所有任务大概300 epoch已经达到收敛 相反,扩散策略倾向于以慢得多的速度收敛或收敛到次优结果。

(3) Efficient scaling with demonstrations

- 在Adroit任务中,DP3和扩散策略都执行合理,而DP3在较少的演示中达到了相当的精度。

- 在简单的MetaWorld任务中,即使演示次数增加,扩散策略也无法学习,明显落后于DP3

(4) Competitive inference speed

DP3实现的推理速度略微超过扩散策略,这主要归功于使用稀疏点云和紧凑的3D表示。

消融实验

选择了6个任务进行消融实验:

Adroit [ Hammer (H), Door (D), Pen (P) ];

MetaWorld [ Assembly (A), Basketball (B), Shelf Place (S) ]

这些任务包括高维和低维控制任务,每个任务只使用10个演示

实验1:不同表示之间的对DP3的影响

实验2:point cloud 编码器选择

实验3:DP3设计

(a) 对点云进行裁剪在很大程度上提高了准确性;

(b) 整合 LayerNorm 层可以帮助稳定不同任务之间的训练;

(c) 在噪声采样器中进行样本预测可以加快收敛速度;

(d) DP3 编码器中的投影头通过将特征投影到较低维度加速了推断,而不会影响准确性;

(e) 移除颜色通道确保了鲁棒的外观泛化;

(f) 在低维控制任务中,作为噪声采样器的 DPM-solver++ 与 DDIM 竞争力相当,而 DPMsolver++ 不能很好地处理高维控制任务。

实验4:Training policies on demonstrations from different experts.

我们希望研究专家的行为方式是否会影响模仿学习方法的性能。为此,我们分别在 MetaWorld 任务中使用 RL 训练的代理和脚本策略生成演示,并在这些演示上进行训练。我们可以观察到,一个更好的专家通常能够帮助使用模仿学习算法训练出更好的策略,但 DP3 与地面真值专家之间仍然存在差距。

实验5:不同的图片分辨率对扩散策略的影响

真实场景实验可以之间看论文,这里就不针对该章节,进行详细描述了

结论

- 介绍了 3D Diffusion Policy(DP3),这是一种高效的视觉模仿学习算法,使用少量示范就能够在模拟和真实环境中管理各种机器人任务。

- DP3 的核心在于将精心设计的 3D 表示与扩散策略的表现力相结合。

- 在 72 个模拟任务中,DP3 的表现优于其 2D 对应物,相对边际提高了 55.3%。

- 在真实环境中,DP3 在使用 Allegro 手执行可变形物体的复杂操作时表现出高准确性。

- 证明了 DP3 具有对各个方面的强大泛化能力,并在真实环境中造成的安全违规较少。

局限

尽管已经开发了一种高效的架构,但控制的最佳 3D 表示仍然有待发现。此外,本文未深入探讨具有极长视角的任务,这留给未来的探索。(未来继续加油)

---------------------------------------------------------------------------------------------------------------------------------

论文地址:

https://arxiv.org/abs/2403.03954

Github:(作者的github写的非常详细,常见错误的解决方法都写出来了)

GitHub - YanjieZe/3D-Diffusion-Policy: [arXiv 2024] 3D Diffusion Policy

项目地址:文章来源:https://www.toymoban.com/news/detail-847867.html

3D Diffusion Policy文章来源地址https://www.toymoban.com/news/detail-847867.html

到了这里,关于《3D Diffusion Policy》论文阅读的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文笔记] chatgpt——PPO算法(Proximal Policy Optimization)](https://imgs.yssmx.com/Uploads/2024/02/428566-1.png)

![[论文笔记] chatgpt系列 1.1 PPO算法(Proximal Policy Optimization)](https://imgs.yssmx.com/Uploads/2024/02/438457-1.png)