Stable Diffusion是一种前沿的开源深度学习模型框架,专门设计用于从文本描述生成高质量的图像。这种称为文本到图像生成的技术,利用了大规模变换器(transformers)和生成对抗网络(GANs)的力量,以创建与给定文本提示相一致的图像。

以下是一些关于Stable Diffusion的关键点:

1. 模型架构:

它通常包括变换器架构的一个变体,如视觉变换器(Vision Transformer, ViT)用于编码图像,以及一个语言模型用于编码文本提示。像这样的模型在训练时会使用多样化的数据集,使得生成广泛种类的图像成为可能。

2. 隐空间扩散:

Stable Diffusion模型通常在一个隐空间工作,而不是直接操作像素。这包括在扩散过程中将图像转换为一个低维度、压缩的表示,然后逐步迭代地添加细节以生成最终图像。

3. 大规模训练:

此类模型在非常大的图像-文本配对数据集上进行训练。训练期间,模型学习文本描述与视觉特征之间的复杂关系。

4. 质量和多样性:

通过Stable Diffusion模型生成的图像以其高质量以及模型生成各种各样图像的能力而出名,从逼真的渲染图像到不同风格的艺术作品,仅靠文本描述即可实现。

5. 控制与定制:

你可以通过调整文本提示来引导图像生成过程。此外,用户通常可以通过各种设置来定制生成过程,这些设置可以影响生成图像的外观、风格和内容。

6. 应用:

除了生成艺术品和插图之外,Stable Diffusion还可以用于机器学习的数据增强、视觉叙事、数字营销的内容创建等任务。

7. 伦理考虑和限制:

像许多AI技术一样,有一些重要的伦理考虑问题。包括版权问题、代表性问题,以及在生成深伪造或其他形式的虚假信息方面的潜在滥用问题。

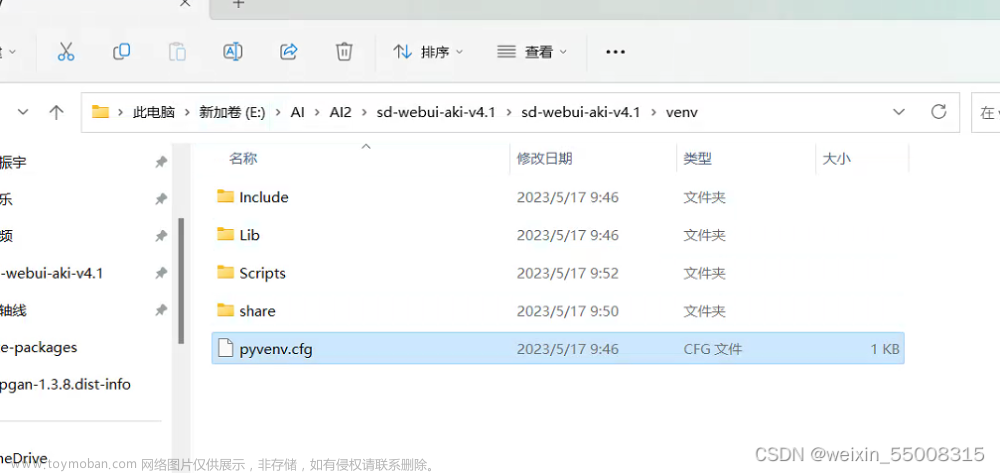

8. 社区与发展:

Stable Diffusion模型的开发通常是协作的,涉及研究人员、开发人员和创意工作者的贡献。开源的特性意味着,随着社区对技术进行试验和构建,改进以及应用可以迅速发展。

9. 面向公众的易用性:

像Stable Diffusion这样的工具使得高效的图像生成技术的使用民主化,允许技术和非技术用户在没有广泛的图形专业知识的情况下创造复杂的视觉内容。

Stable Diffusion是AI研究领域中快速增长的一部分,专注于创造和生成任务。它与OpenAI的DALL-E和Google的Imagen等其他著名模型站在了推动机器学习驱动内容创作边界的前沿。

Stable Diffusion is a state-of-the-art, open-source deep learning framework designed for generating high-quality images from textual descriptions. This technique, known as text-to-image generation, leverages the power of large-scale transformers and generative adversarial networks to create images that are aligned with given text prompts.

Here are some key points about Stable Diffusion:

1. Model Architecture: It often consists of a variant of the transformer architecture known as Vision Transformer (ViT) for encoding images and a language model for encoding text prompts. Models like these are trained on diverse datasets allowing the generation of a wide range of images.

2. Latent Diffusion: Instead of directly manipulating pixels, Stable Diffusion models typically work in a latent space. This involves transforming images into a lower-dimensional, compressed representation before using the diffusion process to add detail iteratively to generate the final image.

3. Large-scale Training: Such models are trained on very large datasets of image-text pairs. During training, the model learns the complex relationships between text descriptions and visual features.

4. Quality and Versatility: The images generated by Stable Diffusion models are known for their high quality and the model's ability to generate a wide variety of images, from photorealistic renderings to artwork in different styles, based solely on textual descriptions.

5. Control and Customization: You can guide the image generation process by adjusting your text prompt. Furthermore, users can often customize the generation process through various settings that can influence the appearance, style, and content of the generated images.

6. Applications: Beyond generating art and illustrations, Stable Diffusion can be used for tasks like data augmentation for machine learning, visual storytelling, content creation for digital marketing, and more.

7. Ethical Considerations and Limitations: As with many AI technologies, there are important ethical considerations. These include concerns about copyright, representation, and the potential for misuse in generating deepfakes or other forms of disinformation.

8. Community and Development: The development of Stable Diffusion models is often collaborative, involving contributions from researchers, developers, and creatives. The open-source nature means that improvements, as well as applications, can evolve quickly as the community experiments with and builds upon the technology.

9. Accessible to the Public: Tools like Stable Diffusion democratize access to powerful image generation technologies, allowing both technical and non-technical users to create complex visual content without extensive graphical expertise.文章来源:https://www.toymoban.com/news/detail-848287.html

Stable Diffusion is part of a rapidly growing field of AI research focusing on creative and generative tasks. It stands alongside other notable models like OpenAI's DALL-E and Google's Imagen in pushing the boundaries of what's possible with machine learning-driven content creation. 文章来源地址https://www.toymoban.com/news/detail-848287.html

到了这里,关于Stable Diffusion介绍的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!