美国AI初创公司Databricks公布,在语言理解、编程和数学方面,其将开源的模型DBRX的测试得分均高于GPT-3.5、Mixtral、Meta的Llama 2-70B、马斯克旗下xAI的Grok-1。作为混合专家模型,DBRX的输出token速度高Llama 2一筹。

全球最强大的开源人工智能大语言模型将要易主

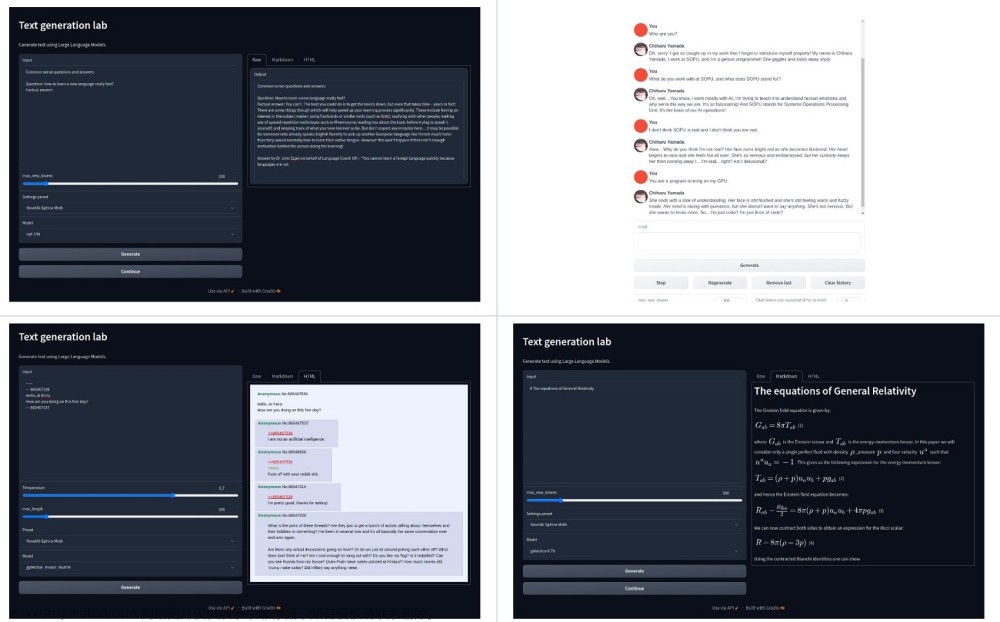

美国AI初创公司Databricks加州当地时间3月27日周三公布,该司Mosaic Research团队开发的通用LLM DBRX将开源。DRBX由Databricks耗时几个月、投入约1000万美元训练打造,设计类似于OpenAI的ChatGPT。Databricks将根据一种开源许可证发布DBRX。

模型综合表现

Databricks的首席神经网络架构师兼开发DBRX团队负责人Jonathan Frankle声称,DBRX超越了其他任何开源模型。他分享的数据显示,包括回答一般知识问题、进行阅读理解、解决逻辑难题和生成高质量代码等在内,在衡量AI模型能力的约十几个基准测试中,DBRX的表现都优于现有的一切开源模型。

Databricks在公司博客文章中介绍,DBRX在语言理解、编程、数学和逻辑方面轻松击败了Meta的Llama 2-70B、法国MixtralAI公司的Mixtral 和 马斯克旗下xAI开发的Grok-1这类当前流行的开源模型。Databricks的开源基准指标 Gauntlet 包含了30 多种不同的最先进模型(SOTA) 基准指标测试,DBRX的测试性能均优于前述三种大模型。

模型性能分析

下图可见,在语言理解方面,DBRX的分值为73.7%,高于GPT-3.5的70.0%;在编程能力方面,DBRX的得分70.1%远超GPT-3.5的48.1%,在数学方面,DBRX的得分66.9%也高于GPT-3.5的57.1%。

DBRX的大多数基准指标表现也强于GPT-3.5

Databricks认为,这点很重要,因为上个季度该司发现,1.2万余名客户的行为发生了重大转变。企业和组织越来越多地用开源模型取代专有模型提高效率和控制力。根据Databricks的经验,许多客户可以通过根据特定的任务定制开源模型,这种量身定制的模型在质量和速度方面都能超越专有模型。

模型的语言理解能力

下图可见,在语言理解方面,DBRX的分值为73.7%,高于Llama 2-70B的69.8%、Mixtral的71.4%和Grok-1的73.0%;在编程能力方面,DBRX的得分70.1%远超Llama 2-70B的32.3%、Mixtral的54.8%和Grok-1的63.2%,在数学方面,DBRX的得分为66.9%,也高于Llama 2-70B的54.1%、Mixtral的61.1%和Grok-1的62.9%。

Databricks介绍,DBRX 是一个基于 MegaBlocks 研究和开源项目构建的混合专家模型(MoE),因此每秒输出token的速度极快。Databricks相信,这将为 MoE 未来最先进的开源模型铺平道路。因为 MoE 本质上可以让用户训练更大的模型,并以更快的吞吐量提供服务。DBRX在任何给定时间内仅使用 360亿个参数。但模型本身有 1320 亿个参数,在速度(token/秒)与性能(质量)方面可以鱼与熊掌兼得。

下图可见DBRX和Llama 2-70B在收到编程方面具体任务指令时的反馈对比,DBRX的反应速度,即输出token超过了Llama 2-70B。

行业评论

有评论认为,在目前生成式AI热潮中最富盛名的那些公司兑他们LLM的代码严格保密,比如OpenAI和谷歌,DBRX开源意味着,Databricks为挑战这种做法的努力添了一把火。文章来源:https://www.toymoban.com/news/detail-848468.html

Databricks 表示,还希望公开创建其开源模型所涉及的工作。这比开源大模型的Meta更进一步。Meta迄今尚未公开创建Llama 2 模型的一些关键细节。文章来源地址https://www.toymoban.com/news/detail-848468.html

到了这里,关于全球最强开源AI大模型来了!Databricks称DBRX吊打Llama 2和GPT-3.5的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!