大数据技术原理与应用 课程实验报告 熟悉HDFS常用操作

附件中有word版本的实验报告

实验目的:

- 理解HDFS在Hadoop体系结构中的角色。

- 熟练使用HDFS操作常用的Shell命令。

- 熟悉HDFS操作常用的Java API。

实验环境:

- Oracle VM VirtualBox虚拟机

- 系统版本centos7

- JDK1.8版本

- Hadoop-3.1.3

- Windows11

- Java IDE:IDEA

实验内容与完成情况:

一、 利用Hadoop提供的Shell命令完成下列任务

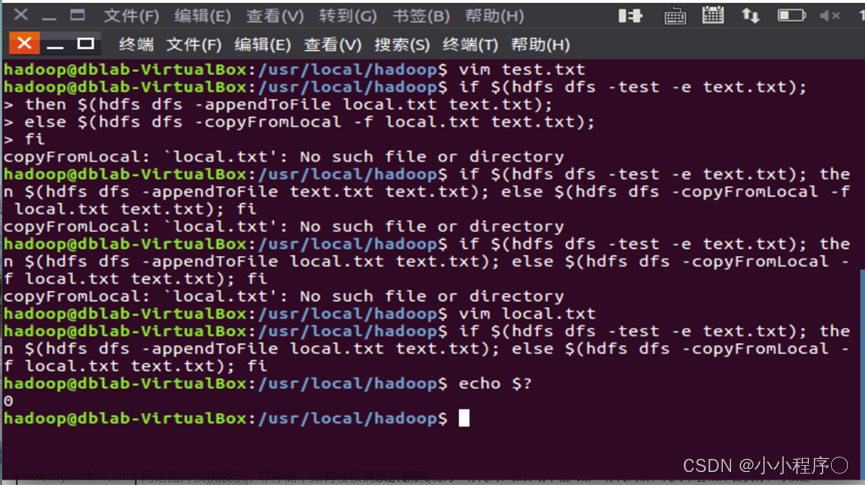

1.向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,由用户指定是追加到原有文件末尾还是覆盖原有的文件。

2.从HDFS中下载指定文件,如果本地文件与要下载的文件名称相同,则自动对下载的文件重命名。

3.将HDFS中指定文件的内容输出到终端中。

4.显示HDFS中指定的文件的读写权限、大小、创建时间、路径等信息;执行下列命令。

5.给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息。

6.提供一个HDFS内的文件的路径,对该文件进行创建和删除操作。如果文件所在目录不存在,则自动创建目录。

7.提供一个HDFS的目录的路径,对该目录进行创建和删除操作。创建目录时,如果目录文件所在目录不存在则自动创建相应目录;删除目录时,由用户指定当该目录不为空时是否还删除该目录。

8.向HDFS中指定的文件追加内容,由用户指定将内容追加到原有文件的开头或结尾。

9.删除HDFS中指定的文件。

10.在HDFS中,将文件从源路径移动到目的路径。

二、 编程实现一个类“MyFSDataInputStream”,该类继承“org.apache.hadoop.fs.FSDataInputStream”,要求如下:

(1) 实现按行读取HDFS中指定文件的方法“readLine()”,如果读到文件末尾,则返回空,否则返回文件一行的文本。

(2) 实现缓存功能,即利用“MyFSDataInputStream”读取若干字节数据时,首先查找缓存,如果缓存中有所需数据,则直接由缓存提供,否则从HDFS中读取数据。

package Main;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

public class main extends FSDataInputStream {

public main(InputStream in) {

super(in);

}

/**

* 实现按行读取 每次读入一个字符,遇到"\n"结束,返回一行内容

*/

public static String readline(BufferedReader br) throws IOException {

char[] data = new char[1024];

int read = -1;

int off = 0;

// 循环执行时,br 每次会从上一次读取结束的位置继续读取

// 因此该函数里,off 每次都从 0 开始

while ((read = br.read(data, off, 1)) != -1) {

if (String.valueOf(data[off]).equals("\n")) {

off += 1;

break;

}

off += 1;

}

if (off > 0) {

return String.valueOf(data);

} else {

return null;

}

}

/**

* 读取文件内容

*/

public static void cat(Configuration conf, String remoteFilePath) throws IOException {

FileSystem fs = FileSystem.get(conf);

Path remotePath = new Path(remoteFilePath);

FSDataInputStream in = fs.open(remotePath);

BufferedReader br = new BufferedReader(new InputStreamReader(in));

String line = null;

while ((line = main.readline(br)) != null) {

System.out.println(line);

}

br.close();

in.close();

fs.close();

}

/**

* 主函数

*/

public static void main(String[] args) {

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://localhost:8020");

String remoteFilePath = "/user/input/test.txt"; // HDFS 路径

try {

main.cat(conf, remoteFilePath);

} catch (Exception e) {

e.printStackTrace();

}

}

}

三、 查看Java帮助手册或其它资料,用“java.net.URL”和“org.apache.hadoop.fs.FsURLStreamHandlerFactory”编程完成输出HDFS中指定文件的文本到终端中

package Main;

import java.io.InputStream;

import java.net.URL;

import org.apache.hadoop.fs.FsUrlStreamHandlerFactory;

import org.apache.hadoop.io.IOUtils;

public class main {

static {

URL.setURLStreamHandlerFactory(new FsUrlStreamHandlerFactory());

}

/**

* 主函数

*/

public static void main(String[] args) throws Exception {

String remoteFilePath = "hdfs:///user/input/test.txt"; // HDFS 文件

InputStream in = null;

try {

/* 通过 URL 对象打开数据流,从中读取数据 */

in = new URL(remoteFilePath).openStream();

IOUtils.copyBytes(in, System.out, 4096, false);

} finally {

IOUtils.closeStream(in);

}

}

}

出现的问题

问题一

在使用 Hadoop jar untuil.jar 运行jar文件时,出现无法连接hadoop的情况

网上有的说法是因为hadoop系统配置有问题,通过

发现hadoop运行正常

问题二

发现在代码中使用的是9000端口.查看本机配置的core文件中是8020

修改代码后仍无法运行

发现core配置文件中的ip为定义的路径server:8020

直接将路径改为127.0.0.1:8020 文章来源:https://www.toymoban.com/news/detail-848533.html

文章来源:https://www.toymoban.com/news/detail-848533.html

运行成功文章来源地址https://www.toymoban.com/news/detail-848533.html

到了这里,关于大数据实验 实验二:熟悉HDFS常用操作的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!