数据解析-正则表达式

在前面我们已经搞定了怎样获取页面的内容,不过还差一步,这么多杂乱的代码夹杂文字我们怎样

把它提取出来整理呢?下面就开始介绍一个十分强大的工具,正则表达式!

正则表达式是对字符串操作的一种逻辑公式,就是用事先定义好的一些特定字符、及这些特定字符的组合,组成一个“规则字符串”,这个“规则字符串”用来表达对字符串的一种过滤逻辑。

正则表达式是用来匹配字符串非常强大的工具,在其他编程语言中同样有正则表达式的概念,

Python同样不例外,利用了正则表达式,我们想要从返回的页面内容提取出我们想要的内容就易如

反掌了。

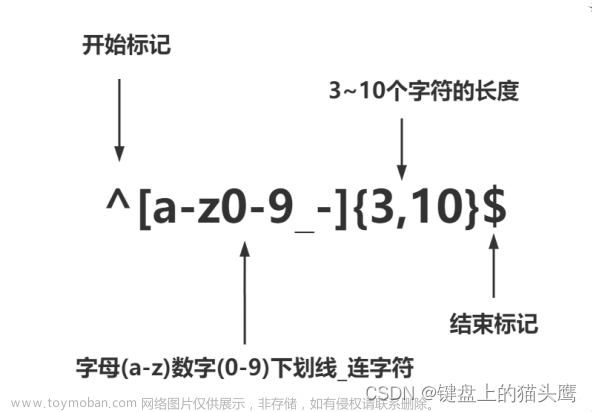

规则

定位符

| 字 符 | 描 述 |

|---|---|

| ^ | 匹配输入字符串开始的位置。如果设置了 RegExp 对象的 Multiline属 性,^ 还会与 \n 或 \r之后的位置匹配。 |

| $ | 匹配输入字符串结尾的位置。如果设置了 RegExp 对象的 Multiline 属性,$ 还会与 \n 或 \r之前的位置匹配。 |

| \b | 匹配一个单词边界,即字与空格间的位置。 |

| \B | 非单词边界匹配。 |

注意

不能将限定符与定位符一起使用

普通字符

| 字符 | 描述 |

|---|---|

| [ABC] | 匹配 [...] 中的所有字符,例如 [aeiou] 匹配字符串 "google runoob taobao" 中所有的e o u a 字母 |

| [^ABC] | 匹配除了 [...] 中字符的所有字符,例如 [^aeiou] 匹配字符串 "google runoob taobao"中除了 e o u a 字母的所有字母 |

| [A-Z] | [A-Z] 表示一个区间,匹配所有大写字母,[a-z] 表示所有小写字母 |

| . | 匹配除换行符(\n、\r)之外的任何单个字符,相等于 [^\n\r] |

| [\s\S] | 匹配所有。\s 是匹配所有空白符,包括换行,\S 非空白符,不包括换行 |

| \w | 匹配字母、数字、下划线。等价于 [A-Za-z0-9_] |

特 殊字符

| 特 别 字 符 | 描 述 |

| ( ) | 标记一个子表达式的开始和结束位置。子表达式可以获取供以后使用。要匹配这些字符,请使用 ( 和 )。 |

| [ | 标记一个中括号表达式的开始。要匹配 [,请使用 \[ 。 |

| ? | 匹配前面的子表达式零次或一次,或指明一个非贪婪限定符。要匹配 ? 字符,请使用 \?。 |

| \ | 将下一个字符标记为或特殊字符、或原义字符、或向后引用、或八进制转义符。例如, 'n'匹配字符 'n'。'\n' 匹配换行符。序列 '\' 匹配 "",而 '(' 则匹配 "("。 |

| { | 标记限定符表达式的开始。要匹配 {,请使用 \{ 。 |

| | | 指明两项之间的一个选择。要匹配 |,请使用 \| 。 |

非打印字符

| 字 符 | 描 述 |

| \cx | 匹配由x指明的控制字符。例如, \cM 匹配一个 Control-M 或回车符。x 的值必须为 A-Z 或a-z 之一。否则,将 c 视为一个原义的 'c' 字符。 |

| \f | 匹配一个换页符。等价于 \x0c 和 \cL |

| \n | 匹配一个换行符。等价于 \x0a 和 \cJ。 |

| \r | 匹配一个回车符。等价于 \x0d 和 \cM |

| \s | 匹配任何空白字符,包括空格、制表符、换页符等等。等价于 [ \f\n\r\t\v]。注意 Unicode正则表达式会匹配全角空格符。 |

| \S | 匹配任何非空白字符。等价于 [^ \f\n\r\t\v] |

| \t | 匹配一个制表符。等价于 \x09 和 \cI |

| \v | 匹配一个垂直制表符。等价于 \x0b 和 \cK |

限定符

| 字 符 | 描 述 |

| * | 匹配前面的子表达式零次或多次。例如,zo* 能匹配 "z" 以及 "zoo"。* 等价于{0,}。 |

| + | 匹配前面的子表达式一次或多次。例如,'zo+' 能匹配 "zo" 以及 "zoo",但不能匹配"z"。+ 等价于 {1,}。 |

| ? | 匹配前面的子表达式零次或一次。例如,"do(es)?" 可以匹配 "do" 、 "does" 中的 "does"、 "doxy" 中的 "do" 。? 等价于 {0,1}。 |

| {n} | n 是一个非负整数。匹配确定的 n 次。例如,'o{2}' 不能匹配 "Bob" 中的 'o',但是能匹配 "food" 中的两个 o。 |

| {n,} | n 是一个非负整数。至少匹配n 次。例如,'o{2,}' 不能匹配 "Bob" 中的 'o',但能匹配 "foooood" 中的所有 o。'o{1,}' 等价于 'o+'。'o{0,}' 则等价于 'o*'。 |

| {n,m} | m 和 n 均为非负整数,其中n <= m。最少匹配 n 次且最多匹配 m 次。例如,"o{1,3}"将匹配 "fooooood" 中的前三个 o。'o{0,1}' 等价于 'o?'。请注意在逗号和两个数之间不能有空格。 |

数量词的贪婪模式与非贪婪模式

正则表达式通常用于在文本中查找匹配的字符串

Python里数量词默认是贪婪的(在少数语言里也可能是默认非贪婪),总是尝试匹配尽可能多的字

符;

非贪婪的则相反,总是尝试匹配尽可能少的字符

例如:正则表达式”ab”如果用于查找”abbbc”,将找到”abbb”。而如果使用非贪婪的数量词”ab?”,

将找到”a”

正则表达式修饰符 - 可选标志

正则表达式可以包含一些可选标志修饰符来控制匹配的模式。

修饰符被指定为一个可选的标志。多个标志可以通过按位 OR(|)

它们来指定。如 re.I | re.M 被设置成 I 和 M 标志:

| 修 饰 符 | 描 述 |

| re.I | 使匹配对大小写不敏感 |

| re.L | 做本地化识别(locale-aware)匹配 |

| re.M | 使边界字符 ^ 和 $ 匹配每一行的开头和结尾,记住是多行,而不是整个字符串的开头和结尾 |

| re.S | 使 . 匹配包括换行在内的所有字符 |

| re.U | 根据Unicode字符集解析字符。这个标志影响 \w, \W, \b, \B |

| re.X | 该标志通过给予你更灵活的格式以便你将正则表达式写得更易于理解 |

正则表达式在线测试 | 菜鸟工具 (runoob.com)

https://c.runoob.com/front-end/854/

Python使用正则

常用方法

- re.match(pattern, string, flags=0)

re.match 尝试从字符串的起始位置匹配一个模式,如果不是起始位置匹配成功的话,match()

就返回none

- re.search(pattern, string, flags=0)

re.search 扫描整个字符串并返回第一个成功的匹配。

- re.findall(pattern,string,flags=0)

re.findall 查找全部文章来源:https://www.toymoban.com/news/detail-848739.html

- re.sub(pattern,replace,string)

re.sub 替换字符串文章来源地址https://www.toymoban.com/news/detail-848739.html

import re

str ='I study python3.10 every_day'

print('----------------------match(规则,内容)-

----------------------------') # 从头开始匹配,

如果匹配上了返回值,如果匹配不上,返回none

m1 = re.match('I',str)

m2 = re.match('\w',str)

m3 = re.match('\S',str)

m4 = re.match('\D',str)

m5 = re.match('I (study)',str)

m6 = re.match('\w\s(\w*)',str)

print(m6.group(1))

print('----------------------search(规则,内

容)-----------------------------') # 从任意位

置开始匹配,,如果匹配上了返回值,如果匹配不上,返回

none

s1 = re.search('I',str)

s2 = re.search('study',str)

s3 = re.search('p\w+',str)

s4 = re.search('p\w+.\d+',str)

print(s4.group())

print('----------------------findall(规则,内

容)-----------------------------') # 从任意位

置开始匹配,返回所有匹配的数据,如果没有匹配内容,返

回一个空列表

f1 = re.findall('ddy',str)

print(f1)

print('----------------------sub(规则,替换的内

容,内容)-----------------------------') # 替换

原来的数据,并返回一个新的字符串,不会修改原来的字符

串

print(re.sub('p\w+','Python',str))

print(str)

print('----------------------test()---------

--------------------')

info = '<html><div><a

href="http://www.itbaizhan.cn">百战程序员</a>

</div></html>'

tf = re.findall('<a href="(.+)">',info)

tf2 = re.findall('<a href=".+">(.+)

</a>',info)

print(tf2)

到了这里,关于Day:004(1) | Python爬虫:高效数据抓取的编程技术(数据解析)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!