规避检测

1.介绍

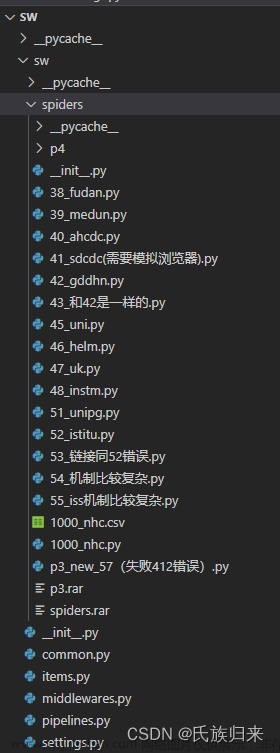

我们在使用Python Selenium进行自动化测试或爬虫时,有时会遇到被网站检测到并阻止的情况。这些网站通常会使用各种技术手段来检测和阻止自动化脚本,例如检测浏览器指纹、检查页面元素是否被自动化程序操作、检测用户行为模式等。本文将介绍一些常见的技术手段,以及如何利用Python Selenium来绕过这些检测。文章来源:https://www.toymoban.com/news/detail-849010.html

2.常见的检测手段

-

检测浏览器指纹

浏览器指纹是文章来源地址https://www.toymoban.com/news/detail-849010.html

到了这里,关于selenium绕过检测,规避检测的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!