kafka的基础概念

-

Producer (消息生产者)

向主题发布消息的客户端应用程序称为生产者(Producer),生产者用于持续不断的向某个主题发送消息。 -

Consumer (消息消费者)

订阅主题消息的客户端程序称为消费者(Consumer),消费者用于处理生产者产生的消息。 -

Consumer Group (消费者组)

每个消费者属于一个特定的消费者群组(可为每个消费者指定group name,若不指定group name则属于默认的group)。

每个消费者群组都有一个唯一的GroupId。

- Brokers(kafka服务器)

一个独立的 Kafka 服务器就被称为 broker,broker 接收来自生产者的消息,为消息设置偏移量,并提交消息到磁盘保存。

一个broker可以容纳多个topic。每个broker都有各自的broker.id。

- Topics(主题)

消息的种类称为 主题(Topic),可以说一个主题代表了一类消息。相当于是对消息进行分类。

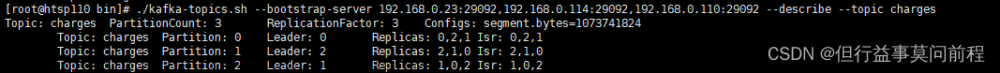

- Partition(分区)

主题(Topic)可以被分为若干个分区(partition),同一个主题中的分区可以不在一个机器上,有可能会部署在多个机器上,

由此来实现 kafka 的伸缩性,单一主题中的分区有序,但是无法保证主题中所有的分区有序。

安装kafka,创建 topic:

Windows安装kafka, 详情见:https://blog.csdn.net/sinat_32502451/article/details/133067851

Linux 安装kafka,详情见:https://blog.csdn.net/sinat_32502451/article/details/133080353

添加依赖包:

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

<version>2.1.10.RELEASE</version>

</dependency>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.0.0</version>

</dependency>

kafka生产者示例:

按以下步骤发送消息:

- 设置 broker服务器的ip和端口

- 生产者初始化

- 发送消息

public class KafkaDemoProducer {

public static final String BROKER_LIST = "localhost:9092";

public static final String TOPIC = "myTopic1";

public static void main(String[] args) {

//属性配置

Properties properties = getProperties(BROKER_LIST);

//生产者初始化

KafkaProducer<String, String> producer = new KafkaProducer<>(properties);

ProducerRecord<String, String> record = new ProducerRecord<>(TOPIC, "hello kafka");

//发送消息

try {

producer.send(record);

} catch (Exception e) {

System.out.println("send error." + e);

}

producer.close();

}

private static Properties getProperties(String brokerList) {

Properties properties = new Properties();

properties.put("key.serializer",

"org.apache.kafka.common.serialization.StringSerializer");

properties.put("value.serializer",

"org.apache.kafka.common.serialization.StringSerializer");

properties.put("bootstrap.servers", brokerList);

return properties;

}

}

kafka消费者示例:

主要按照以下步骤:

-

设置 broker服务器的ip和端口, 设置 消费者群组id

-

初始化消费者

-

消费者订阅主题

-

消费者批量拉取消息

public class KafkaDemoConsumer {

public static final String BROKER_LIST = "localhost:9092";

public static final String TOPIC = "myTopic1";

public static final String GROUP_ID = "group.demo";

public static void main(String[] args) {

consumerRecord();

}

public static void consumerRecord() {

//属性配置

Properties properties = getProperties(BROKER_LIST, GROUP_ID);

//消费者初始化

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

//消息者订阅主题

consumer.subscribe(Collections.singletonList(TOPIC));

//循环

while (true) {

//每次拉取 1千条消息

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(1000));

for (ConsumerRecord<String, String> record : records) {

System.out.println("=============> 消费kafka消息:"+ record.value());

}

}

}

public static Properties getProperties(String brokerList, String groupId) {

Properties properties = new Properties();

//序列化

properties.put("key.deserializer",

"org.apache.kafka.common.serialization.StringDeserializer");

properties.put("value.deserializer",

"org.apache.kafka.common.serialization.StringDeserializer");

//broker服务器的ip和端口,多个用逗号隔开

properties.put("bootstrap.servers", brokerList);

//消费者群组id

properties.put("group.id", groupId);

return properties;

}

}

观察idea 控制台,可以看到 成功消费了消息:

=============> 消费kafka消息:hello kafka

kafka入门文章

https://blog.csdn.net/sinat_32502451/category_12465196.html文章来源:https://www.toymoban.com/news/detail-849183.html

参考资料:

《深入理解kafka 核心设计与实践原理》

kafka的简单理解文章来源地址https://www.toymoban.com/news/detail-849183.html

到了这里,关于kafka入门(一):kafka消息发送与消费的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!