1.背景介绍

奇异值分解(Singular Value Decomposition, SVD)和矩阵逆(Matrix Inverse)是线性代数和数值分析领域中非常重要的概念和方法。这两者在现实生活中的应用非常广泛,例如图像处理、信号处理、数据挖掘、机器学习等领域。在这篇文章中,我们将从以下几个方面进行深入的讨论:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

1.1 背景介绍

线性代数是数学的一个分支,研究的是线性方程组和向量空间等概念。在现实生活中,我们经常会遇到矩阵相关的问题,例如求解线性方程组、计算矩阵的逆等。这些问题在数值计算中非常重要,因此需要学习和理解相关的算法和方法。

1.1.1 线性方程组

线性方程组是数学中最基本的概念之一,通常表示为:

$$ \begin{cases} a1x1 + a2x2 + \cdots + anxn = b1 \ a1x1 + a2x2 + \cdots + anxn = b2 \ \vdots \ a1x1 + a2x2 + \cdots + anxn = b_m \end{cases} $$

其中 $ai, bi$ 是已知的常数,$x_i$ 是未知的变量。线性方程组的解是找到变量的值,使得方程组成立。

1.1.2 矩阵逆

矩阵逆是另一个重要的概念,表示的是一个矩阵的逆运算。如果一个矩阵有逆矩阵,那么这个矩阵是可逆的。可逆矩阵的逆矩阵可以使得矩阵与其逆矩阵的乘积等于单位矩阵。

$$ A^{-1}A = I $$

在实际应用中,求矩阵逆是一个非常重要的问题,但是由于矩阵的数量级很大,求逆矩阵的计算成本非常高昂。因此,需要学习和研究更高效的算法和方法来解决这个问题。

1.2 核心概念与联系

1.2.1 奇异值分解

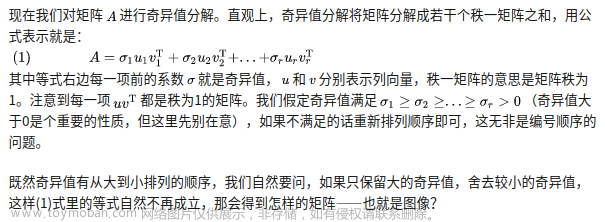

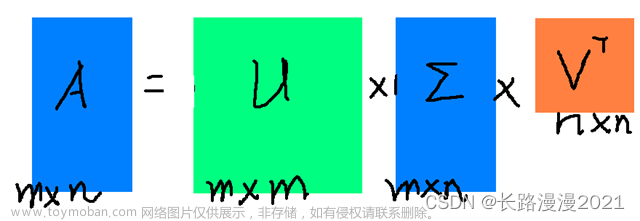

奇异值分解(SVD)是对矩阵进行分解的一种方法,它可以将矩阵分解为三个矩阵的乘积。SVD 的主要优点是它可以处理矩阵的稀疏性,并且可以找到矩阵的主要特征。SVD 的公式表示为:

$$ A = U \Sigma V^T $$

其中 $A$ 是输入矩阵,$U$ 是左奇异向量矩阵,$\Sigma$ 是对角矩阵,$V$ 是右奇异向量矩阵。奇异值分解的核心在于找到这三个矩阵以及对应的奇异值。

1.2.2 矩阵逆与奇异值分解的联系

矩阵逆与奇异值分解之间存在着密切的联系。如果一个矩阵是可逆的,那么它的奇异值分解中的奇异值至少有一个为非零。如果一个矩阵的奇异值都为零,那么它是不可逆的。因此,奇异值分解可以用来判断一个矩阵是否可逆,并且可以求得矩阵的逆矩阵。

1.3 核心算法原理和具体操作步骤以及数学模型公式详细讲解

1.3.1 奇异值分解的算法原理

奇异值分解的算法原理是通过对矩阵进行特征值分解来找到奇异向量和奇异值。具体的算法步骤如下:

- 计算矩阵 $A$ 的转置矩阵 $A^T$ 和矩阵 $A$ 的乘积 $A^TA$。

- 计算矩阵 $A^TA$ 的特征值分解,得到特征向量和特征值。

- 从特征向量中选取模块最大的向量作为左奇异向量。

- 计算矩阵 $A$ 的转置矩阵 $A^T$ 和矩阵 $A$ 的乘积 $AA^T$。

- 计算矩阵 $AA^T$ 的特征值分解,得到特征向量和特征值。

- 从特征向量中选取模块最大的向量作为右奇异向量。

- 将左奇异向量和右奇异向量相乘得到奇异值矩阵 $\Sigma$。

- 将左奇异向量和奇异值矩阵相乘得到左奇异值分解矩阵 $U$。

- 将右奇异向量和奇异值矩阵相乘得到右奇异值分解矩阵 $V$。

1.3.2 矩阵逆的算法原理

矩阵逆的算法原理是通过奇异值分解来求解矩阵的逆矩阵。具体的算法步骤如下:

- 使用奇异值分解算法对矩阵 $A$ 进行奇异值分解,得到左奇异向量矩阵 $U$、奇异值矩阵 $\Sigma$ 和右奇异向量矩阵 $V$。

- 如果矩阵 $A$ 是可逆的,那么奇异值矩阵 $\Sigma$ 中的对角线元素至少有一个不为零。

- 计算奇异值矩阵 $\Sigma^{-1}$ 的逆矩阵。

- 将左奇异向量矩阵 $U$ 和奇异值矩阵 $\Sigma^{-1}$ 相乘得到左逆矩阵 $U\Sigma^{-1}$。

- 将右逆矩阵 $V^T$ 和左逆矩阵 $U\Sigma^{-1}$ 相乘得到矩阵 $A^{-1}$。

1.3.3 数学模型公式详细讲解

在这里,我们将详细讲解奇异值分解和矩阵逆的数学模型公式。

1.3.3.1 奇异值分解

奇异值分解的数学模型公式如下:

$$ A = U\Sigma V^T $$

其中 $A$ 是输入矩阵,$U$ 是左奇异向量矩阵,$\Sigma$ 是奇异值矩阵,$V$ 是右奇异向量矩阵。奇异值分解的目标是找到这三个矩阵以及对应的奇异值。

1.3.3.2 矩阵逆

矩阵逆的数学模型公式如下:

$$ A^{-1} = U\Sigma^{-1}V^T $$

其中 $A^{-1}$ 是矩阵的逆矩阵,$U$ 是左奇异向量矩阵,$\Sigma^{-1}$ 是奇异值矩阵的逆矩阵,$V^T$ 是右奇异向量矩阵的转置。矩阵逆的目标是找到这三个矩阵以及对应的逆矩阵。

1.4 具体代码实例和详细解释说明

在这里,我们将通过一个具体的代码实例来说明奇异值分解和矩阵逆的计算过程。

1.4.1 奇异值分解的代码实例

```python import numpy as np

定义一个矩阵

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

使用奇异值分解算法

U, S, V = np.linalg.svd(A)

打印结果

print("U:\n", U) print("S:\n", S) print("V:\n", V) ```

在这个代码实例中,我们使用了 NumPy 库的 np.linalg.svd 函数来计算矩阵 $A$ 的奇异值分解。这个函数返回了左奇异向量矩阵 $U$、奇异值矩阵 $S$ 和右奇异向量矩阵 $V$。

1.4.2 矩阵逆的代码实例

```python import numpy as np

定义一个矩阵

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

使用奇异值分解算法计算矩阵逆

U, S, V = np.linalg.svd(A)

如果矩阵 A 是可逆的,则奇异值矩阵 S 中的对角线元素至少有一个不为零

if np.linalg.matrixrank(A) == A.shape[0]: Sinv = np.linalg.inv(S) Uinv = np.dot(U, Sinv) Vinv = np.dot(V, Sinv) Ainv = np.dot(Uinv, V_inv.T)

print("A 的逆矩阵:\n", A_inv)else: print("矩阵 A 是不可逆的") ```

在这个代码实例中,我们使用了 NumPy 库的 np.linalg.svd 函数来计算矩阵 $A$ 的奇异值分解。然后,我们检查了矩阵 $A$ 的秩,如果秩等于行数,那么矩阵是可逆的。如果矩阵是可逆的,我们使用奇异值分解算法计算矩阵逆。

1.5 未来发展趋势与挑战

随着数据规模的不断增加,奇异值分解和矩阵逆的计算成本也会增加。因此,未来的研究趋势将会倾向于找到更高效的算法和方法来解决这个问题。此外,随着机器学习和深度学习的发展,奇异值分解和矩阵逆在这些领域的应用也会越来越多。

1.6 附录常见问题与解答

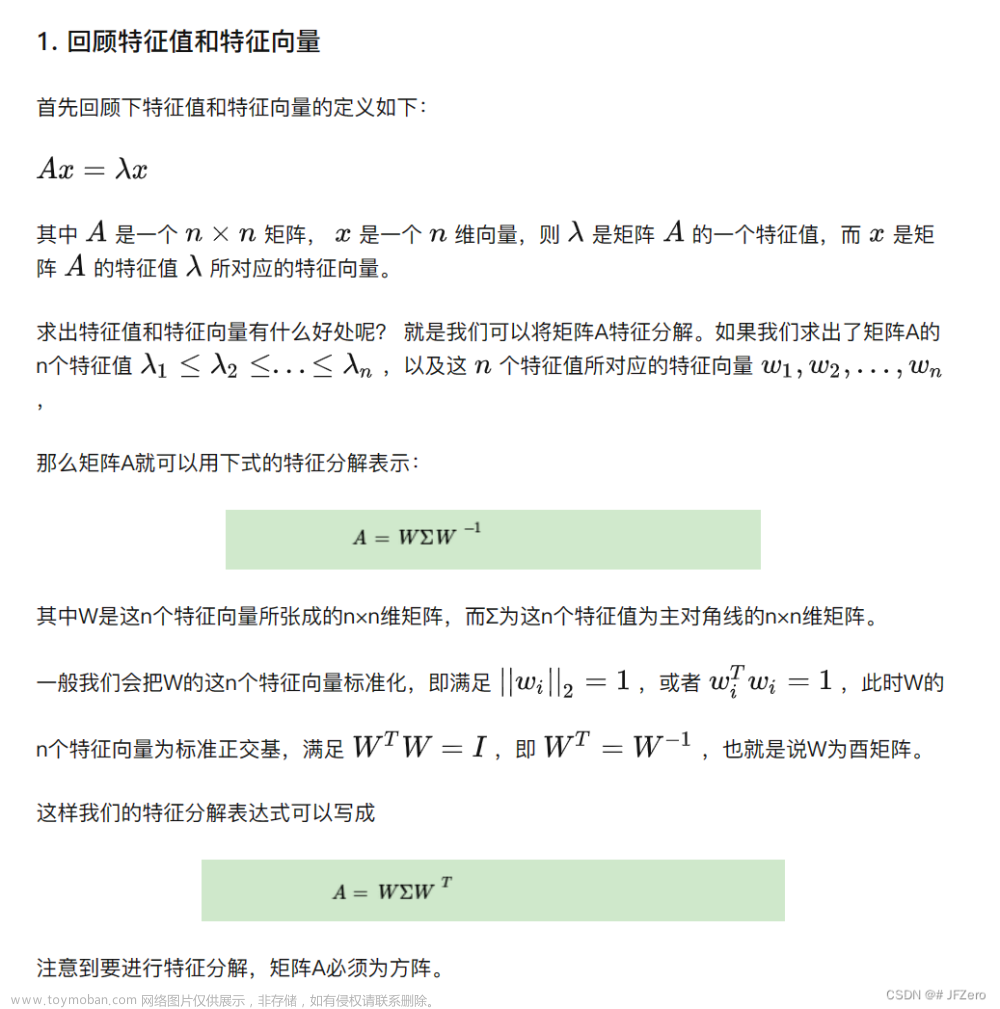

1.6.1 奇异值分解与特征值分解的区别

奇异值分解是对矩阵进行分解的一种方法,它可以将矩阵分解为三个矩阵的乘积。而特征值分解是对矩阵的特征向量和特征值的计算。奇异值分解和特征值分解的区别在于,奇异值分解适用于矩阵的稀疏性,而特征值分解适用于矩阵的稠密性。

1.6.2 如何判断一个矩阵是否可逆

一个矩阵是否可逆可以通过计算矩阵的秩来判断。如果矩阵的秩等于行数,那么矩阵是可逆的。否则,矩阵是不可逆的。文章来源:https://www.toymoban.com/news/detail-849282.html

1.6.3 奇异值分解的应用

奇异值分解在图像处理、信号处理、数据挖掘、机器学习等领域有很多应用。例如,在图像压缩和恢复中,奇异值分解可以用来保留图像的主要特征,从而减少存储和传输的数据量。在机器学习中,奇异值分解可以用来降维和特征选择,从而提高模型的性能。文章来源地址https://www.toymoban.com/news/detail-849282.html

到了这里,关于奇异值分解与矩阵逆:数值实现与优化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!